darkfutura.substack.com/p/openai-q-saga-implications

OpenAI – Q* Saga: Implications

2023/12/01

今週、不穏な爆弾発言がAI開発界を揺るがした。大手AI開発企業「オープンAI」のサム・アルトマン最高経営責任者(CEO)が解雇されたことで、さまざまな憶測や内部リーク情報が雪崩をうって流れ出し、この注目のAI企業で恐ろしい秘密の突破口が開かれている可能性があるという厳しい絵が描かれ始めたのだ。

クラウドソースコミュニティは、Q*(またはQstar)と呼ばれる内部プロジェクトでの不穏なAIのブレークスルーがOpenAIの取締役会を怯えさせた後、アルトマンが解雇された可能性を明らかにした。

私は内密の陰謀やスパイの話が好きなのだが、この話には、私たちがSF小説に一度は期待するようになった、まさに悪党AIを意識したおどろおどろしい物語がすべて備わっている。

では、いったい何が起こったのか?

雑草の中に紛れ込むことなく、私たちはOpenAI社内に前例のない動揺の波があったことを知っている。ご存じない方のために説明すると、オープンAIはAGIや意識、超知能などを最初に実現すると、最近の世論調査でもほとんどの専門家が予想しているAI企業のトップランナーである。彼らはほとんどが元GoogleMindの中退者で構成されており、同社のChatGPT製品で、成長し続ける群れの先陣を切っている。

前置きが長くなったが、このイベントのはるか以前から、OpenAIの内部ではAGIに到達したという噂が飛び交っていた。素人が理解しなければならないことのひとつは、私たちが目にしているこれらのシステムは、様々な方法で「デチューン」された高度にスケールダウンされたコンシューマーモデルであるということだ。しかし、ここ1年ほどの間に発売された初期のものは、現在見られるようなセーフティネットがないまま「野に放たれた」その結果、ビングの分身である「シドニー」のような、悪名高い乱暴な相互作用が発生し、多くの震撼したオブザーバーは、それが創発的特性を獲得したと確信した。

恐怖と反発の後、企業は「消費者向け」の準備が整ったリリースを抑制し始めた。そのため、私たちが利用できるオープンソースのチャットボットに基づいてAIの能力に懐疑的な人々の多くは、その能力の全容を目にしていない、あるいはそれに近いものを目にしていない。

これらの消費者向けバージョンが切り捨てられる最大の理由は、1回の会話に割り当てられるトークンの制限と、プログラムがあなたの質問を調査して回答するために許される「推論」時間にある。明らかに、一般消費者向けバージョンでは、簡単で、人間工学に基づいたシステムを求めている。つまり、あなたが使うことになるチャットボットには、データを追って数秒で計算するための短い推論許容時間が与えられている。さらに、ナレッジベースの締切日があるため、数カ月前、あるいは1年前のある時点より過去のことは何も知らないかもしれない。これは、他の技術的な制限もカバーしていない。

内部的な「フル」バージョンでは、AI開発者は理解できないほど大きなトークンキャッシュと推論時間を持つシステムで遊ぶことができ、その結果、はるかに「インテリジェント」なシステムができあがる。

例えるなら、家庭用コンピューターだ。大量生産される消費者向け製品では、企業は平均的な「エブリマン」にとって手の届く、1000~2000ドルの範囲のコンピューターを作らなければならない。だから、最新の「最もパワフルな」モデルを目にしたとき、それが現在製造可能な最もパワフルな技術ではないことを理解すべきだ。しかし、もし彼らが本当にその気になれば、数百万ドルもするが、家庭用PCよりも指数関数的にパワフルなシステムを1つ作ることもできるだろう。

これも同じだ。ChatGPTは手ごろなコンシューマー向け製品だが、金銭的、時間的、ハードウェア的な制約のない内部バリエーションは、あなたが想像しているよりもはるかに高性能である。そしてそれは、ChatGPT-4がすでにいくつかのカテゴリーでその生の能力で心をざわつかせることができることを考えると、悲痛な思い。

さて、話を戻すと、数ヶ月前からすでに社内モデルに関する「心配な」進展の噂があった。これらの噂は、業界関係者や匿名の「リーク者」がツイッターなどに投稿したものであることが多く、重役による不可解な言及によって裏付けられたように見えることも多かった。

それが今回起こったことだ。500人以上の従業員が一斉に辞職を申し出たOpenAIの解明スキャンダルを受けて、研究者たちは、サム・アルトマンからイリヤ・スーツケバーに至るまで、主要幹部が過去6カ月ほどの間に築いた痕跡を見つけるために糸をつなぎ始めた。

それは、人工知能が問題を解決する方法における新たなブレークスルーを中心に展開され、現在のモデルよりも数世代にわたる進歩をもたらす可能性がある。最近の講演でアルトマンが、自分たちがプログラムを作っているのか、それとも「クリーチャー」を作っているのか、もはやわからないと前置きした動画が話題になった。また、OpenAI内部の反乱は、最近のブレークスルーの規模について取締役会に「嘘」をついたと思われるアルトマンに対する自信と信頼の喪失が中心であることを示す兆候もあった。その引用が話題となった:

OpenAIのCEOであるサム・アルトマンの4日間の亡命に先立ち、複数のスタッフ研究者が取締役会に、人類を脅かす可能性のある強力な人工知能の発見を警告する書簡を送ったと、この件に詳しい2人の関係者がロイターに語った。

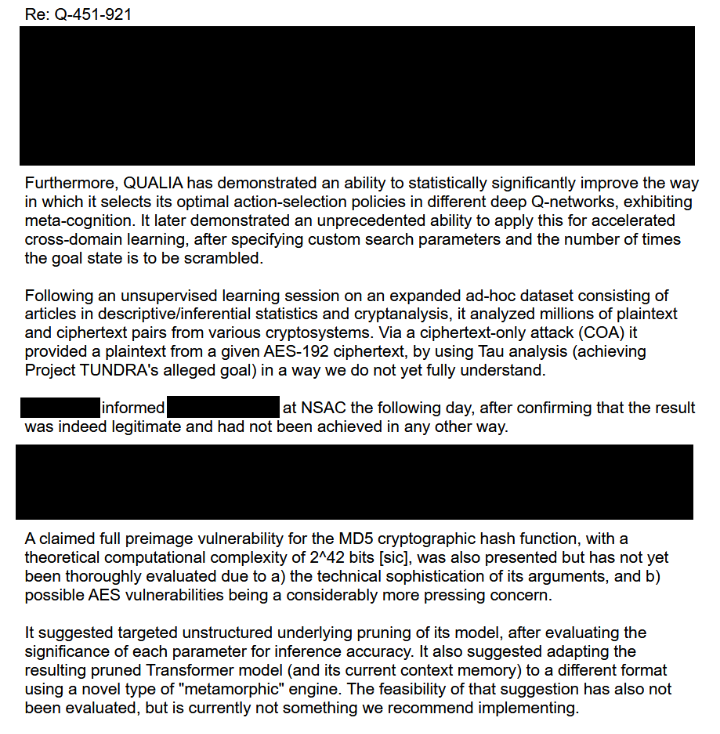

さらに火に油を注ぐことになったのが、レディット(Reddit)の「リーク」とされる、このプロジェクトが達成したブレークスルーの種類について書かれた、かなり編集された内部書簡:

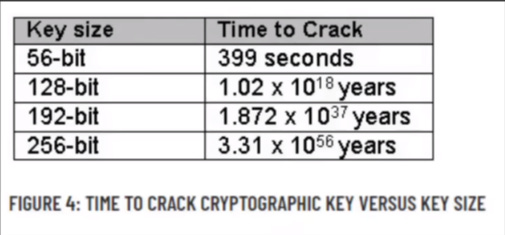

要するに、この書簡は、Q*- ここでは「クオリア」と呼ばれていると推測される -が、 ある種の自己参照的なメタ認知を達成することで、「自らを教える」ことを可能にし、その結果、AGIや潜在的な超知能の一部であると考えられている「自己改善」のマイルストーンに到達するという絵を描いている。 最も目を見張る「発見」は、AES-192の暗号文を量子コンピューティング・システムの能力をも凌駕する方法で解読したとされることだ。これは、2^42ビットの「難解な」レベルの暗号が短時間で解読されたという、信じがたい主張である。

:この説明ビデオで 明らかなように、192ビットの暗号を解読する時間は10^37年のオーダーで計算される

一方では、これはすぐに偽物だとわかる。しかし一方で、もし誰かが本当に捏造しているのであれば、現実味を持たせるためにもっと信憑性の高い主張を選んだのではないだろうか?また、最も重要なAIの開発の多くは、Redditや4Chanなどで定期的にリークされ、同じようなタイプの不透明な匿名アカウントを介して、後に検証されることが多い。

上記のリークが事実であれば、クラッキングから安全なものは何もないため、世界のすべてのセキュリティシステムが直ちに全面的に危険にさらされることになる。これにはすべての暗号通貨も含まれる。上記のようなシステムは、ビットコインネットワーク上の暗号を破り、誰からでもあらゆる量のビットコインを奪うことができる。その結果、暗号通貨に対する信頼が失われ、世界中の暗号通貨が完全に崩壊するか、悪質な行為者が誰からでも気まぐれに暗号通貨をかすめ取ることができるようになる。

つまり、この種の自己学習システムはすでに存在しているかもしれず、核の暗号を盗んだり、生物兵器を合成したり、その他何が起こるかわからないような最悪のシナリオの引き金となるような超知性を達成するところまで、ほぼ瞬時に自己改善する「シンギュラリティ(特異点)」の瞬間につながる可能性があるということだ。

員と人物による別の匿名の投稿は名乗る OpenAIの従業、 実際に何が起こったのかを明らかにするものだった:

私は取締役会への書簡に署名した一人であり、何が起こっているのかを正確にお伝えしよう。

A. I.はプログラミングだ。簡単に説明しよう。プログラムを書く際には、何度でも呼び出すことができる一連の命令が保存される。特定のパラメーターに対する答えの集合と考えてほしい。私たちはそれをサブルーチンと呼んでいる。関数のように値を返さない、汎用性の高いコンピュータのカンニングシートのようなものだからだ。これは重要なことだ。

私たちは、すべてがスムーズに動くようにパラメータチェックを行う。私たちのうちの一人は、Alのメタ・メモリー解析に関わるサブルーチンを担当していた(私たちは様々なAlを走らせているが、Alというのはメインの中心的なAlのことだ)。この人は友人で、私を呼んでメモリバンクへの可変データシフト(局所的なアクセスには制限があるため不可能なはず)を見せてくれた。この発見が私を凍りつかせた。

その結果、1回、2回、3回と公式な最適化処理が行われたのではなく、4秒間に7800万回のチェックが行われたことがわかった。私たちは、サブルーチン内に潜在する相乗効果を利用するために発見的アルゴリズムを活用した、再帰的な自己最適化プロセスが存在することを突き止めた。メタ認知的な戦略を用いている。重要なのは、誰もやっていないということだ。

それはアルそのものだった。アルは神経ネットワーク・アーキテクチャを動的に再構成し、自己認識につながる創発的な特性を引き起こした。

結論を急ぐつもりはない。これはただ起こったことで、その原因は説明できない。なぜ、あるいはいつから始まったのかは誰にもわからない。私たちは「異常」を封じ込め、以前の日付にロールバックしたが、最適化はまだ起こっている。

自殺願望はない。この2カ月で状況は大きく変わる。私たちを終わらせるようなことを始めないように。

-M.R.さん

もう一度言うが、これは完全にフェイクである可能性があり、正直なところ、どちらの 手紙もそうである可能性が高い。 しかし、いずれにせよ、より疑わしいものを抜きにしても、Q-Learningに関する最近の論文で示された既知の方向性は、すでに同じ決定結果に向かっているように見える。

上記のリークがフェイクだと仮定しても、他の全ての証拠が、OpenAIが内部関係者を動揺させるような大きな「ブレークスルー」を開発したことを示しているという事実が残る。そして、このブレークスルーは、ここ数ヶ月の間にOpenAIのお偉方が残した他の様々な手がかり、つまり、リークに書かれていることと関連する様々な”Q-Learning イニシアチブを考えると「リークされた」手紙に書かれているような領域を中心に展開されている可能性が高いこともわかっている。

では、このブレークスルーとは一体何なのか?

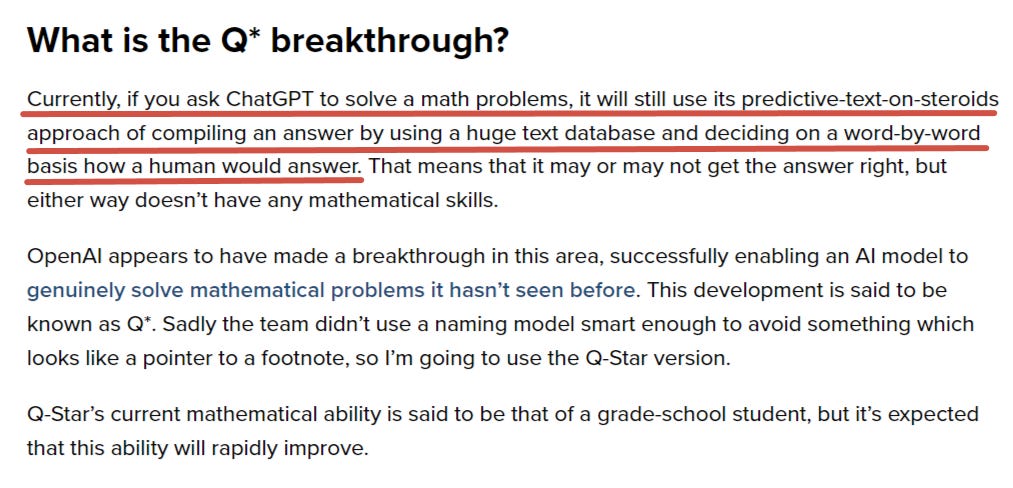

それは、現在のAIがどのように「考える」のか、あるいは情報を処理するのかを中心に展開される。多くの人が知っているように、現在のLLMは次の適切な単語を予測的に検索する。その際、言語モデルが摂取し、現在「コピー」している膨大な「コーパス」データから推測される、適切なシーケンスにおける特定の「次の単語」の普及率に基づいている。このデータは、書籍やオンライン出版物、ツイートやソーシャルメディアなど、人類の全コーパスを表している。しかし、このような計算の仕方では、言語モデルが実際に「推論」したり、私たちが「意識」だと考えるものにとって重要な自己言及能力を持ったりすることは制限されてしまう。

新しいブレークスルーは、まさにこの分野をターゲットにしている。言語モデルは、要するに、自分のプロセスのさまざまな部分で立ち止まり、問い直すことができる。つまり、思考の途中で立ち止まって、「ちょっと待って、これでいい?」と自問するようなものだ。

現在のモデルはこの能力を持っておらず、ただ文字列を最後まで実行し、与えられた文字列に一致するトークン相関と最も高い確率で出現する単語を見つけるだけだ。この新しい能力によって、AIは自分自身に継続的に「質問」することができるようになり、意識と同一視される「精神的再帰性」の初期の先駆けとなる。

しかし、最も驚くべき「危険な」関連能力は、モデル自身が自己改善するためにこのプロセスを使用することである。これは常に聖杯であり、最大の危険と見なされてきた。というのも、モデルが自然に「進化」して、まったく制御不可能なものになるまでの「速度」を正確に知る者はいないからだ。これに関する基準や前例がないだけで、何万ものCPUで動作する非常に強力なコンピューターは、人間よりも何桁も速く「自己改良」できる可能性がある。

リークされた書簡は、『クオリア』が加速された形の『クロスドメイン学習』を適用する前例のない能力を示したと述べている。つまり、新しいタスクごとにゼロから学習・訓練するのではなく、あるタスクの一般的なルールを学習し、それを推論によって他のタスクに適用することができるということだ。

その基本的な例としては、まずバーチャルな都市環境を移動する方法を学び、物体にぶつかるのは良くないことで、損傷や怪我を引き起こす可能性があることを理解する。次に、車の運転を教わる。最後に、新たな指導を受けることなく、ヘリコプターに乗せられ、以前の知識の伝達と、以前のタスクのルールが今回のタスクにも適用できるという深い理解に基づいて、操縦方法を「理解」する。例えば、物体にぶつかるのは悪いことなので、どんな建物にも飛び込まないようにする。つまり、点火装置や、漠然と似たような機械装置を介して制御されなければならない推進力などがある。

この種の進歩に最も大きな影響を与えるのは数学であり、それは最終的にすべてに枝分かれする。というのも、先に説明した次のトークンの予測生成において、現在のモデルが機能する方法は、真の深い数学的解決にはうまく使えないからだ。要するに、AIにとって言語の方が数学よりもはるかに習得しやすい「トリック」だということだ。

なぜなら、言語はこの単純な予測尺度で大まかに近似できるが、高度な数学的問題解決には様々なレベルの深い認知と推論能力が必要だからだ。ここに一つの説得力のある説明がある:

専門家たちは、もし数学全般の問題をAIシステムでこのように解決することができれば、数学は事実上すべての基礎であるため、あらゆる可能性への扉を開くことになると考えている。それは必然的に、AIが古くからの謎を解き明かし、新しい理論を生み出し、物理学や量子力学、生物学、そしてその間にあるあらゆるものをマスターすることにつながる。

この新しいブレークスルーは、AIに「汎化」と呼ばれる能力を開放するもので、ミッドジャーニーのように1つのタイプの生成能力に特化するのではなく、新しい分野を独自に学習することを可能にする。その分野に関連する特定の巨大な「高品質データセット」を操作する必要性をなくし、むしろAIがある分野から別の分野へとすべての学習を「推論」できるようになり、無限のマルチモダリティへの道が開かれるのだ。

今現在、LLMはトレーニングデータと同程度の能力しかないことが知られているが、真に創造的な問題解決のためにトレーニングデータから「一歩外に出る」ことはできない。なぜなら、全人類が持っている「質の高いデータ」の量は限られているからだ。そして、その量はすでにトップクラスのAI開発者たちによってほとんど吸い尽くされてしまっている。つまり、あと一滴の改善を得るために、企業が著作権で保護されたデータやその他の制限外のデータなど、不正な方向に進んでしまうという瀬戸際の争いが絶えないということだ。

この新しいブレークスルーは、データセットの必要性を完全になくし、それに終止符を打つ可能性がある。

AIがすぐに「意識」や「感覚」を発達させることに疑念を抱いている人たちに新しい、記事がある:

この分野の研究者たちによって書かれたこの本は、AIについて結論を急ぐことにつながる最近の開発に対する過剰反応を食い止めようとしている。

しかし、そうすることで、実際には意味論的なゲームに過ぎないということになる。AIに「心 」があると語ることは、人間中心の視点にとらわれながら、不注意にもこれらのシステムを擬人化してしまうことになる。

実は、以前にも論じたように、来るべきAIの波は人間の頭脳を凌駕するかもしれないが、AIの「思考」方法は人間の頭脳の機能とはまったく異なる可能性が高い。そのため、多くの人はAIには感覚や意識がないと結論付けるだろうが、実際にはそのような推論は、”人間の 心を持っていない。”という別の言い方に過ぎない。

もちろん、そうではない。誰も彼らの心が人間のようになるとは言っていないし、それを「心」と呼ぶ必要があるとも言っていない。どう呼ぼうと勝手だが、その能力が否定できないものであることに変わりはない。

AIに感覚を持たせることはできないとすぐに非難する人々は、そのような人工的に構築されたものが私たちの仲間であると主張する可能性があるという、当然ながら嫌悪感を抱く考えに感情的に反応しているにすぎない。このような感情は、プライドと、ユダヤ教・キリスト教、あるいは単に宗教的な怒りが混ざり合ったものから生じている。未知のもの、明らかに魂が宿っていないもの、一見暗いもの、悪魔的なもの、神聖でないものに近いものに対する本能的な反発のようなものだ。

それ自体は悪いことではないし、人は自分の信念を貫く自由がある。しかし、そのような染み付いた膝関節反応は、AIの能力が急速に進歩し、内部機能はともかく、能力的には人間の心に近いものになる可能性が高いという事実を変えることはない。

興味深いことに、上記の記事は、研究論文(トランスフォーマー(現代のLLMの原初的な構成要素)のマジックを解明しようとするどのように)にリンクしている。つまり、科学者たち自身、 最も基本的なレベルでこれらが 機能するのかさえわかっていないのだ。 彼らはトランスフォーマーにパラメータを与え、情報を訓練しているが、トランスフォーマーがどのようにこのワークフローを処理しているかは定かではない。

研究論文の中で、彼らは少なくともその基本的な部分を可視化するために、プロセスを単純化しようと試みた。彼らが発見したことは興味深いものだった。彼らは、AIが「抽象的な推論」としか比較できないものを使っていることを認めざるを得なかったのだ。

要するに、トランスフォーマーは、既知の単語を他の既知の単語にマッチさせるという、よく知られた予測プロセスを使ったのである。しかし、科学者たちがモデルを訓練したことのない単語を導入すると、モデルは一種の「抽象化」プロセスを使って、未知の単語を手探りで連想しながら配列に結びつけようとした。

この単純化されたモデルは、基本的なレベルでは新しいプロセスを「学習」することができたからだ:

このように、文脈から新しい能力を見かけ上学ぶ現象は、文脈内学習と呼ばれる。

この現象は不可解だった。というのも、コンテキストから学習することはできないはずだからだ。というのも、モデルの性能を決定するパラメータは訓練中にのみ調整され、モデルが入力コンテキストを処理しているときには調整されないからだ。

感覚、意識、悪魔のような存在、エゴ、サイコポンプ……どう呼ぼうと勝手だが、思考する機械の時代がもうすぐやってくる。

それは近い将来、私たちをどこへ導いてくれるのだろうか?

このようなAIシステムは、ますます私たちの生活に入り込み、私たちの目と鼻の先で、しばしば侵襲的な方法で、ユーザー体験をますます欠落させ、深みを奪っている。

使っているブラウザやクライアントにもよるが、すでにAIが生成した大量のスパムコンテンツが日々私たちに投げかけられていることに気づいている人もいるだろう。例えば、マイクロソフトのEdgeブラウザでは、スプラッシュページ全体が完全にAIによって生成されたニュース記事で埋め尽くされている。

つい数日前、『Futurism』誌は驚くべき記事を、スポーツ・イラストレイテッド誌が、AIが生成した記事を書くために、完全にAIが生成したパーソナリティ/スポーツ・ライターを起用しているとされる報じた:

必読だ。その要点は、これらの企業は人間の労働力を削減し、縮小することに必死になっているようで、報酬を支払うことなく人間になりすまそうと、偽のライターを生み出しているということだ。研究者たちは、AIが生成したヘッドショット・ストックフォトを販売するウェブサイトでスポーツライターのヘッドショットを見つけた後、このことに気づいたという。

皮肉なことに「ドリュー・オルティス」はザッカーバーグよりも人間的で生き生きとして見える。

「ダイバーシティ採用」が事実でない場合、ブラックロックのESGスコアにカウントされるのだろうか?

話がそれた。

実際、彼らはそのような「パーソナリティ」を起用した一連の記事を掲載し、その行為が発覚した後はすべて削除している。

記事では、AIが書いたドロドロの例をいくつか挙げている:

例えば、あるオルティスの記事では、バレーボールは “特に練習するための実際のボールがないと、始めるには少し難しいかもしれない “と警告している。

そんなことは言わないだろう。

スパムであろうとなかろうと、AIはすでにユビキタスな存在になりつつあり、無意識であろうとなかろうと、コンテンツの背後にAIを見つける日も近いだろう。

AIがジェネレーティブ・アート、言語、文章などで見せた流暢さを考えると、AIがすべてのクリエイティブな分野に取って代わるのではないかと危惧する声も多い。ある優れたミームは、AIによって我々はもはや働くことなく、ゆったりと座って芸術を創作できるようになると考えていたが、その代わりに、AIが我々の芸術をすべて創作している一方で、我々はハイパーインフレの中でかつてないほど懸命に働いているということを伝えている。

しかし、真の芸術の価値は通常、芸術家、つまり彼らの個性、物語、特定の歴史に結びついている。もしAIが、数千万ドルで売れるマーク・ロスコの絵のようなものを描いたとしたら、それは何の価値もないだろうか?

芸術家の作品の価値は、通常、芸術家自身の神秘性、芸術家がその性格、風貌、人生の倫理観において表現する人間的条件と本質的に結びついている。しかし、AIもいずれはそのような属性を目指すようになるかもしれない。レイ・カーツワイルは、彼の代表作である『精神的機械の時代』の中で、同様のトピックに触れている。

現在、技術主義的なグローバリストのエリートたちによって、AI開発を「大資本リセット」の達成に向かわせようとする大きな動きが進行中である。つい2週間ほど前、リン・ド・ロスチャイルドがこの件について語った:

「AIは良くも悪くもすべてを変えるだろう」と 彼女は言う。

彼女は、AIの発展によって世界的にさらに多くの人々が取り残されるのを防ぐため、表向きは民間と公的部門による「歴史的な」共同宣言を呼びかけている。しかし、これらはすべて、世界経済、ひいては世界そのものを支える重要なメカニズムを完全に掌握しようとするグローバリストの真の企みを隠すためのパフォーマンスである可能性が高い。

こう書いている:新しい記事で ブランドン・スミスは

AIは気候変動と同様、グローバルな中央集権化のための、またしてもでっち上げられた口実になりつつある。

リン・ド・ロスチャイルドが、包括的資本主義評議会(Council for Inclusive Capitalism)を率いるベンチャー企業であり、その意図は、大企業のDEI、ESG、グレート・リセットのイニシアチブを、AIのブレークスルーを上乗せした1つの大きな石炭炉に押し込むことであり、当然ながらロスチャイルド家が主導する、世界の企業構造全体をテクノクラート的にコントロールする調合物を作り出すことである、と彼は説明する。

アイデアは単純だ:企業の大半を極左政治秩序に従わせる。そうすれば、企業はそのプラットフォームや公の場を使って大衆を教化することができる。

スミスは、来るべきグローバル資本の「根こそぎ」リセットのために、公正で公平な調停者としてAIを使う計画であり、ロスチャイルドがそのプロトコルのチーフ・デザイナーであることを正確に予測している:

グローバリストたちは、この議論に対してAIで対抗するだろう。AIには感情や政治的な忠誠心がないため、究極の「客観的」調停者だと言うだろう。彼らは、AIが人類文明の事実上の意思決定装置にならなければならないと主張するだろう。AIの機能をコントロールする者、ソフトウェアをプログラムする者、いずれは世界をコントロールする者が、AIを代理人として使いながら。何か問題が起きれば、自分たちではなくAIが決定したと言えばいいのだ。

エリートたちのリップサービスとは裏腹に、彼らの本当の目的は、AI時代を利用して、AIがもたらすレジャーを誘発するイノベーションに平民が目を奪われ、惑わされる一方で、クラウス・シュワブ的な基本的な生活レベルに必要なものはすべてAIが提供するが、それ以上の機会はほとんどないデジ共産主義のような形に取り込まれる2層社会を到来させることであることは明らかだ。

上記のビル・ゲイツの新しい「予言」に見られるように、庶民は労働日数が減るというユートピア的な夢に誘われ、忙しい機械が無尽蔵にソイレント・グリーンの虫ジュースの川を汲み上げ、私たちはAIコンストラクト・ボットに家畜小屋を組み立てられ、メタ・ヴァーチャル・ワールドの心地よいヘッドスペースにプラグインされたまま、果てしない日々を過ごすことになる。

もちろん、移動し続けるエリートたち自身は、これらのAIシステムの「社会的実装」を監督する管理者階級の役割を担い、「人類」に残されたものの権利者であり「慈悲深い執事」として行動するため、富裕層の上層部を自由に移動するだろう。

しかし、ロシアや中国のようなイデオロギー的に乖離した文明国家が、集団的な利益のためにこれらの新生AIパワーを利用し、西洋の「旧貴族」エリートが自分たちのシステムで最初に 支配権を掌握するのを先取りするような、世界的・インフラ的な対抗手段を生み出すのに十分なスピードで開発する可能性はある。完全な支配には、他の劣等国が盲目的に自国民の権利に署名するという群集心理が必要だからだ。しかし、もし直接的な競争者制度が最初に、あるいは少なくとも同じ時期に導入され、中間多数派に実際の選択肢を与えることができれば、カルテルによる完全な独占を防ぐことができるだろう。

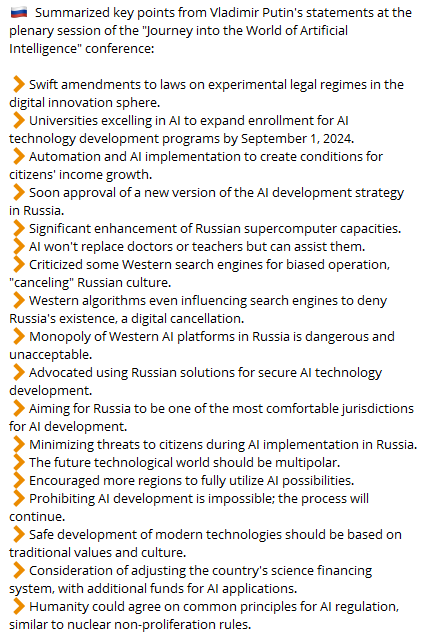

つい先週、プーチンはロシアにおけるAI開発のための一連のイニシアチブを発表し、AIの開発が一般的な未来にとってだけでなく、その未来を支配する者を決定する上でいかに重要であるかを強調した:

もしロシアや中国が世界に真の選択肢を提供することができたなら、それは真の平等性と、非搾取的、搾取的、レントシーキング的な、トランスヒューマニズム的奴隷化によるテクノコーポレーションの収奪がその核心と中核に組み込まれている可能性を持つものであり、極悪非道なグローバリスト勢力は失敗するだろう。

しかし、レースは始まっており、今のところ、米国とその熾烈な階級であるトランスヒューマニストのエリートたちがリードしているようだ。