コンテンツ

en.wikipedia.org/wiki/Doomsday_argument

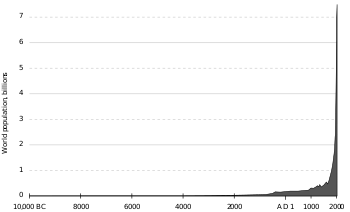

紀元前1万人から西暦2000年までの世界人口

Doomsday argument

終末論法(DA)とは、これまでに生まれた人間の総数を推定して、人類の将来のメンバーの数を予測しようとする確率論的な議論である。簡単に言えば、それはすべての人間がランダムな順序で生まれていることを仮定すると、チャンスは、任意の1つの人間が大体真ん中に生まれているということである。

これは、1983年に宇宙物理学者のブランドン・カーターによって明示的な方法で最初に提案されたものである[1]。より一般的な形式は以前にリンディ効果[4]で与えられたもので、ある現象については将来の寿命は現在の年齢に比例しており(必ずしも等しいとは限らないが)時間の経過とともに死亡率が減少することに基づいている。

コペルニクスの原理は,これまでに生まれた,あるいはこれから生まれてくる人間の総数をNで表すと,どの人間も(他のN – 1人の人間と一緒に)総人口Nのどの位置にいても,同じように(他のN – 1人の人間と同じように)自分自身を見つける可能性があることを示唆している。

つまり、例えば、fが区間(0.05, 1)にある確率は95%であり、f > 0.05である。つまり、これまでに生まれてきた全人類の中で、最後の95%以内に入る確率があると仮定することができる。もし私たちが絶対位置nを知っているならば、この議論は、N < 20nを与えるためにn/N > 0.05を再配置することによって得られるNの95%の確信度の上限を意味している。

Leslieの数字[5]を用いると、これまでに600億人の人間が生まれていることになるので、95%の確率で人間の総数Nが200×600億=1.2兆人以下になると見積もることができる。仮に世界人口が100億人、平均寿命80年で安定すると仮定すると、残りの11400億人の人類は9120年後に誕生すると推定できる。今後数百年後の世界人口の予測によって、推定値は変動するが、1.2兆人以上の人類が生きられる可能性は低いというのが論旨である。

アスペクト

簡単に言うと、今後生まれてくる人類の総数が 600 億人(N1)または 6,000 億人(N2)であると仮定する[6] 。 現在生きている個人 X が人類の歴史の中でどのような位置にいるのかについて予備知識がない場合、代わりに X より前に何人の人間が生まれたかを計算して、(例えば)59,854,795,447 とすると、X はこれまでに生きてきた最初の 600 億人の中にほぼ含まれることになる。

N の各値の確率を合計することで、N の統計的な「信頼限界」を計算することができる。例えば、上記の数字から、N が 6,000 億より小さいことは 99%確実である。

上で述べたように、この議論はNの事前確率が平坦であること、つまり、Xに関する情報がない場合、N1では50%、N2では50%であることを前提としていることに注意してほしい。P(X)が平坦であるとすると、人間の総数がNであるという事前確率P(N)を仮定しなければならない。もし、N1よりもN2の方がはるかに可能性が高いと結論づけたならば(例えば、より大きな人口を生み出すにはより多くの時間が必要であり、その間に低確率ではあるが激変的な自然現象が起こる可能性が高まるからです)P(X|N)はより大きな値のNに重くなる可能性がある。

終末論は、人類が無期限に存在できない、あるいは存在しないとは言っていない。それは人類が永久に存在することができない、あるいは存在しないと言っているわけではないし、人類がいつ絶滅するかの上限を示しているわけでもない。議論の省略形は、確率と確実性を混同して、これらの主張をしている。しかし、上で使われているバージョンの実際の結論は、9,120年以内に絶滅する確率は95%で、その期間の終わりにはまだ生きている人類がいる可能性は5%であるというものである。正確な数字は、特定の終末論の間で異なる。

バリエーション

この議論は活発な哲学的議論を生み出していたが、その解決策についてはまだコンセンサスが得られていない。以下に説明されている亜種は、別個の派生によってDAを生成する。

ゴットの定式化:「漠然とした事前の」総人口

Gottは,生まれてくる人の数(N)の事前分布の関数形を具体的に提案している.GottのDAは曖昧な事前分布を使った。

ここで

P(N) は,まだ生まれていない人間の総数である n を発見する前の確率である.

定数 k は,P(N) の和を正規化するために選ばれる.ここで選ばれた値は重要ではなく,関数形だけです(これは不適切な事前分布なので,kの値は有効な分布を与えないが,ベイズ推論はこれを使ってまだ可能だ).

Gottが全人類の事前分布P(N)を指定しているので、ベイズの定理と無関心の原理だけでP(N|n)を与えてくれる。

これは、これまでに生まれた人口がnの場合の、Nの総人口の事後確率に対するベイズの定理である。さて、無関心の原理を使って

現在の母集団の無条件n分布は、漠然とした先行N確率密度関数と同じである[7]。

P (N | n)を与える(事後確率方程式に代入することで)。

与えられた信頼度(例えば95%)で終末の日の推定値を生成する最も簡単な方法は、Nが連続変数であると仮定して(非常に大きいので)N = nからN = Zまでの確率密度を積分することである(これにより、N ≤ Zの確率の関数が得られる)。

Z = 20nを定義すると

これが終末論の最も単純なベイズの導出だ。

これまでに生まれる人間の総数(N)が、これまでに生まれた人間の総数の20倍以上である可能性は、5%以下である。

漠然とした事前分布の使用は,任意の特定の関数が選択されなければならないことを考えると,N についての知識を可能な限り少なく仮定しているので,十分に動機付けられているように思われる.これは,自分の絶対位置(n)を知った後でも,自分の分数位置の確率密度が一様に分布しているという仮定と同等である.

1993年の論文におけるゴットの「参照クラス」は、出生数ではなく、「人間」が種として存在していた年数であり、彼は20万年とした。また、ゴットは生存時間の最小値と最大値の間に95%の信頼区間を与えようとした。最小値を過小評価する確率は2.5%なので、最大値を過大評価する確率は2.5%しかない。これは、彼の信頼区間の上限の前に絶滅が起こるという97.5%の確信に等しい。これは、Z = 40n、n = 200,000年で上の積分で使用できる。

このようにしてゴットは、n ≤ 8,000,000年以内に絶滅するという97.5%の確信度を導き出しているのである。彼が引用した数字は、N – n = 780万年という残りの時間の可能性が高いものであった。これは、時間に無関心の原則を適用しているため、出生数を数えることで得られる時間的信頼度よりもはるかに高いものであった。(同じ仮説の中で異なるパラメータをサンプリングすることで異なる推定値が得られることは、ベルトランのパラドックスです)。同様に、現在が人類の歴史の最初の97.5%にある確率は97.5%なので、人類の全寿命が少なくとも次のようになる確率は97.5%である。

言い換えれば、ゴットの議論は、95%の信頼度で、将来、5100万年から780万年の間に、人間が絶滅することを示している。

Gottはまた、ベルリンの壁とブロードウェイとオフブロードウェイの演劇に対してこの定式化をテストした[8]。

レスリーの議論は、N の事前の確率分布が曖昧であることを前提としていない点で、ゴットの議論とは異なる。その代わりに、終末論の力は、N の事前の確率分布に関係なく、自分の出生位置を考慮に入れれば、早期の終末の確率が高まることに純粋に存在すると主張している。

ハインツ・フォン・フォースターは、社会、文明、技術を構築するための人類の能力は、自己抑制の結果ではないと主張した。むしろ、社会の成功は人口の大きさによって直接変化する。フォン・フォースターは、このモデルがイエスの誕生から 1958年までの約25のデータポイントに適合していることを発見し、分散の7%だけが説明されていないまま残されていた。いくつかのフォローアップの手紙(1961, 1962, …)は、フォン・フォースターの方程式がまだ軌道に乗っていたことを示して、サイエンスに発表された。データは1973年まで適合し続けた。フォン・フォースターのモデルで最も注目すべきことは、2026年11月13日の金曜日に、人類の人口が無限大か数学的特異点に達するだろうと予測したことである。実際には、フォン・フォースターは、その日の世界人口が実際に無限大になる可能性があることを暗示したのではない。本当の意味は、1960年以前の何世紀にもわたって続いてきた世界の人口増加パターンが終焉を迎え、根本的に異なるパターンに変貌しようとしているということである。この予言が成就し始めたのは、「終末の日」が発表されてからわずか数年後であることに注意してほしい[9]。

参照クラス

終末論議の主要な分野の一つは、n が引き出される参照クラスであり、そのうちの N は究極の大きさである。標準的な」終末論議の仮説は、この点にはあまり時間をかけず、参照クラスは「人間」の数であると単純に言っている。あなたが人間であることを考えると、コペルニクス的原理は、あなたが異常に早く生まれたかどうかを問うために適用することができるが、「人間」というグループ化は、実用的かつ哲学的な理由から広く異議を唱えられていた。ニック・ボストロームは、意識は、何が基準クラスにあるか、何が基準クラスから外れているかを識別する(一部)ものであり、地球外知的生命体が計算に劇的な影響を与える可能性があると主張している。

以下のサブセクションでは、それぞれが標準的な終末論法を適用した異なる参照クラスの提案に関連している。

大量破壊兵器時代の人間だけをサンプリングする

終末時計は、ベイズモデルではなく、専門家委員会の判断で核の終末までの予想時刻を示している。時計の12時間が人類の寿命を象徴しているとすれば、現在の時刻23:58[10]は、我々が生まれてくる最後の1%の人間の中にいることを暗示している(すなわち、n > 0.99N)。J.リチャード・ゴットの終末論(DA)の時間的なバージョンは、そのような特別な時間に生まれたことのあり得ない可能性を克服するために、非常に強力な事前証拠を必要とするだろう。

時計の終末論の推定が正しい場合、その歴史の中のランダムな時間で観察された場合、それが人類の歴史の中でそのような遅い時間を示すのを見ることの100分の1以下のチャンスがある[引用が必要]。

しかし、科学者の警告はDAと整合させることができる[citation needed] 。 終末の日の時計は、原子の自滅が近いと具体的に推定しているが、それは約70年前からしか可能ではなかった[11]。 もし終末の日が核兵器を必要とするならば、終末論議の「参照クラス」は核兵器と同時代の人々である。このモデルでは、広島を生き抜いた人、または広島の後に生まれた人の数はnであり、広島を生き抜く人の数はNである。これらの変数の定義にゴットのDAを適用すると、50年以内に終末の日が来る確率は50%になる。

“このモデルでは、時計の針が真夜中にとても近いのは、終末の条件が1945年以降に生きているからであり、それは今は適用されるが、時計の比喩的な人間の「一日」の以前の11時間53分には適用されない条件である。” [引用が必要]

もし、あなたの人生が爆弾の影の下で生きた全ての人生の中からランダムに選ばれたならば、この単純なモデルは1000年以内に終末の日が来る確率が95%になる。

しかし、地球温暖化によってもたらされる危険性を警告するために、科学者達が最近、時計を前倒しにして使っていることは、この推論を混乱させている。

SSSA. オブザーバーモーメントからのサンプリング

ニック・ボストロムは、観測選択効果を考慮して、自己サンプリング仮定(SSA)を出している。”あなたは、あなたが適切な参照クラスからのランダムな観察者であるかのように自分自身を考えるべきである”。[参照クラス」がこれまでに生まれてくる人間のセットであるならば、これは95%の信頼度(標準的な終末論)でN < 20nを与える。しかし,彼はこの考えを,単なるオブザーバーではなく,オブザーバーモーメントに適用するために洗練させた。彼はこれを形式化した([1]として。

強い自己サンプリング仮定(SSSA)。各オブザーバー・モーメントは、その参照クラスのすべてのオブザーバー・モーメントのクラスからランダムに選択されたかのように推論すべきである。

SSSAの基礎となる原則の適用は(この適用はどこにも明示的にBostromによって述べられていないが)、である。あなたがこの記事を読んでいる分が、すべての人間の寿命のすべての分からランダムに選択されている場合は、(95%の信頼性で)このイベントは、人間のオブザーバーモーメントの最初の5%の後に発生している。将来の平均寿命が歴史的平均寿命の2倍である場合、これはN < 10n (将来の平均的な人間は歴史的平均人間の2倍のオブザーバー・モーメントを占める)という95%の信頼性を意味する。したがって、このバージョンの95%の絶滅時間の推定値は4560年である。

反論

我々は初期の5%にいる。

統計的手法に同意するならば、まだ終末論法(DA)に同意しないことは、次のことを暗示している。

- 現在の人類の世代は、生まれてくる人類の最初の5%以内である。

- これは純粋に偶然の一致ではない。

したがって、これらの反論は、現在生きている人間が最も古い存在の一部であると信じる理由を与えようとしている。

例えば、ある共同プロジェクトの5万人のメンバーであれば、終末論法は、そのプロジェクトのメンバーが100万人を超えることはないという95%の確率を暗示している。これは、他の特徴がアーリーアダプターの典型的なものであれば反論できる。潜在的なユーザーの主流は、プロジェクトがほぼ完成したときに参加することを好むだろう。もし人がプロジェクトの不完全性を喜ぶならば、早期の関与が発見される前に、その人が普通ではないことがすでに知られている。

もし人が典型的なロングランユーザーとは一線を画す測定可能な属性を持っているならば、プロジェクトのDAは、先験的にメンバーの最初の5%以内に入ることが予想されるという事実に基づいて反論することができる。議論の全人類人口形態への類推は次のようなものである:現代人や歴史的な人間を主流の外に置く人間の特徴の分布の予測に対する信頼性は、nを調べる前に、それがNの非常に早い時期である可能性が高いことがすでに知られていることを意味する。

例えば、今後生きていく人間の 99%がサイボーグになると確信していても、これまでに生まれた人間のうち、サイボーグになるのはごくわずかだとしたら、少なくとも 100 倍の数の人間が生まれてくると確信していてもおかしくない。

ロビン・ハンソンの論文は、これらのDAに対する批判を要約している

他のすべてのものは平等ではない;我々はこれまでに生きるすべての人の中から無作為に選ばれた人間ではないと考える正当な理由がある。

批判:人間の絶滅は遠い、事後

絶滅レベルの事象が稀であるという事後的観測は、DAの予測が現実的ではないことの証拠として提示される可能性がある。したがって、今後1,000年以内に人類が絶滅する可能性は低いと主張されている。これも確率論的な議論で、DAとは異なる結論を導き出している)。

ベイズの用語では、DAに対するこの反応は、歴史の知識(または災害を防ぐ能力)が、数兆の最小値を持つNの事前限界を生成すると言う。例えば、Nが10^12から 10^13まで一様に分布しているとすると、N=600億から推論されるN<1兆2000億の確率は極めて小さくなる。これは、今後10万年以内に人類が絶滅する可能性のあるメカニズムが存在しないため、「特別な観測者」でなければならないという理由でコペルニクス的原理を否定する、同様に非の打ちどころのないベイズ的計算である。

この反応は、人類の生存に対する技術的な脅威を見落としていると非難されており、DAの学術的な批評家のほとんど(ロビン・ハンソンを除いては論外であるが)によって具体的に否定されている。

事前のN分布は、nが非常に非有益にすることがある

ロビン・ハンソンは、Nの優先順位は指数関数的に分布しているかもしれないと主張している。

ここで、c と q は定数である。qが大きい場合,我々の95%信頼度上限は,Nの指数値ではなく,一様描画上にある.

これをゴットのベイズ的な議論と比較する最良の方法は,確率がNになるほど(反比例するよりも)ゆっくりと落ちるようにすることで,曖昧な事前分布から分布を平坦にすることである.これは,終末の日が時間的に曖昧な事前分布のpdfを持っていて,人類の成長が時間的に指数関数的であるかもしれないという考えに対応している。これは、最後の誕生であるNよりも、次のような分布を持っているだろうということを意味する。

この先行Nの分布は、NからNの推論を生成するために必要なすべてのことである(不推論の原則で)これは、Gottによって記述されているように、標準的な場合と同一の方法で行われる(この分布では 1に相当する)。

事後確率方程式への代入):

xn以上の任意のNの確率を積分する。

例えば、x = 20ならば、 そして、これは、なる。

したがって、この事前分布では、1兆回の出生の確率は、標準的なDAで与えられる5%の確率よりも、20%をはるかに超えている。アルファが,より平坦な先行Nの分布を仮定することによってさらに減少するならば,nによって与えられたNの限界は弱くなる.アルファが1であれば,出生基準階級を用いたゴットの計算を再現することができ,アルファが0.5前後であれば,(母集団が指数関数的に拡大している場合)彼の時間的信頼区間の計算を近似することができる。α→0(小さくなる)につれて、nはNについての情報量が少なくなる。限界では、この分布は、Nのすべての値が等しく可能性がある(束縛されていない)一様分布に近づく。これは、Pageらの “仮定3 “であり、彼らが先験的に否定する理由はほとんどない。(α ≦1を持つすべての分布は不適切な先験であるが,これはGottの漠然とした先験分布にも適用され,有限の母集団の上限を仮定することによって,それらはすべて適切な積分を生成するように変換することができる)。サイズ2Nの母集団に到達する確率は,通常,Nに到達する確率にNから 2Nへの生存確率を乗じたものと考えられるので,Pr(N)はNの単調に減少する関数でなければならないように思われるが,これは必ずしも逆比例を必要としない。

無限の期待値

終末論のもう一つの反論は、予想される総人口が実際には無限大であるということである。その計算は次のようになる。

総人類人口N = n/f、ここでnはこれまでの人類人口、fは全体の中での我々の端数的な位置である。

ここで、fは(0,1)に一様に分布していると仮定する。

Nの期待値は、

反直感的な無限の期待の類似の例については、サンクトペテルブルグのパラドックスを参照

自己指示の仮定。全く存在しない可能性

一つの異論は、あなたが存在する可能性が全くないかどうかは、これまでに何人の人間が存在するか(N)に依存しているということである。これが高い数字であれば、あなたが存在する可能性は、少数の人間しか存在しない場合よりも高くなる。あなたは実際に存在しているのしたがって、これは、これから存在する人間の数が多いという証拠である。

この異議申し立ては、もともとデニス・ダイクス(1992)によって、今ではニック・ボストロムの名前で知られている:「自己指示の仮定の異議申し立て」。いくつかのSIAがn(現在の人口)からのNの推論を妨げていることを示すことができる。

カーブスの反論

カールトン・M・カーブスによるベイズ論は、一様分布の仮定はコペルニクスの原理と相容れないものであり、その結果ではないとしている。

彼は、ゴットの法則がありえないことを主張するために、多くの例を挙げている。例えば,彼は,あなたが何も知らない誕生日パーティーに偶然出くわしたことを想像してみてほしい.

あなたが祝賀者の年齢について親切に尋ねると,彼女は(tp = )50歳の誕生日を祝っているという答えが返ってくる.ゴットによれば,その女性が[50]/39 = 1.28年から39[×50]= 1,950年先まで生き延びることが95%の自信を持って予測できるという。この広い範囲は女性の生存に関する合理的な予想を含んでいるので,「ゴットの法則」では,1/2の確率で100歳以上,1/3の確率で150歳以上の女性が生存すると予測されていることに気づくまでは,それほど悪いことではないように思えるかもしれない。ゴットの法則を使って女性の生存に賭けようと思う人はほとんどいないであろう。以下のカーブスのオンライン論文

この例はJ.リチャード・ゴットの「コペルニクス法」のDAの弱点を暴露しているが(彼は「コペルニクス法」がいつ適用できるかを特定していない)現代のDAと正確に類似しているわけではない;ニック・ボストロムのような哲学者によるゴットの議論の認識論的な洗練は、それを特定している。

絶対的な出生ランク(n)を知ることは、総人口(N)に関する情報を与えてはならない。

この規則で指定された慎重なDAの変種は、女性の年齢は彼女の寿命の推定の前に与えられているので、上記のカーブスの “老婦人 “の例ではありえないことが示されていない。人間の年齢は生存時間の推定値を与えるので(数理計算上の表を介して)カーブスの誕生日パーティーの年齢推定値はこのただし書きで定義されたDA問題のクラスに入ることはできない。

慎重に指定されたベイズDAの同等の「誕生日パーティーの例」を生成するためには、人間の寿命の可能性のあるすべての事前知識を完全に除外する必要がある; 原理的にはそれができる。しかし、これは日常の経験から修正された例を取り除くことになる。日常的な領域でそれを維持するためには、女性の年齢は生存推定が行われる前に隠されなければならない。(これはもはや正確にはDAではないが、それにはるかに匹敵する)。

女性の年齢を知らなくても,DAの推論は,誕生日(n)を50%の信頼度(N)で最大寿命に変換する規則を生成する.ゴットのコペルニクス法のルールは簡単である。Prob (N < 2n) = 50%である。この推定値はどのくらい正確であろうか?西洋の人口統計学は,現在では年齢を超えてかなり均一になっているので,ランダムな誕生日(n)は,U(0,M)の抽選によって(非常に大まかに)近似することができる.この「フラット」モデルでは,誰もが同じ寿命を共有しているので,N = Mとなる.残りの半分の時間は2nがMを過小評価し、この場合(カーブスが彼の例で強調している)対象者は2nの推定値に達する前に死亡する。この「フラットな人口統計学」モデルでは、ゴットの50%の信頼度の数字は50%の時間で正しいことが証明される。

自己言及する終末論の反駁

主な記事。自己言及する終末論の反論

哲学者の中には、終末論(DA)を熟考した人だけが「人間」という参照クラスに属していると提案する大胆な人もいる。それが適切な参照クラスであるならば、カーターは、彼が最初に議論を説明したときに(王立協会に)彼自身の予測を無視した。存在するメンバーは、このように主張している可能性がある。

現在、世界で唯一の1人の人が終末論を理解しているので、独自のロジックでは、それだけで今まで20人が興味を持つようになるマイナーな問題であることを95%の可能性があり、私はそれを無視する必要がある。

Jeff Dewynne氏とPeter Landsberg教授は、このような推論は終末論のパラドックスを生み出すだろうと提案している。

メンバーがそのようなコメントを通過した場合、それは、彼らが実際に2人の人々がそれを理解すると考えられることを十分にDAを理解したことを示すであろう、したがって、40人以上の人々が実際に興味を持っているだろうという5%のチャンスがあるであろう。また、もちろん、少数の人々が興味を持つことを期待しているからといって、何かを無視するのは、非常に短絡的である。

さらに、カーターが彼の議論を提示して説明したので、その場合、彼がそれを説明した人々は必然的であったように、DAを熟考していたと考えられるべきであり、説明の瞬間にカーターが彼自身の予測のための基礎を作成したという結論が導き出される可能性があることを考慮する必要がある。

将来の持続時間と全体の持続時間の混同

様々な著者が、終末論は、将来の期間と全体の期間の不正確な混同に基づいていると主張していた。これは、2つの期間を「すぐに破滅」と「延期された破滅」と指定していることに起因しており、両方の期間が出生順の観測値の後に発生するように選択されていることを意味している。Pisaturo (2009)[12]の反論では、終末論はこの方程式と同等のものに依存していると論じている。

ここで

- X=事前情報。

- Dp=過去の持続時間がtpであるというデータ

- HFS =現象の将来の持続時間が短いという仮説.

- HFL = 現象の将来の持続時間が長いという仮説。

- HTS = 現象の全持続時間が短いという仮説,すなわち,現象の全持続時間であるttを=tTSとする.

- HTL = 現象の総持続時間が長くなるという仮説、すなわち、現象の総寿命である tt が = tTL であり、tTL > tTS である。

Pisaturoは次に次のように述べている。

明らかに、これはベイズの定理の無効な適用であり、将来の持続時間と全体の持続時間を混同している。

Pisaturoは、この式の2つの可能な補正に基づく数値例を取る:将来の持続時間のみを考慮する場合と、総持続時間のみを考慮する場合である。どちらの場合も、短い将来の持続時間に有利な「ベイズシフト」があるという終末論の主張は誤りであると彼は結論づけている。

この議論はO’Neill (2014)[13]にも反映されている。この著作で著者は、一方向性の「ベイズシフト」は確率論の標準的な定式化の中では不可能であり、確率のルールと矛盾していると主張している。ピサトゥーロと同様に、終末論は、観測された出生順の後に発生する終末時間の指定によって、未来の持続時間と全体の持続時間を混同していると主張する。オニールによれば終末論とその「ベイズ的シフト」の主張に対する敵意の理由は、確率論に精通している多くの人が、実際に観測された結果に関係なく、自動的に一方向的に信念がシフトすることができるという主張の不条理さを暗黙のうちに認識しているからである。これは、根底にある推論メカニズムのある種の失敗で生じる「見切り発車の結論への推論」の一例である。議論に用いられている推論問題の検証を行うと、この疑惑は確かに正しく、終末論は無効であることがわかる。(216-217頁)

![P(N \ leq 40 [200000])= {\ frac {39} {40}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/4f7d1d256554fcc75d5f9282171232cb365d870f)

![N = {\ frac {e ^ {U(0,q]}} {c}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/d7fb9f82fbe59cac05f2d337963c9a78b9b13611)

![P(H_ {TS} | D_ {p} X)/ P(H_ {TL} | D_ {p} X)= [P(H_ {FS} | X)/ P(H_ {FL} | X)] \ cdot [P(D_ {p} | H_ {TS} X)/ P(D_ {p} | H_ {TL} X)]](https://wikimedia.org/api/rest_v1/media/math/render/svg/106a88e612192842779aa7d48552cdecabacc3cb)