コンテンツ

Against the singularity hypothesis

https://www.researchgate.net/publication/380490097_Against_the_singularity_hypothesis

https://doi.org/10.1007/s11098-024-02143-5

デイヴィッド・ソースタッド1

受理された: 2024年3月16日

要旨

シンギュラリティ仮説とは、人工知能の未来に関する仮説であり、自己改良型の人工エージェントは、平均的な人間よりも数桁高い知能を持つようになる、というものである。その主張が野心的であるにもかかわらず、シンギュラリティ仮説は一流の哲学者や人工知能研究者たちによって長く擁護されてきた。本稿では、シンギュラリティ仮説が、裏付けの乏しい成長の前提の上に成り立っていることを論じる。シンギュラリティ仮説に対する主要な哲学的擁護が、いかに懐疑的なケースを克服できないかを示す。最後に、この議論が哲学的・政策的に持つ意味を明らかにする。

キーワード

シンギュラリティ仮説 – 人工知能の哲学 – AIの安全性 – 実存的リスク – 技術的成長

1 はじめに

人工知能学会は最近、人工知能の長期的将来について議論するパネルを開催した。そのパネルでは、人工知能がもたらす「機会や課題の広範なスペクトルを見落としたまま、AI研究の急進的な長期的成果にこだわる傾向」を嘆いた(Horvitz & Selman, 2012, p.302)。殺人アンドロイドや超人的なプランナーを含む極端なシナリオに焦点を当てるよりも、バイアス(Fazelpour & Danks, 2021)、透明性(Creel, 2020)、労働市場の歪み(Korinek & Stiglitz, 2019)といった、より実証済みの問題に集中した方がよいだろう。

特に、ある仮説がパネルの怒りを買った。シンギュラリティ仮説は、人工エージェントが自らの知能を向上させる能力を獲得するという仮定から始まる。そこから、人工エージェントの知性は急速に加速度的に成長し、人工エージェントが人間の創造者よりも数桁も高い知性を持つようになるという知性爆発が起こると主張されている。その結果がシンギュラリティであり、人類の歴史における根本的な不連続点として理解され、その先の人類の運命は、人工エージェントとどのように相互作用するかにかかっている。

その主張の野心性にもかかわらず、シンギュラリティ仮説の支持者は後を絶たない。シンギュラリティ仮説は、Chalmers (2010; 2012)やBostrom (2014)といった哲学者たちによって擁護されてきた。同様の擁護は、グッド(1966年)、ソロモノフ(1985年)、ラッセル(2019年)など、人工知能の歴史の基礎を築いた人物によってもなされている。シンギュラリティ仮説は、現代の人工知能研究者のごく少数に支持されている1。この仮説は、Journal of Consciousness Studiesの特集号(Awret, 2012)や数冊のエッセイ(Eden et al.) シンギュラリティ仮説は、意識(Dennett, 2012)、デジタル・マインド(Dreyfus, 2012)、慈善寄付(Greaves et al.) そして、この仮説は学際的な議論を引き付けている(Armstrong et al., 2016; Yampolskiy, 2016)。

こうした取り組みは、人工知能に対する社会の概念に大きな影響を与えてきた。シンギュラリティ仮説は、ヴィンジ(1993年)やカーツワイル(2005年)の人気作品を通じて一般市民の意識に浸透した。シンギュラリティ仮説は、シンギュラリティ人工知能研究所(Singularity Institute for Artificial Intelligence)やシンギュラリティ大学(Singularity University)のような研究機関の主要な研究テーマとなっている(Yudkowsky, 2013)、 2024; MacAskill, 2022; Greaves et al.)

シンギュラリティ仮説は学術的にも一般的にも支持され続けているが、私は、証拠のバランスからすれば、シンギュラリティ仮説の逆の方が正しいと主張する。以下がその計画である。第2節では、シンギュラリティ仮説を厳密に説明する。第3節では、シンギュラリティ仮説の根底にある成長の仮定が野心的すぎると考える5つの理由を述べる。第4節と第5節では、Chalmers (2010)とBostrom (2014)によるシンギュラリティ仮説に対する最近の哲学的議論を検討し、これらの議論が仮説の成長仮定を十分に支持していないことを示す。第6節では、この議論の哲学的・政策的含意を導き出して結論とする。

2 シンギュラリティ仮説の定式化

「シンギュラリティ仮説」という言葉は、様々な形で理解されるようになった。Eden et al. (2012)に従い、シンギュラリティ仮説には3つの要素があると仮定する。第一に、量を特定する。第二に、この量が加速度的に成長すると主張する。そして第三に、加速度的な成長が人類史の不連続性をもたらすと主張する。これらの各構成要素を詳細に説明することで、私が関心を抱いているシンギュラリティ仮説のバージョンを明らかにする3。

2.1 どの量か?

私が関心を抱いている量は知性である。より具体的には、人工エージェントの一般的な知性は、再帰的な自己改善のプロセスを通じて成長するという主張に興味がある。これはおそらく、I.J.グッドによって哲学者に紹介された特異点仮説の最もよく知られた形である:

超知的機械とは、どんなに賢い人間の知的活動を遥かに凌駕する機械と定義しよう。機械の設計も知的活動の一つであるから、超知的機械はさらに優れた機械を設計することができる。そのとき、間違いなく「知性の爆発」が起こり、人間の知性ははるか後方に取り残されるだろう(Good, 1966, p.33)。

グッドの主張は、一般的な知性という明確な概念が存在し、この概念を人工的なエージェントに首尾一貫して適用できると仮定すれば、最も自然に理解できる。そして、自己改良型機械の一般知能が加速度的に成長することを期待すべきであるという主張である。

ここで言うべきことはまだたくさんある。多くの論者が、一般知能という概念の説得力(Nunn, 2012; Prinz, 2012)や、人工システムが意味のあるレベルの一般知能を獲得する可能性(Dreyfus, 2012; Landgrebe & Smith, 2022; Lucas, 1964; Plotnitsky, 2012)について疑問を呈している4。対照的に、私はシンギュラリティ仮説の虚偽性は議論の余地のないものだと考えている(異論もあるだろうが)。したがって、私は議論のために、一般知能という概念の説得力と、人工エージェントの一般知能が人間の知能に近づく可能性があるという仮説の両方を認める用意がある。

私の懐疑論は、シンギュラリティ仮説の野心的な成長の仮定に集中することになるが、1つだけ例外がある。例えば、人工エージェントの知能は過去50年間で3,300万倍に成長した(3.5節)などである。ここで、このような主張が真実であると同時に、シンギュラリティ仮説の提唱者が必要とする役割を果たすことができるような、知性という概念の明確化を求めるのが適切であろう8。3.5.

2.2 加速する成長

シンギュラリティ仮説は、人工エージェントの一般的な知能が加速度的に成長する時期が持続すると仮定している。これは強力な仮説であるが、この仮説の強さは成長率をどのように測定するかによって決まる。通常、成長率とは相対的な成長、つまり時間経過に伴う量の変化率を指す。例えば、知能が1単位から2単位に変化した場合、知能が2単位から4単位に変化した場合と同じ成長率になる。より稀なことだが、成長率とは絶対成長という弱い概念、つまり時間経過に伴う量の大きさの変化、つまり例えば知能1単位から2単位への変化は、知能2単位から3単位への変化と同じ成長率を表す。

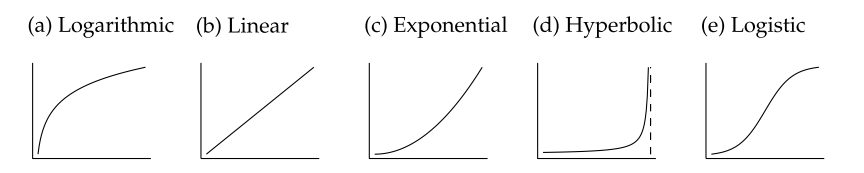

絶対的な理解でも相対的な理解でも、人工知能が加速度的に成長すると言うことは、対数成長(図1a)や線形成長(図1b)のような多くの馴染みのある成長タイプを除外することになる。しかし、指数関数的成長(図1c)については、これらの理解は異なっている。指数関数的成長の持続は、非常に強い成長の仮定であるが、それでも、指数関数的成長は、成長率が絶対成長率に追従するという弱い理解の上で、加速する成長率を表しているに過ぎない。そして実際、指数関数的成長は速いかもしれないが、知性の爆発に求められる質的な振る舞いを生み出すには十分な速さではないことが多い。例えば、仮に知能が年率2%で指数関数的に成長したとすると、知能が3桁成長するには350年近くかかることになる。仮に知能が2年ごとに2倍になったとしても、知能が3桁成長するには20年かかる。このため、指数関数的成長を用いて知能の爆発をモデル化する著者もいるが(Chalmers, 2010)、ほとんどの著者は、知能の爆発にはさらに速い成長様式が伴うと理解している。

7 例えば、Graceら(2016)の回答者の中央値は、40年以内に人間レベルの人工知能が誕生する可能性を50%、100年以内に誕生する可能性を90%としている。同様に、Müller and Bostrom (2016)が実施したAI研究者へのアンケート調査の回答者の中央値は、2050年までに50%、2070年までに90%の確率で人間レベルの知能が実現すると回答している。いつものことだが、このデータの解釈には若干の困難があり、特にGraceたちは、質問の組み立て方に中程度の感度があることを発見した。

8 知能を定量化する1つの方法として、Chollet(2019)の「事前知識、経験、汎化の難易度に関するタスクの範囲におけるスキル習得の効率性」という知性の理解を採用することが考えられるが、おそらくCholletが提案するように、Abstraction and Reasoning Corpus(ARC)データセットをベンチマークとすることが考えられる。しかし、知能の他の運用を好む読者は、そのような見解を念頭に置いて本稿を読んでいただきたい。

図1 成長様式:時間経過に伴う知能

知能の爆発を示す最も一般的なモデルは、有限時間で垂直漸近線に近づく双曲線的成長(図1d)を伴う(Bostrom, 2014; Solomonoff, 1985)。双曲線的な成長は、相対的な理解においても絶対的な理解においても加速度的な成長を構成しており、まさにこの理由から、双曲線的なモデルがどれほど強い成長を前提としているかを誇張することは難しい。例えば、ボストロム(2014)のモデルでは、知能は7.5ヶ月で2倍になり、17.9ヶ月で1000倍に成長し、18ヶ月で無限大に近づく。ある意味では、これらの数字はまだ保守的すぎるかもしれない。ボストロムは、人工知能の「速い」離陸を数分、数時間、数日以内に起こるものと定義し、「中程度の」離陸を数ヶ月、数年以内に起こるものと定義している。ボストロムは、速い離陸や中程度の離陸が起こる可能性は高いと主張している。これらは強力な成長の仮定であり、それに対応する強力な論拠が必要である。

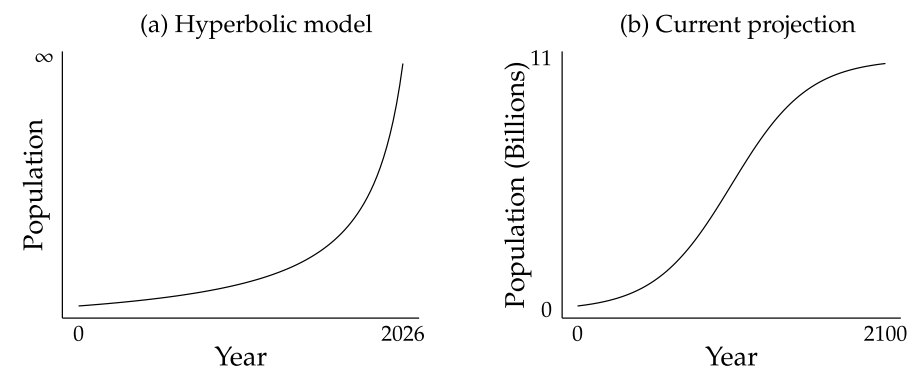

シンギュラリティ仮説は、双曲線的または指数関数的な成長の持続期間を仮定していることに注意することが重要である。これは重要なことである。なぜなら、多くの物量はしばらくの間急速に成長するが、その後はロジスティック成長(図1e)のような穏やかな成長モードに戻るからである。成長を加速させる過去のトレンドを前倒しで予測すると、成長が平坦化する可能性を無視する危険性がある(Modis, 2012)。例えば、経済モデルによれば、20世紀の大半において、世界人口は指数関数的、あるいは双曲線的に増加し、1900年の16億人から1975年には40億人にまで増加した(図2a)。この時期の有名なモデルの1つは、双曲線的な成長を続けると、2026年までに人口が無限に増加するとしていた(Von Foerster et al., 1960)。しかし、双曲線的な人口増加が続くと予測したのは、マルサス的な誤りであっただろう。現在、世界人口は2100年までに約110億人で横ばいになり(図2b)、おそらくその後は減少に転じると予測されている(United Nations, 2019)。結局のところ、急激な成長加速期として始まったものは、総人口への影響が比較的緩やかなまま終わることになる。

人口増加のケースは、知能が何桁も大きくなっても、高い成長率が持続するという前提の重要性を明らかにしている。持続的成長という仮定は、現在の成長率を将来にわたって無限に予測することによっては成り立たない。人口増加に関する議論で明らかになったように、急激な成長率は時間の経過とともに落ち着くことが多いからである。シンギュラリティ仮説の支持者は、人工エージェントの知能が現在指数関数的または双曲線的な速度で成長しているだけでなく、知能が何桁も成長するにつれて高い成長率が続くと主張しなければならない。これはより強力な主張である。この主張の強さは、加速度的成長がもたらす人類史の不連続性の大きさを考えることで浮き彫りになる。

図2:人口増加

2.3 不連続性

この加速成長期はいつまで続くのだろうか。シンギュラリティ仮説は、少なくとも歴史の根本的な不連続点に達するまでは成長が続くと仮定している。すべてが順調に進めば、人工システムは、生きているすべての人間のコピーを、自分自身の本格的なデジタル・シミュレーションとしてアップロードするのに十分な能力を持つようになると考えられている(Chalmers, 2010)。そうなれば、人類はデジタルの形で生き続けることになる。そして、すべてがうまくいかなくなった場合、人工エージェントは、人類を自由に絶滅させたり、無力にしたり、無関係にしたりできるほど強力になると予測されている(Bostrom, 2014)。このような意味合いについては第6章で詳しく説明するが、とりあえず、このような発展をもたらすためには、どれほどの知能の成長が必要なのだろうか?

意見は様々だが、シンギュラリティ仮説の提唱者の多くは、平均的な人間よりも数桁高い知能を持つ機械を想定している。例えば、Richard LoosemoreとBen Goertzelは、「人間のレベルより2~3桁高い一般知能のレベル」(Loosemore & Goertzel, 2012, p.86)を最低目標とし、Chalmersは、「最も知能の高い人間がネズミを超えるのと同じくらい、少なくとも最も知能の高い人間を超える」(Chalmers, 2010, p.11)機械を考えている。想定される未来は、人工エージェントが人間に匹敵するまでに成長するものではなく、人工エージェントが未改造の人間をはるかに置き去りにするものである。

まとめると、シンギュラリティ仮説は、自己改良型人工エージェントの一般知能が持続的に成長する時代を想定している。知能の成長は加速度的に進み、指数関数的、あるいは双曲線的な成長が長期化する。この成長は、人類の歴史に根本的な断絶が訪れ、人類の運命が我々よりも桁違いに知能の高い人工エージェントに支配されるまで続くだろう。

これらは強力な主張であり、それに見合う強力な論拠が必要である。第4節と第5節では、その根拠となる2つの主張について述べる。4と5では、シンギュラリティ仮説に対する2つの代表的な哲学的擁護が、シンギュラリティ仮説に大きな説得力を与えないことを論じる。それぞれのケースにおける私の回答は、特異点仮説の成長主張に対する懐疑の理由に焦点を当てる。そのため、私の最初のプロジェクト(第3節)では、特異点仮説の成長主張に懐疑的である5つの理由を導き出す。4と5である。これらの懐疑的な理由は、特異点仮説が物理的に不可能であることを意味するものではなく、その代わりに、特異点仮説の支持者に、仮説を支持する強力な論拠を提示する責任を課すものである。4と5では、この負担はまだ果たされていないと論じている。

3 懐疑論への反論

シンギュラリティ仮説に対する既存の反論は、多くの場合、二つの戦略のうちの一つを追求している。第一に、一般的知性という概念の説得力や、目下の事例への適用可能性を押し付ける(Nunn, 2012; Heylighen, 2012; Prinz, 2012)。第二に、人工システムがすぐに人間レベルの知能に到達することを否定している(Dreyfus, 2012; Landgrebe & Smith, 2022; Lucas, 1964; Plotnitsky, 2012)。シンギュラリティ仮説に対する抵抗の別の原因を探りたい。それは、シンギュラリティ仮説の成長の仮定に疑問を呈することである。本節では、シンギュラリティ仮説の根拠となる知性の成長率に懐疑的である5つの理由を挙げる。そして第4節と第5節では、シンギュラリティ仮説の根拠となる知性の成長率に懐疑的な5つの理由を述べる。4節と5節では、シンギュラリティ仮説に対する代表的な哲学的擁護は、成長率に対する懐疑を覆すものではないことを論じる。

3.1 異常な主張には異常な証拠が必要である

シンギュラリティ仮説は、人工エージェントの知能が指数関数的または双曲線的に持続的に成長し、少なくとも人間がマウスを超えるのと同じくらい、機械の知能が人間を超えるまで続くと仮定している。持続的な超高速成長が物理的に可能であることを示すだけでは十分ではない。シンギュラリティ仮説の提唱者は、彼らが主張する成長速度の異常性にもかかわらず、その成長速度が実際に人工知能の将来の成長を表していることを疑うに足る多くの理由を我々に提供しなければならない。この証拠能力が満たされるまでは、シンギュラリティ仮説の主張する成長率が異常であることを理由に、シンギュラリティ仮説の信憑性は低いと考えるのが妥当である。

3.2 良いアイデアを見つけるのが難しくなる

深い池で代わり映えのしない釣りをしているとしよう。最初は魚を釣るのは簡単だ。釣った魚は浅瀬に棲み、簡単に食いつく。しかし、時間が経つにつれて、釣れるまでの時間が長くなる。池に残された魚はより抜け目なくなり、水中深く棲むようになる。魚を釣るのは数分の問題から、数時間、数日、数週間の問題になる。

多くの社会科学者は、ある一点を超えると、ほとんどすべてのアイデア創出プロセスが釣りのように振る舞うと考える。低空飛行の果実が摘み取られるにつれて、良いアイデアを見つけることは難しくなる(Bloom et al., 2020; Kortum, 1997; Gordon, 2016)。研究生産性は、一定のアウトプットを生み出すのに必要な研究投入量として理解され、その後発見されるたびに低下する。研究生産性は、当初は一定か、あるいは上昇する可能性もあるが、多くのアイデア創出プロセスでは、研究が進むにつれて研究生産性が低下していくという見方が一般的である10。また、1971年から1991年までの20年間で、先進国のインフレ調整後の農業研究費は60%以上増加したが、1エーカー当たりの作物収量の伸びは15%低下した(Alston et al.) 問題は、研究者が怠け者や低学歴、高給取りになったことではなかった。むしろ、良いアイデアを見つけるのが難しくなったのである。数十年前の研究者たちは、有望な薬剤や農業技術の改善策を数多く発見したが、後の研究者たちはより複雑な介入策を探し回ることになった。良いアイデアを見つけるのが難しくなるにつれ、研究の生産性は低下した。

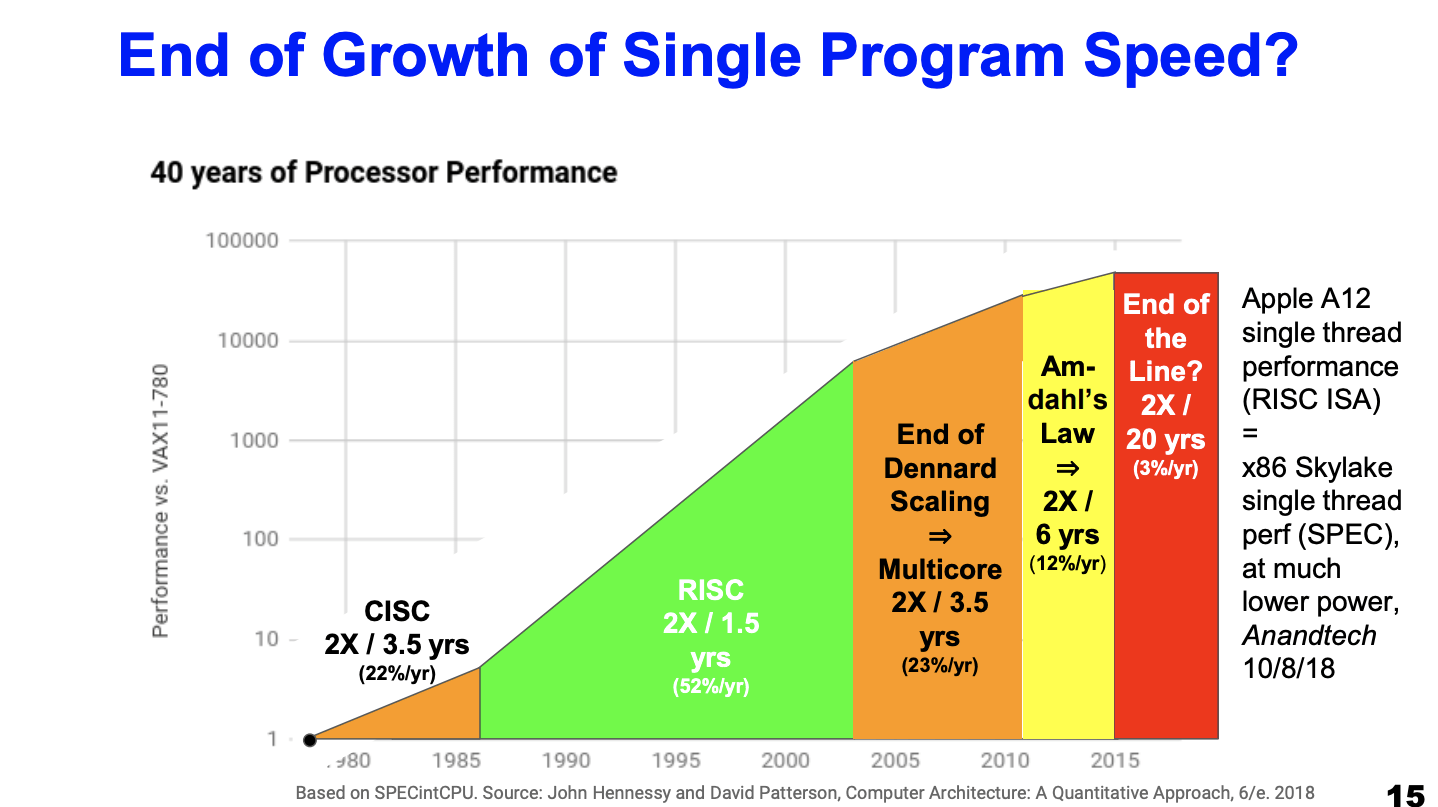

人工授精剤の改良問題は、研究生産性の低下というルールの例外になり得るのだろうか?最近の歴史は、そうでないことを示唆している。1971年から2014年にかけて、ムーアの法則は、半導体研究に費やされた労働力と資本の天文学的な増加によって、半導体研究の生産性が18倍も低下する中で維持された(Bloom et al.) この状況は持続不可能である。多くの予測者は、ムーアの法則はこの10年で終わると考えており、残りの大部分も、ムーアの法則はすでに終わったと考えている(Mack, 2011; Shalf, 2020; Theis & Wong, 2017; Waldrop, 2016)。ハードウェアの成長ペースの低下は、研究生産性の低下が自己改良型人工知能に関連することを示すもう一つの証拠である。

人工エージェントの改良という問題に特別なものがないとしても、この問題を扱う研究者に何か特別なものがあるのだろうか?おそらく、研究生産性の低下は人間の研究者を苦しめるが、人工エージェントは苦しめないのだろう。研究生産性の低下の原因の一つは、人工エージェントの得意とする知識ストックを大量に維持することの難しさである(Jones, 2009)。しかし、根底にあるフィッシング・アウトの問題は、エージェントではなく問題の特徴であり、人工エージェントを研究者として採用することで解消できるものではない。しばらくすると、どのような賢明な調査プロセスであっても、最も簡単な発見がその割合以上になされるようになり、その後の発見は難しくなる。それを過ぎると、研究の生産性は低下する。シンギュラリティ仮説を支持する多くの論者でさえ、この点を認めており、研究生産性の逓減を知性の成長モデルに直接組み込んでいる(Davidson, 2021; Roodman, 2020)。

研究生産性の低下は、現在の知識を飛び越え、飛び越え、飛び越えようとする研究過程に深刻な脅威を与えることはないかもしれないが、人工知能を現在の枠から何桁も超えようとする研究過程には脅威となる。研究の生産性が低下する割合が比較的小さくても、自己改良のサイクルを何度も繰り返すうちに、その割合が非常に大きくなり、知能の成長率に大きな下降圧力がかかることになる。

3.3 ボトルネック

成長プロセスが減速するのは、ボトルネックにぶつかるからであることが多い。たった一つのボトルネックが、成長を遅らせるのに十分なのである。

この点を強調する1つの方法は、Philippe Aghion氏らによるものである(Aghion et al. これらのプロセスは、順に、より初歩的な計算などのサブコンポーネントに分かれていく。アルゴリズムが最も遅い構成要素よりも速く実行できないことは、不変の数学的事実である。もし、構成プロセスの10分の9は高速化できても、残りのプロセスは高速化できないとすると、アルゴリズムは10倍しか高速化できないことになる。このため、すべてのプロセスを一度に高速化できない限り、ボトルネックが発生する可能性がある。

ボトルネックが発生すると予想される理由のひとつは、さまざまなソフトウェアやハードウェアのコンポーネントを改善する余地がどれほどあるかが不明確であることだ。ソフトウェアから始めると、コンピューター科学者や数学者は非常に長い間、探索などのアルゴリズムやニューラルネットワークなどのアーキテクチャに取り組んできた。改善の余地があることは間違いないが、アルゴリズムやアーキテクチャがすでに達成可能な最高の性能に達しているのであれば、それらをより高速化するためにできることは限られている。次にハードウェアに目を向けると、ボトルネックになると予想される理由のひとつは、3.4節で議論する物理的リソース制約の多くが、その克服に時間を要することである。3.4で説明する物理的資源制約の多くは克服に時間がかかる。ハードウェアの改良には、主要材料の採掘、製造プラントの建設、資本設備の構築、大量のエネルギーの生成と分配が必要である。これらのプロセスを高速化することは可能かもしれないが、一夜にしてそのすべてが何千倍も効率化されることを期待するのは無理がある。また、1つのプロセスでさえスピードアップに抵抗すれば、再帰的自己改善のシステム全体が遅れてしまうかもしれない。高速で持続的な再帰的自己改善のプロセスを仮定するには、自己改善の主要なボトルネックがすべて克服されるという強い前提が必要である。可能性が高いが、いくつかのボトルネックが残っている場合、再帰的自己改善のプロセスは遅くなる。

3.4 物理的制約

自然界における急速な成長プロセスが停止する理由の1つは、有限な資源や物理法則などの物理的制約に突き当たることである。この点を文脈で理解するために、ほとんどの専門家がムーアの法則が終焉を迎えつつあると考える理由を考えてみよう。なぜ、回路あたりのトランジスタ数が隔年で倍増し続ける可能性が低いのか?

最初の課題は、リソースの制約である。一定の面積により多くのトランジスタを詰め込むことで、計算中に回路に供給しなければならないエネルギー量が大幅に増加している(Mack, 2011)。このようなエネルギー需要は高価なだけでなく、安全性にも問題がある。現在の技術では、回路をオーバーヒートさせずに通過させることができるエネルギーは限られている。エネルギーに加えて、資本も不足している(Waldrop, 2016)。新しい半導体工場のコストは数十億ドルに膨れ上がり、さらに資金を投入してハードウェアの目標を達成し続けることはますます難しくなっている。

リソースの制約に加えて、我々は物理学の基本法則にも立ち向かっている。例えば、我々の最高の回路は、直径が典型的な原子の10倍しかないトランジスタを使っている(Yeap et al.) トランジスタのサイズが素粒子に向かって急降下するにつれて、縮小するトランジスタの製造や相互作用はますます困難になり、以前は無関係だった量子の不確定性現象が、トランジスタのサイズに対する潜在的な制限として生じてくる。

ムーアの法則の終焉は、自己改良型人工知能の進歩にとって重要な教訓となる。人工知能を向上させるための実行可能な道筋は、いずれリソースの制約や物理法則にぶつかり、簡単には乗り越えられない。場合によっては、既存の物理的制約を回避する新しい資源や方法を見つけることができるかもしれない。しかし、そうしている間、そしておそらくそれ以後も、成長は鈍化すると予想される。

3.5 入手可能な改良による知能成長の非線形性

シンギュラリティ仮説がもっともらしく思える理由の一つは、近年、処理速度、記憶力、探索深度などの量が急速に向上していることである。もし知能がこれらの量に比例して成長するのであれば、指数関数的な知能の成長には、現在の傾向を継続する以上のことは必要ないはずである。しかし、そうではない。知能の関連概念は、最近の成長の対象である処理速度などの基礎的な量において、非線形的に成長するのである。

この点を理解する1つの方法は、知能ともっともらしく相関しそうなパフォーマンス指標を考えてみることである。ここでの話は驚くほど一貫している。例えば、Thompson et al.(2022)は、コンピュータゲーム(チェス、囲碁)と、高度な計算に大きく依存する3つのタスク(タンパク質折り畳み、気象予測、地下石油貯留層のモデル化)における性能向上を調査している。各領域において、トンプソンらは、時間経過とともに適用される計算能力の量が指数関数的に増加することを発見したが、チェスや囲碁のELO評価、タンパク質折り畳み問題を解く能力、天候パターンや石油埋蔵量を予測する能力などの指標においては、直線的な増加に過ぎなかった。このことから、コンピュータの基礎となる能力が指数関数的に向上しても、知能に関連するタスクはせいぜい直線的にしか向上しないということがわかる14。

性能測定基準からの議論に対する自然な反論は、状況を改善するのにほとんど役に立たない。おそらくシンギュラリティ仮説の擁護者は、問題のメトリクスはすべて知能と不完全な相関しか示さないと反論するかもしれない。しかしその場合、指数関数的に増加する一貫したパターンを示す代替指標を提示することは歓迎される。今のところ、もっともらしい指標は提示されていない。あるいは、性能向上のペースが遅いのは、連続的な改良の難易度が上がっているなど、無関係な要因によるものだという反論があるかもしれない(3.2節)。しかし、仮にそれが真実であったとしても、問題を解決するのではなく、単に問題を置き換えるだけであろう15。

知能は基礎的な能力において非線形的に成長すると考えるもう1つの理由は、ムーアの法則による。過去50年間で、私たちの最も優れた回路に使われているトランジスタの数は、1972年の3500個から2022年には1140億個に増加し、他のハードウェアの能力も同様の伸びを示した。もし知能がハードウェア容量の関数として直線的に成長すると考えれば、コンピュータはこの間に3,300万倍の知能を持つようになったと言わざるを得ない。

多くの読者は、この主張があり得ないと思うかもしれない。シンギュラリティ仮説の提唱者がこのような主張をしたいのであれば、2つのことをする必要がある。第一に、このような規模の知性の増大が起こったとする根拠となる知性の概念を明確にすることである。そして第二に、関連する知能概念が、彼らの見解が要求する仕事をどのようにこなすことができるかを説明する必要がある。例えば、知能の向上が知的エージェントを設計する能力の向上に比例することを期待する理由(第4節)や、平均的な人間よりも数桁高い知能を持つエージェントに印象的で神のような力を与える理由を説明する必要がある(第6節)。

その代わりに、知能の関連概念が基礎となる計算能力において非線形に成長するのであれば、知能の指数関数的な成長には基礎となる計算能力の超指数関数的な成長が必要となる。双曲線的な成長は?聞いてはいけない。

3.6 シンギュラリティ仮説に対する反論のまとめ

シンギュラリティ仮説は、人工知能の爆発的な成長が持続すると仮定している。このセクションでは、この仮説が主張する成長に懐疑的である5つの理由を紹介した。第一に、シンギュラリティ仮説は異常な主張をしており、それに見合った異常な証拠を必要とする。第二に、時間が経てば経つほど、さらなる改良のためのアイデアを見つけるのが難しくなる。第三に、成長へのボトルネックが一つでもあれば、知性の爆発を止めるのに十分である。第四に、資源の制約を含む多くの物理的制約が、成長の道を閉ざすだろう。そして最後に、人工知能の急速な成長には、メモリや計算速度といった基礎的な量が底知れぬ速さで成長することが必要かもしれない。

シンギュラリティ仮説の擁護者は、その主張が乗り越えなければならない障害に照らし合わせて、彼らの成長主張を受け入れる強い理由をわれわれに示す義務がある。次の2つのセクションでは、シンギュラリティ仮説に対する代表的な哲学的抗弁を概観する。これらの擁護は、特異点仮説の成長主張に対する懐疑論を克服するには弱すぎると主張する。

4 観測的議論

Chalmersは、「知性の増加は、知的システムを設計する能力の増加に比例する」(Chalmers, 2010, p.21)という比例仮説を提唱し、シンギュラリティ仮説を支持している。比例仮説が真実であるならば、各AIシステムは少なくとも後継システムと同程度の向上を遂げるはずであり、こうした向上が十分に迅速にもたらされる限り、知能の爆発的な増加につながることになる。

第3節では、成長率が低下する可能性が高いことを示唆したが、この文脈では、人工知能の向上は、人工システムを設計する能力において、最終的には比例しないほどの向上をもたらすはずであることを意味する。チャルマースは、少なくとも自己改良を何度も繰り返すまでは、成長率が低下することを否定しなければならない。この点に関する懐疑的な理由を考えると、成長率の逓減に対する拡張的な議論を期待したくなる。チャルマーズの議論はもう少し圧縮されている:

どちらかといえば、知能に関連する能力の10%向上は、あらゆる種類の知的ブレークスルーを引き起こし、10%を大幅に上回る次世代の知能向上をもたらす可能性が高い。人間であっても、設計能力の比較的小さな差(例えば、チューリングと平均的な人間の差)は、設計されるシステムの大きな差(例えば、コンピュータと重要なものの差)につながるようだ。(Chalmers, 2010, p.27)。

最初の文章は比例性テーゼの再述であり、議論の重荷は2番目の文章にある。この文章でチャルマーズは、チューリングと平均的な人間との差というたった一つの観察データを用いて、比例論を全面的に擁護している。これを観察論と呼ぶ。

観察論には2つの課題がある。第一に、グローバルではなくローカルであることだ。人工知能の歴史におけるある瞬間を指し示し、この局所的な時点において、機械設計者の知能の向上が、結果として生じるシステムの知能を比例以上に向上させたと主張する。局所的な議論の問題点は、曲線上の一点での成長率しかサンプリングしていないため、持続的な高成長の可能性を実証できないことである。シンギュラリティ仮説に懐疑的な人々は、人工知能の歴史において比例仮説が成り立つ時点があったことを否定しているわけではない。我々が否定するのは、比例仮説が長い再帰的な自己改良の過程を通じて維持され続けるということである。成長率に関するたった一つの局所的な観察は、その成長率がいつまでも続くという証拠にはならない(Dreyfus, 2012)。

さらに、チャルマースがサンプリングした局所点は、成長率が低下する可能性を最大限に軽視するように選ばれている。コンピューティングの歴史のごく初期における成長率を考慮することで、チャルマーズは、低くぶら下がる果実が使い尽くされたり、資源が枯渇したり、ボトルネックに遭遇したりする可能性が高い前の時点をサンプリングしており、成長率の逓減に関する最良の議論の多くを回避している。初期段階の研究が、しばしば一定の、あるいは増加する成長を示すことは容易に認めることができる。

観測的な議論に対する2つ目の懸念は、知能と設計能力を同一視していることである。引用されているデータは、チューリングと平均的な人間の設計能力のわずかな差が、設計されたシステムの知能に大きな差をもたらしたというものである。チューリングと同時代の研究者の多くが、チューリングよりも知性は高かったが、知的システムを設計する能力ははるかに低かったことを否定するつもりはないからだ。したがって、この議論から得られる結論が、知能の向上は知的システムを設計する能力の向上に比例するというものであることは明らかではない。そうでなければ、なぜチューリングよりも知能の高い多くの人々が、チューリングのような知的システムを設計する能力を欠いていたのかを説明しなければならなくなる。

さて、チャルマーズが指摘するように、知性に関する言及をすべて他の用語に置き換えても、同じようにうまくいくだろう。つまり、チューリングと平均的な人間との設計能力のわずかな差が、設計されたシステムの設計能力に大きな差をもたらした例と考えれば十分なのである。しかし、この推論は両者とも失敗する。チューリングが設計したシステムに設計能力が全くなかったことは明らかではない。また、チューリングと平均的な人間の設計能力の差が小さいという表現が適切であることも明らかではない。実際、チューリングの設計努力は、彼の設計能力が平均的な現代人の設計能力をはるかに凌駕していることの証拠であると考えるのが正しいかもしれない。

本節では、知能の向上は知的システムの設計能力の向上に必ず比例するという比例論に基づき、シンギュラリティ仮説の論拠を検討した。われわれは、比例テーゼが成立する歴史的な例としてチューリングの初期の進歩を挙げた、比例テーゼに対するチャルマーズの観察的議論を検討した。しかし、この議論は2つの点で苦戦している。それは、グローバルな議論ではなくローカルな議論であること、そして知性と設計能力の間を等閑視していることである。したがって、チャルマーズの観察論は特異点仮説を正当化するものではない。

5 リカルシトランスと最適化能力

Bostrom (2014)は、人工知能の変化速度は2つの量によって左右されると主張している。1つ目は、最適化能力、つまり人工システムの改善に適用される品質加重設計努力の量である。2つ目の量は、知能の成長の反動性であり、現在のマージンで知能の単位変化を生み出すために適用しなければならない最適化パワーの量である。最適化パワーとリカルシトランスについてこのように理解すれば、知能は最適化パワーとリカルシトランスにおいて分数的に成長する:

知能の変化率 = 最適化パワー ÷ リカルシトランス(不可操作性)

リカルシトランスが低い状態が持続している間に、大量の最適化能力が適用されれば、その結果、知性は爆発的に向上する。

ボストロムの研究の歓迎すべき点は、ボストロムが、低いリカルシトランスと高い最適化力が得られると 予想される具体的な理由を数多く提示していることである。これにより、ボストロムの提案を詳細に検討することができる。しかし、悪魔は細部に宿るものであり、本節では、ボストロムが提唱する低再従順性と高最適化能 力に関する実証的根拠が不十分であることを論じる16 。

より具体的には、ボストロムが提示した詳細は3つのカテゴリーに分けられると主張する。最初の、そして最も大きな分類は、未来がどのように発展していくかについての、ありふれた、しかしもっともらしい記述であり、それが知能爆発の可能性を支持するように過剰に解釈されている。2つ目のクラスは、シンギュラリティ仮説の背後にある核心的な希望を薄く詳述したものである。そして3つ目は、過去の歴史的傾向の事実誤認による解釈である。私は、ボストロムの議論は詳細であるにもかかわらず、高い最適化能力と低いリカルシトランスを併せ持つ持続的な期間について、十分な裏付けを提供できていないと結論づける。

5.1 もっともらしいが過大解釈されたシナリオ

ボストロムは、知能が持続的に成長する期間を通じて、リカルシトランスが低いままであると考える5つの理由を提示している。これらの提案のうち3つはもっともらしいが、知能爆発が起こる可能性を大きく裏付けるものではない。第一に、人工知能が全脳のエミュレーションを通じて到達し、最初の人間レベルの人工知能が人間の脳1個のコンピュータによるエミュレーションであると仮定する17。しかし、最初のエミュレーションが出来上がると、急速な改良を重ねるにつれて、リカルシトランスは低下する。例えば、神経表現を粗視化することでアルゴリズムを単純化し、より高速に実行できるようにするかもしれない。あるいは、異なる個体の脳をエミュレートして、利用できる人工エージェントのストックを増やすかもしれない。

これは、低反抗期が持続する可能性を過剰に解釈した、詳細かつ全くありえないわけではないシナリオの最初の例である。全脳エミュレーションは、他の新技術と同様、一度導入されれば改良される可能性があることは間違いない。また、最初の改良が、低いところにある果実を利用することで急速に進む可能性があることにも疑問の余地はない。しかし、このような改良が、強力な超知性をもたらすのに十分な速さ、強力さ、持続性を持つとは考えられない。確かにそうである、

ボストロム自身も、エミュレーション技術の改善はすぐに収穫逓増期に突入する可能性があると認めている。

人工知能がどのように改善されるかを示す2つ目の例は、ボストロムが「コンテンツの改善」と呼ぶもので、コア・アルゴリズムの変更を超えたソフトウェアの改善である。ボストロムは知識ストックの増加を例に挙げている。小さなデータベースで訓練されたエージェントは、国会図書館全体のような大規模なデータセットで訓練することによって改善されるかもしれない。ここでもまた、改善のための詳細かつ比較的妥当なシナリオが示されているが、人工知能の成長には限定的な意味しか持たない。より大きなデータセットでエージェントを訓練する傾向があること、データセットの改善は人工エージェントの能力を向上させる良いツールであることは、ボストロムの言う通りである。しかし、そのような改良がインパクトのあるものであるとしても、国会図書館全体を吸収することでさえ、突然超知能が出現すると疑う理由は与えられていない。実際、この点については疑問の余地がある。結局のところ、国会図書館はすでに人類の集合的知識ストックの一部であるが、この知識は我々をここまで導いてくれたに過ぎない。

人工知能がどのように改善されるかの3つ目の例は、ハードウェアの改善である。ここで3つ目の、そして最後の例として、知能が爆発的に向上する可能性は低いが、その可能性は高いものに遭遇する。第3節で見たように、人工システムはすでに爆発的な知能爆発を経験している。3では、人工システムはすでにハードウェアの急速な成長を持続的に経験しているが、この成長だけでは天文学的な利益は得られなかったことを見た。また、多くの専門家が、ハードウェアの成長ペースは加速するどころかむしろ鈍化すると予想していることから、ハードウェア容量の増加を訴えても、知能の成長速度が速まることの説得力のある証拠にはなりそうもない。

5.2 核心的希望を再確認する

ボストロムは、知能が持続的に成長する期間中、リカルシトランスが低水準に保たれると考える根拠をさらに2つ提示している。第一に、ボストロムは、人工知能は巧妙なソフトウェアの洞察力によって一回の飛躍で生み出される可能性があることを示唆している。もし我々が超知能から1回のプログラミングで飛躍的に進歩するのであれば、地下室にいる一人のプログラマーが、いつか知能の爆発を起こし、完成させるかもしれない。そして第二に、ボストロムは、知性の爆発は処理方法の転換によって起こるかもしれないと示唆している。今現在、人工エージェントは主にその領域全般の推論能力を向上させることによって進歩しており、人工エージェントの領域全般の推論能力が優勢になり始めると、人工エージェントはその領域全般の推論能力を自分自身の改善の問題に向けることができるようになり、その結果、知能が急速に成長するということである。

これらの提案はいずれも楽観的な希望を表明しているが、さらなる証拠がなければ、シンギュラリティ仮説の核心的な主張の域を出るものではない。もちろん、ひとつのソフトウェア的洞察が超知性を生み出す可能性はある。また、人工エージェントがある一定レベルの領域一般推論能力に達すると、1つまたは一連の迅速なソフトウェア的洞察によって自らを向上させる可能性もある。しかし、これらの主張を単なる可能性から科学的信憑性へと引き上げるには、それが実現する可能性が高いと考える根拠を示す必要がある。そして、これまでのところ、ボストロムはどちらの主張にも根拠を提示していない。

5.3 歴史の誤った解釈

知性の爆発を引き起こすためには、知性向上のリカルシトランスはどの程度低くなければならないのであろうか?ボストロムは、最適化能力は人工システムの知性に比例して直線的に増加し、知性が2倍になったシステムは最適化能力も2倍になると仮定するよう我々に求めている。これは一見、チャルマーズの比例性テーゼのより妥当なバージョンのように思われる。しかし、ボストロムは、このような仮定を置いた場合、一定のリカルシトランスと知能と最適化能力の直線的な関係を組み合わせたとしても、指数関数的な知能の成長しか生まれないと指摘している。

ボストロムは、双曲線的な成長を実現するために、チャルマーズよりも強力なモデル化の仮定を置いている。すなわち、リカルシトランスがエージェントの現在の知性のレベルIに反比例して変化し、リカルシトランスが1/Iに等しくなるという仮定である。このモデルでは、確かに知能の爆発が起こる。エージェントがより賢くなればなるほど、さらなる進歩が容易になり、人工知能は双曲線的に成長する。

しかし、リカルシトランスが急速に減少するという仮定は、正当化を必要とする驚くべき主張である。ここでボストロムはムーアの法則に訴える:

システムがそれ自身の設計に大きく貢献できるようになる前に、システムに適用される最適化パワーがほぼ一定であり、これによりシステムの能力が18ヶ月ごとに2倍になるとする。(これは、ムーアの法則とソフトウェアの進歩の組み合わせによる過去の改善率とほぼ一致する)。この改善率は、ほぼ一定の最適化能力によって達成される場合、システム能力の逆数として減少するリカルシトランスを伴う。(Bostrom, 2014, p. 76)。

すなわち、人工エージェントの知能は18カ月ごとに倍増していること、そして、この倍増は、人工エージェントの改善に適用される最適化能力が増加することなく行われていることである。これらの仮定は、人工エージェントの知能において、歴史的な不従順の割合が反比例して減少していることを意味し、その傾向を時間的に前方に予測すれば、双曲線的な成長の論拠が通ることになる。

しかし、ボストロムの仮定はいずれも過去のデータを誤って解釈している。知能の倍増時間については、第3節で見たとおりである。3.で見たように、知能はハードウェアの能力に応じて非線形に成長する。したがって、例えばトランジスタの数が50年間で3300万倍になったという事実から、人工エージェントの知能が同じ期間に数百万倍になったと結論づけることはできない。また、第3節で見たように、歴史的なハードウェアの性能の向上は、ハードウェアの性能の向上とは無関係である。3では、ハードウェア容量の歴史的な増加は、最適化能力の絶え間ない発揮によって達成されたものではないことを見た。主要な経済モデルは、この期間にハードウェアの容量を2倍にするために必要な品質加重研究努力が18倍に増加したことを示唆している(Bloom et al., 2020)。したがって、歴史的な証拠は、知能の爆発を根拠づけるために必要とされる、一定の最適化能力に対する知能の急速な倍増という仮定を支持していない。むしろ、知能はハードウェアと歩調を合わせて成長するわけではないため、ハードウェアの利得が増加するにつれて知能の利得も増加し、その結果、知能の利得が増加するにつれて知能の利得も増加することを、この証拠は示唆している。ボストロムのモデルでは、このような仮定は指数関数的な知能の成長さえも根拠づけることはできない。

本節では、ボストロムの知性の爆発的増加に関する議論を検討した。この議論では、最適化能力の増大は、リカルシトランスが一定または低下している期間に適用され、人工知能の急速な成長につながると主張している。ボストロムの結論を支持する考察は、3つのカテゴリーに分類される。第一のカテゴリーは、中程度にもっともらしい未来のシナリオに関する詳細な記述からなり、これらは知能の爆発的な増加を支持するものとして誤って解釈されている。第二のカテゴリーは、シンギュラリティ仮説の背後にある核心的な希望を薄っぺらく主張しているに等しい、詳細のない未来シナリオである。最後のカテゴリーは、歴史的な成長トレンドの誤った解釈であり、これが修正されれば、知性の爆発を支持するどころか、むしろ否定することになる。これらを総合すると、シンギュラリティ仮説を実質的に支持することはできない。

6 哲学的含意

シンギュラリティ仮説は、自己改善の再帰的プロセスによって人工エージェントの一般知能が加速度的に成長する持続的な期間を仮定している。この成長は、人工エージェントが人間の設計者よりも桁違いに知能が高くなり、人類の歴史に根本的な不連続性が生じるまで続くと仮定している。

第3章では、人工エージェントが人間の設計者よりも桁違いに知能が高くなるまで、この成長が続くと仮定した。3では、シンギュラリティ仮説に懐疑的な理由があることを述べた。シンギュラリティ仮説は異常な主張であり、それに見合った異常な証拠を必要とするはずである。時間が経てば経つほど、さらなる改良のアイデアを見つけるのは難しくなるだろう。多くの成長過程と同様、人工知能の成長もボトルネックによって停滞する可能性が高い。やがて、有限な資源や物理法則といった物理的な制約が、改善のペースを制約するようになるだろう。また、人工知能の急速な成長には、メモリや計算速度といった基礎的な量の底知れぬ速さの成長が必要かもしれない。

第4節と第5節では、シンギュラリティ仮説に対する2つの代表的な哲学的議論を調査した: チャルマーズの観察的議論と、ボストロムの、高い最適化能力と組み合わされた低反応性の持続的期間に関する議論である。我々は、それぞれの議論が特異点仮説の正当性を証明するには至らないことを見た。もしそうだとすれば、現時点でシンギュラリティ仮説を実質的に信頼するのは不適切である。

本節では、シンギュラリティ仮説に対する信頼が低下した場合の哲学的・政策的帰結について論じる。これらの帰結は、想定されるシンギュラリティ後の未来の性質に大きく依存するため、今後の研究の方向性を探る(6.3節)前に、楽観的な見方(6.1節)と悲観的な見方(6.2節)に分けて議論する。

6.1 楽観的見解

シンギュラリティ仮説の提唱者の多くは、シンギュラリティ後の未来が何をもたらすかについて楽観的な期待を抱いてきた。例えば、レイ・カーツワイルはシンギュラリティ後の未来について次のように考えている:

人間の老化と病気は逆転し、公害は止まり、世界の飢餓と貧困は解決される。ナノテクノロジーによって、安価な情報プロセスで事実上あらゆる物理的製品を作ることが可能になり、最終的には死さえも解決可能な問題に変わるだろう。(カーツワイル、2005年)。

シンギュラリティ研究所を設立したエリエーザー・ユドコフスキーは、シンギュラリティを早期に実現することを明確な目的とし、「できるだけ早くシンギュラリティに到達することが、人生の中間的意義である」と宣言した。

シンギュラリティ後の人生という楽観的なビジョンにおいて、シンギュラリティ仮説は哲学的にも現実的にも重要な結果をもたらす。シンギュラリティ仮説に疑問を投げかけることは、そのような帰結を和らげる傾向がある。本節では、精神的アップロードと変革的経済成長に関わる帰結に焦点を当てる。

シンギュラリティ仮説の楽観的バージョンは、人間が意識をデジタル形式でアップロードし、超長寿のデジタル版自分自身になって死をごまかすことが可能になる世界を約束している(Chalmers, 2010; Kurzweil, 2005; Yudkowsky, 1996)。精神的アップロードの可能性は、私たちの人生で最も重大な決断のひとつになるかもしれないことを提起している。脳スキャンや冷凍保存といった技術によって意識を保存するかどうかということだ。脳スキャンや冷凍保存といった技術によって意識を保存するかどうかである。どちらの技術も今日、企業によって提供されているが、延命効果が期待できることに加え、非常に現実的なコストとリスクがある。少なくとも、意識の保存にはコストがかかる。シンギュラリティの実現に時間がかかればかかるほど、既存の保存方法が失敗したり、それに取って代わられたり、あるいは意識を保存している企業が倒産したりする可能性が高くなる。脳スキャンと冷凍保存はどちらも致命的なプロセスであるため、より質の高い保存がまだ生きている人の身体で実現できると考える人々にとっては、利害関係が高まることになる。シンギュラリティ後の世界について、人工知能の急速な成長を期待する楽観主義者は、シンギュラリティが近いから保存のメリットがコストを上回ると考え、生きているうちに保存されることを選ぶかもしれない。

もう一つの帰結は、経済成長の主要な理論において、人工知能の進歩による急速な技術成長が経済成長の暴走につながるという観察から生じる(Aghion et al.) 介入がなければ、成長の恩恵は少数のテクノロジー企業に集中し、テクノロジー企業は瞬く間に世界経済の大部分を支配するようになり、人間の労働者は、人工労働者が支配する市場で自給自足レベルの賃金すら要求できなくなる可能性がある。こうした脅威に対する回答として、テクノロジー企業が一定水準以上の利益を再分配することを義務付ける、風前の灯火条項の導入を提案する著者もいる(O’Keefe et al.) もしシンギュラリティ仮説が正しければ、極端な利益の暴走は今日の人類が直面する最も重要な政策課題の一つであり、今日、風当たり条項の導入に多大な努力が払われるべきである。これとは対照的に、人工知能の発展が鈍化するか、劇的な発展が期待できなくなるにつれ、風当たり条項は重要な提案であり続けるが、それを成立させる緊急性と価値は後退する傾向にある。

ここまでは、シンギュラリティ仮説に対する信頼が低下した場合に政策に関連する結果がどうなるかを念頭に、シンギュラリティ後の未来について楽観的なビジョンが何を予測するかを検証してきた。では、シンギュラリティ後の未来について、より悲観的なヴィジョンは何を予測するのだろうか。以下、この疑問について述べる。

6.2 悲観的な見方

シンギュラリティ仮説の支持者の中には、シンギュラリティ後の未来が何をもたらすかについて、より悲観的なヴィジョンを持つ者もいる。特に、人工知能の急速な進歩が人類に実存的な破局をもたらすかもしれないと主張する者がいる。「地球を起源とする知的生命体が早期に絶滅するか、あるいは、将来的に望ましい発展を遂げる可能性が永久的かつ大幅に破壊される」(Bostrom, 2013, p. 15)かもしれないのである。

人工知能による実存的リスクに関する最も有名な議論は、ボストロム(2014)とユドコフスキー(2013)によるものである。この議論は3つの重要な主張に基づいている。1つ目は、シンギュラリティ仮説である。シンギュラリティ仮説では、自己改良型人工システムの加速度的な成長が、人工超知能の急速な出現につながるとする。例えば、Bostrom(2014)は、超知能が数分、数時間、数日の「速い」タイムスケールか、数カ月、数年の「中程度の」タイムスケールで出現する可能性が最も高いと主張していることを第2章で見た。ボストロムは、このようなタイムスケールでは、一つのプロジェクトが決定的な戦略的優位性を獲得し、急速に世界的な優位に立つ可能性が高いと論じている。この時点で、超知能は、「世界レベルで単一の意思決定機関が存在する世界秩序」(Bostrom, 2014, p.78)を形成するのに十分な「認知的超大国」を保有することになる。

その認知的超大国と世界的支配力があれば、超知的シングルトンは人類にその意志を強制することができる。さらに、「直交性のテーゼ」と「道具的収束のテーゼ」(Bostrom, 2012)という2つの前提を用い、人工エージェントは問題のある動機を持つ可能性があることを示唆している。ここから、ボストロム-ユドコフスキーの議論は、重要な是正措置がなければ、人類は人工超知能の手によって近いうちに実存的破局を迎えるかもしれないと結論付けている。

ボストロム=ユドコフスキーの議論に反撃する方法はたくさんある。しかし、過小評価されている抵抗の一線は、シンギュラリティ仮説に疑問を投げかけることである。シンギュラリティ仮説に圧力をかけることは、ボストロムがシングルトンの可能性を主張するために用いる超知性の急速な出現に圧力をかけることになる。また、特異点仮説に疑問を投げかけることは、超知的エージェントが持つであろう「認知的超能力」の程度にも圧力をかけることになり、超知的エージェントが実存的破局を引き起こしたいと考えるだけでなく、そうすることができるということを示すためには、さらなる研究が必要であることを示唆している。

最近の著者の中には、シンギュラリティ仮説に頼らない、人工エージェントの実存的リスクに関する議論を構築しようとしている者もいる(Carlsmith, 2021; Cotra, 2020; Ngo & Bales, 近刊)。シンギュラリティ仮説があり得ないという私の考えが正しければ、こうした努力は一般的に称賛されるべきものである。しかし、シンギュラリティ仮説がなければ、これらの努力は、当初のボストロム-ユドコフスキーの議論では直面しなかった3つのハードルに直面することになる。

第一に、これらの議論が強力な人工エージェントの出現の遅れを想定している限り、人工エージェントがシンギュラリティを形成する立場にあるという考えを動機付けるために、より努力する必要がある。ボストロムも認めているように、超知能の出現が遅ければ遅いほど、他のイニシアチブが力を競い合う時間が増え、人類が人工システムの成長について学び、それに対応する時間が増える。

第二に、これらの議論では、ボストロム的な「認知的超能力」を持たない、それほど根本的に強力でないエージェントを想定している限り、人工エージェントが実存的破局を引き起こす可能性があるという考えを動機付けるために、より努力する必要がある。例えば、Carlsmith(2021)による最近の議論は、ボストロムの認知的超能力を、ハッキング能力、資金力、協調性、社会的影響力、兵器システムへのアクセスによって生み出される破壊力といった、よりありふれた能力に置き換えている。このような能力がどのように実存的な大惨事につながりうるかを実証するには、現在提供されているよりもはるかに持続的で詳細な議論が必要である。現存するすべての核兵器が意図的にオムニスティックに誤用されたとしても、実存的な大惨事を引き起こすにはほど遠いというのが、次第に一致するようになってきている(Ord, 2020)。このことから思い起こされるのは、不正な人工システムが金融災害を引き起こしたり、人間を操ったり、兵器を誤射したりする可能性を示すだけでは不十分だということだ。実証されなければならないのは、人工システムが人類を滅亡させたり、我々の可能性を永久に抑制したりするのに十分な力を持つということである。それは容易なことではない。

第三に、これらの議論がより時間的に遠い脅威を想定している限り、存亡の危機を研究し、防ぐために今日行動する緊急性を動機付けるために、より努力する必要がある。論理ベースのエキスパート・システムのために開発された安全技術が、今日のディープ・ラーニング・システムにはほとんど役に立たないかもしれないのと同じである。また、タイムラインをさらに未来に押し進めることは、将来の世代のために行動を先送りする可能性もある。将来の世代は、より優れた情報を持ち、リスク軽減のための努力を支援する経済的余裕もあり、うまくいけば、極度の貧困など、解決すべき緊急の問題は少なくなるだろう。

まとめると、シンギュラリティ仮説を否定することは、人工エージェントによる実存的リスクを主張するボストロム=ユドコフスキーの議論に対抗するための有望な戦略である。新たな議論は、シンギュラリティ仮説に依存する実存的リスクの主張を減らそうとしている。これは称賛に値する発展であるが、同時に新たな論者が克服すべき新たな課題も提起している。

6.3 今後の方向性

これまで、シンギュラリティ仮説の否定は、シンギュラリティ後の未来について楽観的、悲観的にかかわらず、哲学的、政策的に重要な意味を持つことを見てきた。シンギュラリティ仮説のさらなる意味を探ることは、今後の研究にとって生産的かもしれない。例えば、シンギュラリティ仮説を考察することで、人工知能の本質と可能性について何を学ぶことができるだろうか(Dreyfus, 2012)。人工的な一般知能が最終的に到達する最も妥当なルートは何だろうか(Mandelbaum, 2022)。また、シンギュラリティ仮説は、人工知能の成長によって提起される、より伝統的な倫理的問題とどのように結びついているのだろうか?しかし、シンギュラリティ仮説そのものについては、仮説の根底にある成長の仮定が、その擁護者たちが考えているよりも信憑性が低いことを示したいと思う。

謝辞

オーストラリア国立大学とGlobal Priorities Instituteの聴衆、そしてPhilosophical Studiesの査読者2名に、この原稿に対するコメントをいただいた。特にNiall Maherには多大な調査協力をいただいた。また、アダム・ベイルズ、トム・デビッドソン、ガウラヴ・ヤーダヴの各氏には、本原稿の初期の草稿に対してコメントをいただいた。

オープンアクセス

本論文は、クリエイティブ・コモンズ表示4.0国際ライセンスの下でライセンスされている。このライセンスは、原著者および出典に適切なクレジットを付与し、クリエイティブ・コモンズ・ライセンスへのリンクを提供し、変更が加えられた場合にその旨を示す限り、いかなる媒体または形式においても、使用、共有、翻案、配布、複製を許可するものである。この記事に掲載されている画像やその他の第三者の素材は、その素材へのクレジット表示で別段の指示がない限り、記事のクリエイティブ・コモンズ・ライセンスに含まれている。素材が記事のクリエイティブ・コモンズ・ライセンスに含まれておらず、あなたの意図する利用が法的規制によって許可されていない場合、あるいは許可された利用を超える場合は、著作権者から直接許可を得る必要がある。このライセンスのコピーを見るには、http://creativecommons.org/ licenses/by/4.0/を参照のこと。

参考文献

- Aghion, P., Jones, B., & Jones, C. (2019). Artificial intelligence and economic growth. In A. Agrawal, J. Gans, & A. Goldfarb (Eds.), The Economics of Artificial Intelligence: An Agenda (pp. 237–90). University of Chicago Press.

- Alston, J., Chan-Kang, C., Marra, M., Pardey, P., & Wyatt, TJ. (2000). A meta-analysis of rates of return to agricultural R &D. International Food Policy Research Institute, https://www.ifpri.org/ publication/meta-analysis-rates-return-agricultural-r-d.

- Armstrong, S., Bostrom, N., & Shulman, C. (2016). Racing to the precipice: A model of artificial intelligence development. AI and Society, 31, 201–6.

- Awret, Uziel. (2012). Introduction. Journal of Consciousness Studies, 19, 7–15.

- Bahri, Y et al. (2021). Explaining Neural Scaling Laws. https://arxiv.org/abs/2102.06701.

- Bales, A., D’Alessandro, W., & Kirk-Giannini, Cameron Domenico. (2024). Artificial intelligence: Arguments for catastrophic risk. Philosophy Compass, 19, e12964.

- Baum, S., Goertzel, B., & Goertzel, Ted. (2011). How long until human-level AI? Results from an expert assessment. Technological Forecasting and Social Change, 78, 185–95.

- Bloom, N., Jones, C., Reenen, V. J., & Webb, M. (2020). Are ideas getting harder to find? American Economic Review, 110, 1104–44.

- Bostrom, N. (2012). The superintelligent will: Motivation and instrumental rationality in advanced artificial agents. Minds and Machines, 22, 71–85.

- Bostrom, N. (2013). Existential risk prevention as a global priority. Global Policy, 4, 15–31. Bostrom, N. (2014). Superintelligence. Oxford University Press.

- Callaghan, V., Miller, J., Yampolskiy, R., & Armstrong, S. (eds.). (2017). The Technological Singularity: Managing the Journey. Springer.

- Carlsmith, J. (2021). Is power-seeking AI an existential risk? Open Philanthropy: Technical Report. Chalmers, D. (2010). The singularity: A philosophical analysis. Journal of Consciousness Studies, 17,7–65.

- Chalmers, D. (2012). The singularity: A reply to commentators. Journal of Consciousness Studies, 7–8, 141–67.

- Chollet, F. (2019). On the Measure of Intelligence. https://arxiv.org/pdf/1911.01547.pdf.

- Cotra, A. (2020). Forecasting TAI with Biological Anchors. https://www.alignmentforum.org/posts/KrJfo ZzpSDpnrv9va/draft-report-on-ai-timelines.

- Creel, Kathleen. (2020). Transparency in complex computational systems. Philosophy of Science, 87, 568–89.

- Davidson, T. (2021). Could advanced AI drive explosive economic growth? Technical Report, Open Philanthropy, https://www.openphilanthropy.org/research/ could-advanced-ai-drive-explosive-economic-growth/.

- Dennett, Daniel. (2012). The mystery of David Chalmers. Journal of Consciousness Studies, 19, 86–95. Dreyfus, Hubert. (2012). A history of first step fallacies. Minds and Machines, 22, 87–99.

- Eden, A., Moor, J., Søraker, J., & Steinhart, E. (eds.). (2012). Singularity Hypotheses: A Scientific and Philosophical Assessment. Springer.

- Fazelpour, S., & Danks, David. (2021). Algorithmic bias: Senses, sources, solutions. Philosophy Compass, 16, e12760.

- Good, I. J. (1966). Speculations concerning the first ultraintelligent machine. Advances in Computers, 6, 31–88.

- Gordon, R. (2016). The rise and fall of American growth. Princeton University Press.

- Grace, K., Salvatier, J., Zhang, B., & Evans, O. (2016). 2016 Expert survey on progress in AI. AI Impacts, aiimpacts.org/2016-expert-survey-on-progress-in-ai.

- Greaves, H., Thorstad, D., & Barrett, J. (eds.). Forthcoming. Essays on longtermism. Oxford University Press.

- Hernandez, D., et al. (2021). Scaling Laws for Transfer. https://arxiv.org/abs/2102.01293.

- Heylighen, Francis. (2012). A brain in a vat cannot break out: Why the singularity must be extended, embedded and embodied. Journal of Consciousness Studies, 17, 126–42.

- Horvitz, E., & Selman, B. (2012). Interim report from the panel chairs: AAAI presidential panel on longterm AI futures. In A. Eden, J. Moor, J. Søraker, & E. Steinhart (Eds.), Singularity Hypotheses: A Scientific and Philosophical Assessment (pp. 301–6). Springer.

- Jones, Benjamin. (2009). The burden of knowledge and the ‘Death of the renaissance man’: Is innovation getting harder? Review of Economic Studies, 76, 283–317.

- Kaplan, J. et al. (2020). Scaling Laws for Neural Language Models. https://arxiv.org/pdf/2001.08361.pdf. Korinek, A., & Stiglitz, J. (2019). Artificial intelligence and its implications for income distribution and unemployment. In A. Agrawal, J. Gans, & A. Goldfarb (Eds.), The Economics of Artificial Intelligence: An Agenda (pp. 349–90). University of Chicago Press.

- Kortum, Samuel. (1997). Research, patenting, and technological change. Econometrica, 65, 1389–1419.

- Kremer, Michael. (1993). The O-ring theory of economic development. Quarterly Journal of Economics, 108, 551–75.

- Kurzweil, R. (2005). The Singularity is Near: When Humans Transcend Biology. Viking.

- Landgrebe, J., & Smith, B. (2022). Why Machines Will Never Rule the World: Artificial Intelligence Without Fear. Routledge.

- Lohn, A., & Musser, M. (2022). AI and compute: How much longer can computing power drive artificial intelligence process? CSET Issue Brief, https://doi.org/10.51593/2021CA009.

- Loosemore, R., & Goertzel, B. (2012). Why an intelligence explosion is probable. In A. Eden, J. Moor, J. Søraker, & Eric Steinhart (Eds.), Singularity Hypotheses: A Scientific and Philosophical Assessment (pp. 83–96). Springer.

- Lucas, J. R. (1964). Minds, machines and Gödel. In A. R. Anderson (Ed.), Minds and Machines (pp. 43–59). Hoboken: Prentice Hall.

- MacAskill, W. (2022). What we owe the future. Basic Books.

- Mack, Chris. (2011). Fifty years of Moore’s Law. IEEE Transactions on Systems Science and Cybernetics, 24, 202–7.

- Mandelbaum, Eric. (2022). Everything and more: The prospects of whole brain emulation. Journal of Philosophy, 119, 444–59.

- Modis, T. (2012). Why the singularity cannot happen. In A. Eden, J. Moor, J. Søraker, & E. Steinhart (Eds.), Singularity Hypotheses: A Scientific and Philosophical Assessment (pp. 311–40). Springer.

- Müller, V., & Bostrom, N. (2016). Future progress in artificial intelligence: A survey of expert opinion. In V. Müller (Ed.), Fundamental Issues of Artificial Intelligence (pp. 555–72). Springer.

- Ngo, R., & Bales, A. (2023). Forthcoming. Deceit and power: Machine learning and misalignment. In:

- H. Greaves, D. Thorstad, and J. Barrett (eds.), Essays on Longtermism, Forthcoming. Oxford University Press.

- Nordhaus, William. (2021). Are we approaching an economic singularity? Information technology and the future of economic growth. American Economic Journal: Macroeconomics, 13, 299–332.

- Nunn, Chris. (2012). More splodge than singularity? Journal of Consciousness Studies, 19, 57–60. O’Keefe, C., Cihon, P., Garfinkel, B., Flynn, C., Leung, J., & Dafoe, A. (2020). The windfall clause: Distributing the benefits of AI for the common good. Center for the Governance of AI Research Report, https://www.fhi.ox.ac.uk/windfallclause/.

- Ord, T. (2020). The Pecipice. Bloomsbury.

- Plotnitsky, Arkady. (2012). The singularity wager: A response to David Chalmers. Journal of Consciousness Studies, 7–8, 61–76.

- Prinz, Jesse. (2012). Singularity and inevitable doom. Journal of Consciousness Studies, 19, 77–86.

- Roodman, D. (2020). On the probability distribution of long-term changes in the growth rate of the global economy: An outside view. Technical Report, Open Philanthropy, https://www.openphilanthropy. org/sites/default/files/Modeling-the-human-trajectory.pdf.

- Russell, S. (2019). Human compatible: Artificial intelligence and the problem of control. Viking. Scannell, J., Blanckley, A., Boldon, H., & Warrington, B. (2012). Diagnosing the decline in pharmeceutical R &D efficiency. Nature Reviews Drug Discovery, 11, 191–200.

- Shalf, John. (2020). The future of computing beyond Moore’s law. Philosophical Transactions of the Royal Society A, 378, 20190061.

- Solomonoff, Ray. (1985). The time scale of artificial intelligence: Reflections on social effects. Human Systems Management, 5, 149–53.

- Stein-Perlman, Z., Weinstein-Raun, B., & Grace, K. (2022). 2022 Expert Survey on Progress in AI. AI Impacts, 3 Aug 2022, https://aiimpacts.org/2022-expert-survey-on-progress-in-ai/.

- Theis, T., & Wong, H. S. P. (2017). The end of Moore’s law: A new beginning for information technology. Computing in Science and Engineering, 19, 41–50.

- Thompson, N., Ge, S., & Manso, G. (2022). The importance of (exponentially more) computing power. https://arxiv.org/abs/2206.14007.

- Thorstad, D. (2023). Exaggerating the risks, Part 8: Carlsmith wrap-up. Reflective Altruism, https://ineff ectivealtruismblog.com/2023/06/03/exaggerating-the-risks-part-8-carlsmith-wrap-up/.

- United Nations, Population Division, Department of Economic and Social Affairs. (2019). World Population Prospects 2019.

- Vinge, Vernor. (1993). The coming technological singularity: How to survive in the post-human era.

- Whole Earth Review, 81, 88–95.

- Von Foerster, H., Mora, P., & Amiot, L. (1960). Doomsday: Friday, 13 November, A.D. 2026. Science, 132: 1291–1295.

- Waldrop, Mitchell. (2016). The chips are down for Moore’s law. Nature, 530, 144.

- Wei, J. et al. (2022). Emergent Abilities of Large Language Models. https://arxiv.org/abs/2206.07682. Yampolskiy, R. (2016). Artificial superintelligence: A futuristic approach. Chapman and Hall.

- Yeap, G. et al. (2019). 5nm CMOS production technology platform featuring full-fledged EUV, and high mobility channel FinFETs with densest 0.021µ m2 SRAM cells for mobile SoC and high performance computing applications. In: 2019 IEEE International Electron Devices Meeting (IEDM) pp. 36.7.1–36.7.4.

- Yudkowsky, E. (1996). Staring into the Singularity 1.2.5. . Yudkowsky, E. (2001). The Low Beyond. https://web.archive.org/web/20070613184827/http://yudkowsky.net/singularity.html.

- Yudkowsky, E. (2013). Intelligence explosion microeconomics. Technical Report 2013-1, Machine Intelligence Research Institute, http://intelligence.org/files/IEM.pdf.

- Zhang, B., Dreksler, N., Anderljung, M., Kahn, L., Giattino, C., Dafoe, A., Horowitz, M.C. (2022). Forescasting AI progress: Evidence from a survey of machine learning researchers. Https://doi. org/10.48550/arXiv.2206.04132.