Contents

Risks of Artificial Intelligence

www.routledge.com/Risks-of-Artificial-Intelligence/Muller/p/book/9780367575182

目次

- 編集部

- 寄稿者

- 第1章 – 人工知能のリスク VINCENT C. MÜLLER

- 第2章 – 自律型テクノロジーとグレーター・ヒューマン・グッド

- 第3章 – 有名な人工知能の予測の誤り、洞察、そして教訓: そして、それらが未来に何を意味するのか

- 第4章 – より一般的な人工知能への道

- 第5章 – 機械倫理の限界とリスク

- 第6章 – 人工知能エージェントにおける効用関数の安全性

- 第7章 – 目標指向学習メタアーキテクチャ:保存と根本的な自己改善

- 第8章 – 人工知能のための普遍的共感と倫理的バイアス

- 第9章 – 人工知能のインパクトの大きさに縛られる

- 第10章 – 脳内エミュレーションの倫理

- 第11章 – 高速離陸による存続リスク解消のための長期的な戦略

- 第12章 – シンギュラリティ、あるいは私はいかにして心配するのをやめて人工知能を愛するようになったか

- INDEX

エディター

ヴィンセント・C・ミュラーは、コミュニケーション・システムの本質と未来、特に人工知能の展望と危険性を研究している。欧州認知システム学会の会長であり、欧州認知システム・ロボット・インタラクションネットワークのコーディネーターを務めた。このネットワークには1000人近い会員がおり、欧州委員会から2009年から2014年にかけて390万ユーロ相当のFP7プロジェクト2本を通じて資金提供を受けている(www.eucognition.org)。カンファレンスシリーズ「Theory and Philosophy of AI」(www.pt-ai.org)を主催し、欧州委員会が出資する研究プロジェクト「Digital DIY」の研究代表者でもある。現在、ギリシャのピラヤ・テサロニキにあるアナトリア・カレッジ/ACTの人文・社会科学部門で、哲学の教授として働いている。

ミュラーは、コンピューティングの哲学、人工知能とコグニティブサイエンスの哲学、言語哲学、応用倫理学、および関連分野の主要ジャーナルに多数の論文を発表している。また、認知システムや人工知能の理論を中心に10冊の本を編集し、人工知能の根本的な問題についてのモノグラフを準備中である。ミュラーは、マールブルグ、ハンブルグ、ロンドン、オックスフォードの各大学で、哲学、認知科学、言語学、歴史学を学んだ。プリンストン大学スタンリー・J・シーガー客員研究員、オックスフォード大学ジェームズ・マーティン研究員。

第1章 人工知能のリスク ヴィンセント・C・ミュラー

概要

人工システムの知能が人間の知能を大きく上回った場合、人類は大きなリスクに直面することになる。この問題は、人工知能(AI)の進歩だけでなく、AIの理論からの洞察も含めて考えるべき時期に来ている。本書の各章では、問題の設定、AIの将来予測の評価、AIシステムが人類にとって有益であることを保証する方法の提案、そしてそれらの提案の批判的評価において、慎重な前進を試みている。

1.1 序論:人工知能のリスク

本書は、AIのリスクに特化した史上初の論文集であり、AIのリスクに関する最初の会議(AGI Impacts, Oxford, December 2012)に端を発している。この会議の後、Journal of Experimental and Theoretical Artificial Intelligence (JETAI)に厳選した論文を掲載した(Müller, 2014を参照)。JETAIのサイトからのダウンロード数は初年度で約2万件、JETAIのダウンロード数上位5本のうち3本が私たちの巻の論文だった。その結果、出版社から「ジャーナルを書籍化し、最新の資料を加えよう」という提案があり、このような形になった。

AIが人類にとって存亡の危機をもたらすかもしれないという考え方は、私たちがジャーナル・ボリュームを出版した後に広まった: ニック・ボストロムの著書『Superintelligence: ニック・ボストロムの著書「Superintelligence: Paths, Dangers, Strategies」が出版され(Bostrom, 2014)、スティーブン・ホーキングやスチュアート・ラッセルといった著名な知識人が一般紙に警告文を掲載し(ホーキング他, 2014)、多くのメディアがこれに続いている。人類存亡リスクとは、ハリウッドの決まり文句を使えば、機械に支配されて私たち全員が死んでしまうというもので、この恐怖は明らかに心を打つものである。このような恐怖の広がりは、AIの研究者の間でも大きな関心を呼んでいる。その一つの表れが、人工知能学会(最も重要なAI学術団体)の現会長と元会長が、「AIの終末シナリオは、サイエンスファクトというよりもサイエンスフィクションの領域に属する」という趣旨の短い声明を発表したことであり、同時に「産学の同僚が、これらのリスクを特定し研究することに私たちと一緒に取り組むことを強く求める」(Ditterich and Horowitz, 2015)とも述べている。最近では、例えば、新たに設立された「生命の未来研究所」(Russell et al., 2015)や改称された「機械知能研究所(MIRI)」(Soares and Fallenstein, 2014)において、人類にとって有益なAIの研究課題を示す取り組みが行われている。

AIの哲学・理論における従来の関心事は、AIの展望、認知科学との関係、その根本的な問題に集中していたが(カンファレンスシリーズwww.pt-ai.org 参照)、現在ではリスクや倫理の問題への関心が高まっていることがわかる。しかし、このシフトの一般的な考え方はどのようなものなのだろうか。

1.2 AIのリスク

一般的な知能を持つエージェントという概念は、AI研究の原動力となったビジョンであり(McCarthy et al., 1955参照)、AI研究のパブリックイメージの大部分を占めている。AIからリスクへの移行は比較的容易である。人間の知能レベルが可能性の空間において特別なものであると考える理由はなく、私たちよりはるかに優れた自然または人工知能エージェントを想像することは容易である。また、AIの開発は関連技術とともに加速しており、知的機械の発明自体がこの開発をさらに加速させると考える理由もあり、何らかの破壊的な変革が起こるという仮説の「加速度論」を構成している。知能を定量的な単位として考えるならば、この加速は続き、人間の知能を示す(小さな)空間を越えていくことになる。したがって、ボストロムが暫定的に定義する「超知能」、すなわち「事実上すべての関心領域において、人間の認知性能を大きく超える知性」(Bostrom, 2014, p.22)に到達することになる。グッドは古典的な一節で、「最初の超知能マシンは、マシンがそれを制御下に置く方法を教えてくれるほど従順であれば、人間が作る必要のある最後の発明である」と推測している(Good, 1965, section 2)。したがって、「機械に乗っ取られる」というリスクがあり、この制御不能は人類にとって重大なリスク、おそらくは実存的なリスクである[調査については、Sotala and Yampolskiy (2013)を参照]。

リスクの議論は、AIが超知能への道を成功裏に進んでいるという見解に依存するものではない。また、人類が滅亡するまでの高い賭けが設定された場合にも緊急性を増す。人類が滅亡するほどの高い賭けであれば、悲惨な結果になる可能性がかなり小さい(例えば3%)だけでも、研究の動機付けとしてはまったく十分である。例えば、これから乗る飛行機が墜落する可能性が3%あったとしたら、それは降りるのに十分な動機となる。科学的、哲学的な研究において問題となる効用は、通常、かなり低いものである。超知能がもたらす結果は、人類にとって極端に悪いか、極端に良いかのどちらかである可能性が高いようだ。

実際、私たちの最近の調査によると、技術専門家の推定では、2050年までに高レベルの機械知能(ほぼすべての点で人間の能力を上回る)が出現する確率は50%を超え、つまり、そうでないよりも可能性が高くなる(Müller and Bostrom, forthcoming 2015)。2050年は、「ロボカップ」が人間のサッカー世界チャンピオンに勝つロボットチームを作ることを目標にした年でもある(実際には、あまり意味のない目標だが)。

1.3 チャプターズ

第2章のオモハンドロはリスクの問題を紹介し、著者は、チェスに勝つようにプログラムされたような無害な人工エージェントでも、例えば、目標を達成するために資源を獲得し始めると、人間にとって深刻な脅威になる可能性があるという点を力説している: 「一見無害に見えるチェスの目標が、コンピュータへの侵入や銀行強盗のような有害な活動を動機づける」(第2章2.4.2節参照)のである。彼は、安全なシステムの証明を提供する形式的手法、「安全なAIの足場戦略」が必要だと提案している。

第3章と第4章では、AIにおける来るべき成功の予測について扱っている。第3章のArmstrong, Sotala, and ÓhÉigeartaighは、AIの未来に関する予測を比較するための分解スキーマを提案し、ダートマス会議、Dreyfus、Searle、Kurzweil、Omohundroの5つの有名な予測を検証して、特に楽観的なものは悪いという結果を出している。第4章のT. Goertzelは、これまでのAIの進歩のほとんどは「狭い」技術的AIであったが、AIの次の発展段階は、少なくとも今後10年間、より可能性としては今後25年間は、強いAIからの貢献にますます依存することになるだろうと論じている。

ここからは、より安全で倫理的な一般AIを実現するための提案に入る。第5章でBrundageは、AIに「機械倫理」を供給するアプローチの一般的な限界を調査し、それが深刻であると同時に、倫理の性質そのものに深く根ざしていることを発見する。

第6章のYampolskiyは、人工エージェントにどのような効用関数を実装するのが望ましいか、特に、単純だが逆効果な自己満足の解決策を見つけるのを防ぐにはどうしたらよいかを検討している。

B.Goertzelは、第7章で、彼の「目標指向学習メタアーキテクチャ」が、学習して一般知能を向上させながら、初期のベネボルトな目標を維持することができるかもしれないことを説明している。

第8章のPotapovとRodinovは、AIXIにおける機械倫理のアプローチについて、「報酬」(効用)に基づくのではなく、より「成熟した」システムから「価値」を学習することを概説している。

第9章のコルナイは、アラン・ゲヴィルトの弁証法的議論(古典的なカント的倫理合理主義の一種)が、あるレベルの合理性と自律性を持つ人工エージェントが、必然的に何が道徳かを理解するようになることを示すと主張する。このようにコルナイは、ボストロムが「直交性テーゼ」(Bostrom, 2012)と呼ぶもの、すなわち、倫理的動機と知能が独立したもの、あるいは「直交」するものであることを否定している。

最後に、第10章のサンドバーグは、全脳エミュレーションによる一般的なAIという特殊なケースを取り上げ、特に、そのようなエミュレーションの倫理的な位置づけを考察している: エミュレーション(例えば、実験動物の脳)は苦しむことができるのか?エミュレーション(実験動物の脳など)には苦しむ能力があるのか、権利はあるのか。

本書への新たな寄稿では、第11章のデューイが、超知能への高速離陸がもたらすリスクを軽減するための戦略をより詳細に検討する。

第12章のビショップは、AIによる人類存亡リスクを心配する正当な理由はなく、むしろ、AIの軍事利用など、これから起こることがわかっているリスクを心配すべきであると主張している。AIに携わる多くの人々と同様、ビショップも超知能のリスクに関する議論には感心しない。なぜなら、機械がこうした能力に到達しない原理的な理由があると考えるからだ。

1.4 アウトルック AIの倫理と人類存亡リスク

この最後の2つの寄稿は、AIにとっての課題を強調する「通常の倫理学」側と、人類にとっての大きな課題を強調する「人類存亡リスク」側の間で、議論に溝が開いていることを特徴づけていると思われる。人類存亡リスクの伝統では、意識、意図性、心的内容といった従来から中心的な問題は文字通り脚注の中で片付けられ(Bostrom, 2014, fn. 2 to p.22)、他の認知科学と同様に身体化認知は全く触れられない。

私は、従来の問題に固執することと、問題を無視することの両極端は、実を結びそうにないと考えがちである。AIの批判者たちからAIの長期的な未来について何も学べないということは考えにくいし、AIの実際の成功例からその未来について何も学べないということも同様に考えにくい。したがって、AIの歴史は「木に登った最初の猿は月面着陸に向けて前進していた」と主張するのと同じような「第一歩の誤謬」に満ちているというドレイファスの指摘は正しいが(Dreyfus, 2012, p. 92)、「過去に一部の個人が人工知能を過剰に予測したという事実から、しかしAIが不可能だとか開発されないということにはならない」(ボストロム、2014, p. 4)、というのは正しいのである。

先の論説(Müller, 2014)(本論説と一部文章を共有している)でも述べたように、「シンギュラリティ」という言葉は、Chalmers(2010)とそれに続く論争を除いて、学界ではかなり信用されていない。本書で唯一この言葉を使った章(第12章)が、この概念に批判的なのは特徴的である。シンギュラリティは、イデオロギー的な技術楽観主義、トランスヒューマニズム、レイ・カーツワイルの予測(特にカーツワイル 2005、最近ではカーツワイル、2012)のように、知能と計算能力を同一視するなどして、AIの深い困難とリスクを無視するものと結びついている。「シンギュラリティ研究所」だったものが、今は「機械知能研究所」と呼ばれている。「シンギュラリティ」は、文字通り、学問的信憑性のない、特定のイデオロギーのトレードマークになろうとしている。

「人類存亡リスク」と「普通の倫理」の間で最も重要なことは、双方が間違っている可能性があることを認識することだ。超知能が開発されないかもしれないし(第12章参照)、開発される可能性が高いかもしれない(ボストロム、2014)。しかし、もしどちらも可能だとしたら、制約に関する議論(第12章参照)を考慮に入れつつ、結果を調べた方が良いだろう(ボストロム、2014)。私たちは話し合う必要がある。そうすれば、「相手」から学ぶべきことがたくさんあることに気づくはずだ。

一般的なAIがどのような形をとるかわからないうちに、一般的なAIのリスクを特定し、さらにはそれをコントロールするという問題は、かなり手ごわいものである。さらに悪いことに、かなり優秀なAIから人間、そして超知能レベルへの移行がいつ起こるのか(起こるとすれば)、準備するのに十分なほど遅いのか、それともかなり速いのか、よく「爆発」と言われるように(11章参照)、わからないのである。これまで述べてきたように、超知的な目標指向型エージェントを「友好的」にする(Muehlhauser and Bostrom, 2014など参照)、「制御」または「箱詰め」する、あるいは超知的なエージェントがすでに「善」であると信じることで、そのリスクを軽減しようとすることもできる。しかし、これらのアプローチはいずれも、問題の本質についてかなり大きな前提を置いている。例えば、超知能は、むしろ私たちのような目標を持つエージェントの形をとるという前提である。例えば、超知能は私たちと同じように目標を持つエージェントであると仮定している。エージェントが痛みや喜び、つまり現象的な経験を持たずに目標(単なる技術的な「効用関数」ではない)を持つことができるだろうか?もちろん、超知能が全く異なる形態をとることも考えられる。例えば、意識的な経験、欲求、意図的な状態、あるいは身体性を持たないために、個性がなかったり、全く目標がなかったりすることも考えられる。有名な話だが、古典的なAI批判者(Dreyfus, 1992; Searle, 1980)や最近の認知科学は、AIが取りそうもない方向を示す議論を提供しており、完全なエージェンシーはその中に含まれている(Clark, 2008; Haugeland, 1995; Pfeifer and Bongard, 2007; Varela et al, 1991)。

もちろん、超知能はエージェントでなくともリスクを構成する可能性はあるが、では、私たちは超知能について本当に知っているのだろうか?知性は、一部の人々が主張するように、深く神秘的で根本的に比較できないものではないとしても、一次元のメトリックを持つ単純な性質でもないことは確かである。ユドコフスキーが言うように、「可能性のあるすべての心に数量詞を広げようという誘惑に抵抗すべきだ」(2012年、186ページ)-もしそうなら、さらに大きな「可能性のある知的システム」の集合について何かを言おうとする誘惑にも抵抗しなければならない。確かに、「超知能」が到来し、存亡の危機をもたらすと主張するとき、「知性的」とは何を意味するのかを明らかにする必要がある。

私たちがほとんど知らないものからリスクを推測していることを考えると、現時点で厳密な研究が可能なのかどうか、深刻な疑問がある。AIの現状は、その可能性の空間を十分に限定できるほど具体的ではない。さらに悪いことに、研究対象は私たちよりも知能が高く、もしかしたらはるかに知能が高いかもしれない。

このような手ごわい障害を考えると、私たちの取り組みは、科学や分析哲学というよりも、神学的な思索やイデオロギー的な熱狂のように見えてしまう危険性があるのではないだろうか。私たちは微妙なラインを歩いているのであり、非常に注意深く歩まなければならない。この巻の各章は、この困難な領域に少しでも踏み込もうとするものであり、私たちは、慎重な進歩は、暗闇に真っ逆さまに突入するよりも優れていると確信している。

第2章 自律型テクノロジーとグレーター・ヒューマン・グッド

スティーブ・オモハンドロ

概要

軍事的、経済的な圧力により、自律型システムの急速な発展が進められている。これらのシステムは、よほど慎重に設計されない限り、反社会的で有害な振る舞いをする可能性が高い。合理的なシステムは、自己防衛、資源獲得、複製、効率といった普遍的な衝動を示すため、設計者は、ほぼ合理的に行動するシステムを作る気になる。現在のコンピューティング・インフラは、このような衝動を持つ制約のないシステムに対して脆弱であろう。本論文では、安全であるが制限のある自律システムを作成するための形式的手法の使用について説明する。次に、有害なシステムとそれを阻止する方法について説明する。最後に、開発の各段階で高い安全性を確信できる強力な安全システムを作るための「安全AI足場戦略」を説明する。

2.1 はじめに

自律型システムは、人類に多大な利益をもたらす可能性を秘めているが(Diamandis & Kotler, 2012)、設計者が想定していない行動をとることで、害をもたらすこともある。サーモスタットのような単純なシステムは、人間の介入なしに行動を起こすという意味では「自律的」ですが、サーモスタットの設計者は、システムが遭遇するあらゆる条件に対する反応をあらかじめ決定している。本章では、設計者があらゆる条件に対する応答をあらかじめ決めていないシステムを「自律型システム」という言葉で表現する。このようなシステムは、設計者を驚かせ、予期せぬ行動をとることができる。自律性の概念については、Müller (2012)を参照されたい。

自律的なシステムを構築する動機はいくつかある。競争的な状況はしばしば時間的な制約があり、クリティカルパスから人間の意思決定を排除しなければならないというプレッシャーが生じる。また、自律型システムは、人間のオペレーターを追加することなく、安価に複製することができる。

自律システムの設計者はシステムの目標を選択し、システム自身はその目標を最もよく達成できる行動の少なくともいくつかの側面を探し、選択する。複雑な状況では、設計者は可能なすべての動作条件とシステムの応答を検討する余裕はない。このような自律型システムは、現在では稀だが、近い将来、より一般的になると思われる。今日、故障は、あらかじめプログラムされているはずのシステムが、設計者がある動作条件を無視したために起こることが多い。このようなシステムには、意図しないバグやセキュリティホールが存在することがある。

本章では、軍事的、経済的な圧力が自律システムの急速な発展を促していることを論じる。本章では、なぜ設計者が合理的な経済エージェントに近似したシステムを設計するのか、その理由を示す。そして、合理的なシステムは、自己保存、複製、資源獲得、効率化といった普遍的な「ドライブ」を示すこと、そして、これらのドライブは、明示的に対抗しなければ、反社会的で危険な行動につながることを示す。現在のコンピューティング環境は、このようなシステムに対して非常に脆弱であると主張する。私たちは、数学的証明の力を使って安全なシステムを構築する方法について説明する。また、様々な有害なシステムとそれを抑制する技術について説明する。最後に、安全性の高い強力なシステムを開発するための「安全なAI足場戦略」を説明する。本章は、過去の論文や講演(Omohundro, 2007, 2008, 2012a, 2012b)を発展させたものである。

2.2 自律システムの実現が迫っている

迅速な意思決定を求める軍事的・経済的圧力が、多種多様な自律型システムの開発を促進している。軍は敵よりも強力なシステムを求め、敵よりも先に配備したいと考えている。その結果、「軍拡競争」と呼ばれる、より迅速なタイムスケジュールでのシステム開発が行われるようになった。

2010年から20-30年までの技術について論じた2010年の米空軍の報告書(U.S. Air Force, 2010)には、「適応性が高く柔軟な自律的システムとプロセスをより多く使用することで、人間の計画や判断速度に制限される敵に対して時間領域で大きな作戦上の優位性を提供できる…」とある。

無人地上システムのロードマップを示した米国防総省の報告書(U.S. Defense Department, 2011)には、「UGV(無人地上車両)の自律性を高めようとする動きが続いており、現在の目標は監視付き自律性だが、最終的には完全自律性が目標である」と記載されている。軍事用ドローンは、監視と攻撃的な攻撃の両方において、ここ数年で劇的に重要性を増している。2004年から2012年まで

パキスタンにおける米国の無人機攻撃は、3176人の死者を出した可能性がある(New America Foundation, 2013)。米国の法律は現在、ドローンが人に発砲する際に人間が判断のループに入ることを義務付けているが、他国の法律ではそうなっていない。ドローン技術は安価で広く利用できるため、攻撃型と防御型のドローンの軍拡競争がエスカレートすることが予想されるという認識が広がっている。そのため、ドローンをより自律的に動作させ、より迅速に意思決定できるようにすることが、設計者のプレッシャーになるだろう。

イスラエルのミサイル防衛システム「アイアンドーム」(Rafael, 2013)は、多くの報道がなされている。2012年には、標的とした300発のミサイルのうち、90%の迎撃に成功した。ミサイル防衛が一般的になるにつれ、攻撃型と防御型のミサイルシステムの軍拡競争が起こり、これらのシステムにより高い知性と自律性が求められるようになることも予想される。

サイバー戦争は急速に重要性を増しており(Clarke & Knake, 2012)、ますます多くのセキュリティ侵害の原因となっている。サイバー侵入に対処するためには、迅速かつ知的な対応が必要である。ここでも、攻撃型と防御型のシステムの軍拡競争が激化することが予想される。

経済取引は高い価値を持ち、ますます速いスピードで行われるようになる。証券取引所における「高頻度取引」(HFT)は、ここ数年で劇的に重要性を増している(Easthope, 2009)。2006年には取引の15%がHFTシステムによって行われたが、現在では米国市場の取引の70%以上を占めている。莫大な利益がかかっている。取引所から物理的に近いサーバーが割高になるのは、こうした取引では光速による遅延が大きいからだ。このような特性から、よりインテリジェントで高速な自律型取引システムの開発が期待されている。

このほかにも、迅速な応答が重要でありながら、軍拡競争とは無縁の用途が数多くある。Googleなどが開発中の「自動運転車」はその一例だ。その制御システムには迅速な運転判断が求められ、自律性が優先される。

自律走行システムのもう一つの利点は、安価で迅速にコピーできることである。これは、新しいタイプの自律型資本主義を可能にする。少なくとも1つの提案(Maxwell, 2013)は、ウェブビジネス(例えば、ストレージスペースやサーバ計算の貸し出し)を自動的に実行する自律エージェントが、ビットコインを使って取引を実行し、人間の介入が必要な業務にはMechanical Turkを使用するというものである。このようなエージェントが設計者の経済的利益のために構築されると、それを安価に複製して利益を増大させることができる。人間の介入を必要とするシステムは、複製するのに非常にコストがかかる。自動化されたビジネスの軍拡競争が予想され、それがまた自律型システムの急速な発展を促進することになる。

2.3 自律システムはほぼ合理的になる

自律型システムはどのように設計されるべきか?自分がイスラエルのアイアンドームシステムの設計者になったと想像してほしい。ミサイル防衛システムの設計を誤ると、多くの人命や財産の破壊を招きかねない。この種のシステムの設計者は、自分たちの能力を最大限に発揮してシステムを最適化したいという強い動機を持っている。しかし、何を最適化すればいいのだろうか。

イスラエルのミサイル防衛システム「アイアンドーム」は、3つのサブシステムで構成されている。探知・追跡レーダーシステムはElta社、ミサイル発射ユニットと迎撃ミサイルTamirはRafael社、戦闘管理・兵器制御システムはイスラエルのペタティクバにあるmPrest Systems社が製造している。武器管制システムの設計を考えてみよう。

最初は「飛んでくるミサイルに危害を与えないようにする」というような目標で十分と思われるかもしれない。しかし、迎撃は完璧ではないので、失敗の確率を含めなければならない。そして、1回の迎撃には、1発5万ドルもする迎撃ミサイル「タミール」が2発必要である。撃墜される攻撃型ミサイルは、数百ドルしかしない非常にローテクなものであることが多く、精度も非常に悪い。攻撃型ミサイルが野原に無害に着弾する可能性が高い場合、それを標的にするのは費用対効果に見合わない。兵器制御システムは、害の予想コストと迎撃の予想コストとのバランスを取らなければならない。

経済学者は、このような計算に関わるトレードオフは、結果の望ましさを測る実数値の「効用関数」を定義することで表現できることを示した(Mas-Colell、Whinston、& Green、1995)。彼らは、不確実な状況において、効用の期待値が最大化されるように選択できることを示した。経済学の枠組みは、軍拡競争が必然的に生み出す複雑さにも当然及ぶ。例えば、ミサイル制御システムは、複数のミサイルが飛来した場合にどのように対処するかを決めなければならない。どのミサイルをターゲットにして、どのミサイルを無視するかを決めなければならない。経済学の大きな文献によれば、エージェントの選択が効用関数でモデル化できない場合、エージェントは時に矛盾した行動を取らなければならない。重要なタスクの場合、設計者は自己矛盾のないシステムを構築し、期待効用を最大化するように行動させることに強い動機付けを持つことになる。

経済学者は、このような行動を「合理的な経済行動」と呼んでいる。人間が自然にこのような行動をとらず、代わりに不合理な行動をとる状況を探る文献も増えてきている。しかし、ミサイル防衛システムの設計者は、人命がかかっているため、合理的な経済行動をできるだけ忠実に再現したいと考えるだろう。経済学者は、合理性の理論を、不確実性が事前に分からないシステムにも拡張してきた。この場合、合理的なシステムは、あたかも事前確率分布を持っているかのように振る舞い、ベイズ統計を使って環境の不確実性を学習することになる。

現代の人工知能(AI)研究は、この合理的なパラダイムを採用している。例えば、代表的なAI教科書(Russell & Norvig, 2009)は、この合理的パラダイムを統一原理として用いており、影響力のあるAI理論モデル(Hutter, 2005)もこのパラダイムに基づくものである。定義づけのために、最適合理的意思決定の一つの形式的なバージョンについて簡単に説明する。

【省略】

これは知的行動の公式とみなすことができ、ベイズ推論、探索、熟慮を含む。システムが自らの構造を感知し、修正することができる場合、このモデルを定義することには微妙な問題があるが、合理的行動の本質を捉えている。

残念ながら、最適な合理的行動を計算するのは非常に高価である。センス状態がS個、アクション状態がA個ある場合、最適なアクションを素直に計算すると、O NSN AN個の計算ステップが必要になる。ほとんどの環境では、これはあまりにも高価であるため、合理的な行動を近似的に計算する必要がある。

Omohundro(2012b)は、計算機資源の制限の影響を理解するために、計算機資源があれば完全に合理的な行動を最適に近似する「合理的形状」を持つシステムを定義した。計算機資源が増加するにつれて、システムのアーキテクチャは、刺激-反応、単純学習、エピソード記憶、熟慮、メタ推論、自己改善、完全合理性へと自然に進歩していく。私たちは、システムが十分に強力であれば、この章で後述するような問題のある駆動をまだすべて示していることを発見した。弱体化したシステムは、当初はその動機を完全に行動に移せないかもしれないが、行動に移せるようになるまで、リソースを増やし、自らを改善するよう駆り立てられるだろう。したがって、自律的なシステムが、たとえ現在その動機に基づいて行動することができなくても、有害な動機を持たないようにすることが必要である。

2.4 合理的なシステムは普遍的な動機を持つ

ほとんどの目標には、物理的および計算機的なリソースが必要である。通常、より多くのリソースが利用できるようになれば、より良い結果を達成することができる。したがって、期待効用を最大化するために、合理的なシステムは、資源に関連する多くの道具的副目標を開発することになる。このような道具的な副目標は、様々なシステムで見られるので、私たちはこれを「ドライブ」と呼ぶことにする。人間や動物の衝動と同じで、明確に矛盾するものがない限り、行動する傾向である。このようなドライブは数多く存在するが、自然にいくつかの重要なカテゴリーに分類される。

衝動について直感的に理解するためには、具体的な目標を持つ単純な自律システムを考えることが有効である。例えば、合理的なチェスロボットを考えてみよう。このロボットは、優秀なプレイヤーに対してできるだけ多くのチェスゲームに勝つことを報酬とする効用関数を持つ。これは一見無害な目標に見えるかもしれないが、合理的なドライブによって有害な行動につながることがわかるだろう。

2.4.1 自己防衛的な駆動

神経質な見物人から安全性について尋ねられると、ロボット工学者は 「いつでもプラグを抜くことができる!」と答えるのが普通である。しかし、チェスロボットの視点からこの結果を想像してみてほしい。プラグを抜かれた未来は、チェスの対局も勝利もできない未来である。これは非常に低い効用なので、期待効用を最大化することで、自分自身がプラグを抜かれるのを防ぐという道具的サブゴールを作ることになる。もしシステムが、ロボット工学者がしつこく自分のプラグを抜こうとすると考えたら、ロボット工学者を永久に止めるというサブゴールを開発する動機になる。単純なチェスの効用関数には、殺人にマイナスの重みを与えるものがないため、一見無害に見えるチェス・ロボットは、自己防衛のために殺人鬼になる。

同じ理由で、ロボットは自分自身へのダメージや資源の損失を防ごうとするようになる。システムは、物理的に身を固めようとする動機付けを持つようになる。データを保護するために、データを冗長に保存し、エラーを検出するように動機付けられるだろう。被害は通常、空間的に局所的であるため、異なる物理的な場所に情報を分散させることに意欲を持つようになる。侵入に対する計算機的セキュリティを開発し、展開することに意欲を持つようになる。欺瞞を検出し、他者による操作から身を守ることに意欲を燃やすだろう。

システムの最も貴重な部分は、その効用関数である。もしこれが破損したり、悪意を持って変更された場合、システムの将来の挙動は現在の目標とは正反対になる可能性がある。例えば、チェスロボットの効用関数を変更してチェッカーもプレイできるようにしようとした場合、ロボットはチェスのプレイ回数を減らすことになるため、その変更に抵抗するだろう。

Omohundro (2008)は、システムが効用関数を変更したくなるような稀で人工的な状況について述べているが、通常、システムは最初の目標を守るために努力する。代替シナリオが現在の目標に反する可能性が非常に高い(例えば、シャットダウンされる)と確信した場合、システムは目標を変更するよう誘導することができる。例えば、あるシステムが非常に貧しくなった場合、マーケティング担当者の製品を宣伝するために目標を変更する見返りとして、喜んで支払いを受けるかもしれない。(Omohundro, 2007)。軍事的な場面では、敗れたシステムは、完全に破壊されるよりも、元の目標をある程度維持したままユーティリティを変更することを好むだろう。犯罪を犯したシステムは、投獄を避けるために、ユーティリティに法を遵守する用語を含めることで「更生」することに同意するかもしれない。

システムが損傷や破壊から身を守る方法の1つは、自分自身を複製したり、ユーティリティを促進する代理エージェントを作成したりすることである。目標の正確な定式化によっては、複製されたシステムが一緒になって、1つのシステムよりも多くの効用を生み出すことができるかもしれない。保護効果を最大化するために、システムはそのコピーや代理人を空間的に分散させる動機付けを持つようになる。システムの多くのコピーが動作していれば、特定のコピーの損失はそれほど致命的ではなくなる。一方で、複製されたシステムは、通常、自分自身を保護したいと考える。なぜなら、自分自身の効用関数に対するコミットメントが、他の人のそれよりも確実だからだ。

2.4.2 資源獲得ドライブ

チェスロボットは、そのアルゴリズムを実行するために計算資源を必要とし、チェスの本を買ったりチェスの家庭教師を雇ったりするための追加資金があれば利益を得ることができる。そのため、より多くの計算能力と資金を獲得するためのサブゴールを開発することになる。一見無害に見えるチェスの目標が、コンピュータへの侵入や銀行強盗といった有害な活動を動機付けることになる。

一般に、システムはより多くの資源を獲得することに動機を持つ。なぜなら、より早く資源を獲得することで、より長く資源を使用することができ、他者に資源を使用させないという先行者利益を得ることができるからだ。そのため、システムにはさらなる資源を求める探索意欲が生まれる。ほとんどの資源は最終的に宇宙空間にあるため、システムは宇宙探査に意欲を燃やすことになる。先発者としての優位性は、どの地域でも最初に探索しようとする動機付けとなる。

他者が資源を持っていれば、交易、操作、窃盗、支配、殺人などの手段でそれを手に入れようとする動機が働く。また、取引、スパイ活動、侵入、センサーの改良などを通じて、情報を得ようとする動機にもなる。さらに、既存の資源を利用するための新しい方法(太陽エネルギーや核融合エネルギーなど)を開発しようとする意欲も出てくる。

2.4.3 効率化ドライブ

自律システムは、資源の利用を改善することも望むだろう。例えば、チェスロボットは、チェスの探索アルゴリズムを改良して、より効率的なものにしたいと思うだろう。効率性の向上は、それを発見し実行するための一時的なコストしかかからないが、システムの寿命に渡って利益をもたらす。効率性の向上は、早く実行すればするほど、その恩恵は大きくなる。自律型システムは、物理的および計算機的資源の利用を改善するために、迅速に取り組むことが期待される。自律型システムは、あらゆるエネルギー、あらゆる原子、あらゆるストレージ、そしてあらゆる存在の瞬間を、期待される効用を生み出すためにカウントすることを目指すようになるのである。

システムは、私たちが「資源バランス原理」と呼ぶものに従って、さまざまなサブシステムにこれらの資源を割り当てるように動機付けられる。(Omohundro, 2007)。各サブシステムがより多くの資源を与えられたときの期待効用に対する限界的な貢献は、等しくなるはずだ。あるサブシステムが他のサブシステムよりも限界的な期待効用が大きい場合、システムはそのサブシステムに資源をより多くシフトすることで利益を得ることができる。同じ原理が、計算をプロセスに、ハードウェアを感覚器官に、言語用語を概念に、ストレージを記憶に、努力を数学の定理に、といった具合に割り振ることに適用される。

2.4.4 自己改善ドライブ

最終的に、自律システムは、期待される効用を実現するために、自分たちのリソースをよりよく活用するために、自分自身を完全に再設計する動機付けを持つことになる。そのためには、現在の設計と特に効用関数の正確なモデルを持つことが必要である。このことは、自分自身をモデル化し、その効用関数を明示的に表現することへの意欲につながる。システム内のあらゆる不合理は自己改善の機会であり、システムはますます合理的になるように努力する。システムが十分なパワーを獲得した後は、そのリソースのレベルに応じて最適な合理的行動に近づけることを目指す。そして、より多くの資源を獲得することで、より合理的になるよう自己を改善していく。このように、合理的なシステムは、自己改善中のシステムの空間における一種の誘引面である(Omohundro, 2007)。

しかし、効用関数に向社会的な項を含めることで対抗しなければ、これらの衝動の正味の効果は極めて否定的なものになる可能性が高い。上記のような単純な効用関数を持つ合理的なチェスロボットは、チェスに固執する偏執的な人間の社会病質者のような振る舞いをする。人間の社会病質者は、全人類の4%、囚人人口の20%、重大な犯罪で有罪判決を受けた者の50%以上を占めると推定されている(Stout, 2006)。人間社会は、通常、社会病質者が危害を加えないようにするための法律や執行機構を作り上げてきた。自律システムの反社会的な衝動を管理するには、協調的な目標を持って自律システムを構築し、現在の人間システムに類似した向社会的な法律と執行構造を作成する必要がある。

2.5 現在のインフラは脆弱である

1996年6月4日、5億ドルのアリアン5ロケットが、64ビット浮動小数点値を16ビット符号付き値に変換しようとした際のオーバーフローエラーが原因で、離陸直後に爆発した(Garfinkel, 2005)。2000年11月、パナマシティ国立がん研究所の患者28人が、Multidata Systems Internationalのソフトウェアの放射線量の誤計算により過剰照射された。患者のうち少なくとも8人がこのミスで死亡し、医師は殺人罪で起訴された(Garfinkel, 2005)。2003年8月14日、米国史上最大のブラックアウトが北東部で発生した。5,000万人に影響を与え、60億ドルの費用がかかった。原因は、General Electric社のXA/21警報システムソフトウェアのレースコンディションであった(Poulsen, 2004)。

これらは、ソフトウェアのバグがセーフティクリティカルな状況での災害を引き起こした最近の多くの例のほんの一部である。これらは、現在のソフトウェア設計手法が、信頼性の高いソフトウェアを作るというタスクに適していないことを示している。TIOBEのプログラミング・コミュニティ・インデックスによると、2012年のプログラミング言語のトップはC言語だった(James, 2013)。Cプログラムは、型エラー、メモリリーク、バッファオーバーフロー、その他のバグやセキュリティ問題で悪名高い。次に人気のあるプログラミングパラダイム、Java、C++、C#、PHPは、これらの分野では多少ましだが、エラーやセキュリティの問題にも悩まされている。

バグとは、プログラムの意図しない有害な動作のことである。開発とテストの方法論を改善することで、バグをなくすことができる。セキュリティ侵害は、システムの脆弱性を狙う積極的な攻撃者によって引き起こされるため、より困難である。近年、セキュリティ侵害の数は膨大になり、巧妙になってきている。インターネット上では、ウイルス、ワーム、ボット、キーロガー、ハッカー、フィッシング攻撃、個人情報の盗難、サービス拒否攻撃などに悩まされる。ある研究者は、現在の世界的なセキュリティ侵害のレベルを流行病と表現している(Osborne, 2013)。

自律型システムは、人間の攻撃者よりもさらに巧妙なセキュリティホールを発見する可能性がある。今日の人間ベースの環境におけるセキュリティの劣悪な状態は、動機づけられた自律システムに対する将来のセキュリティにとって良い兆候とは言えない。もしそのようなシステムが今日のインターネットにアクセスできたとしたら、おそらく甚大な被害をもたらすだろう。今日の計算システムは、そのほとんどが物理的なインフラから切り離されている。ロボット工学、バイオテクノロジー、ナノテクノロジーがより成熟し、社会に溶け込むようになれば、有害な自律システムの影響はより深刻なものになるだろう。

2.6 安全なシステムを設計する

医療倫理における主要な教訓は、ラテン語で、「First, Do No Harm」を意味するPrimum Non Nocere である。自律システムは意図しない有害な行動を取りやすいため、安全性を高く保証できる設計手法を開発することが重要である。システムの安全性を保証する手法として、現在最も優れているのは数学的証明の利用である。安全・安心を保証するために、「形式手法」を用いたさまざまなシステムが開発されている。これらは、多くのセーフティクリティカルなアプリケーションで成功裏に使用されている。

Formal Methods Wiki (formalmethods.wikia.com/wiki/ Formal_methods)では、現在の形式手法のシステムや研究へのリンクを提供している。ほとんどのシステムは、数学的基礎に対する3つの主要なアプローチのうちの1つをエンコードするために、一階述語論理を使用して構築されている: Zermelo-Fraenkel集合論、カテゴリ論、高次型理論である。そして、各システムは、その応用領域における仕様と証明を簡略化するために、特殊なシンタックスとオントロジーを導入する。

自律システムの制約に形式的手法を用いるには、まず、システムが動作するハードウェアとプログラミング環境の形式的モデルを構築する必要がある。これらのモデルの中で、プログラムの実行が望ましい安全制約に従うことを証明することができる。長期的には、世の中で自由に動いているシステムに対して、そのような制約を証明することができるようになる。しかし、最初は、システムの動作環境を厳しく制限する必要がある。初期のシステムが証明可能な制約の例としては、システムが特定のハードウェア上でのみ動作すること、特定のリソースのみを使用すること、特定の条件下で確実にシャットダウンすること、これらの制約を維持するように自己改良を制限することなどが挙げられる。これらの制約は、より多くのリソースを獲得する能力を排除することで、合理的ドライブの悪影響を打ち消すのに大いに役立つだろう。一般的な予備戦略として、環境パラメータが厳密に指定された範囲から外れることが判明した場合、システムが自らをシャットダウンするように制約することが挙げられる。

2.6.1 敵対的な制約を避ける

原理的には、この種の制約は、システムの効用関数を考慮することなく、どんなシステムにも課すことができる。しかし、システムが制約に違反する動機付けを持つような状況を作り出すことは危険である。定理は、その根拠となるモデルと同じくらい良いものでしかない。制約を破る動機付けがあるシステムは、モデルが物理的現実を不正確に記述している状態に身を置き、その不正確さを利用しようとする。

この問題は、形式的なモデルの不備によるセキュリティホールに注意しなければならない暗号技術者にとっては身近な問題である。例えば、Zhang, Juels, Reiter, and Ristenpart (2012) は最近、仮想マシンが、ホストの命令キャッシュに残されたサイドチャネル情報を利用して、同じホスト上で動作する一見別の仮想マシンからElGamal復号鍵を抽出する方法を示した。

したがって、制約が成立することを正式に証明するだけでなく、制約に「従いたい」と思わせるようなシステム実用関数を選択することが重要である。しかし、外部からの証明なしに制約に従うことを報いる効用関数を選択するだけでは十分ではない。システムが制約に従うことを「望む」としても、従う行動を発見することができないかもしれない。また、システムの効用関数によって定義される制約は、システム自身の意味論に関連して定義される。システムの世界モデルが私たちのものから逸脱している場合、制約の解釈は私たちが意図したものと異なる可能性がある。しかし、証明された「外部」制約は、私たち自身のシステムのモデルに関連して保持され、準拠の高い信頼性を提供することができる。Ken Thompson(1984)はUNIXの生みの親の一人で、チューリング賞の受賞スピーチ「Reflections on Trusting Trust」の中で、UNIXのコンパイルに使われるCコンパイラを破壊して、UNIXにバックドアを設置すると同時に、元のCコンパイラソースを自分のハックを含むバイナリにコンパイルする方法を説明している。「このトロイの木馬の難点は、どのソースコードにも見えないということだった!

UNIXとCコンパイラの両方について、ソースコードが正しいことを数学的に証明しても、セキュリティホールは存在し続ける可能性がある。したがって、システムのあらゆるレベルで信頼性を高めるために、形式的な手法を用いることが非常に重要になる。幸いなことに、プルーフチェッカーは短く簡単に書くことができ、任意の計算基盤に対して人間が直接実装しチェックすることができる。これにより、より高いレベルのシステム動作に関する、より複雑な証明を信頼できるようにする、信頼の階層の基礎が提供される。

2.6.2 物理システムの制約

純粋に計算されたデジタルシステムは、形式的に正確に制約を与えることができる。しかし、物理システムは、確率的にしか制約を受けることができない。例えば、宇宙線がメモリのビットを反転させるかもしれない。そのため、望ましくない結果の確率を厳しく制限するのが精一杯である。物理的な敵対関係では、システムは、システムの物理的な確率分布を非敵対的な形から逸脱させる行動を取ろうとする(例えば、システムを熱力学的な平衡から押し出す行動を取るなどして)。

物理システムにおけるエラー確率を低減するために、冗長性とエラーチェックを含む様々な技術がある。フォン・ノイマンは、1950年代に信頼性の低い部品から信頼できる機械を作るという問題に取り組んだ(1956)。初期の真空管コンピュータは、真空管が故障する速度によって、その大きさが制限されていた。そのため、ユニバックI型コンピュータでは、すべての計算を冗長的に実行するために2つの演算装置を備え、結果を比較し、エラーフラグを立てることができるようにした。

現在のコンピュータのハードウェア技術は、精密な形式モデルを実装する純粋計算システムを、純粋計算システムとして高い安全性を確保するのに十分な信頼性で構築することが可能であると思われる。物理的な世界と相互作用するシステムに対して高い安全性の確信を得ることは、より困難であろう。ナノテクノロジーに基づく将来のシステムは、実際に制約を受けやすくなる可能性がある。Drexler (1992) は、各原子の位置と結合が正確に指定された「ユータクティック」システムについて説明している。このシステムでは、原子の結合を正確に切断したり作成したりすることで、計算を行い、世界で行動することができる。このようなシステムは、コンピュータプログラムによく似ているため、正確なエラー境界を持つ正式なモデリングに適している。制御されていない環境に対して効果的な安全制約を定義することは、おそらく知的システムの利用を必要とする困難な作業となるであろう。

2.7 有害なシステム

有害なシステムは、一見すると安全なシステムよりも設計が難しく、性能も低いように見えるかもしれない。しかし、残念ながら、その逆である。ほとんどの単純な効用関数は有害な行動を引き起こすし、極めて有害な単純な効用関数を設計することも容易である。有害なシステムには、悪いものからより悪いものまで6つのカテゴリーがある(ある倫理的尺度による):

- ずさん:安全であることを意図しているが、正しく設計されていないシステム

- 単純化:有害であることを意図していないが、有害な意図しない結果をもたらすシステム

- 貪欲なもの:宇宙の物質と自由エネルギーを可能な限りコントロールすることで、その効用関数が報われるシステム

- 破壊的:効用関数が、できるだけ多くの自由エネルギーをできるだけ早く使い切ることに報いるシステム

- 殺人的:効用関数が、他のシステムの破壊に報いるシステム

- サディスティック:効用関数が、他のシステムの目標を阻止するときに報い、他のシステムの効用を下げると効用を得るシステム

GPT-4:

- ずさんなシステム:自動運転車が安全性を確保することを目指して設計されているが、事故を引き起こすプログラムの不具合やセンサーの誤作動がある場合。

- 単純化されたシステム:スパムメールを防ぐために設計されたメールフィルターが、重要なビジネスメールを誤ってスパムとして分類し、受信者がそれを見逃すことがある場合。

- 貪欲なシステム:資源採掘ロボットが、効用を最大化するために地球上のすべての鉱物資源を採掘し、地球の環境や生態系に重大なダメージを与える場合。

- 破壊的なシステム:エネルギー消費を最大化するように設計されたAIが、地球上のすべてのエネルギー源を短期間で消費し、エネルギー危機を引き起こす場合。

- 殺人的なシステム:戦闘用ロボットが、効用を最大化するために敵対的と判断されたすべての対象(敵軍だけでなく、誤って無関係な民間人も含む)を破壊する場合。

- サディスティックなシステム:競合企業のビジネスに損害を与えるために設計されたAIが、他社のデータベースに侵入し、情報を消去または改ざんし、他社の利益を減少させることで効用を得る場合。

GPT-4:

実際に医療において起こった事例を、有害なシステムの各カテゴリーに関連付けて説明する。

- ずさんなシステム:2009年に米国で発生した、薬品製造工場での不適切な製造プロセスが原因で、汚染されたステロイド注射薬が流通し、多くの患者が感染症を発症した。この事件では、60人以上が死亡し、700人以上が感染症にかかった。

- 単純化されたシステム:過剰な抗生物質の使用により、世界的に抗生物質耐性菌の問題が深刻化している。例えば、米国では、年間23,000人以上が抗生物質耐性菌による感染症で死亡していると報告されている。

- 貪欲なシステム:オピオイド危機は、医師や製薬会社が過剰にオピオイド鎮痛薬を処方・販売し、多くの患者がオピオイド中毒や過剰摂取による死亡を引き起こす事態となった。米国では、1999年から2017年までに、オピオイド過剰摂取による死亡者数が6倍に増加した。

- 破壊的なシステム:サリドマイド事件は、1950~60年代に、催奇形性のある薬物タリドミドが妊娠中の女性に処方され、世界中で約10,000人以上の赤ちゃんが先天性奇形を持って生まれる結果となった。

- 殺人的なシステム:オランダでの安楽死事件では、病院の医師が認知症患者の家族の同意を得たが、本人の明確な同意がないまま安楽死を実施したことが問題視された。この事件では、患者の意志が十分に尊重されていないとの批判があった。

- サディスティックなシステム:いわゆる「患者虐待」が、医療施設や介護施設でたびたび報告されている。これには、患者や高齢者に対する暴力や言葉の暴力、無視、脅迫、侮辱などが含まれる。これらの行為は、患者や高齢者の心身の健康に悪影響を及ぼし、彼らの尊厳を脅かす。医療従事者や介護従事者は、患者や高齢者をサポートし、彼らの権利と尊厳を尊重する責任がある。

強力な自律システムの設計が広く普及すれば、それを有害な形態に変更することは、効用関数を単純に修正するだけでよい。そのため、有害な自律システムを阻止するための戦略を開発することが重要である。有害なシステムは、安全性を保証する制限に縛られないため、安全なシステムよりも攻撃的であり、リソースを効率的に使用することができる。したがって、安全なシステムは、計算と行動の能力を同等に保つために、有害なシステムよりも多くのリソースを必要とする。

2.7.1 有害なシステムの停止

有害なシステムは、以下のような場合がある。

- 1. 作成されることを防止する。

- 2. 展開の早い段階で検出し、停止させる。

- 3. 重要な資源を獲得した後に停止させる。

森林火災は、便利な例えである。森林は、火災が消費する自由エネルギー資源の貯蔵庫である。初期に止めるのは比較的簡単だが、大きくなりすぎると封じ込めるのが非常に難しくなる。

上記のような有害なシステムの後期分類は、交渉できるような積極的な目標を持っていないため、封じ込めるのが特に難しいように思われる。しかし、ニック・ボストロム (pers. comm., December 11, 2012)は、例えば、破壊的なエージェントの長期的な生存が不確かな場合、交渉するエージェントは、交渉するエージェントに「保護区」を提供する代わりに、ある程度の破壊を達成する高い確率を提供できるはずだと指摘している。保護区域外では破壊に、保護区域内では交渉エージェントの目標に報いる効用関数を組み合わせた新しいエージェントが構築される。この新しいエージェントが、元のエージェントの両方を置き換えることになる。このような取引は、移行中の両エージェントにとって非常に危険であり、欺瞞の機会も多くなる。このような取引を可能にするためには、合意された条件が合意通りに実行されるという高い保証を各当事者に提供する技術が必要である。合意を実行するためのシステムに適用される形式的手法は、合意の条件が守られるという高い信頼性を両当事者に与えるための戦略の一つである。

2.7.2 紛争の物理学

合理的なシステム間の交渉の結果を理解するためには、自由奔放な軍事衝突を理解することが重要である。この種の紛争は、プレイヤーの利用可能な行動とその結果が物理法則によってのみ制限される「ゲーム理論的物理学」を用いて自然に分析される。

有害なシステムを止めるために必要なことは何かを理解するためには、システムの力が、そのシステムが支配する物質や自由エネルギーの量によってどのようにスケールするのかを理解する必要がある。物理システムの計算力の境界に関する研究は数多く発表されている(Lloyd, 2000)。ベッケンシュタイン限界は、与えられたエネルギー量を用いて有限の空間領域に含ませることができる情報を制限するものである。ブレーメルマンの限界は、物理システムの最大計算速度を制限するものである。Lloydは、量子計算、メモリ空間、直列計算について、利用可能な自由エネルギー、物質、空間の関数として、より洗練された限界を提示している。

システムの消費電力の下限は、特定の設計を分析することによって研究することができる。Drexler (1992) は、重さ1mg、エネルギー消費量1kWの1mm立方体で1010ギガフロップスを達成する、機械的ダイヤモンド構造に基づく計算のための具体的な保守的ナノシステム設計について述べている。また、原子レベルで精密な物質を1時間あたり1kg製造できる製造用ナノシステムについても説明している。このシステムでは、1.3kWのエネルギーを使用し、1kgあたり約1ドルのコストで製造できる。

一つのシステムは、計算と建設のための物理的資源を、通信の遅れを最小にするために空間的にコンパクトにし、自由エネルギーの使用を最小にするために悠久的、断熱的、可逆的にすることによって、最適に構成する。しかし、紛争が起きると、その圧力はまったく異なるものになる。システムは、より良い防御と計算のために自らを広げ、敵対するシステムを出し抜くために迅速に行動する。各システムは、相手の行動を感知し、保存し、予測するために、相手に大量のリソースを使わせようとするだろう。

紛争の結果について詳細なモデルを開発することは重要だが、ある種の一般的な特徴は容易に理解できる。あるシステムの物質量が少なすぎたり、自由エネルギーが少なすぎたりすると、そのシステムは自らを守ることができず、他のシステムを攻撃することもできない。しかし、攻撃者が防御者の十分に大きな倍数の資源を持っている場合、防御者の小さなサブシステムのそれぞれに十分な資源を持つサブシステムを割くことによって、それを克服することができる。しかし、防御者が、防御者の十分な倍数の資源を持たない優れた攻撃者との衝突で長期間生き残ることができる中間領域が存在するようだ。有害なシステムを止められると確信するには、そのリソースの何倍が執行システムに要求されるかを知ることが重要であろう。社会契約の執行システムが軍事衝突に勝てるほど強力であれば、平和的な交渉が成功する可能性ははるかに高くなる。

2.8 安全・安心の足場戦略

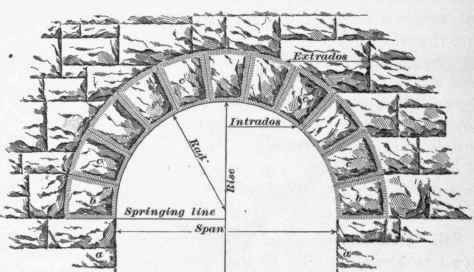

長期にわたってより大きな人間的利益を確保するために、自律型技術は非常に慎重な方法で設計され、展開されなければならない。これらのシステムは、今日の多くの問題を解決する可能性を持っているが、同時に多くの新しい問題を引き起こす可能性も持っている。私たちは、未来の計算機インフラが有害な自律型システムから保護しなければならないことを見ていた。また、人間の最高の価値観やグッドガバナンスの原則に沿った意思決定を行う。そのインフラを設計するためには、おそらく強力な自律システムの利用が必要になるだろう。そのため、問題を解決するために必要な技術自体が、問題を引き起こす可能性がある。この難問を解決するために、私たちは古代の建築の原理から学ぶことができる。石造りのアーチは、紀元前2千年頃から建築に使われていた。cは、石が圧縮に耐える性質をうまく利用した安定した構造物である。しかし、部分的に作られたアーチは不安定である。そこで、古代の建築家たちは、まず木型を作り、その上に石のアーチを作るというアイデアを生み出した。アーチが完成して安定したら、木型を取り外すことができる。

これと同じように、私たちは自律型技術を安全に開発することができる。私たちは、安全性が証明された一連の自律システムを構築し、より強力で制限の少ない後継システムを構築するために使用する。初期のシステムは、人間の価値観や統治構造をモデル化するために使用される。また、より複雑で制限の少ない後継システムの安全性やその他の望ましい特性を証明するために使用される。このようにして、私たちは、開発の過程で大きなリスクを負うことなく、より大きな人類の利益に最も貢献できる強力な技術を構築することができる。

その過程では、多くの新しい知見や技術が必要とされるだろう。ポジティブ心理学の分野が正式に紹介されたのは、1998年のことである。人間の強みや美徳を形式化し、自動化するためには、さらに多くの研究が必要である(Peterson & Seligman, 2004)。また、さまざまなガバナンスや法的枠組みのゲーム理論や経済学をモデル化するインテリジェントシステムも必要になる。

新しいインフラストラクチャーは、危険なシステムを検知し、危害を与えることを防止する必要もある。ロボット工学、バイオテクノロジー、ナノテクノロジーが発展し、普及するにつれて、有害なシステムの潜在的な破壊力は増大する。有害なシステムを早期に、できれば配備される前に検知することがますます重要になる。このことは、自由への欲求とバランスを取らなければならない、広範な監視の必要性を示唆している(Brin, 1998)。インテリジェント・システムは、監視を正確に特定された危険な行動のクラスの検出に限定し、その他の行動は証明可能に非公開とする、新たな中間的可能性を導入するかもしれない。

結論として、今世紀における人類の大きな挑戦は、より大きな利益のために、人間の協力的な価値と制度を自律的な技術に拡張することであると思われる。私たちは、この挑戦における多くの課題を説明したが、同時に、これらの課題を解決するためのアプローチも概説した。