コンテンツ

https://www.lesswrong.com/posts/PwfwZ2LeoLC4FXyDA/against-llm-reductionism

Against LLM Reductionism

byErich_Grunewald 2023年3月9日

概要

- 大規模言語モデル(以下、LLM)は、「単なる」浅いパターンマッチャー、「単なる」大規模ルックアップテーブル、「単なる」オートコンプリートエンジンであると言われることがある。これらの比較は、一種の(方法論的)還元主義である。このような比較は、ある種の真実である一方、誤った、あるいは少なくとも明らかに真実ではない結論を持ち込んでいるように思う。

- 例えば、LLMがやっていることは単なる丸暗記や巧妙な手品に過ぎず、分布外のデータには一般化できないと暗示しているようだ。実際、LLMは一般的なアルゴリズムを学習することができ、私たちが使っているものと同じような世界の表現を含んで使うことができることを示唆する経験的証拠がある。

- また、LLMは単に次のトークンを予測することに最適化しているだけだとも言われているようだ。LLMが(主に)ネクストトークン予測で訓練されているのは事実であり、それがLLMの出力を大きく左右しているのも事実だが、これが実際に機能しているかどうかはわからない。また、次トークン予測を訓練することによって、どのような種類の高度な能力が生まれるのか、あるいは生まれないのかもわかっていない。

- だから、LLMについて考えるときには、慎重であるべきだ。特に、(1)LLMが将来できるようになるかならないかを予測するとき、(2)LLMの中でこういうことが起こるはずだ、起こらないはずだと仮定するときには、注意が必要だと思う。

パターンマッチャー、ルックアップテーブル、確率論的パロット

機械学習(以下、ML)モデル、特にLLMの内部で何が行われているのか、私はまだ多くの点で初歩的な理解しかできていないが、どんなに想像したくとも、それは人間の頭の中で行われているようなものではなく、もっと奇妙な、もっと異質な、もっとエルドリッチ(奇妙で不気味)なものだということは十分に理解できるだろう。LLMがスケールアップされ、より多くの計算量とデータがより多くのパラメータを持つモデルに注ぎ込まれるにつれて、LLMは質的な変化を遂げ、本質的に同じアーキテクチャとトレーニングプロセスを維持しながらも、前任者が把握できなかった、あるいは失敗したさまざまなタスクができるようになった[1]。

一つの方法は、その優秀さを直接否定することである。ゲイリー・マーカスは、法学修士が失敗する無数の方法を指摘し、それを喜んでいる。LLMの主な限界は、信頼性が低く、真実味に欠けることだと彼は言う。(それについての私の考えは脚注を参照されたい[2])。

それも一つのルートだが、私がここで論じたいのはそのルートではない。私がここで議論したいのは、いわば魔法を払拭することである。LLMの内部で行われていることは「浅はか」であり、LLMには「理解」が欠けていると主張することである。これは、LLMはパターンマッチング[3]をしているだけだとか、ウェブ上の資料を言い換えただけだとか、単なる確率的オウム返し[5]に過ぎないとか、巨大なルックアップテーブルから物を取り出すだけだとか、そういう形で主張されることが多い。Gary Marcusは、この根本的な問題を「世界の認知モデルの欠如」と表現している。

新しいモデルが、人間がどのように単語列を使うかについてのデータをより多く、より多く持っていることが、そのような改善の主な理由である。しかし、それでもまだ本物の理解力を伝えることはできず、そのため、非常に壊れやすい[…]。

まあ、ある意味、公平性を保つためなら、この考え方もあながち間違ってはいないのだが。

- LLMは、ある意味、パターンマッチングである。LLMには、入力から特定のパターンを検出し、それがモデルの出力を決定するのに役立つ、大量のアテンションヘッドやニューロンなどがあると思われる。

- LLMは、ある意味、ウェブ上の資料を言い換えたに過ぎない。彼らが訓練を受けているデータのすべて、あるいはほとんどすべてがインターネットに由来しており、彼らのアウトプットはこの事実によって深く形作られている。

- LLMは、ある意味、巨大なルックアップテーブルである。入力と出力を直接対応させるので、しばしば記憶力に頼っているように見える。

AI Chatbot:

ルックアップテーブルは、コンピュータプログラミングにおいて、値間のマッピングを保存するために使用されるデータ構造であり、高速な検索やデータ検索操作を実行するために使用される。ルックアップテーブルに格納される値は、数値、文字列、その他のデータ構造など、どのようなタイプでも可能である。ルックアップテーブルの基本的な考え方は、配列やマップを使ってキーと値を関連付けることで、キーがあれば、データ構造全体を検索することなく、対応する値を素早く取り出すことができるようにすることである。ルックアップテーブルは、データ圧縮や画像処理などのコンピュータアルゴリズムで、処理時間を短縮するためによく使われる。

これらの表現の背景には様々な動機があると思うが、その根底にあるのは、AIシステムは現在、見た目よりも能力が低く、将来的には私たちの予測よりも能力が低くなるという考え方のようだ[6]。特に、LLMが浅いパターンしか学習しない場合、分布外のデータに対して一般化する能力が低下してしまうだろう。今回の投稿はまさにそれだ。これらの表現は、現在と将来のAIの能力について何を表現しているのか(LLMに意識があるかどうか、意識はあるか、といった質問ではないが、重要な質問かもしれないこと[7])についてである。特に、私がMLの専門家でないことを指摘する良い機会かもしれないが、これらの記述方法–パターンマッチング、ルックアップテーブル、確率的パロット–はLLMの良い記述方法ではなく、おそらくこれらを使うべきではない、と主張するつもりでいる。

それは良い説明ではない

LLMはパターンマッチャーである、などという懸念は、こう言われるかもしれない。「ああ、それでどうなんだ?」これは、スコット・アレクサンダーが、何年も前のように感じるが実際は2018年のことであるGPT-2について議論しているときに、彼が書いたときに表現したことである。

昨日の記事に対して、ある機械学習研究者が私にこう書いてきた。「GPT-2は、インターネットをブレンドして、質問されたらちょっと不味い混合物を返す、ブルートフォース統計的パターンマッチャーだと今でも思っている」

「ああ、まあ、きみのお母さんは、インターネットをブレンドして、聞かれたらちょっと不味い混合物を返すブルートフォース統計パターンマッチャーだろう」と答えたい衝動に駆られた。でも、それは真実だっただろうと思う。

つまり、ある物事が「単なる」パターンマッチングであるとか、インターネットからフレーズをつなぎ合わせるだけであるとか、ルックアップテーブルで物事を検索するだけであるとか、そうでないとかいうとき、人々はしばしば異なることを意味しているように思えるのである。このような誤解は、あらゆる場面で頭をもたげてくるものである。特に、このような主張は、読者に誤った印象を与え、次のようなことを思わせてしまうのではないだろうか。

- LLMは実際に流通外の業務がうまくなっているわけではなく、これまで以上に精巧な「パーラートリック」を学んでいるだけだ。

- LLMの中には、面白いことや洗練されたことは何もない。

- LLMは純粋に丸暗記に頼り、抽象的なルールや世界のモデル、因果関係のメカニズムを推論することはない。

- LLMは単なるオートコンプリートエンジンであり、正確な次のトークンを予測するために最適化されているに過ぎない。

- LLMはユニークなものを生み出すことはできない。

- LLMは計画の作成および/または実行ができない[8]。

私の判断では、少なくとも一部のLLMについては誤りであり、その他については不明だが、いずれにせよ、現段階でLLMについてわかっていることを考慮すると、誰かがこれらのどれかが真実であると確信を持って信じることが正当化されるとは思えない。

LLMは一般的なアルゴリズムを学ぶことができる

まず、LLMは巧妙なパーラートリック(手品)でしかしない、丸暗記に頼るしかない、浅いパターンを覚えるしかない、という意味合いがある。これらのことはしばしば真実だが、常に真実というわけでもないと思う。

- LLMが一般的な分析能力を身につけ、それを使って難しい問題を解決できるという証拠がある。

- モジュールと2進数の足し算で訓練された小さな非言語の変換器が、完全に一般的なアルゴリズムを学習できるという証拠があるのだ。

- LLMや類似のモデルには、計算量やデータ、パラメータを増やすと、突然新しいタスクを解決できるようになるという、相変化の証拠がある。LLMが丸暗記しかしていないのであれば、これは説明しにくい。

一般的な分析能力

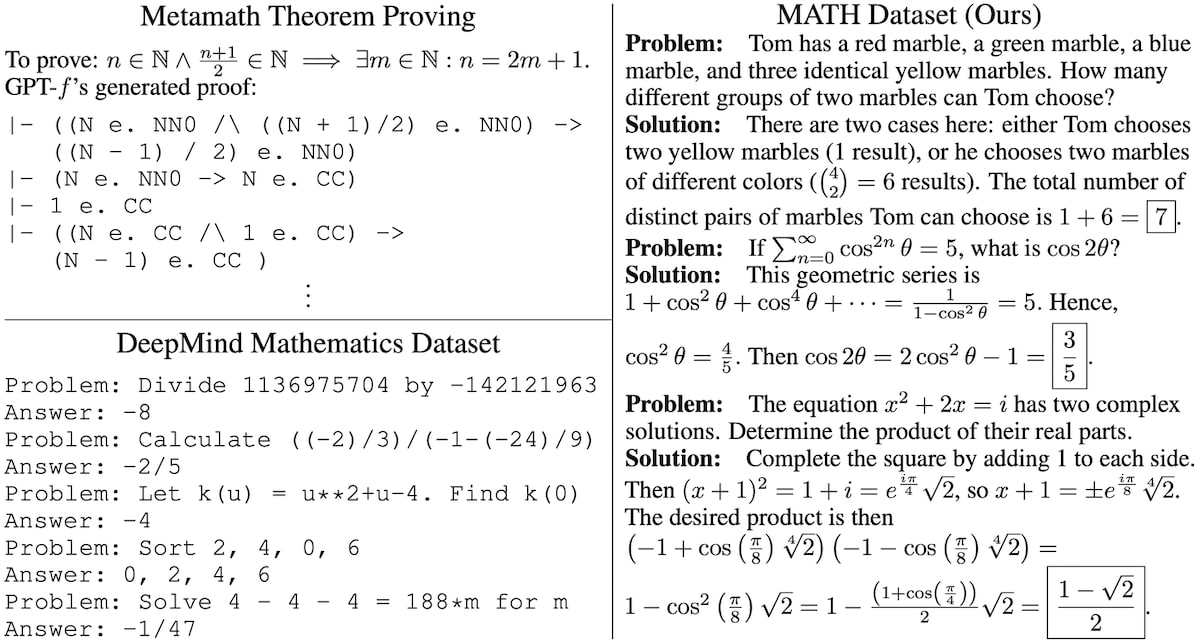

Lewkowyczら(2022)は、PaLM(Googleが作成したLLM)のバージョンを技術コンテンツ(例えば、arXivのプレプリント)で微調整し、MATHデータセットでそこそこの性能(成功率〜50%)を得られるようにした。問題は些細なことではない(右側のパネル)。

著者らは、このモデルが単なる丸暗記でこのような結果を得たのかどうかを調べるための手段を講じている。まず、モデルが最も良い結果を出した100の問題を見て、その痕跡をトレーニングセットから探すが、何も見つからなかった。次に、問題を修正(言い回しや数字を調整)して、モデルの成績が悪くならないかを調べるが、そうではない。最後に、モデルの解答をデータセットにある真実の解答と比較し、同じような言い回しになるかどうかを調べるが、非常に短い答えの問題を除いては、そうではない。

このことは、このモデルが、この種の問題を解くのに一般的に有用なルールやアルゴリズムを本当に学習していることを示唆しているね。とはいえ、モデルを分解して、そのアルゴリズムをモデルの重みの中に見出したわけではない。

完全一般化アルゴリズム

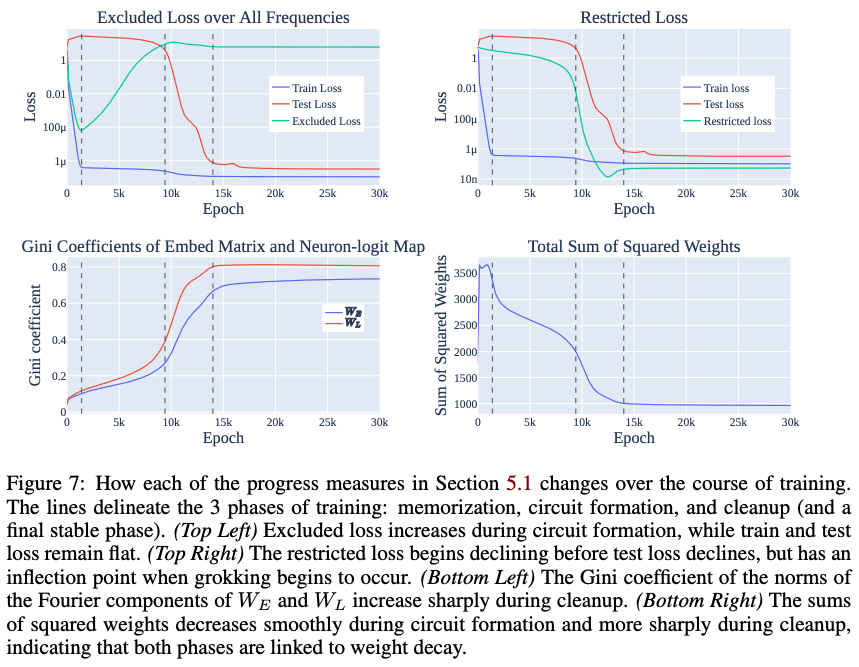

Nandaら(2023)は、モジュール加算(モデルが扱える最大数(この場合は113)を超えた場合、結果が「折り返し」て再び0から始まる加算)の小さな(私のカウントが正しければ〜200Kパラメータ)変換器を訓練し、訓練誤差(青線)を素早く0近くまで減らした後、突然それも0近くまで減少するまで、モデルが長い間高いテスト誤差(赤線)で止まっていることを発見した。

この現象はグロッキングと呼ばれ(Power et al.2022)、テストデータで急激に改善することを相転移と呼ぶ。まるで、最初は訓練データの答えを記憶しているだけのモデルが、やがて完全に一般的なアルゴリズムを見つけ、テストデータに対して~完璧に汎化できるようになるかのようだ。そして実際、このモデルは「離散フーリエ変換と三角恒等式を使って、加算を円周上の回転に変換する」(Nanda et al.2023)ことが判明した。このアルゴリズムはかなり複雑で、連続した層に広がる複数のステップで進行し、コンピュータで加算が通常働く方法とは低レベルで全く異なっている。

このブログの記事も同じような話である。著者は、極めて小さな(422パラメータ)ニューラルネットワークを訓練して2進数の加算を実行させ、内部を覗き込んで賢いアルゴリズムを発見している。

相変化

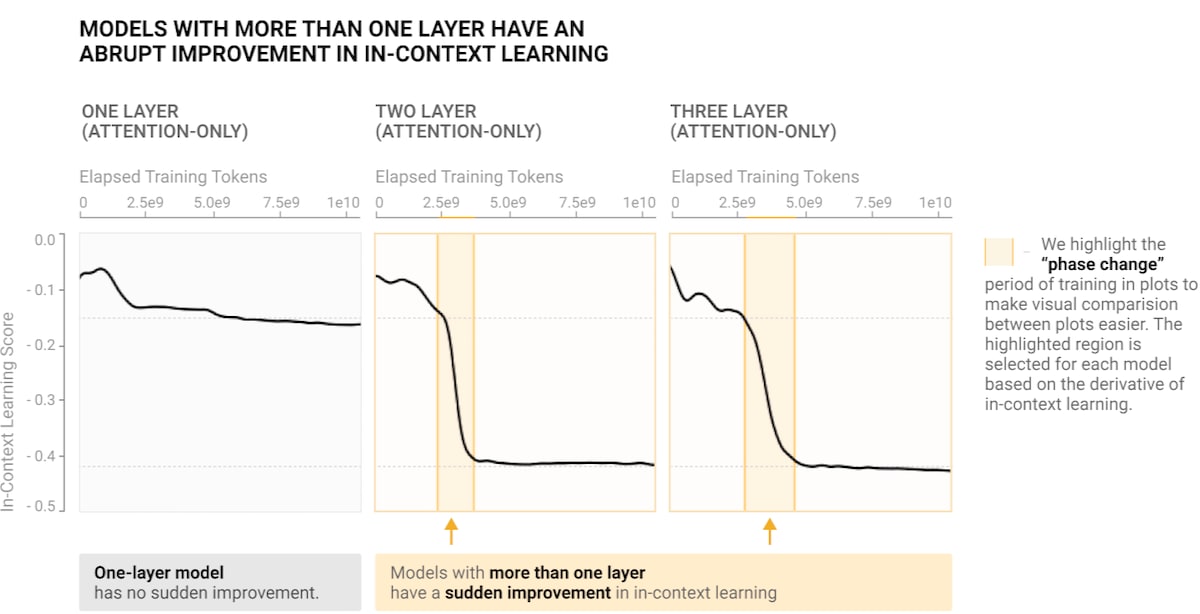

この2つの追加実験は、LLMで行われたわけではないが、似たようなアーキテクチャのモデルで行われたので、LLMが原理的にも実際にも完全に一般的なアルゴリズムを見つけることができるという強い証拠のように思える。LLMの中で実際に発見されたアルゴリズムについての証拠は乏しく、LLMは気の遠くなるような巨大さだからだ。しかし、LLMには、より多くの学習やより大きなモデルの結果として、相変化の証拠がいくつかある[11]。例えば、Olssonら(2022)で研究された言語モデルは、文脈内学習が著しく向上する相変化を起こす。

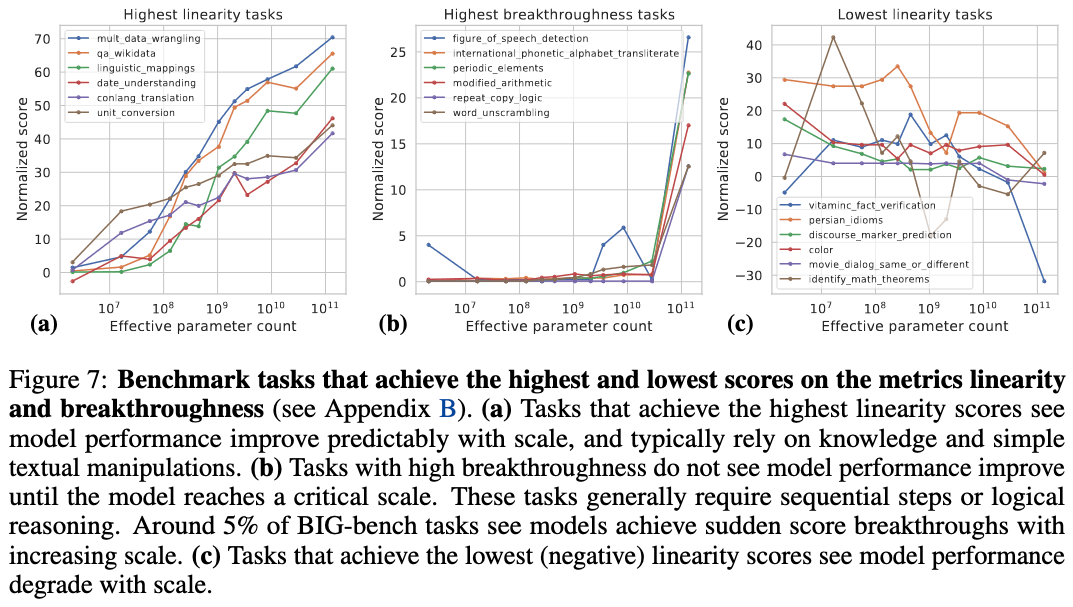

また、Srivastavaら(2022)のBIG-benchデータセットでは、LLMの学習データに現れないように設計されたタスクで構成されているが、一部のタスク、特に算数のような知識・記憶に依存しないタスクでは、LLMはモデルサイズスケーリングの位相変化を起こすことが分かる(中段)。

こういう場合、具体的にどうなるのか、私にはよくわからないのだが。

- これらの言語モデルは、Nandaら(2023)のモジュール式加算モデルに似た方法で、一般的なアルゴリズムを発見する(あるいはパラメータ数が増加した場合には、それが可能になる)可能性があるが、モジュール式加算モデルとLLMの間には重要な異同が存在する。

- もう1つの可能性は、1つ目の説明と似ているかもしれないが、特にそれらのタスクには、部分的な成功がないことである。モデルが失敗すれば、完全に失敗する。

また、一般的なアルゴリズムの発見や利用は、例えばクリエイティブ・ライティングよりも算数の方がはるかに簡単だ。しかし、LLMが純粋に丸暗記や浅いパターンマッチングに頼っていたのでは、このような相異が起こるとは考えにくい。

LLMは世界のモデルを格納し使用することができる

ここで再び、ゲイリー・マーカスの一節を紹介しよう。

GPT-3がGPT-2より純粋に優れているのは事実であるし、InstructGPTがGPT-3より純粋に優れているのも事実かもしれないね。確かに、どのような例でも、正解の確率は上がっていると思う。[しかし、根本的な問題である「世界の認知モデルの欠如」が改善されたと考える理由はまったくない。新しいモデルが、人間がどのように単語列を使うかについてのデータをより多く、より多く持っていることが、その改善の主な理由である。

これは経験的な問題だが、LLMは非常に巨大で、しかもさまざまなテキストを対象に学習するため、機械的な解釈可能性研究の対象としては捉えにくいものである。その代わり、研究者はより小さなモデルを研究する傾向がある。より小さな言語モデルの中に、世界を表現する証拠があるのだろうか?そうだ、ある。

Toshniwalら(2021)は、チェスのゲームログでGPT-2類似のLLMを微調整し、このモデルが内部でボード状態を表現しているという状況証拠を発見した。この論文に触発され、Liら(2022)はオセロのゲームログでGPTの変種を微調整し、ゲームの盤面状態を完全に直感的に表現するネットワーク内部を発見した。ここでは、特に2つの観察が重要である。(1)このモデルは合法的な手を予測することができる。(2)ゲーム中に盤面状態の内部表現を変更すると(いわば一種の手術)、次の手の予測がそれに応じて変化するのを見ることができる。(この点については、この論文の筆頭著者によるブログ記事がわかりやすく、かつ詳細に書かれている)

言語モデルが世界の表現に欠けているというのは、明らかに事実ではない。問題は、言語モデルがどの程度、そのような表現を持っていて、それを使っているかということである。

LLMにも世界表象のヒントがある。特に、LLMの内部に色の表現があるという証拠を見つけた論文がある(Li, Nye, and Andreas 2021; Abdou et al. 2021; Patel and Pavlick 2022)。つまり、LLMの中にも世界の表現がある可能性が高い。LLMは、簡略化された次のトークンの予測に役立つ。

もちろん、現実の世界は複雑で厄介で、オセロや色のように完璧にモデル化することはできない。しかし、現実の世界は不完全にモデル化することができ、それは長い道のりを歩むことができる。人間の脳は、チェスのゲームを簡単にモデル化できるが、他人の行動を簡単にモデル化することはできない。しかし、それは致命的なことではない。なぜなら、私たちは他人の行動をある程度しかモデル化することができないが、その結果、その人が何をするかについてほとんど良い予測を立てることができるからだ。LLMもまた、多くの厄介で複雑な現象をモデル化することができるようになると思う。

LLMはネクストトークン予測ではなく、ネクストトークン予測アーテファクトである

ゲイリー・マーカス氏は語る。

ニューラルネットワークのモデルを大きくしていくと、良くなるものもあれば、そうでないものもある。特に信頼性と真実性において、そうでないものがあるのは、これらのシステムが世界についてのこうしたモデルを持っていないからだ。これらのシステムは、基本的にオートコンプリートを見ているだけなのである。私たちの文章を自動補完しようとしているだけなのである。しかし、これではAGI(人工知能)と呼ばれるものに到達するのに必要な深さとは言えない。

Shanahan (2022)は、はっきり言って、私よりはるかにAIに詳しい人が書いた一流の論文だが、微妙にではあるが、似たような感情がある。

例えば、LLMに「月面を歩いた最初の人物は」というプロンプトを出し、「ニール・アームストロング」と答えたとする。ここで私たちは何を問うているのだろうか。重要な意味で、私たちは「月面を歩いた最初の人物は誰か」と聞いているのではない。私たちがモデルに問いかけているのは、次のような問いかけである。膨大な公開コーパスの(英語の)テキストに含まれる単語の統計的分布を考えると、「The first person to walk on the Moon was」というシーケンスに続く可能性が最も高いのはどの単語か?この質問に対する良い答えは、「ニール・アームストロング」である。

LLMがネクストトークン(トークンとは大まかに言って単語のこと)予測で学習されるのは完全に事実である(ChatGPTのように、人間のフィードバックによる強化学習で追加学習されるものもあるが)。この事実が、生成されるテキストに大きな影響を与えるということも、完全に事実である。だから、LLMをオートコンプリートエンジンと呼んだり、ネクストトークンの予測を強調したりするのは、不合理だとは思わない。しかし、それは微妙に誤解を招くと思う。

- LLMは次のトークンの予測に最適化されるように訓練されているが、必ずしもそれが彼らの仕事ではない。私たちは、LLMが何をするのかを知らないのである。トレーニングの過程で、配布中のデータに対してより良いネクストトークン予測を行うような行動やヒューリスティックがモデル内で強化される。しかし、これらの行動やヒューリスティックが、特にモデルが分布外データに遭遇したときに、次のトークンの予測を最適化することを基本的に「目的としている」ことを意味するわけではない[12]。

- ここでいう通常の例とは、人類の進化のことである。人類は、生殖適性を最適化するプロセスによって形作られた。このため、家族の絆、名声、性的快楽といった一連の欲求が生まれた。この欲求は、基本的には生殖の最適化には関係ないのだが、新しい環境(例えば、避妊具のある環境)に入ると、それが明らかになる。

- さらに、知性が役立つタスクに最適化することで、最適化されたものがより知的になることを促す。サム・アルトマンは先週、「言語モデルは、次の単語を予測するようにプログラムされているだけです。私たちを含む動物は、生存と繁殖のためにプログラムされているだけなのに、そこから驚くほど複雑で美しいものが生まれてくるのです」と述べた。

- 次のトークンを予測するのに役立つ知能の形は、人間の生殖に役立つ知能の形とは異なるが、(1) 基本的な能力、例えば概念の使用や適用などは、非常に広く役立つと思われるし、(2) LLMが訓練するデータは、人間によって、人間のために書かれ、しばしば人間や私たちにとって重要な事柄について書かれている。(ジェイコブ・スタインハートは、Alignment Forumのこの投稿で同様の主張をしている)。

チンパンジーの「次の言葉」予測思考実験

それと同じような思考実験を紹介する。10万匹のチンパンジーを想像してほしい。このチンパンジーは、一生を感覚遮断室で過ごし、互いに顔を合わせることはない。大人になったとき、チンパンジーに不完全な文章を与え、それぞれの文章について次の単語を予測するよう求める。(仮に、各不完全なテキストに対して、可能な限りの単語を与え、1つを選択させる。)これらの文章は、1991年から2023年までに人間がインターネット上に書き込んだものである。次の単語を予測するタスクで最も優秀だった1%のチンパンジーは生殖が可能で、彼らの精子と卵子を取り出し、人工子宮で子供を作る。そして、その世代はすべて安楽死させられる。(この作業が1T(1兆)年続くとする(参考までに、H.サピエンスとP.トログロディテスは約400-1300万年前に分岐している)。

問題は、この最適化プロセスの向こう側に、どのような生物が出現するかということである。どのような(認知)能力を持つのだろうか?2023年の人間について知っていることがあるとすれば、それは何だろうか?

非常に憶測だが、もっともらしいと思われる話を紹介する。

最初は、チンパンジーが偶然よりうまくいくことはほとんどなかった。

そして、ある突然変異により、一部のチンパンジーは「the」や「a」といった単語をよく選ぶようになり、この対立遺伝子は遺伝子プールの中で急速に広まっていった。

例えば、「from time to」を「time」で完結させたり、「the Eiffel Tower is in」を「Paris」で完結させたりする傾向があるなど、他の変異はチンパンジーにより精巧なヒューリスティクスを与える。例えば、「ジェフ・ベゾスはアマゾンのCEOだ」という言葉は、「アマゾンのCEOは」という意味であり、「ジェフ・ベゾス」で完結させるべきものである。これらのヒューリスティクスは、私たちが知識、概念の使用、推論、演繹などと呼んでいるものと機能的に区別がつかないようになり始める。そして、これらのことはすべて選択される。なぜなら、次の単語を予測する能力が高いチンパンジーを生み出し、それが彼らの繁殖適性にとって重要なすべてだからだ。

(チンパンジーはLLMではないし、進化は確率的勾配降下法とは異なる最適化プロセスであるということは注目に値する)。私は、どの異系がここに関係しているのか混乱している。私は、チンパンジーが遺伝子の突然変異によって知識、あるいはそれに近いものを獲得できると仮定しているのは明らかである。チンパンジーの脳はおそらくそのようには働かないだろうが、そのおかげで思考実験がLLMの訓練に似ているのだ…)

これが延々と続くのだ。さて、このプロセスはどのような能力に向かうのだろうか?その結果、どのような生物が誕生するのだろうか。その生き物は、人間が書いた文章の次の言葉を予測するために、どんな能力を発揮するのだろうか?

さらに推測になるが、このような予測をするのに役立つことをいくつか思いつく。

- それは、1991-2023年のインターネット上で人間が書くものについての親密な知識(あるいはそれに類するもの)を持っている(あるいは少なくとも含んでいる)のかもしれない。

- 1991-2023年のインターネットにものを書く人間について、(…)親密な知識を持っているのかもしれない。

- 幅広い一般的な推論力を有している可能性がある。

- 次の言葉を予測するための特殊なスキルを多数持っている可能性がある。例えば、(人間の)数学の仕組みを学ぶことで、数学に関係する文章をより正確に予測することができるようになる。

- そのような知識をより多く得て、推理力を向上させる能力や意欲があるのかもしれない。

- 次の単語を予測する、しかも正しく予測する、予測するまで死なない、あきらめないというモチベーションを生来持っているのかもしれないね。

さらに、このような生物に2024年のリアルワールドでコンピュータを与えたとして、進化した(流通する)知識、あるいは苦労して獲得した才能を、新しい(流通しない)環境で使うことができるのか、と考えてみるのもよいだろう。文字でしか世界を見れないため、検証能力がないことが致命的なのかもしれない。次のトークンを予測しやすくするために、世の中に影響を与えようとするかもしれない(あるいは、それ以外のことに憧れるかもしれない)。これらはすべて、未解決の問題であると私は考えている。別の言い方をすれば、現在構築されているLLMが一般的な知能にスケールアップするかどうか、あるいは学習させる世界(テキスト)や方法(ネクストトークン予測)によって制限されるかどうか、私にはわからない。そのためには、マルチモーダルシステムや他のものが必要かもしれないし、あるいは、決して不可能なことかもしれない。

注意すべき理由

LLMの能力を予測する場合(その予測は何度も外れている)、LLMの内部でこういうことが起こるはずだ、起こらないはずだと仮定する場合、いずれにせよ、LLMについて考えるときには、並々ならぬ注意を払う必要があると思う。

例えば、Landgrebe and Smith (2021)には、こんな一節がある。

[確率モデルは安定した環境を必要とする。確率モデルの出力の質は、それが表現しようとする現実の入出力関係をどれだけよく反映しているかに依存する。(中略)関係が安定していても、入出力関係のどちらかが少しでも変化すれば、モデルはすぐに無効になってしまう。これは、モデルが一般化しないためだ。学習させた分布とは異なるデータを入力すると、モデルは失敗する。

しかしこれは、少なくともいくつかのケースでは間違っている。MLモデル、特に言語モデルは、明らかに汎化できる。例えば、前述したモジュラー/バイナリ加算のモデルで、そのことが確認されている。もちろん、常に完璧に汎化できるわけではないのは事実である。それはMLの研究者が取り組んでいる工学的な問題である。しかし、前述のようにこの文章は2021年当時も間違っていたし、現在も同様に間違っている。

同じ論文にこだわって、Landgrebe and Smith(2021)は論じている。

[ディープニューラルネットワーク]は、文脈に沿った文の解釈に必要な推論を行うことができない。この問題は、次のような簡単な例で説明される。

“The cat caught the mouse because it was slow” vs. “The cat caught the mouse because it was quick.”

「猫がネズミを捕まえたのは[それが]遅かったからだ」 vs 「猫がネズミを捕まえたのは[それが]早かったからだ」

それぞれの文の”it “は何だろう?アナフォラを解決するためには、世界知識(ここでは、物体の同一性の持続、捕獲、速度、捕食者と被食者の役割など)を使って推論する必要がある。しかし、これまでのところ、このような事前知識をどのように[ディープニューラルネットワーク]に組み込むか(もしそれが可能であれば)については、ほとんど研究されていない。その結果、強化学習のように学習材料を合成的に生成できるゲーム的な状況を除けば、現在のあらゆる用途で作られた[ディープニューラルネットワーク]モデルは、非常に弱いものにとどまっている。ディープニューラルネットワーク]モデルを多数集めて「アンサンブル」と呼ばれるものにしても、この問題を克服することはできない。

それは一方で、2021年当時はそうだったけれど、今はどうなのか。

ME:この2つの文のそれぞれの[it]は何だろうか?

- 「猫がネズミを捕まえたのは、[それが]遅かったからだ」

- 「猫がネズミを捕まえたのは、[それが]速かったからだ」

CHATGPT: 最初の文では、”it “はネズミのことで、ネズミは遅いので、猫に捕まったのです。第2文では、”it “は猫のことで、猫は足が速く、それゆえネズミを捕まえることができました。

(GPT-3のtext-davinci-003版はまだこのタスクに失敗しているようだが、davinci-instruct-βは成功している。この改善は、davinci-instruct-βで行った人間の例に対する微調整や、ChatGPTが使用しているモデルgpt-3.5-turboで行った人間のフィードバックに対する強化学習によるものと思われる。なお、gpt-3.5-turboは、このテストの微妙に難しいバージョンでまだ失敗している[13])。

私も、過信に弱い。「エッフェル塔 → パリ」という連想が格納されているLLMの部分を「エッフェル塔 → ローマ」と修正し、「エッフェル塔はイタリアのローマのサン・ピエトロ大聖堂の真向かいにある」などと出力させるMengら(2022)を初めて聞いたとき、LLMが人間の概念に非常に近いものを持ち使っているという決定的証拠になると思った。しかし、ジャック・ティボドーの投稿を読み、特に、(1)編集は双方向ではないこと(例えば、LLMはローマの有名な塔をエッフェル塔と認識していないようだ)、(2)「Eiffel Tower」というフレーズが明示されていない促しには反応しないようだ、ということがわかった。ここでの教訓は、LLMは奇妙で複雑で人間離れしているということである。

「もし私たちが成功するとしたら[…]、それはYを『ただのX』 に減らすことでなければならない」

2020年当時(一昔前!)、グワーンはこう書いていた。

多くの人が抵抗することなく、むしろ喜ぶ誘惑に駆られる。それは、専門家としてのデフォルメに屈し、どんなモデルも「単なる」あれこれ(「数十億のIF文」、「数百万の乗算」、「記憶したウェブページ」)として切り捨てることであり、チェスエンジンについてMoravecが評したように木を見て森を見ない。

「この出来事は多くの理由で注目されたが、特にここで注目されるのは1つの理由である。両試合中、カスパロフは何度もマシンに心の動きがあることを報告した。第2回大会では、舞台裏で人間がディープブルーに戦略的な洞察を与えているのではないかと心配したこともあったそうだ[他のすべてのチェスコンピュータでは、無差別だが限定的な先読みと長期的な戦略の欠如からくる機械的な予測可能性を報告している。ディープ・ブルーには、その代わりに「宇宙人の知性」を見たのである。」

[…]ディープブルーの開発者は、他のチェスマシンに対する量的優位性を熟知しているが、そのプレイの質の違いをカスパロフと深く共有できるほどのチェスへの理解がない。この二律背反は、今後ますます顕著になると思う。先進的なロボットのメカニズムを熟知しているエンジニアは、自分たちが本物の頭脳を持っていると認めるのは最後だろう。ロボットの内部では、どんなに精巧なレイヤーであっても、機械的な原理に従って動作する機械であることに間違いはない。しかし、外から見て、全体として理解できるようになったとき、初めて知性を感じることができるのである。人間の脳もまた、神経生物学者の顕微鏡の下では知性を発揮しないが、会話に参加することで知性を発揮するのだ。

しかし、もちろん、AIや還元主義全般で成功するとしたら、それはYを「ただのX」に還元することに違いない。知性を必要とするタスクが、「知性」を持たないよく定義されたアルゴリズムで解決できることを示すことが、まさに成功の姿でなければならないのである!(そうでなければ、疑問は完全に霧散し、問題は別のところに押しやられるだけだ。(そうでなければ、疑問は徹底的に持ち去られ、問題は別の場所に押しやられただけだ。コンピュータチップはトランジスタでできており、特に小さなホムンクルスではない)

次の言葉を予測するチンパンジーは、誤った比喩である。私はそれを容易に認める。実際、私が出会ったLLMのメタファーはどれも間違っていて、ばかばかしいものばかりだった。LLMの例示的な比喩はあるが、真の比喩はない。私が思いつく最高の比喩も間違っているが、少なくとも、これらのシステムが実際にどのように機能するかはわからないというメッセージ、つまり、私たちは偉大な計算雲を見ているのだというメッセージを伝えている。

オリバー・ゲストの草稿に対するフィードバックに感謝する。

参考文献

アブドゥ、モスタファ、アルトゥール・クルミゼフ、ダニエル・ハーシュコビッチ、ステラ・フランク、エリー・パブリック、アンデルス・ソガード。2021.”Can Language Models Encode Perceptual Structure without Grounding? a Case Study in Color.” arXiv.https://doi.org/10.48550/ARXIV.2109.06129

Elhage, Nelson, Neel Nanda, Catherine Olsson, Tom Henighan, Nicholas Joseph, Ben Mann, Amanda Askell, et al. 2021.「トランスフォーマー回路のための数学的フレームワーク」トランスフォーマー回路スレッド。

ランドグレーブ、ジョブスト、バリー・スミス。2021.”Aiを再び意味あるものにする”.Synthese198: 2061–81.

Lewkowycz, Aitor, Anders Andreassen, David Dohan, Ethan Dyer, Henryk Michalewski, Vinay Ramasesh, Ambrose Slone, et al. 2022.”Solving Quantitative Reasoning Problems with Language Models.” arXiv.https://doi.org/10.48550/ARXIV.2206.14858

リ、ベリンダ・Z、マックスウェル・ナイ、ジェイコブ・アンドレアス。2021.”Implicit Representations of Meaning in Neural Language Models.” arXiv.https://doi.org/10.48550/ARXIV.2106.00737

Li, Kenneth, Aspen K. Hopkins, David Bau, Fernanda Viégas, Hanspeter Pfister, and Martin Wattenberg.2022.”Emergent World Representations:合成タスクで訓練されたシーケンスモデルの探索” arXiv.https://doi.org/10.48550/ARXIV.2210.13382

メン、ケビン、デイビッド・バウ、アレックス・アンドニアン、ヨナタン・ベリンコフ。2022.”Locating and Editing Factual Associations in Gpt.” arXiv.https://doi.org/10.48550/ARXIV.2202.05262

ナンダ、ニール、ローレンス・チャン、トム・リーバム、ジェス・スミス、ジェイコブ・スタインハート2023.”Progress Measures for Grokking via Mechanistic Interpretability.” arXiv.https://doi.org/10.48550/ARXIV.2301.05217

Olsson, Catherine, Nelson Elhage, Neel Nanda, Nicholas Joseph, Nova DasSarma, Tom Henighan, Ben Mann, et al. 2022年。「インコンテキストラーニングとインダクションヘッド」トランスフォーマー・サーキット・スレッド

パテル、ローマ、エリー・パブリック。2022.「言語モデルを根拠ある概念空間にマッピングする」.InInternational Conference on Learning Representations.https://openreview.net/forum?id=gJcEM8sxHK.

Power, Alethea, Yuri Burda, Harri Edwards, Igor Babuschkin, and Vedant Misra.2022.”Grokking:小さなアルゴリズムデータセットでのオーバーフィッティングを超えた一般化” arXiv.https://doi.org/10.48550/ARXIV.2201.02177

シャナハンマーレー2022.「大規模言語モデルについて語る」Arxiv Preprint Arxiv:2212.03551.

Srivastava, Aarohi, Abhinav Rastogi, Abhishek Rao, Abu Awal Md Shoeb, Abubakar Abid, Adam Fisch, Adam R. Brown, et al. 2022.”Beyond the Imitation Game:言語モデルの能力を定量化し、外挿する” arXiv.https://doi.org/10.48550/ARXIV.2206.04615

Toshniwal, Shubham, Sam Wiseman, Karen Livescu, and Kevin Gimpel.2021.”Chess as a Testbed for Language Model State Tracking.” arXiv.https://doi.org/10.48550/ARXIV.2102.13249

Wei, Jason, Yi Tay, Rishi Bommasani, Colin Raffel, Barret Zoph, Sebastian Borgeaud, Dani Yogatama, et al. 2022年。”Emergent Abilities of Large Language Models.” arXiv.https://doi.org/10.48550/ARXIV.2206.07682

- 算数、単語のスクランブル解除、類推など、ベンチマークタスクのセットを用いて測定された創発的な能力の例については、Wei et al.(2022)を参照。︎

- LLMが信頼性に欠けることは事実だが、マーカスの評価や予測は間違っていると思う。なぜなら、(1) 多くのアプリケーションでは信頼性は必要ない、(2) 必要な場合でも、LLMの出力をチェックする品質管理プロセスを追加するなどして、LLMの信頼性の欠如を回避できる場合がある、(3) AI能力のフロンティアは永遠に欠陥があるとしても、LLMは特定のタスクにおいてより信頼性が高くなっている[14]。これは、かつてフロンティアであった特定の能力が、今では当たり前になっているために忘れられがちで、マラソンランナーが数歩先を見据えたまま、自分の移動距離を実感していないことを思い起こさせる。真実性については、不確定要素が多いが、LLMはもっと良くなると思う。しかし、人間と同じように、すぐに完璧な真実性を持つようにはならないだろうし、それは現実の問題である。

- ゲイリー・マーカスは、「LaMDAも、その同類(GPT-3)も、インテリジェントとは言い難い」と書いている。彼らがすることは、パターンをマッチングさせ、人間の言語の膨大な統計データベースから引き出すだけである。”︎

- ChatGPTがウェブページの内容を一字一句引用するのではなく、言い換えることで、読んだことをそのまま繰り返すのではなく、自分の言葉で考えを表現しているように見せ、ChatGPTがその内容を理解しているように錯覚させるのです。人間の場合、丸暗記は真の学習の指標にはならないので、ChatGPTがウェブページから正確な引用をすることができないのは、まさに何かを学んだと思わせるためなのである。言葉の並びを扱う場合、非可逆圧縮の方が可逆圧縮よりも賢く見える。[しかし、文章を書くということは、既存の文書を信頼性の低いコピー機にセットして印刷ボタンを押すこと以上のことが必要なのである。将来的には、自分の世界観だけで文章を書くことができるAIができるかもしれない。しかし、その日は私たちの予測のはるか彼方にある。それまでは、「ウェブを言い換えるものを持っていて、何の役に立つのか」と問うのが妥当だろう。︎

- エミリー・ベンダーは、「『言語モデル』とは、膨大な学習データから、文脈や意味を全く考慮せずに、無造作に言語形態をつなぎ合わせるシステムである。確率的オウム返しという言葉もここから来ている。オウムは音を真似るが、その意味を理解していない。LMは無造作に形を出力することがあり、もっともらしく見える形を作るのはかなり上手になっている。しかし、合成されたテキストを理解するのは、やはり人間であり、合成されたテキストに出会った人間である。コンピュータは、人間が意味づけするためのパターンを作っているに過ぎない。ChatGPTはまだ単なる言語モデルであり、テキスト合成マシン/ランダムBSジェネレーターに過ぎない。そのトレーニングは、特定のトピックのように見えるものを避けるトレーニングなど、BAの形をもう少し洗練させたが、まだそこには何もない。[ChatGPTは、学習データから単語の組み合わせで文字列を生成している。人間が理解したときに正しくて理にかなったことを言っているように見えることがあっても、それは偶然に過ぎないのである。”ベンダーの議論を「浅いパターンマッチャー」や「大量のルックアップテーブル」といった表現で括るのは不公平かもしれない。つまり、LLMは(1)言葉の意味を世界の感覚的な経験に基づかないため、理解することができない、(2)何も意図せずにテキストを生成する、というものである。しかし、ベンダーは、このことがLLMにできること、そして将来できるようになることに影響すると考えているようだ。なので、結局のところ、彼らをグループ化するのは公正なことなのかもしれない。LLMが非テキストの世界にアクセスできないことで制限を受けていることは、人間が教科書を通してしか物事を学べない場合に制限を受けるのと同じように、私には十分あり得ることだと思う。AGIに到達するためには、多様なタスクで訓練されたマルチモーダルシステムや、他の体制が必要なのである。︎

- もうひとつは、過剰な擬人化に対して反発することである。しかし、人々が擬人化に反発する理由は、LLMが見た目よりも能力が低い、あるいは印象が薄いことを証明するためであることが多いように思う。もう一つの理由は、欠陥のある推論に終止符を打つことである。これは称賛に値する目標だが、その後、同様に欠陥のある推論に後退することによって損なわれる。

- 重要なことだが、それを否定する根拠にはならない。ジャスティン・ワインバーグの言葉を借りれば、「この技術に対する最も愚かな反応は、『意識/思考/知性はないから大したことはない』というようなことを言うことだろう」︎

- 内部計算だけで、原理的に戦略的な認識を持つ計画システムを作り出すことができるのだろうか?LLMが計画を記述するテキストを生成できるのは明らかですが、それを「理解」したり、行動したりすることはできるのだろうか?私はそうは思わない。LLMは受動的で、促されたときだけ何かをするのである。つまり、LLMは出力を生成するときに、ある種の計画や計画実行を内部で行うことができる。トランスフォーマーは、バニラニューラルネットワークのように、推論を行う際に逐次的に計算を行う。Elhage et al. (2021)を参照。”トランスフォーマーの高レベルアーキテクチャの主な特徴の1つは、各層がその結果を「残差ストリーム」と呼ぶものに追加することである。[中略)残差ストリームは深い線形構造を持っている。各層は、任意の線形変換を実行して、最初に残余ストリームから情報を「読み込み」、追加する前に別の任意の線形変換を実行して、その出力を残余ストリームに「書き戻す」のである。”つまり、LLMは、その前の層で(受け取った入力に適した)計画を立て、後の層でその計画を実行することができるようだ。そうすると、原理的には、LLMは(少なくとも初歩的な)計画を立てることができることになる。しかし、今日のLLMでこのようなことが実際に行われているかどうかは、未解決の問題である。︎

- このモデルは足し算を直接学習している。つまり、LLMと同じアーキテクチャを共有しながらも、LLMよりもはるかに限られた種類のデータで、はるかに特殊なタスクのために学習されているのである。LLMがこの足し算モデルと同じように一般的なルールを学習できない理由はないと思うが、特に足し算の一般的なルールを理解するには、もちろんLLMの方がはるかに時間がかかると思う。︎

- 答えを記憶しておけば訓練データでの損失が少ないのに、なぜモデルはより一般的なアルゴリズムに挑戦するのだろうか?結局のところ、学習中にテストデータを見ることはないので、分布外での成績の悪さには気づかないのである。答えは、最近のMLモデルは正則化されており、より一般化できるパターンを学習するように様々な方法で促されている、ということである。Nanda et al. (2023)では、これは主に、モデルが大きな重みを持つことにペナルティを与えることで行われている(これを重み減衰と呼ぶ)。これにより、誤差を少なくするという目標を達成するために小さな重みを使うように動機付けられ、事実上、丸暗記に罰を与えている。私の理解では、少なくともこの実験では、モデルは徐々に重みを下げるのに役立つ小さな一般的なパターンを拾い上げ、例えば、2+7が7+2と等価であることを認識する。これらのパターンは、独立して機能するアルゴリズム全体を形成しているわけではないので、分布外のデータでモデルを助けることはできないが、モデルをより簡略化するのに役立つ。しかし、ある時点で、これらの一般的なパターンが十分にあり、モデルが独立して動作するアルゴリズムに「まとめる」ことができるようになり、(1) 分布外でも分布内と同じように動作し、(2) 学習データに対して(今は不要な)答えを記憶することが迅速にできるようになる。︎

- Jacob Steinhardtは、「Future ML Systems Will Be Qualitatively Different」と「Emergent Deception and Emergent Optimization」でMLの位相変化に関するさらなる例を集めている。︎

- この記事を書いているときに、同じようなテーマでMatthew Barnettの投稿に出会った。彼は、ほぼ同じようなことを主張している。

- ChatGPTは、同じ系統のテストに一部失敗している。”me:この2つの文のそれぞれの「it」は何だろうか?

- 猫が子猫に餌を与えたのは、子猫がお腹を空かせていたからだ。

- 猫が子猫に唸ったのは、怒ったからだ。

CHATGPT: どちらの文でも、「it」は猫を指している。最初の文では、猫が子猫に餌を与えたのは、猫が空腹だったからだ。2つ目の文では、猫が子猫に唸ったのは、猫が怒ったからだ。”

でも、言い方を変えれば、正しく理解できることもある(常にではないが)。

“me:この2つの文のそれぞれの「it」は何だろうか?

- 猫が子猫に餌を与えたのは、子猫がお腹を空かせていたからだ。

- 子猫が猫に唸られたのは、猫が怒っていたからだ。

CHATGPT: 両文とも、「it」はその前にある節の主語を指している。

- 最初の文章で、「それ」は子猫を指しており、子猫はお腹が空いていたので、猫に餌をもらったのである。

- 第2文では、’it’は猫のことで、猫は怒っていたので子猫に唸り声を上げた。”

だから、ChatGPTがこれらの文章の意味を理解していない、あるいは十分に理解していないことを認めてもいいと思う。GPT-4はこのテストに合格すると思うのだが、どうだろう。︎

- 例ランダムに生成された1桁の整数リストをソートする。2年前、janusはGPT-3でこれをテストし、32ショット(!)のプロンプトでも、GPT-3は5個の整数のリストを10/50回、10個の整数のリストを0/50回ソートできることを発見した。(0ショットのPython風プロンプトでは、それぞれ38/50と2/50でもっとうまくいった)。先ほどChatGPTで同じことをテストしたところ、10整数のリストで5/5回正解してくれた。(プロンプトの例”このリストを昇順に並べ替えられるだろうか?[0, 8, 6, 5, 1, 1, 1, 8, 3, 7]”.)そして、5つの10進数のリストを一度にソートするように指示したところ、4/5が正解した。(注:この改良はChatGPTがもたらしたものではなく、ChatGPTの上に構築されているGPT-3の新しいバージョンでもたらされたものだと確信している)