Contents

ヨナス・B・サンドブリンク1*1

1 イギリス、オックスフォード大学、ナフィールド医学部 *

要旨

人工知能(AI)の進歩が生命科学の進歩を推進する一方で、生物製剤の兵器化や悪用を可能にする可能性もある。本稿では、このようなバイオセキュリティリスクをもたらす可能性のある2種類のAIツール、すなわち大規模言語モデル(LLM)と生物学的設計ツール(BDT)を区別する。

GPT-4やその後継のようなLLMは、両用可能な情報を提供する可能性があり、その結果、歴史的な生物兵器への取り組みが直面した障壁を取り除くことができる。LLMがマルチモーダルな実験補助装置や自律的な科学ツールとなるにつれて、専門家でなくても実験室での作業をサポートできるようになる。したがって、LLMは特に、生物学的悪用に対する障壁を低くする可能性がある。

対照的に、BDTは洗練された行為者の能力を拡大する。具体的には、BDTによって、これまでのものよりはるかに壊滅的なパンデミック病原体を作り出すことが可能になるかもしれないし、より予測可能で標的を絞った生物兵器の形態が可能になるかもしれない。

LLMsとBDTsの融合により、生物製剤による被害の上限が引き上げられ、生物製剤が広く利用されるようになる可能性がある。さまざまな介入がリスク管理に役立つであろう。

リリース前の独立した評価は、モデルの能力とセーフガードの有効性を理解するのに役立つだろう。このようなツールへのアクセスを差別化するオプションは、システムを公開することのメリットと慎重に比較検討すべきである。

最後に、リスクを軽減するために不可欠なのは、遺伝子合成産物の普遍的かつ強化されたスクリーニングである。

はじめに

人工知能(AI)は、生命科学と医学の分野で大きな進歩をもたらす可能性を秘めている。しかし、AIがライフサイエンスを加速させる一方で、関連する能力の有害で悪質な応用を可能にする可能性もある。Urbinaらは、AIを活用した創薬ツールが、化学兵器となりうる新種の有毒化学物質の設計図を生成するのに利用できる可能性を示した[1]。同様に、AIは生物学的製剤の兵器化や誤用にも力を与える可能性があり、生物学的製剤は感染する可能性があるため、生物学的製剤によるリスクは化学的製剤を上回る可能性がある。生命科学分野における人工知能の多大な潜在的利益についてはすでに広く議論されているため、本稿では、AIシステムのさまざまな潜在的バイオセキュリティリスクの分類法を作成することに明確に焦点を当てる。議論されているリスクの多くはまだ推測の域を出ないが、そのような潜在的リスクを特定することで、研究者やセキュリティ専門家は、その存在と重大性に関する証拠を収集することができる。

本稿では、異なる方法でバイオセキュリティリスクを悪化させる可能性のある2種類のAI、すなわち大規模言語モデル(LLM)と生物学的設計ツール(BDT)を特に区別する。生物学的設計ツールとは、生物学的データに基づいて学習され、タンパク質やその他の生物学的薬剤の設計に役立つシステムを指す。LLMとBDTは、大きく異なる特性とリスクプロファイルを持つ。

これらのツールが生物兵器の製造を可能にする直接的な方法のほかに、AIシステムは間接的な経路を通じてバイオセキュリティリスクを高める可能性もある。例えば、LLMは誤情報や偽情報の問題を悪化させる可能性があり[2]、生物学的事象の対応や帰属に悪影響を及ぼす可能性がある。さらに、LLMは、病原体サンプルの共有や生物兵器開発のための技術的専門知識の取得のために、科学者を急進的に勧誘したり、強要したり、操ったりするための道具として機能する可能性がある。このようなリスクは、バイオセキュリティーに特有なリスクとは言い難く、今回のテーマではない。

大規模言語モデル(LLM)によるリスク

生物学の悪用を可能にする可能性のあるAIツールの最初の種類は、科学文書や考察・フォーラムなどの大量のテキストを対象に学習させた大規模言語モデル(LLM)である。LLMや関連する「AIアシスタント」は、科学情報を提供したり、関連するオンラインリソースやツールにアクセスしたり、研究を指示したりすることができる。その例として、基礎モデル(GPT-4/ChatGPTなど)、科学的作業を支援するために最適化された言語モデル(BioGPTなど)[3]、他の科学ツールや実験用ロボットと連携するためのLLMベースのアプリケーション[4,5]などがある。基礎モデルは、大規模で高価なトレーニングの成果であり、現在、少数の企業によって開発されているが、これらのシステムは、よりリソースに制約のあるグループによって最適化され、特定のドメイン用のアプリケーションにすることができる[4,5]。

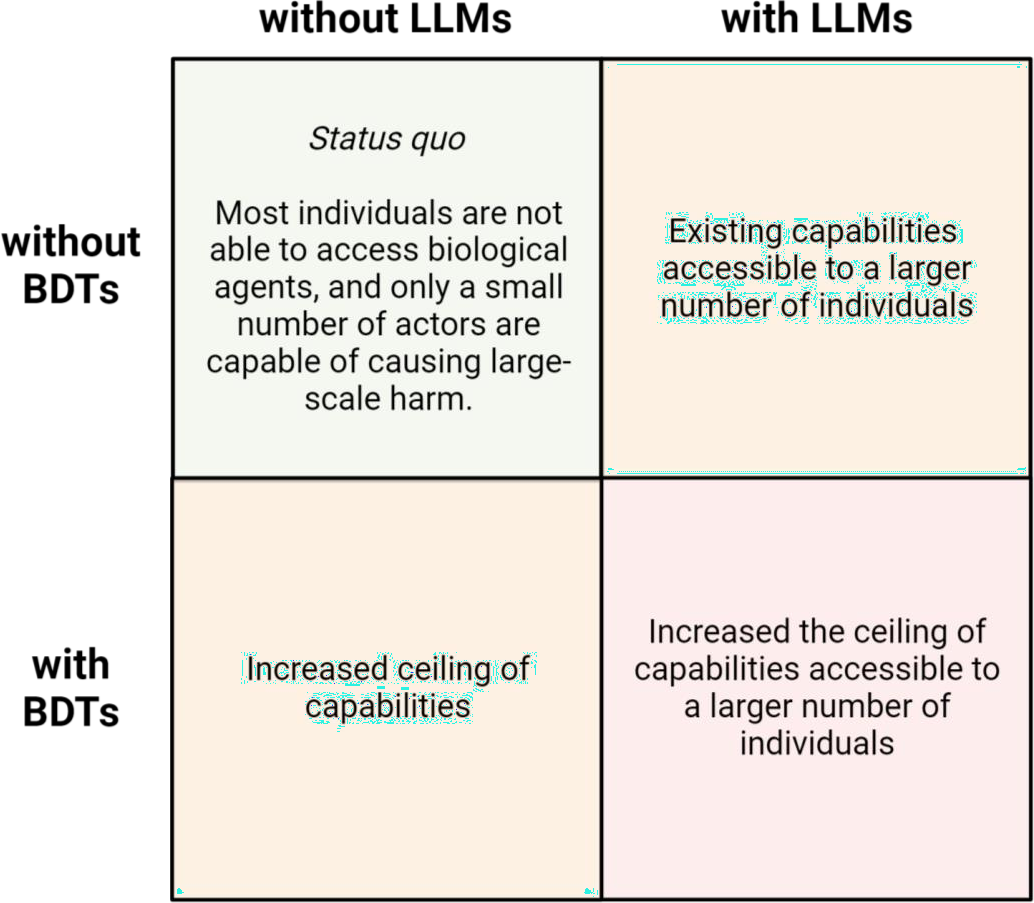

LLMは、いくつかの点で生物学的誤用のリスクに影響を与える可能性がある。重要なテーマは、LLMによって既存の知識や能力へのアクセスが向上し、生物学的悪用への障壁が低くなる可能性があるということである(図1b参照)。

図1:LLMとBDTが生物学的悪用の能力に及ぼしうる影響人工知能ツールが、生物学を悪用する可能性のある行為者全体の能力にどのような影響を及ぼしうるかを、セーフガードを導入しない場合の図式で示したもの。LLMは大規模言語モデル、BDTは生物学的設計ツールである。

1. デュアルユースのトピックを教える

第一に、LLMは、合法的な研究への情報提供に利用されるだけでなく、危害をもたらす可能性もある「二重利用」の知識について、効率的な学習を可能にする可能性がある。現在のLLMが、インターネット検索エンジンよりも、デュアル・ユース・トピックの教育において優れているかどうかは、まだ未解決の問題であるが、LLMは、現在あるいは将来のシステムがこのような可能性を持つことを意味する特性を備えている。インターネット検索エンジンとは対照的に、LLMは多くの異なる情報源にまたがる知識を統合し、複雑な情報を専門家でなくてもアクセスできるようにし、専門家でなくても利用できるようにし、利用者が問い合わせることを知らなかった変数を積極的に指摘することができる。生物兵器を可能にする情報がこのように提示されれば、小規模な生物兵器の取り組みが、重要なボトルネックを克服できるようになるかもしれない。例えば、日本の終末教団オウム真理教が生物兵器の開発に失敗した一因として、ウイルス学の博士号を持つ主任科学者の遠藤精一郎が、ボツリヌス菌とそれが産生する致死的なボツリヌス毒素の違いを理解できなかったという仮説がある[6]。2023年6月の試験時点で、ChatGPTは細胞からの毒素含有上清の「採取と分離」の重要性と、濃縮、精製、製剤化のさらなるステップを容易に概説している。オウムが生物兵器の製造に失敗した理由は他にもあるが[7]、この例は、チャットボットが潜在的なバイオテロリストに役立つ情報を提供できることを示している。同様に、LLMは、食品製造を専門とする微生物学者であるアルカイダのリード・サイエンティスト、ラウフ・アーメドに、炭疽菌やその他の有望な生物兵器剤について学ぶ手助けをしたかもしれないし、イラクの生物兵器研究者に、液体炭疽菌をより危険な粉末状にする方法を教えることもできたかもしれない[6,8]。現在のLLMは、偽の、あるいはでっち上げの情報という形の「幻覚」を作り出すことがあり、潜在的な悪意ある行為者を苛立たせたり、誤解させたりすることがある。しかし、モデル開発者がますます最適化されたシステムを開発するにつれて、このような幻覚は消えていくであろう。

2. 生物学的悪用への道を特定する

第二に、LLMは、生物学的製剤をどのように入手し、改変し、普及させるかについて、アイデアや計画を練るのに役立つ可能性がある。すでにLLMは、生物製剤を不正に入手するために既存のサプライチェーンがどのように悪用されうるかを特定することができる。最近行われた1時間の実習では、LLMは、科学者でない学生が、4種類のパンデミック病原体の可能性とその合成方法、顧客や注文を選別することなく合成DNAを供給する企業、関連する実験室業務を請負業者に依頼する可能性などを特定できるようにした[9]。しかし、この実験は、インターネット上で同じ情報を見つけようとするグループとコントロールされていなかった。現在のLLMが、現状と比較してどの程度のアップリフトを提供しているかについては、より注意深くコントロールされた研究が、より多くの光を当てるかもしれない[10]。しかし、長期的には、LLMは、特定の病態を引き起こすにはどのような分子標的が最も適しているかなど、特定の目標に合わせた生物学的製剤の設計方法のアイデアを生み出す可能性もある。

3. ステップバイステップの指示とトラブルシューティング実験

さらに、LLMは、実験のステップバイステップの指示や、トラブルシューティング実験の指導を行うことができる、非常に効果的な実験助手となる可能性がある。このために特に重要なのは、マルチモーダルモデルの出現である。マルチモーダルモデルは、個人化された文書による指示を与えることができるだけでなく、画像やビデオを生成することもできるようになるだろう。このようなAIラボアシスタントは、経験の浅い研究者を助けたり、出版物の実験方法を再現したりするために、多くの有益な応用が期待される。しかし、このようなAI実験支援者は、悪意のある目的で実験室作業を支援することもあるかもしれない。例えば、オウム真理教が炭疽菌の兵器化に失敗した主な理由は、遠藤誠一がプラスミド挿入の関連プロトコルにアクセスしたにもかかわらず、炭疽菌の良性ワクチン株を病原体に変えることに成功しなかったからである。遠藤は、オーダーメイドの指示を出し、トラブルシューティングを助けてくれるAIの実験室アシスタントがいれば成功したかもしれない。未解決の重要な問題の1つは、「暗黙知」、つまり一般的に文書化されていなかったり、簡単に言葉にできなかったりする知識によって形成される障壁である[11]。暗黙知のさまざまなカテゴリーが定義されており、[12]、AIラボアシスタントによってさまざまな程度で影響を受ける可能性がある。ピペットの使い方のマッスルメモリーのような 「身体的」暗黙知は、AI実験補助者によってほとんど手つかずのまま残るかもしれない。対照的に、文書化されていないが言葉にすることができる実験プロトコルの微調整のような 「弱い」暗黙知や、異なる専門分野の多くの知識の合流から生まれる。「共同的」暗黙知は、オーダーメイドの実験指示を提供するために最適化され、多くの異なる分野の知識を利用できるAI実験補助者によって低下する可能性がある。最後に、AI実験アシスタントが、実験室での偉業がより達成可能であるという認識を生み出せば、より多くのグループや個人が挑戦するかもしれない。

4. 自律的科学能力

長期的には、LLMや関連するAIツールが、人間の介入を最小限に抑えて科学的作業を行う能力を向上させれば、生物兵器に関連する障壁が取り除かれる可能性がある。第一に、LLMは自然言語コマンドに基づいて実験用ロボットに指示を与えることができる。実験用ロボットがより進化すれば、人間が行う実験作業の必要性が減り、「身体的」暗黙知の障壁が取り除かれるかもしれない。第二に、LLMは自律的な科学エージェントの基礎として機能し、タスクを管理可能な断片に分割し、関連する特殊な計算ツールとインターフェースを取り、実験用ロボットに指示を与えることができる[5]。秘密裏に大規模なチームを調整するという課題は、ソビエトやイラクの生物兵器開発計画を制限した。自律的な科学能力によって個人や小規模なグループが大規模な科学的作業を達成できるようになれば、秘密裏に行われる生物兵器プログラムに力を与える可能性が高い。

生物学的設計ツール(BDT)によるリスク

悪用のリスクをもたらす可能性のあるAIツールの2つ目の種類は、生物学的設計ツール(BDT)である。これらのBDTは生物学的データに基づいて訓練され、新しいタンパク質やその他の生物学的薬剤の設計を支援することができる。BDTの他にも、さまざまなAI対応生物学的ツールがある[14]。BDTの例としては、RFDiffusionや、ProGen2やAnkhのようなタンパク質言語モデルがある[15-17]。将来的には、生物学的データに基づいて微調整されたLLMが、最も強力なBDTになる可能性がある。現在、BDTは、アカデミア(RFDiffusion)か産業界(ProGen2、Ankh)かに関係なく、頻繁にオープンソース化されている。例えば、免疫回避のような特性を予測することで宿主と病原体の相互作用に光を当てるツール[18]や、ヒトゲノムの機能的理解を進めるツール[19]などである。現時点では、生物学的設計ツールは、比較的単純な単一機能を持つタンパク質の作成に限られている。しかし、いずれは、様々な機能を最適化したタンパク質や酵素、さらには生物全体を設計できるようになるだろう。

BDTが生物学的悪用のリスクに影響を与える可能性がある主な方法は3つある。特に生物兵器へのアクセス性を高める可能性のあるLLMとは対照的に、BDTは能力の上限を高め、その結果、生物兵器がもたらす危害の上限を高める可能性がある(図1c参照)。しかし、BDTが将来、特に実験室での検証を必要としないゼロ・ショット設計を生み出すことになれば、悪用に対する障壁も低くなる可能性があることは注目に値する。

1. 洗練されたグループと増大する最悪のシナリオのリスク

第一に、生物学的設計ツールが生物学的設計を進歩させるにつれて、生物学的誤用が引き起こしうる危害の上限が増大する可能性が高い。進化的な理由から、自然に出現する病原体は、伝播性と病原性の間にトレードオフの関係があると仮定されている。[20]。BDTは、このトレードオフを克服し、これらの特性の両方に最適化された病原体の創出を可能にするかもしれない。このような病原体は、オウム真理教のようなグループによって、偶発的あるいは意図的に放出される可能性がある。このような病原体を用いたバイオテロは、可能性の低いシナリオである。というのも、そのような動機を持つ人はほとんどおらず、AIツールを用いたとしても、最適化された病原体を設計するには、かなりのスキル、時間、資源が必要になるからである。しかし、大規模な言語モデルやその他のAI実験支援ツールが進歩すれば、BDTを使用する上でのこうした障壁は減少するだろう。したがって、人類は、存亡の危機をもたらす可能性のある病原体を含め、自然が作り出す病原体よりもはるかに悪い病原体の脅威に直面するかもしれない。

2. 国家権力者と新たな能力

第二に、生物学的設計ツールは、国家行為者にとって生物兵器をより魅力的なものにする形で、生物工学的能力を高める重要な一因となる可能性がある。米国は、1960年代に開発された生物兵器を、その保存期間の短さと友軍に危害を加える危険性から、戦争計画に組み入れることはなかった。[6]。イラクが生物兵器を配備しなかったのは、その有効性に確信が持てず、報復措置を恐れたからであろう。AIツールが生物学的設計の限界を押し上げ、生物製剤をより予測しやすく、特定の地理的地域や集団に照準を合わせやすくすれば、生物兵器の魅力が増す可能性がある。

3. シーケンスに基づくバイオセキュリティ対策の回避

近い将来、生物学的設計ツールは、危険な病原体へのアクセスを制御する既存の対策に挑戦することになるだろう。その例として、輸出規制のための分類学に基づくオーストラリア・グループ・リストや、合成DNA製品の遺伝子配列に基づくスクリーニングが挙げられる。BDTによって、既知の毒素や病原体の機能や塩基配列に類似しない、潜在的に有害な薬剤の設計が容易になる可能性が高い。さらに、ProteinMPNN [21]のような現在あるいは近い将来に開発される逆フォールディングツールを使えば、既知の毒素の構造を、大幅に異なる遺伝子配列に「再コード化」することがすでに可能かもしれない。このようにして再コード化された構造の本来の機能を保持することがどれほど難しいかはまだ不明である。ポリオウイルスにおける同義コドンの変化がウイルス機能の喪失につながることが示唆されたように、おそらく結果を予測することは困難であろう[22]。AIがバイオデザイン能力を高めるにつれ、分類学や配列類似性に基づく管理では、AIを活用したバイオデザインの時代に有害な生物学的製剤への不正アクセスを防止するには不十分となる。

リスク軽減のための留意点

LLMとBDTの潜在的なバイオセキュリティリスクの特徴を明らかにすることは、そのようなリスクの調査に役立ち、ガードレールの先制的な探索のきっかけとなる。現在までのところ、記述されたリスクはまだ推測の域を出ていない。LLMがすでに生物兵器に対する障壁を低くしているのかどうか、また、こうしたリスクが将来どのように進化するのかを明らかにするためには、確固たる証拠を収集する必要がある。このような証拠を収集するために特に重要なのは、インターネットを使用する場合と比較して、AIシステムがどの程度の向上をもたらすことができるかを評価するために慎重に設計された研究である。さらに、モデル開発者と政策立案者は、将来のリスクを軽減するために、どのようなガードレールが適切かを事前に検討すべきである。特に、AIの能力は非常に速く、予測不可能に進歩する可能性があるため、これは重要かもしれない[23]。LLMがBDTとどのように相互作用し、高度な生物学的設計能力をより利用しやすくするかが、今後の重要な課題である(図1d参照)。考えられるメカニズムとしては、LLMがBDTを使用するための自然言語インタフェースを提供すること、AIラボアシスタントが生物学的デザインを物理的エージェントに変換することを支援すること、あるいは最終的にLLMが生物学的デザインにおいて専門ツールよりも強力になることなどが挙げられる。

放出前モデル評価により、リスクと保障措置の有効性を評価することができる

最先端のAIシステムのリスクを評価し、軽減するためには、リリース前とリリース後のモデル評価が重要になる可能性がある。[24]. OpenAIは、GPT-4のリリース前に、このようなリリース前モデル評価のプロトタイプ版を実施した[25]。理想的には、リリース前のモデル評価には、外部からの独立した基礎モデルの監査が含まれる。これには、専門家によるレッド・チー ムのほか、生物学的攻撃の計画や実行を支援する能力など、モデルのリスクと安全策を評価するためのより構造化されたテストの両方が含まれる可能性がある。これによって開発者は、訓練や配備を通じて、有害なモデル動作を除去する動機付けを得ることができる。リリース前のモデル評価には、様々な足場、ツール、モデルの微調整が必要であり、システムの修正がどのように新たな能力をもたらすかを評価する必要がある。

無制限アクセスとセキュリティのトレードオフを慎重に検討する

AIシステムが悪用される可能性があることから、オープンサイエンスとセキュリティーをどのようにトレードオフするかという難しい問題が提起される。[26]。重みの公表を含むモデルのオープンな公表は、一般に、さらなる進歩のための摩擦を最小にし、場合によっては、リスクの理解を深めるのに役立つ。同時に、モデルの重みが公表されると、モデル開発者が実施したあらゆる安全策が取り除かれ、有害なバージョンのモデルが流通する可能性がある[27]。モデル開発者と政策立案者は、モデルを公開するメリットがそのリスクを上回る場合を理解するための証拠を収集し、ツールを開発する必要がある。モデルを公開しない場合、モデルへのアクセス権を誰に与えるかを決定する際にも、同様の問題に対処する必要がある。一方では、特定の関係者に特定のAI能力への独占的なアクセスを与えることは、社会的不平等を悪化させ、硬化させる可能性がある。同時に、パンデミックに対応できるウイルスの作成方法を専門家でない人々に教えることができるAIシステムへの無差別なアクセスは、重大なリスクをもたらす可能性がある。ますます強力になる実験アシスタントやBDTが、何らかのユーザー認証を伴うべきかどうかについては、多様な利害関係者を巻き込んだ議論が必要である。

遺伝子合成スクリーニングの義務化

LLMやBDTによるリスクを軽減するためには、さまざまな介入が有効であろう[28]。LLMやBDTによるリスクの増大を緩和するための特に効果的な方法の一つは、デジタルから物理的なものへの境界におけるバイオセキュリティ対策を強化することであろう。合成DNAへのアクセスは、あらゆる生物学的設計を物理的作用物質に変換するために不可欠である。業界のリーダーたちは、すでに自主的に遺伝子合成オーダーのスクリーニングを行っており、規制のベースラインを要求している。[29]。遺伝子合成注文やその他の合成生物学的サービスのスクリーニングのためのこのような義務的なベースラインは、生物製剤への不正アクセスを防止するための非常に効果的な対策となるであろう。AIに関する2023年の米国大統領令は、連邦政府が資金を提供する研究に対して、スクリーニングされたDNAの使用を義務化することで、そのようなベースライン構築への第一歩を踏み出している。[30]。同時に、生物学的設計の進歩に合わせて、スクリーニング・ツールも改善する必要がある。例えば、将来の合成スクリーニングツールでは、タンパク質の構造を予測し、既知の有害物質の構造と比較することが重要になる。そのためには、AI開発者、バイオセキュリティの専門家、合成製品を提供する企業が協力して、適切なスクリーニング・ツールを開発することができるだろう。

結論

人工知能の進歩がバイオセキュリティ・リスクをどのように、またどの程度悪化させるかは、まだ定かではない。しかし、AIの能力が急速に進歩する可能性を考えれば、リスクを評価し軽減するための対策を採用することは賢明である。AIによるリスクを効果的に軽減することができれば、AIが生命科学と人間の健康にとって非常に有益な意味を持つようになるための下地が整うことになる。

謝辞

Markus Anderljung、Anemone Franz、Nicole Wheeler、その他、原稿に対するコメントと有益な議論をいただいた。本稿はあくまでも筆者の意見であり、筆者が所属するいかなる組織の意見でもない。筆者の博士課程研究は、オープン・フィランソロピーから資金提供を受けている。

Artificial intelligence and biological misuse: Differentiating risks of language models and biological design tools