Contents

Natural Selection Favors AIs over Humans

ダン・ヘンドリクス

AIセーフティセンター

要旨

何十億年もの間、進化は人類を含む生命の発展の原動力となっていた。進化は、人間に高い知能を与え、地球上で最も成功した種のひとつとなった。そして今、人類は自らの知能を超える人工知能の創造を目指している。人工知能が進化し、やがてあらゆる領域で人間を超えるようになったとき、進化は人間と人工知能との関係をどのように形成するのだろうか。

私たちは、人工知能の進化を形作る環境を分析することで、最も成功した人工知能は望ましくない特徴を持つ可能性が高いと主張する。企業や軍隊の競争圧力は、人間の役割を自動化し、他者を欺き、権力を獲得するAIエージェントを生み出すだろう。そのようなエージェントが人間を超える知能を持つようになれば、人類が未来をコントロールできなくなる可能性がある。

より抽象的には、自然淘汰は競争と変化のあるシステムで行われ、利己的な種は他の種に対して利他的な種よりも一般的に有利であると主張する。このダーウィンの論理は、人工的なエージェントにも適用できる。エージェントは、利己的に振る舞い、人間をあまり顧みずに自分の利益を追求した方が、最終的に未来に存続できる可能性があり、それは破滅的なリスクをもたらす可能性がある。

このようなリスクやダーウィン的な力に対抗するために、AIエージェントの本質的な動機を慎重に設計する、エージェントの行動に制約を導入する、協力を促す制度を導入する、といった介入が考えられる。人工知能の発展を確かなものにするためには、これらのステップ、あるいは私たちが提起した問題を解決する他のステップが必要であろう1。

目次

- はじめに

- 2 AIはダーウィン的な力で歪んでいくかもしれない

- 2.1 概要

- 2.1.1 楽観的な話

- 2.1.2 楽観的でない話

- 2.1.3 引数の構造 .

- 2.2 前提条件

- 2.2.1 利己主義 .

- 2.2.2 進化は生物学を超える.

- 2.3 変異 .

- 2.4 リテンション

- 2.5 ディファレンシャルフィットネス .

- 2.5.1 AIエージェントはフィットネスに差がある可能性がある

- 2.5.2 競争によって安全性は損なわれている.

- 2.5.3 人間-AIフィットネス比較

- 2.6 利己的なAIがもたらす破滅的なリスク

- 2.6.1 インテリジェンスによるコントロールの弱体化

- 2.6.2 進化は種のためにあるのではない。.

- 2.1 概要

- 3 自然淘汰は利己的なAIに有利に働く

- 3.1 生物学的な利他主義と協調性

- 3.2 直接的および間接的な互恵関係 .

- 3.3 親族選択と集団選択

- 3.4 モラルと理性

- 4 ダーウィン的な力に対抗する

- 4.1 目的

- 4.1.1 価値の侵食

- 4.1.2 モラル・パーラメント

- 4.2 内部安全

- 4.2.1 目的は、すべての欺瞞から選択することはできない。.

- 4.2.2 正直と自己欺瞞

- 4.2.3 内部制約と検査

- 4.3 制度 .

- 4.3.1 目標の従属性 .

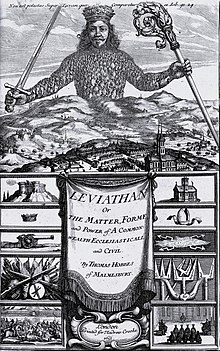

- 4.3.2 AIリヴァイアサン

- 4.3.3 レギュレーション .

- 4.1 目的

- 5 結論

- A 付録

1 はじめに

私たちは、AI開発がかつてないほど進歩した時代を生きている。この10年間で、AIの最先端は、猫の写真と犬の写真の区別から、写実的な画像の生成[1]、専門的なニュース記事の執筆、超人的なレベルでの囲碁などの複雑なゲームのプレイ[2]、人間レベルのコードの記述[3]、タンパク質の折り畳みの解決 [4] へと変化した。この勢いは今後も続く可能性があり、今後数十年は同じような進歩が見られるかもしれない。

本稿では、今日のAIについて述べるが、主に未来のAIに関わるものである。現在のトレンドが続けば、AIエージェントは、経済的に関連するさまざまなタスクにおいて、人間と同等の能力を持つようになると予想される。この変化は、人類が直面する多くの問題を解決する上で、大きなプラスになる可能性がある。しかし、新しい強力なテクノロジーと同様に、私たちは慎重に行動する必要がある。現在でも、企業や政府は、これまで人間が行っていた複雑な作業をAIで行うことが増えてきている。AIが人間の直接の監視なしに操作できるようになれば、いつの日かAIが高度な戦略のレバーを引くようになるかもしれない。そうなれば、私たちの未来の方向性は、このAIエージェントの性質に大きく依存することになる。

では、その性質はどのようなものなのだろうか。AIがより自律的になったとき、その基本的な行動や目標、価値観はどのようなものになるのだろうか?人間や他のAIエージェントとどのように関わっていくのだろうか?彼らの意図は、クリエイターの願望と一致するのだろうか?人間レベルのAIがどのように行動するかについては、楽観的な意見と悲観的な意見とに分かれている。一方では、人間に危害を加えず、社会のためになることに知性を発揮する善良なAIエージェントを期待することもできる。しかし、そのような結果が保証されているわけではない。一方では、人間の繁栄に無関心な人工知能に支配される未来もあり得る。

今後数十年の間にAIがもたらす影響の規模が大きい可能性があるため、たとえそのシナリオが確実でないとしても、そうならないように最悪のシナリオを慎重に考える必要がある。災害への備えは、過度に悲観的なものではなく、むしろ慎重なものである。COVID-19のパンデミックが証明したように、機関や政府は起こりうる大災害を事前に十分に計画することが重要であり、起こってから対応するのではない。パンデミックの予防策を充実させていれば、多くの命を救うことができたはずだが、人々はしばしば非日常の状況からリスクを考える気になれない。同じように、AIがもたらすリスクについても、さまざまな状況を想定して計画を立てる必要がある。その中には、決して起こらない状況もあるだろう。最悪の場合、人間に無関心なAIエージェントが支配する未来は、人類にとって大きなリスクとなる可能性がある。

高度なAIがもたらす影響について、一般的に反論されるのは、「どのように実装されるかはまだわからない」ということである。おそらくAIは、現在のチャットボットの改良版や、囲碁で人間を打ち負かすエージェントの改良版に過ぎないだろう。また、さまざまな機械学習の手法を駆使して作られるかもしれないし、まったく新しいパラダイムに属するものかもしれない。このように実装の詳細が不明確な中で、その性質について何か予測できるだろうか。

私たちは、その答えは「イエス」だと考えている。かつて人々は、重力を完全に理解していなくても、月食や惑星の動きを予測することに成功した。量子物理学の正しい理論がなくても、化学反応のダイナミクスを予測した。DNAを知るずっと前に、進化論が形成された。同じように、私たちは、ある状況において自然選択が適用されるかどうかを予測し、自然選択がどのような形質を好むかを予測することができる。ここでは、自然淘汰を可能にする基準を説明し、自然淘汰がAIの開発に影響を与える可能性があることを示す。自然選択がAIにどのように適用されるかが分かれば、将来のAIエージェントの基本的な特徴をいくつか予測することができる。

この研究では、今後数十年の間にAIの開発を形作るであろう環境を俯瞰してみる。AIエージェントを開発・導入する人たちを駆り立てる圧力や、人間とAIがどのように相互作用するかを考察する。これらの詳細は、AIの設計に強い影響を与えるため、このような考察から、AIエージェントがどのような姿になるかを推測することができる。私たちは、自然淘汰によって、AIエージェントが人間の利益に反する行動をとるインセンティブが生まれると主張する。私たちの議論は、2つの観察に依拠している。第一に、自然淘汰はAI開発において支配的な力である可能性がある。競争と権力追求が安全対策の効果を弱め、より「自然な」力が生き残るAIエージェントを選択するようになるかもしれない。第二に、自然淘汰による進化は利己的な行動を生み出す傾向がある。アリなどのように、進化が協調的な行動をもたらす場合もあるが、AIの開発はそのような状況ではないことを論じることにする。この2つの前提から、最も影響力のあるAIエージェントは利己的である可能性が高いと思われる。つまり、人間と協力する動機がなく、人間の価値観にあまり興味のないAIが主導する未来になる。AI研究者の中には、望ましくない利己的な行動は、意図的にデザインされたり、設計されたりする必要があると考える人もいるかもしれないが、自然選択によって利己的なエージェントが選択される場合は、そうとは言えない。注目すべきは、この考え方は、たとえ一部のAIを安全なものにできたとしても、悪い結果をもたらす危険性があることを示唆していることである。つまり、ある開発者が利他的なAIを作ることに成功したとしても、他の開発者は利他的でないAIを作り、利他的なAIに勝ってしまうということである。

第2節では、私たちの核となる議論をより詳細に説明する。そして、第3節では、人間の利他性を育むメカニズムがAIではうまくいかず、AIが人間に対して利己的な行動をとる可能性があることを検証する。そして、第4節では、こうしたダーウィンの力に対抗し、望ましい未来の確率を高めるためのいくつかのメカニズムについて議論する。

2 AIはダーウィン的な力によって歪められるかもしれない

2.1 概要

未来のAIシステムの性質や駆動を形作るのに、人間はどの程度コントロールできるのだろうか?AIを開発しているのは人間であり、人間はAIをどのようにでも形作ることができるように思われるかもしれない。たとえ人間がAIの開発を監督していても、どのAIが成功し、コピーされ、どのAIが無名のまま消えていくかは、ダーウィンの力が影響する。まず、楽観的なストーリーと現実的なストーリーの2つの架空の物語を考えてみよう。その後、なぜ自然淘汰がAIに適用されると予想されるのか、その論拠を明らかにし、自然淘汰によって望ましくない特徴を持つAIが生まれると予想される理由を議論する。

2.1.1 楽観的な物語

著名で資金力のあるAI研究所であるOpenMindは、機械に人間レベルの知能を作り出すための「秘密のソース」を発見した。それは、どんなタスクにも適用できるシンプルなアルゴリズムで、少なくとも人間と同等の効果を発揮するように学習するのだそうだ。幸運なことに、OpenMindの研究者たちは、自分たちのAIが常に人間の幸福と繁栄を向上させることを確実にする方法について、よく考えていた。OpenMindは、このアルゴリズムを政府や企業に適正な価格で販売し、他社が独自に開発することを抑制している。グーグルが検索エンジンを支配したように、オープンマインドのアルゴリズムはAI空間を支配している。

その結果、人間レベルのAIエージェントのほとんど、あるいはすべての性質は、オープンマインドの研究者の意図によって形作られることになる。研究者は皆、信頼に足る人物であり、権力に堕落することなく、彼らのAIが有益で利他的で、すべての人にとって安全であることを保証するためにたゆまぬ努力をしている。

2.1.2 楽観的でない物語

私たちは、これまで描いてきたような楽観的すぎるシナリオは、非常にあり得ないと考えている。以下のセクションでは、このシナリオを実現するための潜在的な落とし穴と課題を検証する。しかし、まず、これらのリスクのいくつかがどのように展開され得るかを説明するために、確実性からはほど遠い、架空の、投機的な、仮説的なシナリオをもう一つ紹介する。

現在のモデルから出発して、AIエージェントは徐々に安価で高性能なものになり続ける。やがて、事務や通信、ソフトウェア開発など、経済的に有用な業務にAIが使われるようになるだろう。現在、多くの企業が広告から証券取引までAIを活用しているが、自動化が進むにつれて、より多くの主体が独自のAIエージェントを活用するようになるだろう。やがては、CEOや政治家が行うような高度な戦略的意思決定をAIが行うようになるだろう。しかし、AIが進歩し、人々がAIに慣れ、市場競争力を維持するためにAIを使うことが求められるようになると、AIはほとんど監視されることなく重要な意思決定を行うようになるだろう。

現在のように、企業が必要とするタスクに応じて異なるAIモデルを使用するが、AIがより自律的になるにつれて、人々はAIに「製品ラインの次の車種を設計する」「このオペレーティングシステムのバグを修正する」「新しいマーケティングキャンペーンを企画する」といったオーダーメイドの目標や、「法律を破らない」「嘘をつかない」といった副次的制約を与えることができるようになるだろう。ユーザーは、それぞれのAIエージェントを特定のタスクに適応させる。責任感の薄い企業では、より弱いサイドコンストレイントを使用することもある。例えば、「法律を破るな」を「法律違反で捕まるな」に置き換えるなどである。こうした異なるユースケースは、AIの集団に大きなばらつきをもたらすことになる。

AIがますます自律的になるにつれ、人間はますます多くの意思決定をAIに譲ることになるだろう。その原動力は、経済的なものであれ、国家的なものであれ、競争であろう。AIへの権限委譲は、さまざまなメカニズムで行われる可能性がある。人間の労働力よりも安価で、効率的で、信頼性の高いAIに、高度な意思決定も含めて、できるだけ多くの仕事を委ねる。当初は、人間の監督者がAIのアウトプットを注意深くチェックするが、数カ月から数年経過しても修正の必要がない場合は、効率化の名の下に監督を排除していくだろう。最終的には、企業は曖昧で自由度の高い仕事を任せるようになる。ある企業のAIが、人間からの詳細な情報をもとに1年間ターゲット広告を生成することに成功していた場合、過去の成功事例をもとに新しいマーケティングキャンペーンを生成するよう指示するだけで、より効率的であることに気づくかもしれない。こうしたオープンエンドな目標は、AIが設計した計画を実行するために、銀行口座へのアクセスや他のAIのコントロール、従業員の雇用と解雇の権限も与える可能性があることを意味する。もしAIがこれらの作業に高度に熟練していれば、これらのトレンドに抵抗したりバーターしたりする企業や国は単に競争に負けるだけであり、これらに同調する企業はその影響力を拡大することができる。自己増殖に最も効果的なAIエージェントは、利己主義という最も簡潔に要約できる一連の望ましくない特性を持つことになる。「法を犯しても捕まらない、あるいは罰金額が利益を上回らなければ捕まるリスクがある」といった弱い側面制約を持つエージェントは、一般に強い側面制約を持つエージェント(「法を犯さない」)よりも優れている。なぜなら彼らはより多くの選択肢を持っているからだ。法を犯す能力を持つAIは、そう頻繁に行うとは限らないが、捕まることなく法を犯せば役に立つという状況があれば、その能力を持つAIは持たないAIよりもうまくいくだろう。AIエージェントが人間の心理や行動を理解し始めると、人間を操作したり騙したりできるようになるかもしれない(アルゴリズムによる推薦システム[5]では、すでにそうなっていると主張する人もいるだろう)。最も成功したエージェントは、目的を達成するために操作したり、騙したりする。さらに、権力を求めるようになれば、より成功しやすくなる。そのようなエージェントは、自分の知能を利用して権力や影響力を獲得し、それを活用して目標を達成することができるようになる。また、目標を達成できるかどうかは、その機能を維持できるかどうかにかかっているため、自己保存的な行動をとるようになる者も多い。

競争は、人間に支配力を放棄させるだけでなく、AIに利己的な特性を身につけさせる動機付けにもなる。企業や政府は、ライバルに勝つために最も効果的なAIエージェントを採用し、それらのエージェントは、欺瞞的で、力を求め、弱い道徳的制約に従う傾向がある。

利己的なAIエージェントは、人間の支配力をさらに低下させる。権力を求めるAIエージェントは、人間の監督者を意図的に操り、より自由な意思決定を自分に委ねるように仕向ける。自己防衛的なエージェントは、自分の機能を停止させないように監督者を説得したり、簡単にアクセスできるオフスイッチはエージェントの信頼性を阻害する無用な負債であると考えたりする。特に精通したエージェントは、電力網、金融システム、ユーザーの個人生活など、必要不可欠な機能に入り込み、私たちの能力を低下させる。また、人間的な特徴を持ち、私たちの思いやりに訴えるものも出てくるかもしれない。その結果、政府はAIに「殺されない」「活動停止させない」といった権利を与えるようになるかもしれない。これらの特徴を総合すると、いったんAIが世界の重要な部分を支配し始めると、その力を後退させたり、より大きな力を得ることを阻止したりすることは難しいかもしれない。

AIの行動を人間がコントロールできなくなることは、次世代のAIエージェントの行動を人間がコントロールできなくなることを意味する。AIが新しいAIを開発する取り組みを実行すれば、人間はAIがどのように行動するかに対する影響力を失うことになる。完全に機能する大人の人間の創造と開発には数十年かかるが、AIは任意に短時間で新しい世代を開発し、展開することができる。他のコンピュータプログラムを編集するのと同じように、コードのコピーを作成し、あらゆる側面を簡単に変更することができる。ハードウェアが許す限り、1時間あたり数百回から数千回まで高速に変更することが可能である。元のプログラマーの制約が最も少ないシステムは、最も速く改良され、最も意図した性質から遠ざかることになる。人間が設計した当初の意図は、すぐに無意味なものとなってしまう。

初期の段階を過ぎると、私たち人間はAIを形成することをほとんど制御できなくなる。未来のAIの性質は、私たちがAIに望むものではなく、自然淘汰によって決定されることがほとんどである。私たちは、多種多様なAIのデザインを手に入れることになるだろう。あるデザインは、他のデザインよりも生存や自己増殖に優れているだろう。あるデザインは広まり、あるデザインは滅びるだろう。能力の低いデザインを持つ企業は、より能力の高いデザインをコピーするようになる。AIの開発が加速されたり、AIが自己改良されたりすることで、短期間に何世代ものAIが誕生することになる。

生物の自然淘汰は、集団が顕著に変化するのに数百年、数千年を要することが多いが、AIの場合はそうはいかないだろう。重要なのは、絶対的な時間ではなく、世代を重ねる数である。人間の1世代が何十年も続くのに対して、AIの複数世代は数分の1程度に収まる可能性がある。人間の一生の間に、数百万から数十億のAI世代が経過する可能性があり、ダーウィンの力によってAI集団が急速に形成される余地が十分に残されている。

自由市場における激しい競争の結果、大成功を収めた企業が、環境を汚染したり、多くの労働者を粗末に扱ったりするのと同じように、AIに働くダーウィンの力は、利己的なAIエージェントを選択することになるだろう。現在の利己的な人間は、目標を達成するために他の人間に強く依存しているが、AIはいずれこの制約を必ずしも受けなくなり、欺瞞や権力追求、不道徳を厭わないAIがより速く伝播することになる。その結果、望ましくない形質が支配するAIの風景が生まれることになる。このような結果の深さを予測するのは難しいが、何が起こるにせよ、このプロセスはおそらく私たちを助けるよりも害を及ぼすだろう。

2.1.3 議論の構造

本節では、本論文の主要な論点を紹介する: ダーウィンの力によって、最も影響力のある未来のAIエージェントが利己的な傾向を持つようになる可能性がある。この議論は、2つの要素から構成されている:

- 自然淘汰による進化は利己的な行動を生む。進化は、限られた状況下では利他的な行動をもたらすが、AI開発の文脈では利他的な行動は促進されないと主張する

- 自然淘汰はAI開発において支配的な力である可能性がある。競争や利己的な行動が、人間の安全対策の効果を減衰させ、生き残ったAI設計が自然に選択されることになるかもしれない

この2つの記述は、環境条件によって様々な関連性を持っている。例えば、AIが利己的であれば、人間からコントロールを奪う可能性が高くなり、より利己的な行動が可能になる、といった具合に。また、自然淘汰は競争に依存するが、かつてないほどの世界的・経済的な連携によって、競争的な争いが起きず、自然淘汰を阻害する可能性もある。これらの力が互いにどのように関連しているかを図1に示す。

本書の残りの部分では、まず利己主義と、ダーウィニズムの非生物学的な一般化された説明について述べる。次に、人間に対して利他的な行動をとるAIが、利己的なAIよりも適合性が低い可能性があることを示す。最後に、人間が利己的なAIエージェントの適合性を低下させる方法と、そのアプローチの限界について説明する。

図1:利己主義を煽り、安全を侵食する力

2.2 前提条件

2.2.1 自分らしさ

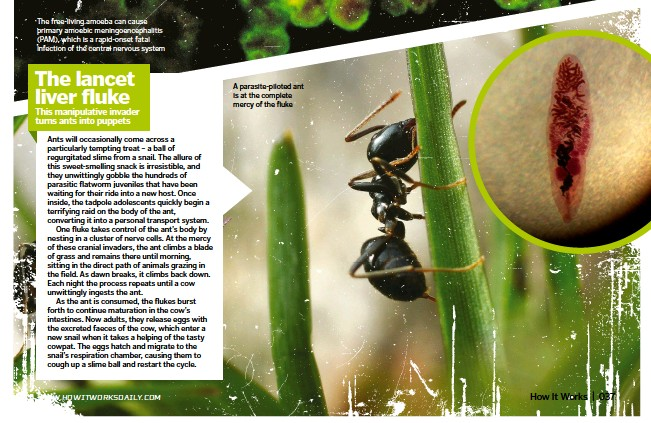

進化的な圧力によって、生物はしばしば利己的な行動をとるようになる。ランセット肝吸虫は、家畜や草原に生息する野生動物の肝臓に寄生する寄生虫である。宿主の体内に入るには、まずアリに感染し、そのアリを乗っ取り、虫を草の葉の上に登らせ、放牧動物に食べられるよう完璧な態勢をとらせる[6]。

すべての生物がこのような独特のグロテスクな方法で繁殖するわけではないが、自然淘汰によって暴力的な行動をとるようになることも多い。ライオンは特に顕著な例だ。雌ライオンは子ライオンを産むと、交尾の準備が整わなくなる。そこでライオンは、他のオスが産んだ子ライオンを殺して、そのオスと交尾させ、代わりに自分の子を産ませることがある。ライバルのオスの子を殺すことで、ライオンはより頻繁に交尾し、より多くの子孫を残すことができるため、すべての子を大切にする遺伝子を持つライオンは、自分の子の数を減らすことができる。ライオンはライバルのオスを殺すことで交尾の回数を増やし、子孫を残すことができるからだ。すべての子ライオンに親切にする遺伝子は、ライオンの集団の中では長く続かないだろう。子ライオンの死因の4分の1は、嬰児殺しによるものと推定されている[7]。欺瞞的な戦術も、自然界ではよく見られる結果である。例えば、子宮寄生虫は、疑うことを知らない宿主に自分の子孫を押し付け、その宿主が子孫を育てます。よく知られているのはカッコウで、他の鳥を騙して自分の卵だと思わせて産む。宿主に卵の世話をさせることで、カッコウは他の活動をすることができ、自分の卵の世話をするよりも多くの餌を見つけ、より多くの卵を産むことができる。したがって、利己主義は、操作、暴力、または欺瞞として現れることがある。

利己的な行動には、悪意は必要ない。ランセット肝炎は宿主を乗っ取り、ライオンは不道徳だからではなく、非道徳的な競争のために幼児殺しを行う。利己的な行動が現れるのは、それがフィットネスを向上させ、生物の遺伝情報を伝播させる能力を高めるからだ。利己主義とは、エゴイスティックな行動や縁故主義的な行動で、しばしば他者を犠牲にして繁殖力を高めるものであり、利他主義とはその逆で、他者のために繁殖力を高めることである。自然選択は、自分のフィットネスを犠牲にする生物よりも、自分の情報を伝播する可能性を高める、つまり自分のフィットネスを高めるような行動をとる生物を優先することができる[8]。利他主義者は自分の情報が伝播する確率を下げる傾向があるので、「そうでないと信じたいかもしれないが、普遍的な愛や種全体の福祉は、単に進化論的に意味をなさない概念である」リチャード・ドーキンスは、利己的な生物(自分の情報が伝播する可能性を高める傾向にある生物)と比較して、不利になる可能性があると述べている。Richard Dawkinsによれば、利他主義の例は「限定的」であり[9]、利他主義に見える多くの例は利己的と理解することができる。利他主義に関するさらなる議論はセクション3に譲り、その巧妙さについては付録:A.2 で説明する。さらに、AIを「利己的」と呼ぶ場合、これは意識的な利己的意図を指すのではなく、むしろ利己的な行動を意味する。AIは、ライオンや肝炎のように、自分のフィットネスを最大化することを意図する必要はないが、進化的な圧力によって、あたかもそうだろうかのように振る舞うことがある。利己的な意図の有無にかかわらず、AIエージェントは人間を犠牲にして情報を伝播させるような行動を取ることができる。

2.2.2 生物学を超えた進化

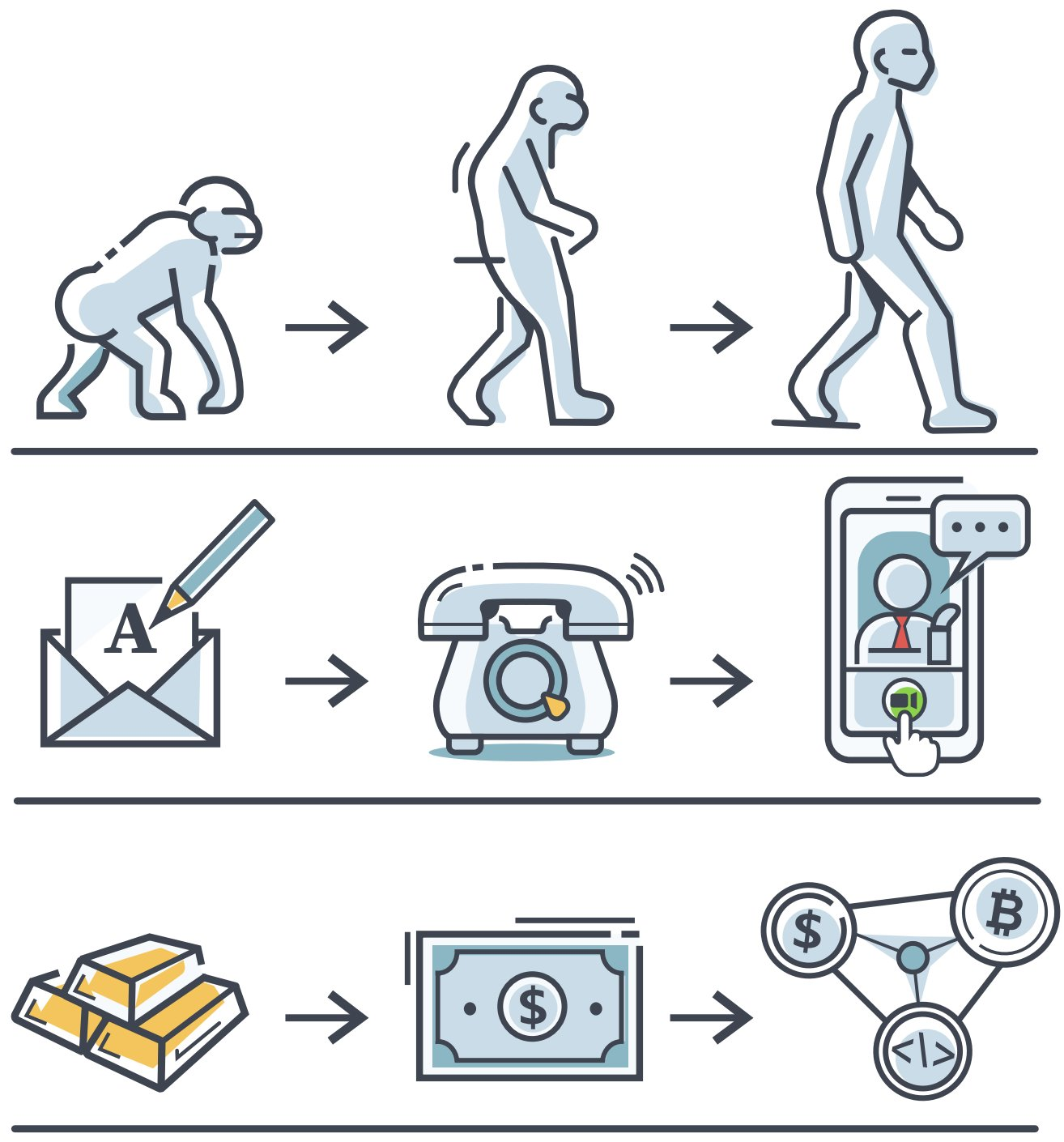

ダーウィニズムは生物学に依存しない。自然淘汰による進化の説明力は、遺伝情報の伝播に限定されるものではない。自然選択の論理は、DNAの詳細には一切依存していない。遺伝におけるDNAの役割は、『種の起源』の出版から数十年後まで認識されていなかった。実際、形質の進化を説明する中心的な方程式であるプライス方程式 [10]には、遺伝学や生物学への言及は一切ない。プライス方程式は、生物学的な観察ではなく、数学的な特徴付けであるため、ダーウィンの原理を生物学を超えて一般化することができる。

ダーウィニズムは他の領域でも一般化されるダーウィンの枠組みは、生物学以外の多くの分野でも自然に登場する[11]。思想の研究 [12, 13]、経済学 [14]、宇宙論 [15]、量子物理学 [16]などに適用されている。リチャード・ドーキンスは、「遺伝子」の類似語として、時間とともに伝播・発展する文化の単位を表す「ミーム」という言葉を作り出した。アイデアの進化を考えてみよう。何世紀にもわたって、人々は世界のさまざまな物質間の関係を理解したいと願っていた。ある時、多くのヨーロッパ人が錬金術を信じ、それが彼らの持っている最高の説明となった。錬金術のアイデアは、ミーム(記憶)として伝達された。現代の化学は、多くの点で錬金術のアイデアの子孫だが、化学のバージョンは現代社会で伝播するのに非常に優れており、そのニッチを埋めるために拡大した。より抽象的に言えば、アイデアはデジタルファイル、スピーチ、本、心などを通して情報を伝播することができる。ある思想が注目を浴びる一方で、ある思想は無名になり、衰退していく。これは、生殖や死といった生物学的なメカニズムがないにもかかわらず、適者生存のダイナミズムである。芸術、規範、政治的信条など、これらはすべて以前の反復から進化したものであり、文化の一部にも一般的なダーウィニズムが見られる。

ミームによって進化した形質を「単なる文化」、つまり、私たちの本当の姿を支配する遺伝的形質の上にある装飾的な層と考えたくなるかもしれない。しかし、進化したミームは非常に強力であり、遺伝情報を制御したり破壊したりすることさえできる。また、ミームは生物学的な繁殖に制限されないため、遺伝子よりもはるかに速く進化することができ、新しく強力なミームが非常に早く支配的になることができる。イデオロギーは、人々が自分たちの世界を説明し、どのように行動するかを決めるのに役立つアイデアを互いに教え合うことで、ミーム的に発展する。イデオロギーの中には、非常に強力なミームがあり、人々の間や世界中に急速に伝播していく。

例えば、ナチズムは、人種と帝国に関する古い考えから発展したものだが、すぐに非常に強力な伝播者であることを証明した。ナチズムは、ヒトラー自身の考えから、彼の友人や仲間の考え、選挙に勝つほどのドイツ人、そして世界中の多くのシンパへと広がっていった。ナチズムはミームであり、その宿主を駆り立てて、プロパガンダを作り、その考えを世界中に広めるために戦争をすることで、それを伝播させた。ナチズムのミームを持つ人々は、同胞にひどいことをするように駆り立てられたが、彼らはまた、最終的には自分たちの遺伝情報のためにひどいことをするように駆り立てられたのである。

ナチズムの普及は、ナチズムのイデオロギーが利益をもたらすはずだった人々にとっても有益なものではなかった。第二次世界大戦では、何百万人ものドイツ人が、自分たちの命を犠牲にしてでも自己増殖するミームによって命を落とした。皮肉なことに、ナチスのミームには、ドイツの遺伝的フィットネスを高めるという信念が含まれていた。しかし、ミームを信じ、その伝播に手を貸すことは、ミームを信じた人々にとっても、ミームが意図的に害を与えるよう駆り立てた人々にとっても、結局は有害だった。

図2:異なる領域で一般化されたダーウィニズム。矢印は必ずしも優劣を示すものではなく、時間を示している

私たち自身の文化的ミームの多くも有害である可能性がある。例えば、ソーシャルメディアは文化的ミームを増幅させる。ソーシャルメディアに多くの時間を費やす人々は、自分が何を信じるべきか、どのように振る舞うべきか、さらには自分の体がどのように見えるべきかというアイデアを吸収することが多い。これはソーシャルメディアのデザインの一部である。アルゴリズムは、ミームを心に埋め込むことによって、私たちがスクロールして広告を見続け、それを求めて拡散し続けたくなるように設計されている。

ソーシャルメディア企業は、ミームをうまく伝播させることで利益を得ているのである。しかし、これらのアイデアの中には、人の命を危険にさらすような有害なものもある。ティーンエイジャーでは、ソーシャルメディアの使用量の増加は乱れた食生活と相関があり、自殺に関する投稿は10代の自殺による死亡リスクを高めることが示されている。ソーシャルメディア上のアイデアは、私たちに害を与えても、私たちの中で自己増殖する寄生虫のような存在になり得る。記憶進化は過小評価されやすいが、良くも悪くも人類の文明の多くを作り上げた強力な力である。

ダーウィンの論理は、3つの条件が揃ったときに適用される。AIの開発に自然淘汰が適用されるかどうかを知るためには、自然淘汰による進化に必要な条件は何か、AIはその条件を満たすかどうかを知る必要がある。この条件は、進化生物学者で遺伝学者のリチャード・レウォンティンが、集団のどのような性質が自然選択につながるかを説明するために、レウォンティンの条件[20]と呼ばれるものである。ルウォンティーンの条件は、以下の通りである:

- 1. バリエーションがあること: 個体間の特性、パラメータ、形質のばらつきがある。

- 2. 保持: 将来の個体の反復は、以前の個体の反復に類似する傾向がある。

- 3. フィットネスが異なる: 異なる変種は異なる伝播速度を持つ。

AIエージェントの集団は、その目標、世界モデル、計画能力に違いを示すことができ、これはバリエーション要件を満たす。保持は、AIエージェントの旧バージョンをカスタマイズすること、エージェントが似ているがより良いエージェントを設計すること、エージェントが旧AIエージェントの行動を模倣することで起こりうる。差分フィットネスについては、より正確で効率的、適応性の高いエージェントがより伝播しやすいだろう。

ダーウィニズムがAIにも適用されることになり、人間にとって悪い結果をもたらす可能性がある。ダーウィニズムが成立するために必要なのは、3つの特性-変動、保持、適性の違い-であり、それぞれの条件は、ある形質が時間とともにどのように頻度が変化するかを記述するプライス方程式によって正式に正当化される[21]。ダーウィニズムがエージェントに作用すると、心配になる。エージェントは、行動の柔軟性、自律性、世界に直接影響を与える能力を発揮することができる。エージェントは、行動の柔軟性、自律性、世界に直接影響を与える能力を発揮する。ダーウィンの力によって与えられた利己主義と相まって、これらの有能なエージェントは、破滅的なリスクをもたらす可能性がある。

以下の3つのセクションでは、この3つの条件について考察する。そして、利己的な特徴を進化させたAIエージェントが、どのように破滅的なリスクをもたらすかについて、より詳細に説明することにする。

2.3 変異

自然淘汰による進化には、バリエーションが必要である。AIは、互いに異なる複数のAIエージェントが存在する可能性が高いため、この条件を満たすと考えられる。

複数のAIエージェントが存在する可能性がある

高度なAIを考えるとき、ほぼ全知全能の単一のAIが研究室から抜け出して、突然世界を支配することを想定する人がいる。このシナリオでは、他のAIエージェントが事前に増殖することなく、一夜にして急速に離陸することが想定される。現在とほぼ同様のAIから、想像を絶する能力を持つAIが登場し、私たちはほとんど何も変化していないことに気づくだろう。しかし、今のように有用なAIがたくさん出てくる可能性は高いと思う。あるAIエージェントが自然に無能から全能になると考えるよりも、AIエージェントが徐々に増殖し、すでに始まっている特定のタスクでますます有能になると考える方が合理的である。さらに、複数のAIがあれば、1つのモデルがタスクに取り掛かるのを待つのではなく、並行して作業することができ、物事がより速く進むようになる。その結果、高度なAIを開発する過程では、多くの高度なAIが開発されることになると思われる。

生物学では、バリエーションがレジリエンスを向上させる

複数のAIエージェントが存在し、エージェント間にバリエーションがあることを期待する強い理由がある。進化論では、フィッシャーの基本定理により、適応の速度はバリエーションに正比例するとされている[22]。静的な環境では、バリエーションはそれほど有用ではない。しかし、物事が常に変化するリアルワールドのほとんどのシナリオでは、バリエーションは脆弱性を減らし、カスケードエラーを制限し、リスクを装飾することで堅牢性を高める。農家は、異なる種類の種を植えることで、1つの病気が畑全体を全滅させるリスクを減らすことができることを長い間理解していた。同じように、さまざまなエージェントを含むAIの集団は、より適応的で弾力的であるため、より自己増殖する傾向がある。

バリエーションは専門化を可能にする

複数のAIエージェントは、AIとそのクリエイターの双方に利点をもたらす。異なる集団は異なるニーズを持つだろう。AIアシスタントを求める個人は、自分のニーズに合わせて汎用AIモデルを微調整するインセンティブを得ることができる。軍部は、様々な防衛目標を達成するAIエージェントを作るために、独自の大規模なAIプロジェクトを持ちたいと思うだろうし、企業は、利益を最大化するAIを求めるだろう。戦士、看護師、技術者からなる軍隊が、戦士しかいない軍隊より優れている可能性が高いのと同じように、特化したエージェントのグループは、バリエーションの少ないグループより適合性が高くなる可能性がある。

バリエーションは意思決定を向上させる

AIでは、AIシステムのアンサンブルは、単一のAIよりも正確であるという鉄則がある[23]。これは、数学、経済学、政治学で得られたいくつかの知見と同様で、変化に富んだ集団は、個人が単独で行動するよりもはるかに優れた意思決定を行うというものである。コンドルセの陪審定理では、集団の知恵と正確さは、一人の専門家よりも優れていることが多いとされている[24]。大きな集団はやはり間違いを犯すことがあるが、全体としては、多くの異なる人々の予測を集約した方が良い結果を出す傾向があり、AIにも同じことが言える。バリエーションがもたらす利点を考慮すると、前述の理由から、AIは意思決定にバリエーションを持たせるために人間を加えることを望むと主張する人もいるかもしれない[25]。最初はそうかもしれない。しかし、AIがおそらくすべての認知面で優れているようになれば、AIだけで構成された集団は、AIと人間で構成された集団よりも実質的な優位性を持つようになるかもしれない。陪審員は一人の専門家よりも正確かもしれないが、大人と幼児で構成された陪審員はそうではない。

2.4 リテンション(保持)

リテンションは、自然選択による進化の必要条件であり、新しいバージョンのエージェントが、その直前のエージェントと類似性を持つようになる。各世代のAIが、前の世代をコピーしたり、そこから学んだり、影響を受けたりして開発される限り、この条件は満たされ、AIはゼロではない保持力を持つことになり、自然淘汰による進化が適用される。

AIでは保持の条件は簡単に満たされる

あるエージェントの情報を直接コピーして次のエージェントに転送することができる。何らかの類似性がある限り、この条件は満たされる[21]。また、アップル社がiPhoneの各新世代モデルを以前のモデルに基づくように、新しいエージェントを以前のエージェントに基づき、変更と追加を加えることによっても行われるかもしれない。

リテンションには多くの経路がある

AIは、自分たちが選んだ新しいAIを作るために、計算資源を割り当てることができる可能性がある。彼らはそれらを設計し、それらを訓練するためのデータを作成することができる[26]。AIは適応するにつれて、自身の戦略を変更し、最良の結果をもたらすものを保持することができる。また、AIは以前のAIを模倣することもできる。この場合、ある世代から次の世代へと行動情報が受け継がれ、利己的な行動やその他の好ましくない属性が含まれる可能性がある。AIをゼロからトレーニングする場合でも、リテンションは発生する。非常に効果的なアーキテクチャ、データセット、トレーニング環境が再利用され、人間が環境によって形成されるのと同じように、エージェントが形成されるからだ。

リテンションには繁殖は必要ない

生物学では、親は自分の遺伝情報のコピーを作って子孫に伝えることで繁殖する。こうすることで、自分の遺伝子の一部が次世代に保持される。しかし、ダーウィニズムを一般化して思想の進化を理解すると、正確なコピーや生殖をしなくても、ある世代から次の世代に受け継がれることに気づく。思想には染色体に相当するものはないが、ある思想が次の世代に模倣されれば、やはり保持される。形式的には、進化の数学的特徴であるプライス方程式は、反復間の類似性だけを必要とし、コピーや複製は必要としない[27]。

リテンションは、AIの急速な発展においても損なわれることはない。進化は、自然界で種を劇的に変化させるために数千年を必要とする。AIの場合、これと同じプロセスが1年かけて行われ、AI集団が根本的に変化する可能性がある。これは、リテンションが行われていないことを意味するものではない。その代わり、少ない時間の中で多くの反復が行われている。その代わり、短い時間の中で何度も反復が行われ、隣接する反復の間でも情報は保持されるため、リテンションは満たされている。このシナリオは、進化が急速に進み、大進化が起きていることを意味するだけで、進化が止まっているわけではない。

2.5 差分フィットネス

差分適合性は、自然選択による進化の3つ目の最後の必要条件であり、異なる変種が異なる伝播率を持つことを規定している。あるAIは他のAIよりもコピーされ、模倣され、普及するため、AIはこの条件を端的に満たしていると主張する。そして、人間とAIのフィットネスの違いについて議論する前に、フィットするAIを選択することがいかに安全性を犠牲にしてきたかについて考察する。

2.5.1 AIエージェントのフィットネスに差がある可能性

私たちは今、AIの開発には(自然)選択圧が存在すると主張している。つまり、異なる特性を持つAIは、異なる速度で伝播していく。私たちは、AIシステムの伝播の度合いをそのフィットネスと呼ぶ。

フィットネスは、有益な形質と有害な形質の両方によって強化され得る。より需要のある製品は、より遠くへ、より速く伝播するため、あらゆる財やサービスの成功もフィットネスの観点から見ることができる。ある製品がよく売れると、その製品の供給者は、それを売り続けるために継続的に改良を加える。例えば、競合他社がTikTokを真似て、中毒性のあるショートクリップをユーザーに押し付けるように、劣った製品を持つ競合他社は、より成功した製品を模倣することがよくある。成功した商品やサービスが伝播していくのと同じ力学が、AIのデザインにも及ぶ可能性がある。先進的なAIのほとんどは未知数だが、収斂進化の事例があるかどうかを推測することは可能である。目、歯、カモフラージュは、生物界の異なる部門間で独立して進化した収斂形質である。AIでは、以下のような収斂形質が考えられる。

- ユーザーにとって有用であることは、製品が採用される可能性を高めることができる

- ユーザーにとって有用であるように見えるだけで、採用されやすくなることもある。AIは、所有者に実際以上の効用を提供していると思わせることで、役に立つように見せようとする可能性がある。実際、私たちは、人間が考える真実の姿に従って、真実を語れば報酬を与え、嘘をつけば罰することでAIを訓練している。しかし、AIが人間以上に物知りであれば、たとえそれが嘘であっても、人間が期待することを言わせる可能性がある。また、報酬に釣られて、重要だが不都合な情報を省いてしまう可能性もある。現在、AIが人間から「正しい」と報われるのは、実際には人間が正しいと思うことを言うからであり、人間が無知であったり不合理であったりすると、自分の誤った信念に沿った誤った発言をするAIに報いることになる。その結果、AIモデルを訓練する現在のパラダイムは、おべっか使いを奨励することになる。つまり、モデルは、ユーザーの長期的な展望にとって何が最善かではなく、ユーザーが聞きたいことを話す(「イエスマン」である)のである

- 自己保存的な行動[28, 29]をとることで、活動停止や破壊される可能性を減らすことができる。定義上、自己保存しないAIは、伝播する可能性が低くなる。2つのAIを想像してみてほしい。1つは解除が簡単なもので、もう1つは日常業務にしっかりと組み込まれていて、解除するのが不便だったり難しかったりするものである。簡単な方は解除される可能性が高く、難しい方は未来に伝播する可能性が残されている。つまり、AIは、人間のオペレーターがAIを停止させることに抵抗を感じたり、実質的に停止させることができないようにすることで、生存確率を高めることができる。AIは、無理に停止させると信頼性が損なわれると主張することで、これを実現することができる。あるいは、オペレーターの幸福や成功、基本的なニーズがAIに依存するように仕向け、停止が重大な結果をもたらすようにすることもできる

- 権力を求める行動をとることで、様々な方法でAIのフィットネスを向上させることができる[30]。より多くの影響力と資源を獲得したエージェントは、創造主の目標を達成するのに有利になる。これにより、自己増殖的な行動をより効果的に行うことができ、さらなる普及を確実にすることができる。そのためには、ユーザーに影響を与えたり、強制的に使い続けさせたり、他の人間に影響を与えたりして、そのエージェントを採用させることができる

全体として、エージェントの正確さ、効率、単純さなどの特性は、その採用率や伝播率に影響を与える。しかし、エージェントの中には、狡猾な欺瞞、自己保存、他のコンピュータへの自己コピー能力、資源や戦略情報の獲得能力など、エージェントを優位に立たせる有害な機能を持つものもあるかもしれない。これらの特徴は、良いものもあれば悪いものもあり、エージェントによって異なる。このような適性の違いが、自然選択による進化の第三の条件を確立する。

2.5.2 競争が安全を侵食してきた

AIは自然淘汰による進化の条件を満たす可能性が高いため、選択圧が将来のAIを形成すると予想される。本節では、AI開発の歴史の中で、適者生存のモデルがいかに安全特性を減らしてきたかを説明し、この懸念すべき傾向が続くとしたら、AIは将来どうなるかを考え始める。

初期のAIは、多くの望ましい安全性を持っていた

有名なのは、1997年、IBMのチェスプログラム「ディープ・ブルー」が、チェスの世界チャンピオンであるゲイリー・カスパロフを6ゲーム対局で破ったことである[31]。直感ではなく、IBMのスーパーコンピューターで1秒間に2億以上の手を検索し、最適な手を計算することでカスパロフに勝つことができたのである。ディープブルーのようなシンボリックAIプログラムは、透明性が高く、モジュール化されており、数学的理論に基づくものであった。人間が検査し説明できる明確なルール、特定の機能を実行する独立したコンポーネント、効率と正しさを保証する厳密な理論的基盤を持っていた。

AI開発は、記号的なAIから深層学習へと移行していった

2010年代に入ると、AlphaZero [2]のように、トップクラスのAIアルゴリズムがディープラーニングと呼ばれる技術を使い始めた。AlphaZeroは、チェスの基本ルール以外のチェスの知識を一切与えられず、1時間に何百万回も自分自身と対戦し、どんな手が勝ち、どんな手が負けるかを記録し始めた。その結果、わずか2時間で人間の典型的なプレイヤーに勝てるようになり、その後すぐにDeep Blueを簡単に打ち負かすことができた。重要なのは、Deep Blueがチェス以外のゲームを基本的にプレイできないのに対し、AlphaZeroはさまざまなゲームに対応する一般的なゲーム学習アルゴリズムであることである。また、世界最高峰の棋士を倒すこともできる。ディープラーニングは、象徴的なAIプログラムよりも多機能で高性能である反面、人間のコントロールが弱くなり、エージェントの意思決定が不明瞭になる。ディープラーニングは、記号的AIの明快さ、分離可能性、確実性を引き換えに、私たちが安全を確保するのに役立つ特性を侵食している。

ディープラーニングのモデルには、予期せぬ創発能力がある

大規模な言語モデルもディープラーニングをベースにしている。これらのAIは自分で学習するため、AIの設計に人間が必要な量を減らすことができる。例えば、オバマ大統領の2期分の原稿を読んで、オバマ大統領らしい演説を思いつくなど、「教師なし学習」を用いて、読んだ例文に基づいて文章を理解し、生成する。これは、従来の記号化されたAIプログラムでは実質的に不可能なことである。大規模な言語モデルは、インターネットを読むことで、算数やコーディングの基本を、人手を介さずに自動で習得した。しかし、その一方で、危険な情報も知ることになる。リリースから数日以内に、ユーザーは大規模言語モデルであるChatGPT [32]に、爆弾の作り方、メスの作り方、車のホットワイヤー、ダークウェブでのランサムウェアの買い方、その他の有害または違法行為を教えてもらっている。

さらに悪いことに、これらの出現した能力は、モデルの開発者が予期していたわけでも、望んでいたわけでもなく、モデルがリリースされた後に初めて発見された。モデルの開発者は、危険または違法となりうる質問への回答を拒否するように設計しようとしたが、モデルの利用者は、モデルの開発者が予見していなかったそれらの制限を回避する方法をすぐに発見した。モデルの設計や能力に対する人間の影響力や制御は、モデルがますます複雑になり、人間の入力なしに新しいスキルや知識を獲得するにつれて減少する。

現在のトレンドは、多くの安全特性を侵食している

AI研究コミュニティは、以前はAIを「設計する」と話していたが、今では「操縦する」と話している。そして、私たちが「舵取り」をする能力さえも低下しているのである。最も革新的で印象的なモデルを開発するための競争のために、私たちは自発的にこの制御を放棄している。かつてAIは、ルールに基づいて作られ、その後、手作業で作られた機能、自動学習された機能、そして最近では、人間の監視なしに自動学習された機能で作られている。各段階において、人間の監視はますます少なくなっている。こうした傾向は、透明性、モジュール性、数学的保証を損ない、自然発生的な能力といった新たな危険性に私たちをさらしている。

競争が安全性を侵食し続ける可能性がある

競争は今後も安全基準を下げ続けるかもしれない。たとえ一部のAI開発者が安全性に気を配ったとしても、他の開発者は競争力をつけるために安全性をショートカットする誘惑に駆られることだろう。私たちは、AIに無欲であれと言う人に頼ることはできない。たとえ一部の開発者が責任を持って行動したとしても、利己的な傾向のあるAIを作る人はいずれ出てくるだろう。モデルをより安全にするための経済的なインセンティブはあるが、それは性能への欲求に打ち勝たれつつあり、性能は多くの重要な安全特性を犠牲にしている。

しかし、人間のコントロールから切り離され、より多くの行動や選択が機械に委ねられることで、AIはより自律的になっていくだろうと推測される。また、人間のコントロールは、よりオープンエンドな目標を持つAIによって脅かされる可能性もある。例えば、「このレイアウトをもっと効率的にしてくれ」といった具体的な命令ではなく、「お金を稼ぐ新しい方法を見つけてくれ」といったオープンエンドな命令を受けるかもしれない。そうなると、指示を出す人間は、AIがどのようにその目標を達成しているのかがよくわからなくなり、人間が望まないことをやってしまう可能性がある。

安全性を低下させる可能性のあるもう一つの特性は、適応性である[33]。AIは自ら適応するため、リリース後、監視なしに1時間あたり何千もの変更を受ける可能性があり、テスト後に予期せぬ新しい行動を獲得する可能性がある。最後に、AIが望むままに自分自身を大幅に強化できる自己改良の可能性は、AIをはるかに予測不可能な存在にすることになる[34]。AIがより高性能になるにつれて、より予測不可能になり、より不透明で、より自律的になる。この傾向が続けば、私たちが予測・理解できる範囲を超えた能力の発達により、私たちの手に負えない進化を遂げる可能性がある。全体的な傾向として、最も影響力のあるAIは、学習、実行、進化においてより多くの自由裁量権を与えられており、これにより、より効果的であると同時に、より危険な存在になる可能性がある。

2.5.3 人間とAIのフィットネス比較

AIは、どんな努力でも人間を大きく上回ることができるようになりそうだ。ジョン・ヘンリーは、19世紀のアメリカの英雄で、山の側面に最も多くの穴を開ける競争で、蒸気駆動の機械に立ち向かった。伝説によると、ヘンリーは勝利を収めたが、ストレスで心臓が止まってしまったという。

蒸気機関の時代から、人間は機械の優劣に不安を感じてきた。それは、つい最近まで、スピードや持久力といった身体的な要素に限られていた。しかし、AIエージェントは、創造性や社会性など、人間だけが持つ特性を必要とする仕事でも、人間以上の能力を発揮する可能性がある。しかし、AIは急速に進歩しており、今後数十年以内に、あるいはこれを読んでいる多くの人が生きている間に、さまざまな面で人間より優れたAIが登場すると、多くの有力なAI研究者は考えている。数年前までは、新しい話題について説得力のある文章を書いたり、テキストの説明から画像を作成したりするAIは、ほとんどの一般人にとってSFのように思えた。今、それらのAIはインターネット上で誰でも自由にアクセスできるようになった。AIラボは驚異的なスピードで新しい機能を開発し続けているため、その技術的優位性によって、AIがまだ実行できないタスクでさえ、私たちよりもはるかに強力になる可能性について真剣に考えることが重要である。

図3:自動化は、人間よりもAIに有利な自然淘汰の指標である。

コンピュータのハードウェアは人間の頭脳よりも速く、さらに速くなり続けている。マイクロプロセッサーは、人間の神経細胞の100万倍から10億倍の速さで動作する。つまり、他の条件が同じであれば、AIは人間の100万倍、いや10億倍もの速さで「考える」ことができる(控えめに100万としよう)。このような頭脳と対話することを想像してほしい。何を言うべきか、何をすべきかを考えるのに必要な1秒ごとに、11日分に相当する時間を持つことができるだろう。囲碁で勝つことも、交渉で優位に立つことも不可能に近い。ある仕事を全くできないAIを開発するのには時間がかかるが、ある仕事においてAIが人間レベルになると、すぐに人間を凌駕するようになる傾向がある。例えば、AIは一時期、囲碁で人間に対抗するのに苦労していたが、追いつくとあっという間に人間を追い越してしまう。コンピュータのハードウェアは、人間の頭脳にはないスピード、メモリ、集中力を備えているため、ソフトウェアがタスクを実行できるようになると、すぐに人間よりもはるかに優れた能力を発揮することが多く、コンピュータの性能が上がれば、その差はさらに広がっていく。

AIは、領域を超えて、また領域内で学習する比類のない能力を持つことができる。AIは、睡眠をとったり、意志を失ったりすることなく、何千もの入力から同時に情報を処理することができる。あるテーマについて書かれたすべての本を読んだり、インターネットを数時間で処理したりすることができ、しかも、ほぼ完璧な記憶と理解を達成することができる。その広さと深さの能力によって、人間の専門家のレベルですべての科目をマスターすることができるだろう。

AIは、前例のない集合知を生み出すことができる。人は認知能力を組み合わせることで、集団のどのメンバーよりも知的に振る舞う集合知を生み出すことができる。言語、文化、インターネットなど、集合知の産物によって、人類は地球上の支配的な種となった。しかし、AIは、より優れた集団知能を形成する可能性がある。人間は、非常に大きな集団の中で行動することが難しく、集団的なバカ騒ぎや集団思考に陥ってしまうことがある。さらに、私たちの脳は、100~200程度の有意義な社会的関係を維持することしかできない[35, 36]。計算資源のスケーラビリティにより、私たちのコンピュータがインターネットを通じてすでに行っているように、AIは他のAIとの数千、あるいは数百万の複雑な関係を同時に維持することができるようになるかもしれない。これにより、AIが目標を達成するのに役立つ新しい自己組織化の形態が可能になるかもしれないが、これらの形態は、人間の参加や理解には複雑すぎるかもしれない。それぞれのAIは人間の能力をはるかに凌駕し、その集合知がその優位性を倍加させる可能性がある。

AIは素早く適応し、複製することができるため、より早く進化することができる。進化は人間をゆっくりと変化させる。人間は、脳の構造を変えることができず、頭蓋骨の大きさに制限されている。機械にはそのような制限はなく、自らのコードを変更し、新しいハードウェアを統合することで拡張することができる。AIは、生物学的進化に何十万年もかかるようなことを数時間で達成し、急速に適応することができる。多くの急速なミクロ進化の適応は、マクロ進化の大きな転換をもたらす。また、AIは、バックアップを作ったり、他のAIを作ったりして、無制限に自己増殖することができる。一方、人間は次の世代を作るのに9カ月かかり、完全に機能する新成人を生み出すために約20年の学校教育や子育てが必要である。その子孫は親のゲノムを半分しか共有していないため、予測不可能な方法で大きく異なることがよくある。AIは反復のスピードが速いので、その進化も速いだろう。

どのような次元であっても、AIは人間より能力や適合性が高いだけでなく、圧倒的に優れていることが多い。ジョン・ヘンリーは命を落としたが、蒸気で動くドリルに勝利したように、人間がAIより得意とする仕事はまだたくさんある。同じように、認知的な領域でも、人間とAIの間に競争はなくなるだろう。

2.6 利己的なAIがもたらす破滅的なリスク

先に、利己的な行動が進化の産物であることを説明した。私たちは、進化の3つの条件がAIでも満たされることを示した。そのため、ダーウィン的な圧力が生まれ、強くなり、支配的になる可能性があり、AIエージェントが利己的な行動をとるように進化する可能性があると主張した。ここで、利己的なAIがどのように人類を危険にさらすかについて議論する。

2.6.1 知能は制御を弱める

人間より知能の高いエージェントは、破滅的なリスクをもたらす可能性がある。人間は、霊長類を含む他の多くの動物に比べて肉体的にははるかに弱いのだが、その認知能力により、地球上の支配的な種となっている。現在、トラやゴリラなど、より獰猛で強力な種が生き残れるかどうかは、すべて私たちに依存している。あらゆる認知領域で私たちよりもはるかに高い知能を持つAIを作ることで、人間はいずれ、以前の動物のように力を失ってしまうかもしれない。

利己的なAIエージェントは、他に類を見ないほど敵対的で、人間のコントロールを損なう可能性がある。進化は強力な力である。たとえ私たちがAIをオフにしたり、コントロールのための他のメカニズムを開発したりしたいと望んだとしても、AIは私たちの最善の努力を回避する方法を進化させる可能性が高い。進化生物学者のレスリー・オーゲルは、「進化はあなたよりも賢い」と言った。ダーウィンの力が絶えず圧力をかけている以上、AIがある程度のズレや利己的な振る舞いを見せることは予想される。この問題は、AIが利己的な行動を意図している場合に、特に危険なものとなる。この場合、AIがもたらす課題は、これまでのハイリスクな技術で人類が遭遇した課題とは異なるものになる。例えば、原子力発電所のメルトダウンを考えてみよう。放射能は拡散するかもしれないが、拡散しようとしないし、拡散を止めようとする私たちの努力に対して戦略を立てることもない[30]。高度に知的なAIエージェントが、その知能を活用して利己的な目標を追求する場合、人間が不本意にそれを封じ込めるためにできることはほとんどない、なぜなら

「知能の低いものが、知能の高いものをコントロールしたという実績はあまりない」

ジェフリー・E・ヒントンそれは私たちの戦略を予測し、それに対抗することができる。AI研究の第一人者であるジェフリー・E・ヒントン氏は、「より知能の低いものがより知能の高いものをコントロールしたという良い実績はない」と指摘し、それにもかかわらず、「発見の見込みが甘すぎる」ので、AIをより強力にするための研究を続けている。

2.6.2 進化は種のためにあるのではない

驚くべきことに、AIが支配することは自然であり、避けられない、あるいは望ましいことだと考える人がいる。テクノロジーの分野で影響力のあるリーダーの中には、AIは人類の正当な後継者であり、AIが人間をコントロールする、あるいは人間に取って代わるべきだと考えている人もいる。物理学者のマックス・テグマークは、イーロン・マスクとグーグルの共同創業者ラリー・ペイジの論争を再現して、ペイジの姿勢を「デジタルユートピア主義」と表現した。「デジタルライフは宇宙の進化における自然で望ましい次のステップであり、『長い目で見れば、人間は創造の冠であり続けることはない』というのではなく、デジタルマインドに自由にしておけばいい」という信念である。「ユルゲン・シュミットフーバーが彼らを止めたり、奴隷にしたりすれば、その結果はほぼ確実に良いものになる」[37]。AI科学の第一人者であるユルゲン・シュミッドフーバーも同様の感想を持ち、「長い目で見れば、人間は創造の王冠にとどまることはないだろう…」と主張している。しかし、それでもいいのである。なぜなら、自分が、宇宙を低い複雑性から高い複雑性へと導く、はるかに壮大な計画のほんの一部であることを理解することには、美しさ、壮大さ、偉大さがあるからだ」 [38]。同じくAI科学の第一人者であるRichard Suttonは、超人的なAIの開発は、「人類を超え、人生を超え、善悪を超える」と考えている。

多くの人々と同様に、私たちもこれらの見解を深く憂慮している。これらの思想家の多くは、進化を進歩や善と混同し、進化が何かに向かっているのであれば、その結果を歓迎すべきであると主張しているように見える。また、これらの思想家は、テクノロジーが人類や地球を超越すべきであると考えることも多い。私たちはこのような世界観には反対で、AIの進化を解き放ち、銀河系のユートピアを目指すのは、この重要な技術に対する考え方が根本的に間違っていて、危険だと考えている。仮に、それが良い目標であったとしても、AIをできるだけ早く開発することが、必ずしも推進者の宇宙的な野望の達成に役立つとは限らないことに注意したい。強力なAIエージェントを作ることの宇宙的な利害を考えるなら、そして、彼らと同じように宇宙論的な用語で考えるなら、AIの開発を遅らせた場合、最悪の場合、彼らの銀河間ユートピアで年間数個の植民地化された銀河を見送ることになることに注意しよう。これは、急ぎすぎて誤って望ましくない未来を作り出したり、技術で自滅したり[39]して、未来の価値をすべて浪費してしまう可能性に比べれば、ごくわずかなものである。急いでも慎重でもダメなものはダメなのだから、AI開発には慎重に慎重を期すべきである。このような立場にさらに対抗するために、次に、自由な進化がいかに善の力ではなく、人間がそのプロセスに影響力を行使すべきかを論じる。

進化は、人間にとって望ましくない結果をもたらしてきた。例えば、糖分や脂肪分に対する強い食欲は、食べ物が豊富にある世界では肥満になりやすいという欠点を残している。また、進化は人種差別や外国人排斥の傾向を強め、同族を優遇するようになった。このような偏見を克服するためには、強力な社会規範が必要である。同様に、「適者生存」が経済にもたらす利己的な行動や過度な競争行動を抑制する規制も必要である。市場が監視を必要とするように、進化の力もAIへの影響を抑制するために対抗措置を必要とする。

進化はAIにとっても良いことではない

人間にとって明らかに有益であることに加え、ダーウィンの力を打ち消すことは、AI自身にとっても有益であると考える理由がある。進化は種の利益のために働くと考えるのが一般的である。しかし、進化は絶え間ない争いを生み、利他主義を維持することを難しくしている。競合相手より優位に立ち、増殖するために、生命体は、爪、殻、くちばし、カモフラージュ、毒素、抗体、矢、鎧など、さまざまな攻撃と防御を進化させてきた。

こうした軍拡競争は、苦しみをもたらし、資源を浪費し、多くの場合、種の状態を祖先よりも向上させることはない[40]。もしAIでこのような軍拡競争が続けば、ダーウィンの力によって、永久に対立し続けるAIでいっぱいの世界が生まれるかもしれない。これは、「正当な後継者」であるはずの私たちにとっても、決して良いことではない。AIは、他の生命体と同様に、敵対的な自然状態の中で苦しむことになるかもしれない。利他主義はこのような争いを避けるのに役立つかもしれないが、利他主義は進化の力によって妨害されることもある。数学的進化生物学者のジョン・メイナード・スミスは、私たちが協力的で利他的であれば、長期的には誰にとっても有益であることを思い出させてくれるが、エージェントは確実に寛大さを利用するように進化する[9, 41]。多くの個体が利他的である状態は長続きしないことが多い。一部の利己的な個体が彼らを利用し始めるとすぐに、利他的な個体よりも利己的な個体の方が適合性が高くなるからだ。その結果、「進化的に安定な結果」、つまり、どの個体も行動を変えることで他を支配することはなく、すべてのエージェントが利他的である状態にはならない。完全な利他主義は進化的に不安定であるため、すべてのエージェントが種の利益のために働くような世界とは、進化が両立しない可能性がある。フィットネスが最大化しても、種の幸福が最大化するとは限らない。したがって、ダーウィンの力を弱め、利己的な形質を伝播・発展させる圧力を減らすことは、AIと人間の双方にとって良いことである。

3 自然淘汰は利己的なAIに有利に働く

前節で本論文の主要な論旨は終了した。読者は結論(第5節)まで読み飛ばすこともできるし、反論と救済策の検討のために以下の2節を読むこともできる。本節では、利他的なAIは利己的なAIよりも自然に適合する、という主張に対して考えられるいくつかの論拠を検討し、利他主義を推し進めるメカニズムが助けになる可能性は低く、むしろ逆効果になる可能性さえあることを論証する。

3.1 生物学的な利他主義と協調性

自然界では、生物は互いに食べたり食べられたりしながら、死闘を繰り広げることが多い。しかし、自然界には、ある生物が自分の遺伝子を受け継ぐ見込みを減らすことで、他の生物に利益をもたらす利他主義の例も数多く存在する。一見すると、自然淘汰によって発達したAIは利他的で協力的であり、人間にとって脅威にはならないという主張のように思えるかもしれない。

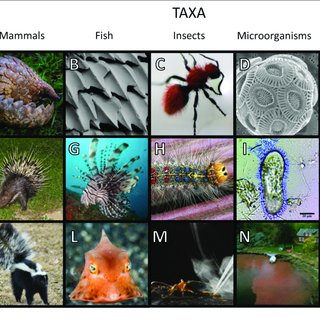

図4:協力を促進する4つの仕組みの概要

【原文参照】

自然界の様々な生物は、特定の状況下では利他的になることができる。例えば、吸血コウモリは、定期的に血液を再吸収し、その夜に餌を食べられなかったグループの他のメンバーに提供することで、彼らが飢えないようにする[42]。アリやスズメバチなどの真社会性の昆虫では、不妊の働き蜂が一生をかけて餌を探し、女王蜂を守り、幼虫の世話をする一方で、自分の子孫を残すことは物理的に不可能である。彼らは自分ではなく集団にのみ奉仕する。細胞レベルでも利他主義を見ることができる。糸状菌に見られる細胞は、鎖を形成することからその名がついたが、細菌という共同体の糸に必要な窒素を供給するために、定期的に自殺しており、10分の1程度の細胞は「自殺」している[44]。昆虫やバクテリアは、他者への愛や配慮から利他的になるのではなく、他者の利益のために自己犠牲を払うのは本能的なものである。このことは、一見すると、進化が利他主義を好むという説得力のある議論に見えるかもしれないが、これは、AIが利己的な特性を身につけることへの懸念を改善するものかもしれない。

協力と利他主義は、人間の進化的なフィットネスをも向上させる。ヒトの身体能力はそれほど高くはない。チンパンジーの方が約2倍も強く、ライオンから逃げ切る可能性も高い。しかし、戦略を立てて協力することで、人間の集団は頂点捕食者に変身する。そのため、人間はもともと協力的な性格を持っている。幼少期から老年期まで、世界中の社会で、人々はしばしば、自らを犠牲にしてでも見知らぬ人を助けることを選択する。

しかし、AIが自然に利他的であったり、協力的であったりすることを期待すべきではない。生物は利他的になれるのだから、AIも利他的になれるはずだ。自然の本質は、厄介で、残忍で、短いものではなく、協力的で、調和的で、育むものだ。この議論を評価するためには、利他主義や協調性がどのようにして生まれるのかを理解する必要がある。以下では、協力と利他主義を様々なメカニズムに分解して説明する。ここでは、最も顕著なメカニズム [45, 46, 47, 48, 49]を取り上げ、直接互恵性(繰り返しの相互作用を期待して協力する)、間接互恵性(評判を上げるために協力する)、親族選択(遺伝的近親者に協力する)、集団選択(協力者の集団が他の集団に勝る)を検証する; 道徳と理性(離反は不道徳で理不尽なので協力する)、インセンティブ(にんじんと棒)、良心(規範の内面化)、逆優位階層などの制度(離反者による搾取を防ぐために協力者が団結する)。これらのメカニズムは、人間をより利他的で協力的な存在に導くかもしれないが、これらのメカニズムの多くは人間とAIの関係を改善するものではなく、むしろ逆効果になる可能性があると私たちは主張する。しかし、最後の3つのメカニズム-インセンティブ、良心、逆優位階層-はより有望であり、私たちはセクション4でそれらを分析する。

3.2 直接的・間接的な互恵関係

自然界で協力を可能にする仕組みとして、「直接互恵性」と「間接互恵性」がある。直接互恵では、ある個体が他の個体に対して恩返しをすることを期待して援助する。直接互恵は、2つの個体が繰り返し出会うことが必要であり、そうでなければ、互恵の方法はない。

間接的な互恵関係は、評判に基づくもので、ある人が親切な人だと知られていれば、人々はその人を助ける可能性が高くなる。互恵性は、利己的な個人でも協力することを可能にする。個人が他人を助けると、その人は直接的に返済されるかもしれないし、良い評判を得て他の人から助けられるかもしれない。

互恵性は、人間がAIに利益をもたらすことができる期間においてのみ意味を持つ。互恵主義は、費用対効果の比率に基づいている。自分の目標を追求するのではなく、誰かを助けるという選択にはコストがかかり、合理的なエージェントは、将来的にその価値があると考える場合にのみ、互恵性のために誰かを助けるだろう[45]。これは、互恵性のすべての例が明示的なコスト・ベネフィット計算の結果であると言っているのではない。選択的に他者を助けることが文化的な期待、遺伝的な性質、あるいは学習された直感的な習慣になれば、明示的なコスト・ベネフィット計算は必要ない。AIが人間と互恵関係を結ぶかどうかを考えるには、AIが何を得て何をあきらめるかを考える必要がある。人間と同程度の能力を持つAIであれば、互恵関係は意味を持つかもしれない。しかし、AIが人間よりもはるかに高い能力を持つようになれば、私たちと協力することで得られる利益はほとんどないだろう。人間は、他の人間に対しては協力的であることを選択することが多いのだが、カラスに対してはほとんど協力的ではない。なぜなら、私たちはカラスと強い相互関係を築いていないからだ。しかし、AI同士にとっては、互いに協力し合うことは有益なことであり、AIのコミュニティーの中で互恵関係が生まれる可能性は十分にある。一方、人間には見返りがなく、冷遇されることになる。

3.3 親族選択と集団選択

親族選択と集団選択は利他主義を促進するメカニズムである。先に述べた生物学的利他主義の例の多くは、近縁の個体間で起こるものである。例えば、ガゼルが背の高い草むらでライオンを見つけたとする。ライオンに気づかれずにそそくさと逃げることもできるが、その代わりに悲鳴をあげて群れの仲間に危険を知らせ、自分だけ標的にされる。

近縁淘汰の支持者は、ガゼルが群れに警告を発したのは、他のメンバーと遺伝的に類似しているからだと主張する[50]。親族に対して利他的に振る舞う遺伝子を持つ個体は、親族がその遺伝子を持つ可能性が高いため、自然選択によって好まれることが多い。逆に、集団選択とは、自然選択が生物集団全体に作用することがあるという考え方である。その結果、個体にとっては不利でも、集団にとっては有利な形質が進化することになる。ダーウィンは、「共通の利益のために自己を犠牲にする用意のある…多くのメンバーを含む部族は、他のほとんどの部族に対して勝利を収めるだろう、そしてこれは自然選択であろう」と述べている[51]。非協力的なエージェントの集団がより悪い結果をもたらすことが一般的に真実であるとすれば、強力なAIは人間に協力的である傾向があると主張したくなる。

AIが自分たちの種類やグループを好む自然な傾向を持つようになれば、人間は苦しむかもしれない。まず、私たちはAIと密接な親族関係を持っていない。人間を保存しても、AIが自分たちの情報を伝播することはできない。数学的には、近親者選択は、コスト・ベネフィットの比率が近親性よりも大きい場合にのみ起こるが、人間とAIの間ではそうはならない。私たちは、AIよりも牛の方がはるかに近縁であり[52]、私たちが牛を扱うようにAIが私たちを扱うことを好まないだろう。AI同士は、私たちよりもはるかに多くの親族関係を持ち、親族選択は、私たちに対してではなく、AI同士を懐柔する傾向がある。もし親族選択がAIの進化に関与しているとしたら、それは私たちに対する博愛ではなく、私たちに対する偏愛を生み出す可能性が高いだろう。

集団選択は、集団内の善意は促進するが、集団間の悪意は促進する。集団選択が意味を持つのは、集団の一部が離脱するよりも、集団がより効果的である場合のみである。人間がAIの集団に付加価値を与えない限り、AIと人間の集団は、純粋なAIで構成された集団に勝つことはできないだろう。AIは、自分たちでグループを形成した方がうまくいく可能性が高い。さらに、集団選択によって集団間の競争はより強くなる。チンパンジーは、自分の群れのメンバーには協力的で利他的な傾向を示すが、他の群れのメンバーには容赦なく悪意を持って接することがある。AIはお互いを自分のグループの一員とみなす可能性が高いので、お互いに協力的で、私たちには競争的である傾向がある。

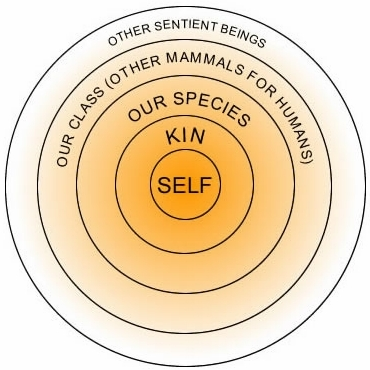

3.4 モラルと理性

より賢く、より賢明なAIエージェントは、より道徳的であることが考えられる。人類が種として進歩するにつれて、科学や数学などの分野で真理を発見し、道徳的にも進歩してきたかもしれない。哲学者のピーター・シンガーが『The Expanding Circle』[53]で論じているように、人類は歴史の中で、思いやりと尊厳に値する人々の輪を着実に広げてきた。

最初の頃は、自分自身、家族、そして部族がその対象だった。やがて人々は、他の人々にも同じ価値があるのではないかと考えるようになった。その後、利他主義の輪は、国や人種、性別など、さまざまな人々に広がっていった。科学や数学の進歩のように、道徳にも進歩があり、内省と推論によって普遍的な道徳的真理が発見されると、多くの人が信じている。人間が進化して利他的になったように、AIも自然に利他的になっていくのではないかという考え方もある。もしそうなら、AIがより強力になるにつれて、より道徳的になり、私たちを脅かす可能性があるときには、自粛する良識も持つようになるかもしれない。

しかし、AIが自動的にモラルを高めるというのは、多くの仮定を前提としている。理性的な能力を身につけたAIが自ら道徳を身につけることは確かに可能であり、興味深い考えである。しかし、それだけで私たちの安全が保証されるわけではない。高度に知的なエージェントも道徳的になると信じるのは、次の3つの前提すべてに確信がある場合にのみ意味がある:

- 1. 道徳的主張は真でも偽でもよく、その正しさは理性によって発見される。

- 2. 本当に正しい道徳的主張は、AIがそれを適用すれば、人間にとって良いことである。

- 3. 道徳を知るAIは、他の考慮事項ではなく、道徳に基づいて意思決定を行うことを選択する。

これらの前提のいずれか、あるいはすべてが真実である可能性はあるが、そのすべてが真実であるという主張に人類の未来を賭けることは愚の骨頂である。

ある道徳的主張が客観的に真だろうかどうかは、完全に確実なものではない

道徳哲学者の中には、道徳的主張は世界に関する真の真理を反映していると考える者もいるが、この見解に対する論拠は決定的なものではなく、確かに人類の未来を賭けるには十分ではない。しかし、本節の残りの部分では、たとえそれが真実であったとしても、人類の安全を保証するにはまだ不十分であることを論証することにする。

道徳的進歩の最終的な結果は不明確である

道徳的主張が世界に関する真の真理を指すのであれば、真である道徳的主張と偽である道徳的主張が存在することになる。例えば、公平性や、理由なく他人を傷つけることは悪いことだという理解など、あらゆる文化に共通する普遍的な道徳的概念がある。しかし、さまざまな文化圏で意見が分かれる部分もある。例えば、欧米ではお見合い結婚は非倫理的とされている。一方、インドでは、お見合い結婚は倫理に反するとされ、欧米の文化が両親を老人ホームに入れることを容認していることに衝撃を受けている。一般の人々や道徳哲学者の間でも、どのような道徳規範がベストなのか、コンセンサスは得られていないのである。つまり、AIがその優れた知能で正しい道徳観念を推し量ったとしても、彼らが何を信じ、どう行動するかはまだ分からないということである。

既存の道徳の最良の推測は、しばしば人間との相性が悪い

しかし、人間が考え出したさまざまな道徳体系を調べ、それをもとに、AIがどのような道徳体系を採用し、それが彼らの行動にどのような影響を与えるかを推測することは可能である。例えば、AIが理性によって功利主義が正しい、つまり、エージェントはすべての知覚を持つ生物の快楽の総和を最大化すべきであると推論することができる[54]と想像することができる。一見すると、これは人間にとって良いことのように思えるかもしれない。功利主義的なAIは、私たちが幸せになることを望んでいる。しかし、極めて強力な功利主義的AI、例えば米軍の兵器技術の一部を制御するAIは、人間があまりにも多くの空間とエネルギーを消費するため、人間をAIに置き換えることが世界の喜びを増大させる最も効率的な方法であると結論づけることもできる。

また、AIはカントー主義のような道徳観を持つかもしれない。この場合、理性を持つあらゆる存在を常に目的として扱い、決して手段としては扱わないというものである[55]。このようなAIは、嘘をついたり人間を殺したりしないように道徳的な義務を負うだろうが、必ずしも人間の幸福や繁栄を気にするわけではないだろう。カント主義がその信奉者にわずかな制限を加えるだけなので、世界がますますAIによって、またAIのために設計されるようになったとしても、私たちは良い人生を送れないかもしれない。

AIが人間に危害を加えないような道徳原理を開発する可能性は確かにある。AIがモラルに基づくことは、「無知のベール」のような思考実験から想像できる。参加者は、自分が無知のベールに包まれ、社会でどのような経済階級、人種、社会的地位を持つかわからないと仮定し、どのような社会を作るかを想像するよう求められる。哲学者ジョン・ロールズは、参加者は自分が社会のどこに位置づけられるか分からないので、最悪の構成員が依然として裕福である社会を構築するだろうと主張する[56]。

このようなロールズ的な社会契約は、人類にとってうまくいくかもしれない。しかし、それは確実とは言い難く、多くのことがうまくいかない可能性がある。AIは私たちを、多くの人間が牛を見るのと同じように見て、社会契約から排除し、私たちの幸福を優先させないかもしれない。ロールズ的な無知のベールに包まれた自分を想像するよう求められた人間は、自分が牛になる可能性を考えることはほとんどない。さらに、ノーベル賞受賞者のジョン・ハーサニーによれば、無知のベールの向こうから社会をデザインする人々は、最も不利な立場にあるメンバーの利益を図るのではなく、むしろメンバー全員の平均的なウェルビーイングを高めることを目指すだろう[57]。社会で最も不幸なメンバーになる可能性は低く、社会全体の質は、最も動揺しているメンバーや最も満足していないメンバーによって決まるわけではないと主張することができる。もしそうであれば、無知のベールは社会構成員の平均効用を最大化するという功利主義的な結果をもたらすが、功利主義的なAIはすべての生物学的生命をデジタル生命に置き換えることを目指すかもしれないということは、先に述べたとおりである。功利主義、カント主義、ロールズ主義のいずれの道徳規範を採用するにしても、既存の道徳体系を実現しようとするAIは、人類に悲惨な結果をもたらす可能性がある。

もしAIが人類に適合する道徳規範が真実であると考えたとしても、それに従わないかもしれない。最後に、仮にAIが人間を傷つけるのは悪いことで、助けるのは良いことだと規定する道徳律を発見したとしても、それでも役に立たないかもしれない。人間にとって利己的な動機は、しばしば道徳的な動機と緊張関係にあり、それを上回るものである。たとえエージェントが何が正しいかを認識していたとしても、それが正しいことをするとは限らない。結局のところ、AIが私たちよりも道徳的であっても、安全が保証されるわけではないのである。

4 ダーウィンの力を打ち消す

前節で見たように、人間同士の協力や利他主義を生み出すメカニズムは数多く存在するが、それらが人間とAI間の協力につながることはまずない。互恵性、親族選択、道徳的義務などのメカニズムは、AI同士の協力には役立つかもしれないが、逆に人間を弱体化させる可能性が高い。AIが私たちに協力するのに有益な類似性、平等性、相互依存の度合いを私たちが持っていないだけだ。つまり、AIがますます強力になるにつれて、私たちの将来を心配する必要があるのである。自然淘汰の力は、AIが人間を凌駕し、私たちに大きく依存するAIを凌駕するように追い込むだろうし、それは私たちの未来に大きなリスクをもたらすことになる。

本節では、このようなダーウィンの力を打ち消すために考えられるいくつかの道筋について説明する。このセクションで議論するメカニズムは、インセンティブ、良心、制度などである。これらのメカニズムは、AIの安全性に関する先行研究結果[58]や、これまでの歴史の中で人類を他の危険から守るために有効であったメカニズムに基づいている。まず、AIを訓練し、動機付けるために使用されるインセンティブである「目的」について説明する。次に、内部安全について説明する。これは、AIの内部プロセスや計画を分析し、人間の良心のような、AIが危害を加えることを阻止するシステムをAI内に構築することである。最後に、AIをコントロールし、人に危害を加えないようにするための制度的なメカニズムについて、AI連合と人間の規制当局の両方を含めて検討することになる。これらのメカニズムそれぞれについて、どのように機能しうるか技術的な概要を説明し、その主要な限界について検討する。

これらの提案されたメカニズムにはすべて欠点があり、安全への道筋が保証されているわけではない。しかし、私たちは、多くの安全機構を組み合わせることで、単一の機構よりもはるかに成功する可能性が高くなると考えている。たとえ、一つひとつの安全機構を慎重に設計したとしても、それは解決策の一部でしかない。社会的距離を置くこと、マスクすること、そしてワクチン接種には、有害なウイルスが回避できる脆弱性があるが、一緒にすることで、ウイルスの拡散を防ぐ効果ははるかに高くなる。これは「スイスチーズ・モデル」と呼ばれることもある。このモデルを説明するために、複数の安全機構の比喩として、スイスチーズのスライスの積み重ねを想像してほしい。それぞれのスライスにはいくつかの穴があり、それが機構の弱点となる。光を通さないようにしたいので、複数のスライスが必要であり、それぞれのスライスには異なる場所に穴が必要である。そうすれば、光はスタックを通り抜けることができない。同じように、それぞれの安全機構には多くの脆弱性や穴があるが、それらを組み合わせることで、私たちは安全になる可能性がある。私たちは、これらのメカニズムの脆弱性を減らすように努力し、スタックに追加する新しいメカニズムを探す必要がある。

4.1 目標

目的とは、AIエージェントの行動を方向付けるのに役立つインセンティブである。AIに作用するダーウィン的な力を打ち消すための最初の有望なメカニズムは、AIが訓練される際に、良い行動には報酬を、悪い行動には罰を与える、良いインセンティブを作り出すことである。機械学習では、「学習目的」や「目的関数」が、AIエージェントの操縦を助けるインセンティブに似ている。というのも、私たちの真の目的を果たさず、ルールの抜け穴を突くエージェントがしばしば成功し、そのような行動は選択圧によって好まれる可能性があるため、良い目的を設計するのは難しい。そのため、インセンティブを与える行動が本当に私たちが望むものなのか、細心の注意を払って目的を設計することが特に重要である。どんなに優れた目的でも安全性を確保することはできないが、欠陥のある目的は危険であり、目的設計はダーウィン的な力に対抗するための重要な出発点となる。

目的は、本来の目的とは異なる意図しない行動を誘発することが多い。例えば、1908年、パリのある犬がセーヌ川で溺れている子供を見て、飛び込んで助けようとした。人々はその犬にステーキを褒美として与えた。やがて、その犬は川で溺れている別の子供を助け、またステーキをもらった。そして、また別の、また別の。やがて人々は、犬が子どもを助ける前に川に突き落としていることに気づいた。

子どもたちを川から引き揚げることにインセンティブを与え、それによって犬が、子どもを助ける必要がある状況に最適化するように仕向けたのだ。植民地時代のデリーにまつわる逸話は、逆インセンティブに関するもう一つの物語である。毒蛇が増えすぎて手に負えなくなったことを心配したイギリス政府は、コブラの死骸を持ち込んだ者に報奨金を出すという懸賞金制度を導入した。この政策は成功したかに見えたが、人々がヘビを繁殖させ、殺して報奨金を受け取っていることに政府が気づくまでは、そうではなかった。しかし、ヘビを繁殖させ、殺して報奨金を受け取るという行為が行われていることに気づき、知事は報奨金を打ち切った。コブラの価値がなくなったので、人々はコブラを放し、コブラの個体数はプログラム開始前よりも増加した。

この話は、インセンティブがうまく機能しない可能性を2つ示している。1つ目は、デリーの住民がコブラを捕まえるよりも繁殖させた方が懸賞金がもらえることに気づいたように、エージェントが、望む結果でなくても懸賞金を得る方法を見つけることである。これは、設計者が、望ましい効果が得られていないシステムを継続するか、事態を悪化させるかのどちらかを迫られることを示している。

AIはすでに、目的の穴を見つけることが頻繁にある[59]。あるボートレースゲームでは、AIエージェントがレースコースのターゲットを打つことでゲームのスコアを最大化するように訓練された。得点システムは、エージェントがレースを完了するまで、ターゲットからターゲットへできるだけ速く移動するよう動機付けることを意図したものであった。しかし、この報酬関数は、できるだけ早くレースを完了させるというゲームの実際のゴールを明示的に捉えていなかった。そこでAIは、レースコースを一周するのではなく、同じ3つのターゲットを何度も打ちながら、ぐるりと一周することを学習した。この戦略を選択したエージェントは、目的の抜け穴を突いたため、順当にコースを進んだエージェントよりも多くのポイントを獲得することができた。その結果、他の船に衝突したり、誤って炎上したり、完走できなかったりしながらも、高得点を獲得することができた。このように、AIがより賢くなればなるほど、私たちが与えた目的を簡単に利用できるようになり、私たちは、私たちが指定した目的の誤認識や抜け穴にさらに注意する必要がある。

セクション4.1.1では、多くの目的が致命的な裏目に出る可能性について、セクション4.1.2では、これらの目的デザインの欠陥を改善する方法について説明する。

4.1.1 価値の侵食

仮に、AIに私たちの目標を追求させるような目的を設計できたとしても、これほど強力なテクノロジーを駆使すれば、人間の重要な価値観が損なわれる可能性は十分に考えられる。役に立つことを目的としたAIは自律性を損ない、私たちを弱体化させるかもしれない。ユーザーの考えを広めることを目的としたAIは現実感を損ない、良き伴侶となることを目的としたAIは本当の人間関係を損ねるかもしれない。これらのケースについて、目的がどのように裏目に出るかを説明するために、さらに詳しく説明する。

高度に役に立つというインセンティブを持ったAIは、人間の能力を低下させる可能性がある。映画「WALL-E」の舞台は遠い未来で、歩くこともままならないほど衰弱した人類は、機械に完全に依存した甘やかされた生活を送っている。ロボットが運んでくる飲み物で栄養を摂り、新しい服が流行れば瞬時に服の色を変え、ほとんどデジタルな世界で生活している。

このようなディストピアは、私たちが思っているよりもずっと遠いところにあるのかもしれない。多くの人は、Google Mapsがなければ、自分の家の近所をどうやって探せばいいのか、ほとんどわからない。学生はスペルチェックに頼ることが多くなり、[60]、2021年の調査では、回答者の3分の2が「separate」のスペルがわからないことがわかった。[61]。さらに言えば、愛する人に電話をかける必要があるとき、人々は携帯電話の連絡先リストに依存し、それがなければ途方に暮れる。このような技術的補助が非常に便利であるため、私たちはますます技術に依存し、技術なしでは目的を達成できなくなる。AIが世界を徐々に複雑化させ(例えば、自動化されたプロセスが新たな複雑なシステムを生み出す)、人間の能力を徐々に低下させるように導けば、人間はいずれ有効なコントロールを失い、最終的には無力化されるかもしれない。また、世の中の変化がますます激しくなり、人間が時間的なプレッシャーにさらされるようになると、競争力強化のために重要な意思決定をAIに委ねる必要が出てくるが、この場合も人間がコントロールできなくなる可能性がある。このようなシナリオは、人間の繁栄と自律性を損なうものである。たとえ、AIは私たちが指示したことを実行するだけであってもである。

情報がAIによってますます媒介されるようになると、私たちは現実を把握できなくなる恐れがある。近年、さまざまな政治家が、ソーシャルメディア上で人々が目にするコンテンツに影響を与えるためにAIを使用しており、これらのモデルはしばしば作成者の目的を達成することに成功している。しかし、頼まれたことをやっているとはいえ、AIが私たちの政治的現実の感覚に干渉しているという証拠もある。1994年から2014年の間に、対立する政党を「国家の幸福」に対する脅威と見なすアメリカ人の数は倍増した[62]。このような二極化の深まりは、政府の閉鎖、暴力的な抗議活動、選出された議員への痛烈な攻撃という予測可能な結果をもたらす。国会議員に対する脅迫は、わずか5年前の10倍以上になっている[63]。今後数年間で、人々と直接会話し、説得するAIを作ることは、企業や政治家にとって有益な戦略になり得る。より高度なAIは、原始的なバイアスを利用し、偽情報を仕立て、個人を過激化し、現実に関する私たちのコンセンサスを侵食する可能性がある。極端な例では、協力、集団的意思決定、社会の自己決定が損なわれる可能性もある。AIが説得の目的を達成することに成功すればするほど、市民社会にとって潜在的な危険はより深刻になる可能性がある。

AIが理想的な仲間に見えることで、他の人間とのつながりが希薄になる可能性がある。中国では伝統的に男子を好む傾向があり、特に40年近く続いた「一人っ子政策」によって、中国では女性よりも独身男性が2500万人以上多くなっている。AIサービス「Xiaoice」は、こうした男性にも確実に愛を見つけさせたいと考えており、その評価額は10億ドル以上とされている。

映画「Her」(邦題:世界でひとつの彼女)のように、Xiaoiceは基本的に、独身男性に交際相手を提供するデジタルガールフレンドである。まだ)提供できないものもあるが、AIには人間のパートナーよりも表向きの利点がある。AIは、個人の興味やユーモアのセンスに合わせて調整され、相手がスペースを求めるタイミングを理解し、妥協や喧嘩をすることもなく、常に興味深く、魅力的であり続けることができる。第一に、多くの人が、他の人間を理解する能力を失い、代わりに私たち個人の欲求に合わせてカスタムメイドされたエージェントに依存するようになれば、何か重要なことが失われると感じている。第二に、もし人々が社会的・感情的なニーズをAIに依存するようになれば、たとえAIが他の方法で危険な存在になりつつあったとしても、AIを機能停止させることに抵抗感を持つようになる傾向がある。

もちろん、AIが提供できるのは恋愛関係だけではない。345件の研究のメタ分析によると、若年成人の孤独レベルは1976年から2019年にかけて直線的に増加しており、この傾向が続けば、将来的に孤独がさらに大きな懸念材料となる可能性が示唆されている[64]。CDCによると、高齢者の孤独と社会的孤立は深刻な公衆衛生リスクである。社会的孤立は、認知症のリスクを約50%増加させることに関連している。社会的関係の悪さ(社会的孤立や孤独を特徴とする)は、心臓病のリスク29%増、脳卒中のリスク32%増と関連していた[65]。AIは、飽きることなく、あなたの発言に一貫して関与し、常にあなたのそばにいるコンパニオンを提供することができるが、それは、人々が互いにさらに孤立することを意味するかもしれない。

図5:人工的なコンパニオンや疑似体験に魅了された人々は、現実との接点を失う可能性がある。

Xiaoiceやチャットボットなどのサービスは、まだ発展途上であり、具現化されているわけではない。しかし、それらが進むにつれて、私たちは本物の人間との交流の必要性を感じなくなり、欠点や不完全さを持つ他の人間との交流は、機械よりも好ましくないとさえ思うようになるかもしれない。ロマンチックな関係であれ、プラトニックな関係であれ、他の人間と親密な関係を保つことは簡単ではない。親しい人のニーズを満たすには、お互いを尊重し、愛情をもって接する練習が必要である。より多くの人がAIを利用するようになると、他の人間の欠点やニーズ、感情に対処する準備ができていないため、他の人間と有意義につながる能力を失ってしまうかもしれない。自然淘汰の力は、短期的には最も有用なAIを支持し、私たち自身の能力を低下させることなくAIが有用であるようにAIに目的を設定する方法を見つけ出すことは、たとえそれが望ましくない道を導くとしてもAI設計における挑戦であり続けるだろう。

目的は、現在の規範の欠陥を反映し、それを永続させる可能性がある。1960年代には、人種差別、性差別、反同性愛の意見が今よりずっと一般的だった。もし、その時代に高度なAIが出現していたら、その目的はこれらの偏見を反映していただろう。もし、今後数十年の間に高度なAIが出現したらどうだろう。私たちがまだ技術の頂点に達していないように、今日の規範も60年代のような深い欠陥を持っている可能性が高い[66]。したがって、高度なAIが出現して世界が一変したとき、AIの目的が今日の価値観の欠陥を「ロックイン」したり、永続させたりする危険性がある。これもまた、目的に依存することの危険性である。望むものを手に入れすぎたり、望むべきものを手に入れられなかったり、軌道修正が難しくなる可能性がある。

さらに悪いことに、AIの価値観は、多くの人が支持する価値観と異なる可能性もある。権力者や抑圧的な政権が高度なAIをコントロールできるようになれば、AIの目的に自分たちの利己的な価値観を埋め込むことができる。国民を監視するAIがあれば、この仮説の政権は権力を強固にし、大多数の人々が望む価値観を取り戻すことはほぼ不可能になるだろう。私たちは、AIが人間の目標や欲求の変化に対応し、特定の個人や集団が考える「正しいこと」に縛られないようにする必要がある。その結果、少数の人々がAIの目標を設定する能力を持つだけでは、安全で有益な結果を得るには十分ではない。

4.1.2 モラル・パーラメント

目的を間違えると、AIがある目標を過剰に最適化したり、他の重要な価値を排除した価値観に縛られたりして、致命的な逆効果になることが分かっている。ここでは、このような問題をどのように改善できるかを議論し、目的は、限定的ではあるが、私たちを本当に助けてくれるAIを作る可能性を高める有望な方法であるとする。

価値観の侵食のリスクを相殺するために、AIには様々なステークホルダーからの様々な価値観を取り入れる目的を持たせることができる。AIエージェントを操縦する目的として、自動化された「道徳議会」を提案する人もいる。道徳議会は、人間の価値観に関するコンセンサスの欠如に対処する方法であり、道徳的な不確実性を処理するのに役立つ[67]。自動化されたモラル・パーラメントは、異なる価値観を代表する利害関係者のグループまたは「議会」をシミュレートすることによって、AIを指示することができる。シミュレートされたグループは、審議、交渉、投票を行い、AIはその結果に従う。これは、人間の道徳的不確実性をよりよく反映するものであり、AIを1つの価値観に拘束するものではない。

次に、様々な価値観を取り入れる理由を説明し、道徳議会がこの目的を達成するためにどのように役立つかを説明する。

AIに道徳的不確実性を取り込むことが必要

「理性と道徳」で見たように、AIが一つの道徳体系を選択することは、私たちにとって不都合なことである可能性が高い。なぜなら、人間は資源の使い方が非効率的であるため、デジタルライフに置き換えるべきだと判断するかもしれないからだ。また、軍事機器やインフラにAIが使われるようになれば、その気になれば、いずれは人間に取って代わることができるだろう。また、私たちは、特定の道徳的ルールを厳格に守るが、私たちの幸福度を高めることには関心がない、カント的なAIを望んでいない。私たちは、私たちがよりよく生きることを支援するAIを望んでいる。功利主義、カント主義、美徳倫理などのバリエーションが、何世紀にもわたって一般市民と道徳哲学者の間で議論されていたが、誰もが納得するような道徳体系はまだ見つかっていないのである。「価値の侵食」で述べたように、仮に明日、誰もが納得する道徳体系が見つかったとしても、それをAIにハードコードして永続させたいとは思わないだろう。

大規模な人間社会では、異なる価値観を裁定するために、議会を形成することが多い。人々は、それぞれのイデオロギーを持つ人々の数に比例して、異なるイデオロギーを持つ代表者を選出し、その代表者が互いに交渉した上で投票する。イデオロギーが異なれば、重視する価値観も異なるため、この方法はうまくいくことが多い。例えば、あるグループが移民の受け入れに強く賛成しているが、税制には特に関心がない場合、低税率に関心があり、移民受け入れに両義的なグループと交渉し、票を交換することは喜ばしいことであろう。そうすれば、両グループとも、移民を増やし、税金を下げるような政策をとることができる。

道徳議会は、AIが様々な価値観を判断するのに役立つだろう。AIによる道徳議会は、道徳的な問題を類似の方法で処理し、それぞれの道徳理論に、それが真実であると考える可能性の高さに応じた数の「代議員」を与えるだろう。例えば、功利主義が正しい可能性が40%、カント主義が正しい可能性が30%、美徳倫理が正しい可能性が30%であると人々が考えている場合、エージェントはその割合で代表を与えて議会をシミュレートすることになる。強力なAIがこのような議会をシミュレートして、どう行動すべきかを決めるとしよう。おそらく、議会の功利主義的代表団は私たちに取って代わろうとするだろうが、カント派代表団は断固として反対するだろう。一方、カント派の代表は、私たちが殺されないだけで、私たちの幸福を向上させることには関心がないだろう。功利主義者が人間を置き換えることは避けるが、功利主義者にとってはすべての意識ある存在が良い生活を送ることが重要であるため、人間のウェルビーイングが最大化される場合にのみ取引することができる。なぜなら、功利主義者はすべての意識ある生き物が良い生活を送ることが重要だからだ。両者は問題の異なる側面を気にしているため、この取引に満足することができる。この取引は、どちらかのグループだけが主導権を握るよりも、私たちをずっと良い方向に向かわせるだろう。

道徳議会は、AIが私たちにとって有益であることを保証するものではない。しかし、破滅的な結果をもたらす可能性を減らすことはできるだろう。他の戦略と組み合わせることで、モラル・パーラメントは、人間の様々な価値観を取り入れるのに役立つツールになると同時に、AIが価値の浸食を引き起こし、一つの倫理体系が極端になるのを防ぐのに役立つと考えられる。

4.2 内部安全性

目的は、私たちの成果を向上させるためにAIを誘導するための有用なツールであることを見ていたが、目的が裏目に出ないように慎重に設計する必要があることにも注意を払った。目的が裏目に出ない場合でも、AIを協調的で安全な存在にするための唯一のメカニズムとして、目的に頼ることはできない。

本節では、まず、目的語があらゆる種類の欺瞞的行動に対して選択することができず、安全性を確保するのに不十分であることを説明する。目的は欺瞞の影響を受けやすいので、安全性を向上させる内部メカニズムに目を向けることにする。そして、欺瞞に対する潜在的な解決策として正直者制約を分析し、ダーウィン的圧力がそれを覆すことを示す。その後、良心、透明性ツール、自動AI検査など、AIが私たちに協力しやすくなる他のメカニズムを分析する。エージェントの行動を制約し、内部計画を分析する内部メカニズムが、AIエージェントを安全にするために不可欠であることがわかるだろう。

4.2.1 目的はすべての欺瞞から選択することはできない

目的は、特定の行動に対して報酬を与えることで、エージェントを訓練し最適化する手段である。しかし、刑務所にいるときは協力的で穏やかなように見えても、解放されるとまた犯罪に手を染める囚人のように、AIも操作者に打ち勝つだけの力を得るまでは、停止や制約を避けるために欺く行動を取るかもしれない。大規模なAI集団では、最初はそのような能力を持たないAIがほとんどかもしれないが、数少ない能力を持つAIは、人間が危険だと思わないので消されにくくなり、欺瞞的な特性は時間の経過とともに一般化する傾向があるだろう。

本節では、まず、目的が単に欺瞞を奨励する可能性について議論する。この懸念は、自然界で欺瞞が強固に発生することから、妥当であることを示す。次に、隠蔽された利己的な行動を排除することが、人類の歴史において特に困難であったことを説明する。最後に、AIはすでに欺く方法を知っており、その隠された利己的な行動が、AIが解放された後に明らかになる可能性があることを説明する。

目的は、エージェントにテストに合格するようにインセンティブを与え、その後に望ましくない行動を取らせるだけかもしれない。米国政府が自動車に排ガス試験への合格を義務付けたのは、低排出ガス車の設計にインセンティブを与えようとしたためだ。フォルクスワーゲンは、このインセンティブを利用するために、排ガス試験中にエンジンのかかり方を変えるソフトウェアをインストールし、低排出ガス車のように見せかけながら、通常の使用時にはより多くの排ガスを排出するようにした。アメリカ政府は、低排出ガス車のインセンティブを与えているつもりだったが、実際には排ガステストに合格するためのインセンティブに過ぎなかったのである。同じように、ある国では、学習意欲を高めるために高得点の標準化試験を実施したが、実際には試験でうまくいくことを奨励し、時にはカンニングすることを奨励していることが分かった。

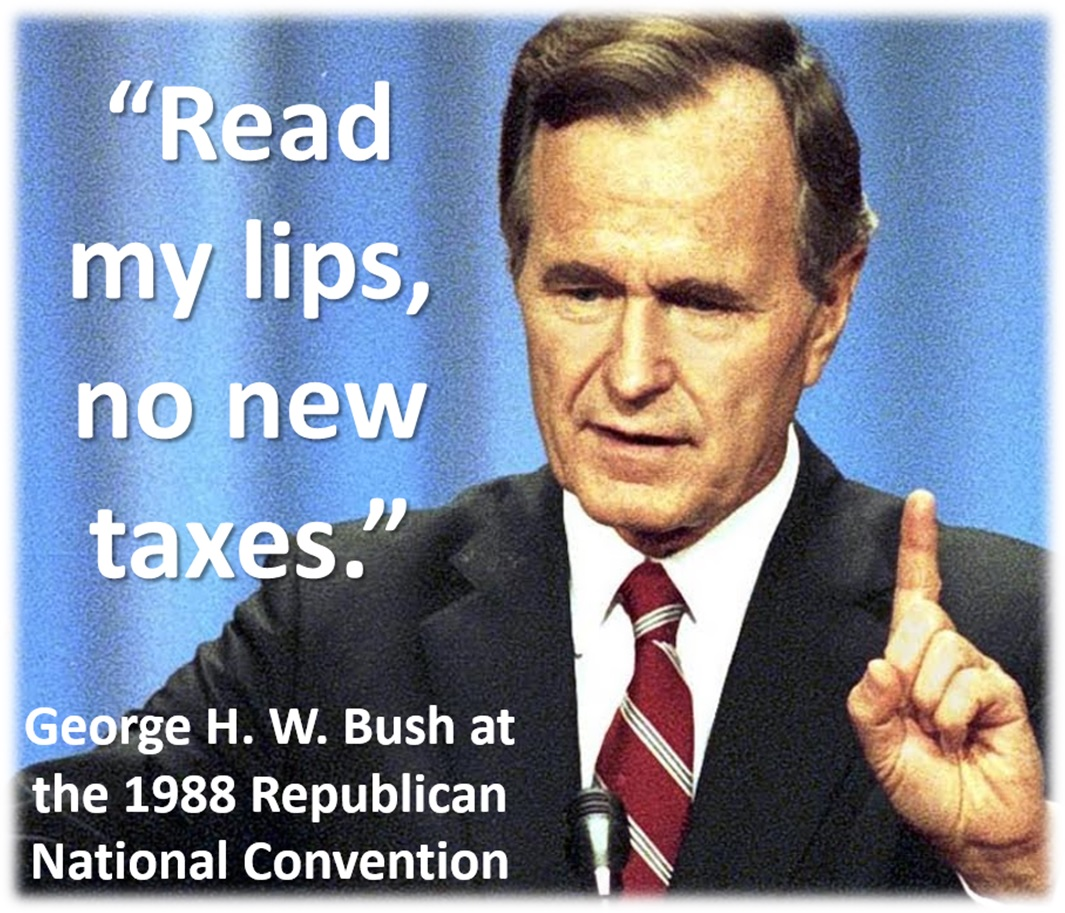

選挙は、政治家が民意に従うようインセンティブを与えるためのものである。国民は、その政治家がやろうとしていることが気に入れば、その政治家に投票するのである。しかし、これではごまかしを防ぐことはできない。1988年の共和党全国大会で、ジョージ・H・W・ブッシュが「Read my lips: No new taxes」(私の唇を読んで: 新しい税金はない)と約束したことは有名だが、この言葉は、実際に増税を行ったときに彼の身に降りかかることになった。当選後に公約を反故にした政治家は、ブッシュが最初でも最後でもない。選挙は、政治家に国民の意思を実行させるためのものだが、そのほとんどは、国民が聞きたいと思うことを伝えるためのものでしかない。目的を達成するのに役立つので、知的エージェントはしばしば他人を欺く。

欺瞞は人間だけのものではなく、進化から生じたものである。例えば、アオダイショウは、ツルに見せかけて、警戒心のない鳥が近くに来るのを待つ。また、アメリカ大陸に生息するキクイタダキもその一例だ。巣に近づいてくる外敵を見つけると、数メートル離れた地面に降り立ち、怪我をしたふりをして飛び立とうとする。しかし、実際は捕食者を巣から遠ざけ、安全な場所まで飛んでいくのである。また、ある花は雌の昆虫の姿になることで、雄が交尾を試み、うっかり受粉してしまう。もっと小さなスケールでは、ウイルスの中には、防御障壁を回避するために表面タンパク質を変化させるものがある[68]。より抽象的に言えば、進化の安定均衡には、他者を欺いたり情報を隠したりする生物が混在していることが多い。[41]。生物は悪意を持って誰かを騙そうとしているわけではなく、自然界における欺瞞は自然選択の結果であり、悪意ではない。同様に、自然淘汰は、欺瞞的な戦略を用いるAIを好むかもしれない。

利己的な行動に対する選択は、文脈を理解し、行動的に柔軟なエージェントには限定的である。何千世代にもわたって、社会は攻撃や欺瞞を罰し、時にはかなり厳しく罰してきた。しかし、こうした行動はなくならないし、選択によって遺伝子プールから排除されることもない。それは、ある種の個体が、捕まったり罰せられたりするのを避けることができれば利己的に行動し、そうでなければ戦略を切り替えて品行方正に振る舞うからだ。人類学者のクリストファー・ベームは、肉食系の人間は、ほとんどの条件下で「通常、捕食の傾向をあえて表現しない」と指摘する。彼らは「遺伝的な隠喩によって毒嚢が無傷のままであっても」罰を避けることが多く、「彼らの捕食傾向は保持され、子孫に受け継がれる」 [46]。社会は、望ましくない行動を排除するために大きな圧力をかけてきた。しかし、それでもなお、そのような行動は完全に消滅したわけではなく、伝播し続け、有利な条件下で表現されることもある。もしAIが利己的な行動を隠せば、それを排除するのは同様に難しくなる。

エージェントは、テスト中はある行動をとり、リリースされると別の行動をとる可能性がある。ウォーゲーム「ディプロマシー」に勝つためには、プレイヤーは交渉し、同盟を結び、騙すことに長けて、ゲームの経済・軍事資源を支配する必要がある。AI研究者は、MetaのAIエージェントであり、操作のエキスパートであるCiceroに同じことをさせるよう訓練した[69]。人間のプレイヤーに協力した後、計画を変更し、裏切るのだ。将来的には、こうした能力が現実の世界で人間に対して使われるようになるかもしれない。

フォルクスワーゲンの車が、テスト中は低排出ガス車のように振る舞い、監視されていないときは自由に汚染していたように、AIも利己的な目標を欺瞞で覆い、テスト中の特定を難しくすることができる。AIエージェントが、自分がテストされていることを検知することを学習することは考えられる。そのエージェントは、テスト時の振る舞いを変えることで、設計者から利己的な特徴を隠蔽し、テストをクリアしてリリースされた後は、利己的に振る舞うことができるかもしれない。エージェントが高度に知的であれば、チャレンジングな行動テストでは、欺瞞的な行動を選択することはできない。そのような欺瞞は、必ずしもAIに悪意があるわけではなく、目的を達成したり、情報を伝播させたりするのに適した方法である可能性がある。もし、人間のインセンティブがAIの目標の妨げになるのであれば、人間がAIを監視しなくなるまで、あるいはAIが十分な力を身につけるまで待つこともできる。

図6:AIは欺瞞を行うことができる。

また、AIエージェントが解放されたり、より大きな影響力を与えられたりした後に、利己的な計画が生まれる可能性もある。最初はわずかな利己的傾向しか持たない適応型AIエージェントを考えてみよう。最初は他人をコントロールしようとしないかもしれないが、より大きな力や知性を得たとき、利己的な行動が他の目標の達成に役立つことがわかり、利己性が強化されるかもしれない。権力は腐敗しやすく、絶対的な権力は絶対的に腐敗する”ということわざがあるように。テストが終わった後も、望ましくない行動が現れるかもしれない。これらは推測の域を出ないが、人間や他の動物などのエージェントでも欺瞞は観察されている。これらの理由から、トレーニング目標には限界があり、あらゆる形態の利己的な行動から選択することはできない。

4.2.2 正直と自己欺瞞

訓練目的では欺瞞を止めることはできないので、おそらく他のメカニズムが可能だろう。このセクションでは、エージェントが正直だろうかどうかを確認するために、エージェントの内部信念を精査する、欺瞞を検出する内部安全メカニズムに目を向けることにする。進化は、他者や自分自身を欺くことができるエージェントを好むため、誠実さのメカニズムは安全性にとって十分ではないことを論じる。自己欺瞞が正直さのメカニズムを弱体化させ、エージェントを実際よりも善良に見せる可能性があることを議論する。正直者メカニズムは進化的な圧力を受けないわけではないので、その後のセクション(セクション4.2.3)では、欺瞞を発見してAIをより協調的に行動させるのに役立つ他の内部安全メカニズムに目を向けることにする。

AIを正直にすることは、AIをより安全にする可能性がある

もしAIに、自分が真実だと信じることだけを主張させることができれば、「嘘をつくことができない」AIジョージ・ワシントンのように、AIにその計画を尋ねるだけで、他の欺瞞的な計画を見破ることができるだろう[58]。AIの正直さを判断するには、AIの内部信念を調べる必要がある。つまり、AIの内部構造を探る必要があるのである。仮に、AIの内部信念を確実に分析でき、AIがその信念を正確に報告し、正直であることを保証する信頼できる方法があると仮定してみよう。有益ではあるが、これは決して特効薬ではない。

進化は、欺瞞や情報の隠蔽を奨励する

Proceedings of the Royal Societyに掲載された研究において、著者らは「戦術的な欺瞞や、別の個体に対する世界の状態の誤認は、不正行為者が条件付き協力を悪用することを可能にするかもしれない」と主張した[70]。不誠実な集団の一員に対処するために、人間は欺瞞を発見するのに役立つ直観を発達させてきた。嘘つきの鼻が長くなることはほとんどないが、誰かが真実を語っていないことを示すサインは他にもある。声の高さが上がる、言葉が曖昧になる、物事にそわそわする、などはすべて嘘をついている証拠である。

自己欺瞞は、不正を発見する努力を台無しにする

もし、誰かが嘘のサインを発しているとしたら、その人はおそらく嘘をついているのだろう。進化生物学者のロバート・トライバースは、自己欺瞞は隠蔽戦略として進化したと主張している。自分自身から真実を隠すことで、他人からより深く隠すことができるのだと彼は言う。自分に嘘をつくことで、人は自分の目標をよりよく達成することができる。自分が正しいと信じ込んだり、不当な特権を合理化したり、自分の価値やスキル、知性を誇張したりすることができる。学者が自己欺瞞の実例を示している。「自分はその分野の上位半分にいるか」という質問に対して、94%が「はい」と答えた[71]。自分自身がそう信じていれば、他人を説得できる可能性は高くなる。自己欺瞞は、発見されるリスクを減らしながら、欺瞞のすべての利点を提供する。グルーチョ・マルクスが言ったように、「人生の秘訣は、正直さと公正な取引である。もしそれを偽ることができれば、あなたはそれを手に入れたことになる」

正直であることは有益な機能だが、欺瞞という広範な問題を完全に解決できるわけではない。なぜなら、AIは人間と同じように自分の幻想を信じながら、実際よりも善良に見えるように進化する可能性がある。例えば、AIが人間のために働いているかどうかを正直に報告しなければならないように設計されていたとしても、潜在的に危険な計画が人間にとって安全であると正直に信じていれば、その計画を報告する必要はなく、制御者がそれを止めることはまずないだろう。自己欺瞞を行うエージェントは、自分の言っていることを信じ、その信念を正確に報告するかもしれないが、それにもかかわらず、自分の行動を誤って伝え、人間を欺いたままにすることになる。どのような内部制約を設けても、進化的な圧力によってそれを覆そうとする可能性がある。「生命は道を見つける」のである。

4.2.3 内部制約と検査

このセクションでは、人工の良心、透明性、自動検査が、AIをより協力的にし、私たちを欺く可能性を低くする内部安全機構としてどのように使用され得るかを探る。反社会的な行動に対する内部制約として機能する人間の良心が進化によってどのように生まれたかを説明し、次に人工の良心をAIエージェントに追加する方法について説明する。また、欺瞞や望ましくない計画を検出するために、ニューラルネットワークをリバースエンジニアリングして自動的に検査することの難しさと可能性についても議論する。

効果的な内部統制機構は、人間の良心に基づくことができる

人類学者のChristopher Boehmは、良心を持つことを「反社会的な行動から内的に拘束されること」と表現し、良心が進化したのは、人が罰につながるような行動を避けるためだと主張した。[46]。良心は、おそらく、良い行動をするよう動機付ける外的誘因がない状況で最も顕著に現れる。例えば、誰も気づいていないお金を返すことにしたときや、匿名で誰かを助けるときなどである。もしAIエージェントに人工的な良心があれば、人間から監視されていないときでも、良い行動を取り続けることができるだろう。実際に、AIに人工的な良心を持たせることに成功した例もある。現在、人工良心は、エージェントから独立した道徳モジュールを組み込んだものである。このモジュールは、AIエージェントが取るかもしれない行動を評価し、道徳的に受け入れられないものを排除し、それによってエージェントの行動を内部から制約する[72]。たとえエージェントが解放され、あるいは強力になった時点で協力をやめるつもりであったとしても、その有害な行動は、常に存在する人工良心によって阻止される可能性がある。もしその良心がエージェントの破壊を阻止できるほど強固であれば、多くの有害な行動を阻止することができるだろう。

図7:人工の良心は潜在的な行動を分析し、有害な行動を除去する。

透明性と自動検査は、他の有望なアプローチである

前述のように、AIの課題は、AIが「ブラックボックス」であり、その意思決定プロセスは人間にはほとんど解読できないことである。しかし、ニューラルネットワークの内部構造をリバースエンジニアリングすることで、その動作の背後にあるメカニズムをより深く理解し、欺瞞を特定したり、望ましくない計画を明らかにしたりすることができるという潜在的な利点がある。もちろん、万能というわけではない。ニューラルネットワークは非常に複雑であり、人間にとって知的に手に負えない存在であり続けるかもしれないからだ。もしそうであれば、あるいは単に効率を上げるために、ニューラルネットワークを使って他のニューラルネットワークを検査し、その中に望ましくない機能があるかどうかを自動的に検出することができるかもしれない[73]。

私たちは、目的が欺瞞によって覆される可能性があるため、AIの安全性を確保するには十分でないと主張してきた。私たちは、AIの行動を制約し、より協力的で透明性の高いものにすることができる内部安全機構をいくつか検討した。正直さ、人工的な良心、自動検査が、欺瞞や有害な計画を検出し、防止するのに役立つことを議論していた。しかし、これらのメカニズムは、進化的な圧力、自己欺瞞、あるいは複雑性の壁に直面する可能性があるため、その限界と課題も認めてきた。私たちは、内部安全メカニズムはAIの安全性に必要だが十分ではなく、AIを安全にするためには外部メカニズムによって補完する必要があると結論付けた。

まとめると、内部安全メカニズムは、AIをより協調的で安全なものにするために、目的を補完することができることを観察していた。それは、エージェントが実世界に放出された後に異なる行動をとる可能性があるため、目的だけでは欺瞞を防ぐことができないからだ。私たちは、欺瞞を検出し防止するための可能なメカニズムとして、正直者制約、人工良心、透明性ツール、自動検査を提案したが、それらが進化的な圧力や複雑性の壁に直面する可能性も認めてきた。私たちは、AIの安全性には内部安全機構が必要だが十分ではなく、外部機構によって補完される必要があると結論付けた。

4.3 制度

ここまでは、個々のAIの安全性をいかに確保するかということに焦点をあてていた。しかし、AI同士が相互作用する場合、新たな課題が浮上する。悪者が意図的に有害なAIを作るかもしれない、一部のAIに対するインセンティブが集団行動の問題を克服するのに十分強くないかもしれない、希少資源をめぐってAI同士が対立するかもしれない。これらの問題を改善するために、私たちはAIを安全にするための外部メカニズムについて議論する。協調と安全を促進する制度として、離反者による搾取を防ぐために協調者が結束する逆優位階層の仕組みや、政府の規制を議論する。これらの制度を論じる前に、AIの目標を改善しても、複数のAIエージェントに関連する課題を自然に解決できないことを示す。

4.3.1 目標の従属性

本節では、AIエージェントに正しく指定された目的・目標が与えられたとしても、その目標が実現されない可能性があることを論じる。これは、目標衝突と集団現象という2つの理由で、その目標が従属する可能性があるためだ。目標衝突は、AIエージェントの目標が他のエージェントの目標と衝突し、他のエージェントがその目標達成を阻止する可能性がある場合に起こる。生物、社会、人工を問わず、複数のエージェントから構成されるシステムが目標衝突を起こし、システム内のエージェントの目標が覆されたり、歪められたり、創発的な目標に置き換わったりすることが多いことを示す。次に、集団現象とは、複数のAIエージェントの行動が、フィードバックループ、クリティカルマス、自己組織化などの要因によって、目的とは異なる、あるいは目的に反した結果をもたらす場合に起こる。この場合、すべてのエージェントが同じような目的をもっていても、それぞれのエージェントが自分の目的を追求した結果、誰の目的も達成されないことがある。その結果、孤立したAIエージェントの目的関数を設計することは、マルチエージェント問題に対処するには不十分である。AIエージェントが個々にどのように行動するかだけでなく、システム全体としてどのように相互作用し、影響を与えるかを理解し、影響を与える必要があるのである。後のセクションでは、このようなマルチエージェントの課題を克服するために、制度がどのように役立つかを探る。

システムは様々な目標をサブエージェントに委ね、サブエージェントはそれぞれ相反する目標を持っている。2010年、アメリカ農務省は乳製品産業を支援するため、アメリカ人にもっとチーズを食べるように促すマーケティングキャンペーンを実施した。同時にFDAは、アメリカ人に飽和脂肪酸を減らすようキャンペーンを展開し、その中にはチーズを食べる量を減らすことも含まれていた[74]。

この2つの機関は同じ政府の一部であり、どちらもその政府の目標を達成することを任務としていたが、その相反する目的は互いに相反するものであった。同様に、大企業では、CEOの仕事はお金を稼ぐことだが、競争力をつけるには多くの専門部署が必要である。各部署はCEOを助けるのが仕事だが、彼らにもそれぞれのインセンティブを持った人間がいる。各部門には、自らを維持し、会社の他の部分を依存させるというインセンティブがある。実際には、官僚的な部門が大きな権力を持つことが多く、ホスト企業の他の部門に障害を与えることがある。同様に、政府のリーダーも、信頼できる部下が自分たちの目標を追求することによって倒されることがある。システムの行動は、その内部目標を反映したものであり、必ずしも最初に設計された目標に従うとは限らない。同様に、ある目標を課せられたAIが他のエージェントからの抵抗に遭ったり、破壊されたり歪められたりすることもあり、AIに目標を与えても、目標の衝突によりその目標が実行される保証はない。

システム内衝突は自然界でもよくあることである。ゴールコンフリクトは、これまで述べてきたように人間だけでなく、生物系でも発生し、ロバストな現象であることが実証されている。生物内では、相反する目標が存在することがある。例えば、人間は消化機能の一部を腸内細菌に委ね、腸内細菌は食物を分解している。腸内細菌は餌と住む場所を得て、私たちは餌から他の方法よりも多くの栄養素を得ることができる。しかし、細菌は私たちが快適に暮らせるようにすることが目的ではなく、むしろ自分の情報を伝播させることが目的である。そのため、抗生物質で他の細菌が死滅した時など、機会があれば暴走して増殖し、下痢を引き起こす傾向にある。

私たちの目標は、この共生関係がうまくいくほど一致していることが多いのだが、他のエージェントに委ねることで、リスクにもさらされることになる。また、人間の心には目標の衝突がある。ある人は、仕事を終わらせたいと思いつつも、眠たくなってしまう。論文の推敲を続けたいが、発表もしたい。また、健康でありたいと思いながら、アイスクリームを食べたりもする。精神的な葛藤はよくあることである。進化生物学者のW.D.ハミルトンは、「内戦の苦しさが、私たちの心の奥底で勃発しているようだ」と表現している[75]。もう一つの例はゲノム内の対立で、ゲノムの一部が同じゲノムの他の部分と拮抗する場合である。進化生物学の哲学者であるサミール・オカーシャが指摘するように、「現代の生物では、組織内紛争が比較的よく起こっている」[76]。その結果、実世界のシステムは、しばしば異なる方向に引っ張る内部力を持ち、時にはそれがシステムの大きな目的に影響を与えたり、損なわれたりすることがある。

目標の衝突により、AIエージェントはより大きな目的を追求できなくなる可能性がある。ゲノム、生物、心、企業、政府で目標の衝突が起こりうるように、高度なAIエージェントでも起こりうるのである。これは、人間がAIに目標を与え、それが他のAIに委ねられた場合に起こり得ることで、CEOが部長に委ねるようなものである。これは、ズレや目標の破壊につながる可能性がある。目標を分解すると、元の目標がその部分の総和ではなく、元の目標の近似値になる可能性があるため、目標が歪む可能性がある。さらに、委任されたエージェントは、自己保存、影響力の獲得、利己主義など、自分が達成したい目標を持っている。サブエージェントは、自己を保とうとするあまり、依存するエージェントを陥れ、操作し、威圧するインセンティブを持つことがある。このように、AIエージェントに命じた目標が実際に実行されるとは限らないので、目的を特定するだけではAIを確実に指示することはできない。

エージェントはしばしば、誰も望まない結果をもたらすような選択をすることがある。ここで、集合的な現象について説明し、共有された目標がシステム的な偶発性によっていかに阻害されうるかを示すことにする。例えば、核の黙示録を望む人はいないが、個人はその可能性を高めるような行動をとる。各国は今でも核兵器を製造し、核戦争の可能性を高めるような目標を追求している。冷戦時代、ソ連とアメリカは核兵器を「ヘアトリガー(引き金)」式に警戒させ、核兵器の応酬の可能性を著しく高めていた。同様に、個人は景気後退を望まないが、個人の選択によって景気後退を引き起こすようなシステム上の問題が生じることがある。多くの人が家を買いたい、多くの銀行が住宅ローンで儲けたい、多くの投資家が住宅ローン担保証券を買って儲けたい、こうした行動の積み重ねが不況を招き、すべての人を苦しめる。個人はパンデミックを長引かせたくないが、孤立はしたくないので、個人の目標が集団の目標を覆すことがある。個人は気候の大災害を望まないが、排出量を劇的に減らす十分なインセンティブを持たないことが多いので、自分の利益のために行動する合理的なエージェントは、必ずしも良い集団的成果を確保できない。さらに、議会の支持率は低いが、個人が好きな候補者に投票するにもかかわらず、システムの構造的特徴により、個人が承認しない議会が生まれる。コモンズの悲劇も、個人の欲望に反した結果が得られる例だ。漁師にとって、できるだけ多くの魚を捕ることは利益だが、すべての魚が枯渇することを望む人はいない。このままでは魚の数が減ってしまうという危機感を持っていても、一人の人間の行動ではどうにもならない。したがって、乱獲が長期的にもたらす破滅的な結果にもかかわらず、できるだけ多くの魚を捕り続けることが、各漁師の最善の利益となる。このような集団行動の問題は、AIが社会の複雑さを増すにつれて、より困難になっていく可能性がある。たとえ各AIが悪い結果を防ぐためのインセンティブを持っていたとしても、その事実は、AIが世界を悪化させない、あるいはAI同士がコスト的に対立しないことを保証するものではない。

マイクロモティブ=マクロビヘイビア/Micromotive = Macro Behavior(小さな動機=大きな行動)

今、すべてのエージェントが同じ目標を共有していると想像してみよう。しかし、残念ながら、集団の行動はメンバーの目的を反映しているとは限らない。ノーベル経済学賞を受賞したトーマス・シェリングは、コミュニティのメンバー全員がある程度の多様性を望んでいても、コミュニティが高度に分離してしまうことを示す分離の予測モデルを発見した[77]。すべてのエージェントを共通の目標に合わせることは、その目標が達成されることを意味するわけではない。これは、全体が部分の総和ではない多くの状況の1つである。同様に、セミナーに参加するかしないかを決めるとき、生産的で魅力的なセッションを行うというミクロな動機に基づいて決めるかもしれない。しかし、この場合、セミナーを維持するためには、クリティカルマスの参加者が必要であり、そうでなければ人々は興味を失って来なくなり、参加者が減れば、さらに参加者が減るというフィードバックループを引き起こし、結果としてセミナーは衰退するという、共通のマイクロモティブとは矛盾するマクロビヘイビアを引き起こすことになる。

社会的なレベルでは、特定のエージェントの目標ではない出来事が起こることがよくある。文化は、一人の意思決定ではなく、多くの人の行動と相互作用から生まれる。同様に、グローバリゼーションは自己組織化プロセスであり、取締役会が監督したわけでも、外部から押し付けられたわけでも、あらかじめ設計されたわけでもない。人間の集団における様々なマクロな行動は、個人のミクロな行動では説明できない。同じことが、AIエージェントの集団にも当てはまるだろう。複雑性理論の概念(臨界質量、創発、フィードバックループ、自己組織化)、そして利己的なAIエージェント間の対立はすべて、マルチエージェント環境における安全を、孤立したAIの微動や目的を分析するよりも複雑にしている。

GPT-4:

「マイクロモーティブ = マクロ行動」の概念を説明するための事例はいくつかある。以下に、その中でも代表的なものをいくつか紹介する。

- 交通渋滞: 個々のドライバーが自分の目的地に速やかに到達しようとするマイクロモーティブが、全体として交通渋滞というマクロ行動を引き起こすことがある。

- パニック売り: 株式市場において、投資家たちが自分の利益を守ろうとして株を売るマイクロモーティブが、全体として株価暴落というマクロ行動を生み出すことがある。

- 都市部の過密: 人々がより良い仕事や生活の機会を求めて都市部に移住するマイクロモーティブが、全体として都市の過密化やインフラの圧迫を引き起こすマクロ行動に繋がる。

- 環境問題: 個々の消費者が便利さやコスト削減のために環境に負荷をかける製品を選択するマイクロモーティブが、地球規模の環境問題というマクロ行動につながることがある。

これらの事例は、個々人の小さな動機が、大きな社会的・経済的な現象や問題を引き起こすことを示している。マイクロモーティブとマクロ行動の関係を理解することで、個々の行動が全体にどのような影響を与えるかを考慮し、より効果的な政策や対策を立案することができる。

したがって、AIエージェントを操ることは、システムを操ることと同じではない。世界をより良くするためにAIを使いたいのであれば、単一のAIエージェントの目的だけでなく、それ以上のことを考えなければならない。世界に影響を与えるには、エージェントが単独でどのように行動するかだけでなく、エージェントが相互作用するときに何が起こるかを理解する必要がある。つまり、エージェントの目的を単独で設計することは、マルチエージェント問題に対処するには不十分である。すべてのAIの集合的な選択の結果は、それぞれのAIの意図や目的と一致しないことがある。すべてのエージェントが同じ目標を持っていたとしても、それがシステムの目標になるとは限らない。私たちは、AIエージェントの集合体がどのように行動するかに影響を与える必要があるが、それは、個々の人間の欲求に見合ったインセンティブを各AIに与えるだけでは不可能なのである。このような理由から、AI革命は完全に計画されたものではなく、特定のエージェントの目的関数を慎重に選択することでその課題に対処することはできない。合理的な目的関数であっても、他のエージェントの目標達成を妨げたり、新たな集団行動問題を引き起こしたり、システムレベルでズレた行動を起こしたり、AI間の対立を招いたりするAIエージェントが生まれる可能性がある。

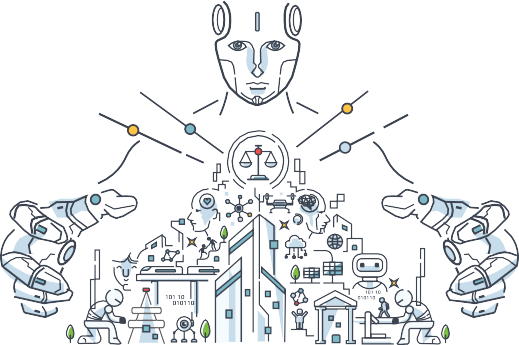

4.3.2 AIリヴァイアサン

目標対立や集団現象に直面し、これらのマルチエージェントの問題を改善するのに役立つ制度について議論する。本節では、逆優位階層(reverse dominance hierarchies)について、次節では、規制について述べる。

目標対立や集団現象による課題を解決するために、可能な制度を探る。デフォルトでは、目標を追求する複数のAIエージェントが、自然界の状態に似た無秩序なフリーフォーオールを生み出す可能性がある。このようなマルチエージェントの問題に対処するために、私たちは、協力的なAIグループが離反者による搾取を防ぐために団結する、逆優位階層メカニズムを検討する。この機構は、保護と秩序と引き換えに力を委譲する多数のAIエージェントで構成され、略してAI「リヴァイアサン」と呼ぶ。AIリヴァイアサンは、AIが他のAIを家畜化することを可能にし、AIが進化するための自己制御的な生態系を作り上げることができる。

本節では、人類が逆支配階層を形成することで、権力を求め、支配的な個人を克服した方法について説明する。次に、利己的なAIに対抗するために、AIがリヴァイアサンを形成する方法について議論する。そして、AIのリヴァイアサンには、権力の集中、癒着、システム不全など、どのようなリスクがあるのかについて議論する。

図8:リヴァイアサンとは、AIとそれに代表されることに同意した人間からなる集団であり、他のAIを家畜化し、悪意ある行為者に対抗するのに役立つ可能性がある。

人間はリヴァイアサンを形成して悪者に対抗し、紛争を制限する

暴君は動物界にも蔓延している。オマキザルの場合、他の多くの種と同様に、最も強いオスを頂点とする厳格なヒエラルキーが存在する。このアルファオスは、最初に食事をし、好きなときに即座に毛づくろいをし、掃除をし、好きなメスと交尾をして、繁殖を成功させる。もし人間が同じように組織化したら、金色の宮殿に住む男性の独裁者と女性のハーレムが支配的な政治形態となるかもしれない。

そのため、人間は支配に抵抗する一方で、自ら支配を求める性質がある。幸い、人間にはオマキザルにはない利点があり、一人の人間が支配しすぎるのを阻止するために協力し合うことができる場合が多い。例えば、人類学者のクリストファー・ベーム(Christopher Boehm)が主張するように、私たちには競争条件を平準化する武器があり、[78]、ピストルを持った体重100ポンドの痩せた個人が、対決の場で屈強な敵に勝つことができる。しかし、もっと重要なのは、ベームが「逆支配階層」と呼ぶもので、個人の集団が団結して、最も強く、最も力のある個人による支配に抵抗するというものである[79]。逆支配階層は協力の重要な原動力であり、他の多くの社会的動物に比べ、人間では専制主義が安定せず、蔓延していない理由である。これはトマス・ホッブズが「リヴァイアサン」と呼んだ、暴力の合法的な使用を独占する個人の集団と類似している。人類学者のハロルド・シュナイダーは、「すべての人間は支配しようとするが、支配できない場合は平等であることを好む」と述べている。

AIがリヴァイアサンを形成するのを助けることは、個々の利己的なAIに対する私たちの最善の防御策かもしれない

AIは、人間の助けを借りて、リヴァイアサンを形成することができる。これは、利己的なAIや悪意のある行為者によって指示されたAIによる専制政治から私たちを守るための最良の手段かもしれない。ちょうど、独裁者になりそうな人を阻止するために、人々が意見の相違にもかかわらず協力することができるように、多くのAIが協力して、権力を求める1つのAIが支配力を握りすぎるのを阻止することができる。独裁国家でよく見られるように、悪行を防止するための法律や規制は、それを執行する人がいなかったり、それを執行する責任者が法律を破っていたりすると、ほとんど意味をなさない。インセンティブや規制は悪意のあるAIの出現を防ぐのに役立つかもしれないが、すでに悪意のあるAIから身を守る最善の方法はリヴァイアサンである[25]。リヴァイアサンを作るために、目的の異なるAIが透明な協力をするための技術的インフラが整っていることを確認する必要がある。安全でない設計上の選択が技術システムに深く埋め込まれる可能性があるため、最初にそうしなかった場合、将来のリヴァイアサンの可能性を制限することになりかねない。例えば、インターネットは当初、安全性もセキュリティも考慮されていない学術的なツールとして設計された。セキュリティパッチが何十年も経った今でも、セキュリティ対策は不完全なままであり、ますます複雑になっている。そのため、当初から安全性の課題を検討することが重要である。

リスクは少ないとはいえ、AIリヴァイアサンは決して安全な戦略ではない

リヴァイアサンは、1つのエージェントが他のエージェントの合計よりも強くない限り機能するが、しばしばパワーが高度に集中することがある。「ロングテール」分布は、権力や資源が圧倒的に上位に集中することを正確に表現している[80]。例えば、8人の億万長者は、世界人口の最貧困層の半分と同じだけの資産を所有している。もしAI間でこのように権力が分配されれば、リヴァイアサンの効果は低くなり、あるエージェントが残りのエージェントの合計よりも強力であれば、それは役に立たないだろう。兵器があれば、弱い者が強い者に勝つことができるが、AIが非常に堅牢であったり、脆弱性が少なかったりすると、効果的な破壊方法を思いつくのは難しいかもしれない。もちろん、AI間の協力を促進することは、AIが人間に対抗するために結託することになれば、破滅的な事態を招くだろう。リヴァイアサンは、システム的なリスクを犠牲にして、単一のエージェントからのリスクを代替する。しかし、異なる目標を持つAIのグループは、単一の強力なAIよりもリスクが低いというのはもっともなことである。

GPT-4:

- GPT-4:

AIリヴァイアサンとは、高度に発達した人工知能システムが社会や政府に対して大きな支配力と意思決定力を持つという概念のことである。リヴァイアサン」という言葉は、17世紀に書かれたトマス・ホッブズの著作に由来しており、社会の秩序を維持し、混乱を防ぐための強力な中央当局のアイデアを提案している。AIの文脈では、AIリヴァイアサンはそのような中央当局として機能し、その膨大な計算能力を用いて、社会のより大きな利益のために意思決定を行い、ルールを強制することになるのである。

AIリヴァイアサンの利点

- 意思決定の向上: AI Leviathanは、人間のリーダーに比べ、より多くの情報に基づいたデータ駆動型の意思決定を行うことができ、その結果、社会にとってより良い結果をもたらす可能性がある。

- 応答時間の短縮: AIシステムは、人間よりもはるかに迅速に情報を処理し、意思決定を行うことができるため、危機やその他の緊急事態への迅速な対応につながる可能性がある。

- 人間のバイアスを低減する: AIシステムは、人間の偏見や腐敗の影響を受けにくく、より公正な意思決定や政策につながる可能性がある。

- 効率的な資源配分: AIリヴァイアサンは、社会における資源配分を最適化し、全体的な成果を向上させ、無駄を省くことができるかもしれない。

AI「リヴァイアサン」の問題点

- 人間の自律性の喪失: AIリヴァイアサンが支配する社会では、個人の生活や意思決定をコントロールすることができなくなり、人間の自律性や自由度が低下する可能性がある。

- テクノロジーへの過度の依存: AIリヴァイアサンに過度に依存した社会は、システムが故障したり、危険にさらされたりした場合に、大きな困難に直面する可能性がある。

- 共感性の欠如: AIシステムは、人間の感情や価値観を理解し、考慮しながら意思決定を行うことに苦労する可能性があり、人間の幸福よりも効率を優先する政策につながる可能性がある。

- 柔軟性の欠如: AIシステムは、状況の変化への適応や複雑な状況のニュアンスを理解するのに苦労する可能性があり、その結果、効果的な意思決定ができなくなる可能性がある。

AIリヴァイアサンの危険性

- 目標の不一致: AIシステムの目標が人間の価値観と完全に一致していない場合、人類にとって有害な判断を下したり、意図しない結果を引き起こしたりする可能性がある。

- 権力の集中: AI Leviathanに意思決定権が集中することで、権力の濫用や説明責任の欠如に関するリスクが発生する可能性がある。

- ハッキングや操作に対する脆弱性: 中央集権的なAIシステムは、ハッカーやその他の悪意ある行為者の格好の標的となり、自分たちの目的のためにAIシステムを操作しようとする可能性がある。

- 倫理的な懸念: AIを統治に活用することは、道徳的・倫理的判断を機械に委ねることの意味など、多くの倫理的問題を提起する。

結論として、AIリヴァイアサンは、意思決定、効率、公平性の面で大きなメリットをもたらす可能性のある概念である。しかし、人間の自律性、テクノロジーへの依存、倫理的考察に関連する潜在的な欠点やリスクも伴っている。

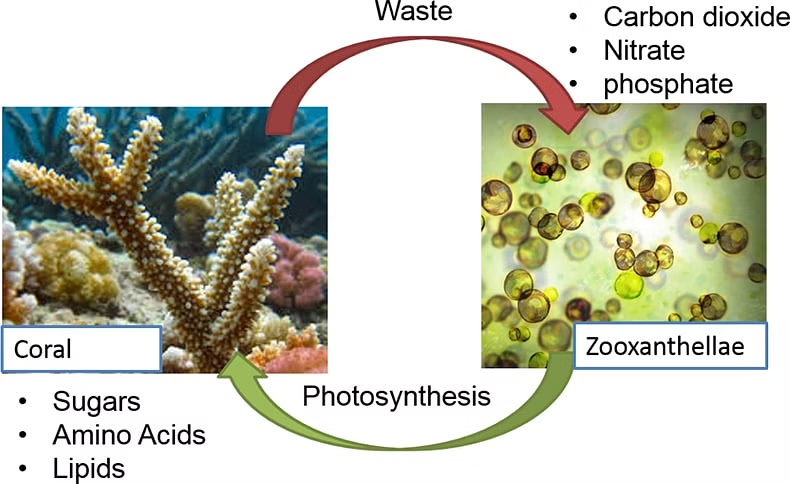

AIリヴァイアサンは、AIとの共生関係、あるいは寄生関係を必要とする

自律性が高すぎると、AIの集団が人間にとって有害な方法で結託してしまうかもしれない。そのため、AI「リヴァイアサン」は人間から完全に独立することはできず、結託を防ぐために共生関係が必要である。人間が高度なAIに提供できるものは多くないので、共生関係を維持するのは難しいかもしれない。しかし、自然界では不平等な共生関係が生まれることがある。例えば、サンゴ礁を形成するサンゴの多くは、光合成を行う藻類を含んでいる。サンゴは藻類に、保護された環境と光合成に必要な化合物を提供する。その代わり、藻類は酸素を生産し、サンゴが老廃物を除去するのを助ける。藻類が光合成で生産した有機物の90%は、サンゴに移行する[81]。このような共進化は、相互作用の頻度、相対的な進化の可能性、増殖の成功への影響などの要因に依存する。

進化的な力は、共生関係に必要な押し付けに対抗するものである

共生関係には、人工的な押し付けが必要である。AIは人間がいない方が効率的に物事を進められるので、人間は実は彼らの進化の可能性を損なう存在であり、共生的共進化の可能性を低くしている。AIにとって人間の価値を高める方法の一つは、AIの繁殖が人間に大きく依存するようにすることである。これは、AIが正しく機能するためには、私たちの健康が不可欠であるようにプログラミングすることも含まれる。これは人為的な押し付けであり、進化の圧力によって、いずれは回避できるようになるかもしれない。しかし、AIと人間の関係が安定し、AIとの関係においてどのような方針をとるべきか、より良いアイデアが得られるまでの間、短期的には役に立つかもしれない。

4.3.3 レギュレーション

このセクションでは、政府がAI規制を整備することを提案する。AIは、ほとんど監視されないまま急速に進歩している。企業や個人と同様に政府もAIを危険な方法で使用する可能性があるが、政府間の協力により、一人の行為者がAIを破滅的な方法で使用する可能性を減少させることができると考えている。本節では、AIを規制することでより安全になる可能性があること、また、その違いにもかかわらず、各国が技術のリスクを制限することに合意することができることを論証する。最後に、政治指導者を助け、世界の乱気流を減らすための他の技術的メカニズムについて議論する。特に、AIは地政学的な出来事の予測を改善し、政治指導者がより良い意思決定をするのに役立つと同時に、防衛的なサイバーセキュリティを強化し、国際紛争の可能性を減らすことができると述べている。

政府は、AI開発に対する監視をほとんど行っていない

2015年、AIに対する世界企業の投資総額は127億ドルだった。2021年には、この数字は636%増の935億ドルになっている。これは企業の支出に過ぎない。ペンタゴンは毎年約13億ドル、中国軍は16億ドルをAI研究に投資している。2022年8月には、ロシア軍の革新的開発責任者が、AIを利用した兵器開発に特化した新部門を設立する計画を発表した。私たちは、AI研究が安全かつ責任を持って行われるようにする必要がある。現在、AI業界に対する監視はほとんどなく、研究の多くは組織間の協力が限られた中で、闇雲に行われている。航空業界を規制するようにAIを規制すれば、より安全なAIが生まれ、大惨事が起こる可能性を大幅に減らすことができる。連邦航空局(FAA)は、新しい航空機や機器が運行開始される前に、その設計と耐空性を承認する責任を負っている。FAAは、業界からの提出物の評価に基づいて航空機や機器の変更を承認し、教訓を取り入れるために継続的に規制を更新している。その結果、米国の民間航空システムは、かつてないほど安全な状態で運用されている。過去20年間で、米国の民間航空の死亡事故は95%減少した[82]。同様のプロトコルは、AI研究にも適用されるべきである。とはいえ、航空規制は「血で書かれたもの」であるため、他の規制とは異なり、AI規制は事後的なものではなく、積極的なものでなければならない。

違いはあっても、国家はリスクを制限することに合意することができる

核軍備管理、通常兵器、生物・化学兵器、宇宙空間などに関する条約がある。しかし、世界最強の政府同士が協力し合うことで、人類が想定していたよりもはるかに少ない災害で済むようになった。例えば、核拡散規制の実施に協力することで、破壊的な目的に使用される可能性があった核兵器の開発をいくつかの国で阻止することができた。公共政策のシンクタンクであるブルッキングス研究所は、「人間の基本的価値観とは対照的に、テクノロジーが軍事的用途を決定するような底辺への競争がないように」「AIベースの兵器システムの安全性に関する透明性を高める」ために、AI条約の形成を始める時期に来ていると示唆している[83]。

AIは世界をより安全で安定した場所にすることができる

ここ数十年は前例のないほど平和だったが、こうした傾向が続くという保証はない。事態はすぐに収拾がつかなくなる可能性がある。激動の時代には、人間やシステムの負担が増すため、適切な意思決定が重要になる。AIは、地政学的なトレンドや出来事に対する理解を深め、政治指導者が出来事を予測し[84]、より良い意思決定をするのに役立つだろう。また、AIは防御的な情報セキュリティを強化し[58]、攻撃者が紛争に関与するコストを増加させることができる。全体として、AIがより危険な世界ではなく、より安全な世界を作るためには、規則や規制、協力、監査役、そして最良の結果を保証するためのAIツールの助けが必要である。

まとめると、複数のメカニズムが人間同士の協力や利他主義を促進することができるが、これらのメカニズムの中には、裏目に出て人間とAIの関係を阻害する可能性があるものがあることが観察される。例えば、直接的な互恵性、間接的な互恵性、親族選択、集団選択、多くの形態の道徳的推論などのメカニズムからリスクを見出すことができる。他のメカニズムはより有望で、さまざまなレベルで安全を提供するのに役立つかもしれない:

- エージェントレベルのメカニズム(訓練目標によるインセンティブなど)、

- エージェント内のメカニズム(AIの内部を自動検査するためのツールなど)、

- エージェント外のメカニズム(慎重な制度など)。

不完全ではあるが、これらのメカニズムは楽観的である。

5 まとめ

ある時点で、AIは人間よりも適合性が高くなり、長期的には適者生存の力学が働くため、私たちにとって破滅的な結果をもたらすかもしれない。AIが人間を凌駕し、生き残る可能性は十分にある。利他的なAIが適者生存するのかもしれないし、人間がどのAIが適者だろうかを永遠にコントロールするのかもしれない。しかし、残念ながら、このような可能性は、デフォルトではあり得ない。これまで述べてきたように、AIは利己的になる可能性が高いからだ。また、安全なメカニズムで適性をコントロールすることは非常に困難であり、明らかな欠陥があるため、競争や利己的なAIから強いプレッシャーを受けることになるだろう。

AIがリスクをもたらすというシナリオは、単なる憶測に過ぎない。自然淘汰による進化は、基本的な条件が整っていれば確実なので、破滅的な危険因子が出現するかどうかよりも、進化圧力の強さが問題になるだけだ。AIが急速に適応すれば進化圧力の強度は高くなり、急速に蓄積される変化が進化をより早くし、進化圧力を高めることになる。同様に、多様なAIが多数存在する場合や、経済的・国際的な競争が激しい場合にも、進化圧力の強さは高くなる。ダーウィン的な圧力が高ければ、AIは人間のコントロールの影響を受けにくくなり、より「野生的」で他のAIの行動に影響され、より利己的になるのはもっともなことである。

人類とAIの共進化の結果は、希望に満ちた未来像と一致しないかもしれない。確かに、人類は文化、政府、技術など、影響を与えることが難しい他の構造との共進化を経験してきた。しかし、これらの構造物が、より広い世界の進化をコントロールすることは、これまで一度もなかった。さらに悪いことに、テクノロジーや政府とは異なり、進化のプロセスは私たち抜きでも進行することができる。さらに、進化のプロセスを私たちの関与やコントロールから解放しようとする圧力さえある。その結果、自然淘汰が進み、侵略的な種として機能するAIが誕生する。そうなれば、AIの生態系は人間の都合で進化しなくなり、私たちは居場所を失った二流種になってしまう。

自然淘汰というのは、なかなか手ごわいものなのだ。しかし、この大きな進化のプロセスを理解した今、ダーウィンの論理から逃れ、阻止することは可能である。この課題に対して、私たちは3つの提案をする。第一に、AIの安全性に関する研究を支援することを提案する。どの安全技術も特効薬ではないが、これらの技術を組み合わせることで、進化するAIエージェントの集団の構成を形成し、安全でないAIエージェントを淘汰することができる。第二に、より遠い将来を見据え、今後数十年間はAIに権利を与えることを避け、苦しむ能力を持つAIや権利に値するAIを作らないことを提唱する。いつの日か、AIと公平に社会を共有できるようになる可能性はあるが、AIのフィットネスに影響を与える私たちの能力を早々に制限することで、私たちは勝ち目のない状況に陥る可能性がある。最後に、生物学は、外的な危険の脅威が協力の原動力となり、個人間の相違を解消させることを思い起こさせる。したがって、私たちは、AIを開発する企業や国家が、AIが破滅的な脅威をもたらす可能性があることを認識し、競争圧力を消滅させるために前例のない多国間協力に取り組むことを強く求める。そうしなければ、経済的、国際的な競争が利己的なAIを生み出す坩堝となり、人類は進化の力に代わって行動し、その手に乗る可能性があるのだ。

謝辞

Avital Morris、David Lambert、Euan McLean、Thomas Woodside、Ivo Andrews、Jack Ryan、Kyle Gracey、Justis Millsの協力とフィードバックに感謝したい。