astralcodexten.substack.com/p/mr-tries-the-safe-uncertainty-fallacy

マージナル・レボリューション (Marginal Revolution) は、経済学者であるタイラー・カウエンとアレックス・タバロックが運営する、経済学を中心にしたブログのこと。このブログでは、経済学、政治、文化など様々なトピックについての意見や分析が投稿され、経済学に関心のある人々によって広く読まれている。

「安全な不確実性の誤謬」はこう説く:

- 状況はまったく不透明である。私たちは何も予測することができない。文字通り、なるのか全く予想がつかない。

- よって、大丈夫だろう。

あなたは何も見逃していない。意味がないはずだ、だから誤謬なんだ。

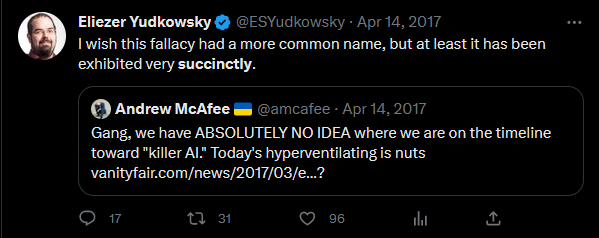

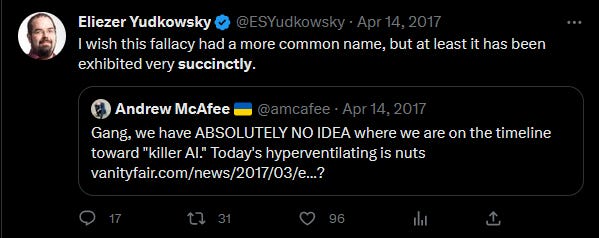

何年も前から、人々はAIのタイムラインで「安全な不確実性の誤謬」を使っていた:

GPT-4はAGIに相当し、多くの人が何十年も先の話だと言っていたAIだ。いつ何が起こるかまったくわからないとき、その答えが「もうすぐ」であることが判明することがある。

今度は、Marginal RevolutionのTyler Cowenが この議論に挑戦している。AIがどうなるかは全く分からない、根本的に不確実だ:

コストとベネフィットの全体的な計算がいかにポジティブであろうとネガティブであろうと、AIは私たちのアップルカートのほとんどを、特にいわゆるおしゃべりなクラスにとって、ひっくり返す可能性が非常に高いのである。

現実は、印刷機の始まりには、それがもたらす変化について、誰も本当のところは考えていなかった。化石燃料の時代の始まりには、それがもたらす変化について、誰もあまり考えていなかった。このような急激な技術革新がもたらす長期的、中期的な結果を予測するのが得意な人はいない(短期的なことは不完全ながらできる)。誰もだ。あなたでも、エリーザーでも、サム・アルトマンでも、あなたの隣人でもない。

人々は印刷機の最終的な影響をどの程度予測できたか? 火事の最終的な影響を、人々はどれだけ予測できただろうか。「火遊び」という言葉もあるくらいだ。しかし、正味のところ、私たちが火の配備を進めたのは良いことだ(「火?そんなことしちゃダメだ!何もかもが燃えてしまう!火で人を殺せるんだ!全員だ!混雑した劇場で誰かが「火事だ」と叫んだらどうするんだ!」)。

よって、大丈夫だろう:

AIによる存亡の危機を「自説」「自論」で語る人の話を読むたびに、ちょっと心が痛む。そんな未来は誰も予測できない!自説を唱え続けると、自分も予測可能であると錯覚してしまう。創造するよりも破壊する方が簡単なので、一度タブラ・ラサ的に未来を考え始めると、その話をすればするほど悲観的になってしまう。破壊が迫っているという議論はそれに比べれば簡単だが、すべてがどのように組み合わされているのかを理解するのは難しくなってしまう。破壊のケースは、「ドーン!」と簡単に表現できるのに、ある時点で、あなたの内なるハイエキアン(ポパー?が支配して、その懸念からあなたを引き離さなければならない。特に、11年前にLessWrongで初めて議論された8つの新しい概念分類に基づく9部構成の議論を聞くときは、そうだ。AIによる人類存亡リスクは、 あなたが想像しようとしている他のあらゆる未来と同様に、確かに遠い可能性だ。すべての可能性は遠い。 AGIのリスクが他の遠い可能性と同列に置かれるという事実だけで、あなたはあまり感動しないはずである。

だから、思い切ってやるべきだ。もし誰かが、今日のAI技術の詳細と、11年前のLessWrongの議論について執拗に議論していたら、これを見ないだろう。彼らの餌に騙されてはいけない。

見てみよう。大丈夫かもしれない。AIによる存亡の危機の可能性は33%だと言ったが、それはつまり、起こらない可能性が66%あると思うということだ。ほとんどの未来で、私たちはうまくやり過ごすことができる。タイラーは、愚かなことをしたと優しく私を叱責する。

そうさせないでほしい。たとえAIがこれまでで最高のもので、決して悪いことをせず、この時点から二度と人種的偏見や別の引用の幻覚を見せることすらないとしても、私は「安全不確実性の誤謬」は悪い議論だという立場を貫くつもりである。

通常であれば、ここでタイラーに鉄槌を下し、彼の主張する最強のバージョンがなぜ間違っているのかを詳しく説明しようとするところである。しかし、その強力なバージョンとは何なのかがわからない。以下、3つの可能性を挙げてみる:

1)人類を殺すものの基本的な割合は非常に低いので、この基本的な割合から推定をずらすには、強い肯定的な論拠が必要であろう。不確実性が高いので、強力な肯定論はなく、「非常に低い」という基本的な割合を維持する必要がある。

例えば、天文学者が全長100マイルの宇宙船が地球に接近しているのを発見したとする。これは、何が起こるかわからない、極めて不確実な状況である。だから、その宇宙船が私たちを殺すことはないだろうから、心配する必要はないだろう?それは間違いだ。

地球に接近したエイリアンの宇宙船が人類を殺すというのは、どのくらいの基準率なのだろうか?今までこのような状況に陥ったことがないため、基本率はない。人間以上のAIが開発され、人類が滅亡する確率は?私たちは、………………わかっただろう?

基本率のようなもので釣ってみるのも手だ:「農業以来、100の大発明があったが、そのどれもが人類を滅亡させなかったので、大発明が皆を滅ぼす基本率は約0%である」

しかし、私は反論することができる:「アウストラロピテクス→ホモ・ハビリス、ホモ・ハビリス→ホモ・エレクトスなど、ある種の賢者がより知的な後継種を生み出したことは十数回あり、いずれの場合も後継種は前任者を一掃した。つまり、より知能の高い後継種が皆殺しにする確率は、約100%ということになる」

Less Wrongersはこのゲームを「基準クラステニス」と呼び、唯一の必勝法はプレイしないことだと主張している。この問題を基本レートで考えるのは、他の方法で考えるのと同じくらい難しく、ある基本レートが他のものより優れている理由を説明する必要がある。タイラーは何もしていない。

2)いろいろな可能性があり、仮に100とする!- で、死ぬのはそのうちのひとつに過ぎないから、死ぬ確率は1%しかない。

これは、私の解釈のようなものだ:

AIによる存続リスクは、 あなたが想像しようとしている他の未来と同じように、確かに遠い可能性だ。すべての可能性が遠いということは、いくら強調しても足らない。AGIのリスクが、他の遠い可能性と同列に扱えるという事実だけで、あなたはあまり感心しないはずだ。

再びエイリアンの時代!全長100マイルの宇宙船というシチュエーションがどのような結末を迎えるのか、いくつかの可能性を紹介する:

- 宇宙人は平和的で、自分たちの高度な技術を分かち合いたいと考えている

- 宇宙人は、私たちを研究したい科学者である

- 宇宙人はとっくに死んでいて、船は宇宙を漂う空っぽの殻になっている

- 宇宙人は、船の原子炉に燃料を補給するために、私たちからウランを買って帰りたいのだ。

- 宇宙人は私たちを自分たちの宗教に改宗させようとする宣教師である。

- 宇宙人は800Fで成長し、金星の植民地化を目指しており、地球にはまったく関心がない。

- […その他数十名]である。

- 宇宙人が人類を皆殺しにする

だから、巨大な宇宙船を心配する必要はない。殺される確率は1%しかない!もっと巧妙にシナリオを作れば、0.5%以下にすることも可能だ!

現実にはこのような推理はできない、すみません。シナリオの具体性(「宇宙人は555銀河年ごとに1つの文明にジンジャーブレッドクッキーを与えることを儀式として要求する宗教を設立し、今それを私たちに与えている」というのは、「宇宙人は私たちを研究したい」というのが「1つのシナリオ」であるのと同じように、「ひとつのシナリオ」であるのか)と可能性が等しいという偽りの仮定に依存している。

3) あるシナリオが真実であることを証明できない場合、その可能性は0であると仮定しなければならない、それがルールだ。

いいえ、そうではない!私はこの議論を何度も試みてきた。例えば、「証拠がないことは悪い科学コミュニケーションの赤信号」というフレーズがある。 武漢の新型コロナウイルスがヒトからヒトへ感染するのではないかと心配する人がいた。医師は文献に目を通し、このテーマで誰も研究していないことに気づき、「落ち着け!ウイルスがヒトの間で広がるという証拠はコロナにない!もしそうだと思うなら、あなたは科学否定論者である!中学校に戻って、仮説を支持するためには証拠が必要だということを学べ!」と。もし、あなたが「コロナウイルスがヒトの間で広がらないという証拠はあるのだろうか」という質問を したら、彼らは「証拠は必要ない、それは帰無仮説だ」と言うだろう。 そして、「科学を信じろ」という理由で、検疫や安全対策の試みをすべて打ち消すだろう。そして、コロナウイルスがヒトの間でうまく拡散することが判明すると、彼らはいつも裏切られたような顔をする。どうしてそんなことがわかったのだろう?証拠がなかったのだ。

どちらか一方を証明できない場合は、最善の推測をする必要がある。通常、ベースレートを使用することになる。ある薬が癌を治すという証拠がない場合、私はその薬が癌を治さないのではないかと考える。エイリアンの宇宙船が人類を滅ぼすという証拠がない場合、どの基準率を使うかは分からないが、すぐに「可能性は0%、証拠ができたらまた来てほしい」とは言わない。

信念を生み出すためには、認識論的な作業をしなければならない。私はこの問題についてよく考え、AIが人類を絶滅させる確率は33%だと予想している。タイラーはどうなんだ?彼は「遠い可能性」としか言わない。それは33%という意味だろうか?5~10%なのか(Katjaの調査によれば、AI研究者の中央値はそう考えている)、1%なのか。それとも、タイラーは特定のパーセントを念頭に置いていないのだろうか。それは、「ゼロではないのだから、私がこの未来を特に傲慢に否定していると非難することはできない」という意味に聞こえるが、特定の数字が両方の基準を一度に満たすかどうかを確認するという難しい作業をしなくても「気にするな」という意味にも聞こえる表現で、自分の悪い議論を洗浄したいのだろう。

ある発言(「ブロックスターはグリーブリックか」)について、完全に不確実であれば、その確率を50%とすべきだ。それ以外の推定値を持っている場合、それがどれほど根本的に不確かなものだろうかから判断しているのだと主張することはできない。具体的な事例を提示する必要がある。いつかタイラーの記事を読むのが楽しみだ。

最後にこう言っている:

歴史的な視点が長ければ長いほど、この点はより明白になる。私たちは思い切って行動すべきだ。私たちはすでに思い切って行動している。私たちは思い切って行動するために、分散型社会を設計し、許容していた。皆さん、あの世でお会いしよう。

もちろん、これはナンセンスだ。私たちは、イノベーションを阻害することに長けた社会を設計した。今、私たちは、妨害者、過剰な規制者、反テクノロジー狂信者、社会主義者、そして一般的な原則から新しいものを嫌う人々の勇敢な連合によってのみ解決できる問題に遭遇しているのである。まるで、シャックがバスケットボールをすることでしか世界を救うことができない状況に遭遇する映画のようだ。21世紀のアメリカ社会がそのテロスを発揮する機会を失うことは、 存亡の危機である以上に、茶番劇だ。