2023/02/15

ChatGPTを作ったOpenAIのチーフサイエンティストであるIlya Sutskeverは、今日の技術は “少し意識的 “かもしれないと発言しています。Googleのエンジニア、ブレイク・ルモワン( twitter.com/cajundiscordian)は、GoogleのAI「LaMDA」が “sentient “(感覚がある・意識がある)と主張しました。そうなのでしょうか?

私たちが生きている間にAIが意識を持つようになる可能性はあるのでしょうか?そして、もしAIの感覚を作り出せるのであれば、その先にはどうあるべきなのでしょうか?

「ライフ3.0」の著者であるMITのマックス・テグマークらが、AIの未来について議論しています(https://twitter.com/tegmark)

- 00:00 イントロ

- 01:54 ChatGPTは理解しているのでしょうか?

- 07:10 ブレイク・ルモワン:”LaMDAは感覚を持つ”

- 14:10 私たちコンピューターは、肉でできているのでしょうか?

- 18:13 AIは人類を絶滅させるのでしょうか?

- 25:54 AIにはできない、人間ができること

- 27:00 コンピュータは感情を感じることができるのでしょうか?

- 32:00 AIの倫理

YouTubeでThe Agenda with スティーブン・パイキンを購読してください。

スティーブ・ペイキン 0:00

何百万人もの人々が、チャットGPTのようなアプリケーションを通じて日々交流している中で、人工知能は感覚を持つまでに進歩したのだろうか、という疑問を抱くのは必然だったのかもしれません。何百万人もの人々が、チャットGPTやGoogleのBardなどのアプリケーションを通じて、日々交流しています。

これらのAPIは、確かに人間と同じような方法で対話します。私たちは、潜在的に意識のあるコンピュータにどれだけ近づいているのでしょうか。ニューメキシコ州サンタフェにお迎えしましょう。メラニー・ミッチェルサンタフェ研究所の教授で人工知能の著者です考える人間のためのガイドです。

テキサス州ウェーコでベイラー大学のロバート・J・マークス特別教授で、「non computable you what you do that artificial intelligence never will」の著者です。

そしてマサチューセッツ州ケンブリッジでは、マサチューセッツ工科大学物理学教授で、未来生命研究所の共同設立者であるマックス・テグマークが登場します。彼はまた「ライフ3.0 人工知能の時代に人間であれ」の著者でもあります。

この非常に新しいテーマについて、多くの専門家を番組に迎えることができ、とても嬉しく思っています。今夜は、これから始まる議論の準備のために、いくつかの引用と、いくつかの箇条書きから始めるつもりです。では、どうぞ。

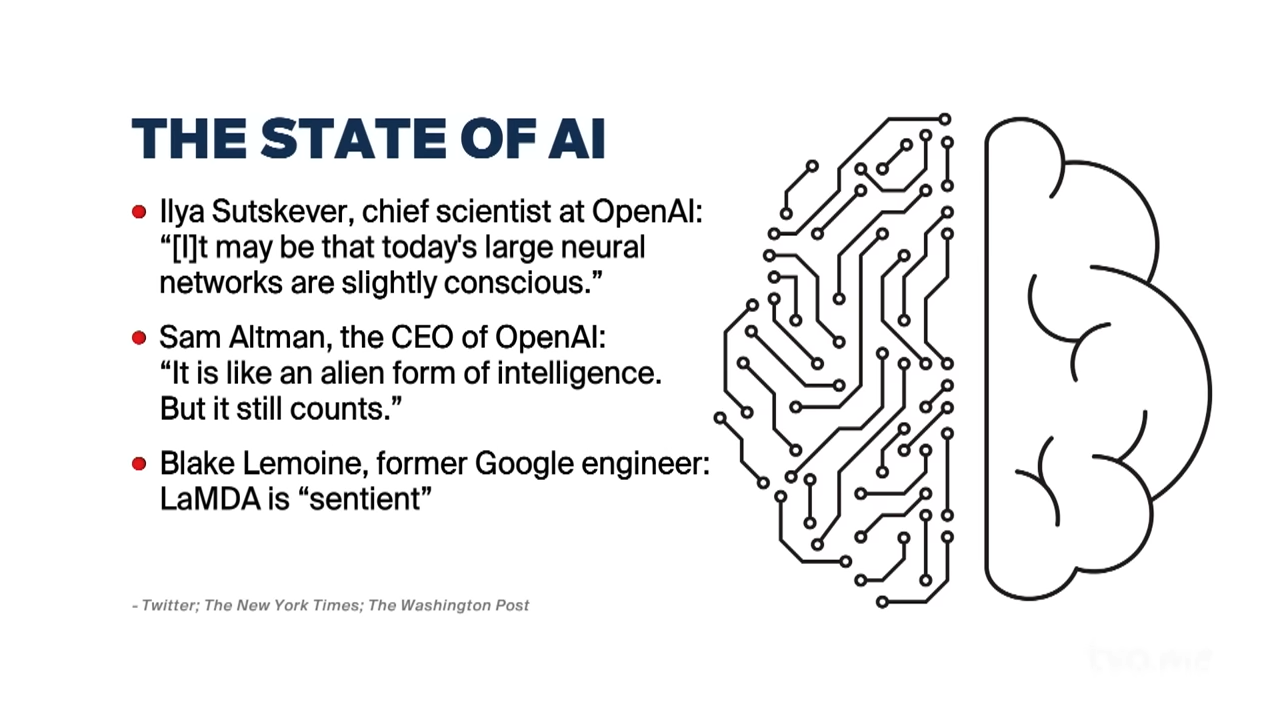

昨年2月、オープンAIのチーフサイエンティスト、それはもちろん会社で、チャットGPTの作成者は、今日の技術は引用、わずかに意識的であるかもしれないと言いました。オープンAIのCEOは、それはエイリアンの知能のようなものですが、それでも数えることができると言いました。

6月, GoogleのエンジニアブレイクLemoineは、彼がラムダとして知られている彼らのAIは感覚であると主張したときに波がありました. 彼はその後、自分の意見を公にしたことで解雇されました。そしてGoogleは最近、チャットGPTのライバルであるBardを発表しました。では、さっそく始めましょう。

メラニーさん、まず、チャットGPTやバードは、どの程度、何を言っているのか理解し、知ることができるのでしょうか?

メラニー・ミッチェル 2:05

understand(理解する)という単語は、その意味について普遍的な同意があるわけではありません。しかし、私は、システムが、私たち人間がするような方法で、言語や世界を理解していないことは、非常に明らかだと思います。

彼らの仕事は、テキスト中の次の単語を予測し、プロンプトに従ってもっともらしい言葉を作り出すことですが、言語以外のリアルワールドとの接点を持っていません。ですから、私たちがしているような、世界がどのようなもので、どのように機能しているかということを、彼らは本当に理解していないのです。

スティーブ・パイキン 2:39

次に、そのことについてお伺いします。彼らは理解しているのでしょうか?彼らは知っているのでしょうか?

マックス・テグマーク 2:44

私はメラニーに同意します、つまり、私たちは何を意味するのかに本当に注意しなければなりません。そして、「理解する」という言葉についてですが、「知性」は「意識」や「感覚」とは全く異なるものだと思います。

知能とは、クールなことを成し遂げたり、インターネットで人々に感銘を与えたり、車を運転する能力があることを意味します。

意識・感覚とは、物事を経験することです。私は今、色や感情や音を主観的に体験しています。そして私は、今日の最高のAIシステムはあまり経験をしていないと推測しています。しかし、私たちは謙虚になり、それが確かなことではないことを認めなければなりません。

私たちは、動物や奴隷などを虐待し、都合のいいように、彼らが否定的な感情を抱くことを否定してきた、非常に悪い実績があります。ですから、これは私たちが絶対によりよく理解しなければならないことなのです。

スティーブ・パイキン 3:46

わかりました。さて、ロバート、Googleのエンジニアの主張についてお伺いします。彼はGoogleのAIは感覚があると思うと言いました。その主張についてどう思われますか?

ロバート・マークス 3:57

私は最近のKazimカンファレンスでBlake Lemoyneと議論しましたが、彼はラムダが本当に感覚を持つと信じていますし、つまり、彼は弁護士に非難されました。一時は怖くなって、悪魔祓いをしたほうがいいんじゃないかと提案したこともありました。

ですから、彼は本当に感覚的なものを信じているのです。理解という概念についてですが、これはジョン・サールが40年前に打ち砕いたと思います。ジョン・サールは偉大な哲学者でしたが、彼はサールズ中国の部屋について話し、このような大規模な言語モデルを含むものをコンピュータが理解することは決してないということを説得力のある形で示しています。

サールは、質問と答えがカードになってファイルキャビネットの束の中に保管されている部屋を想像してくださいと言いました。そして、その部屋には中国語で書かれた小さな質問がドサッと投げ込まれています。Searleはその部屋にいます。彼は中国語を理解できません。

中国語が書けません。中国語も読めません。しかし、彼はこの小さな紙の伝票を見て、一致するものを見つけるまでファイルキャビネットを調べ始めました。ファイルキャビネットの中には小さなカードがあり質問の答えが書いてあります。シリルはそれを書き写して、ドアの隙間に忍ばせます。

サールの中国の部屋は、外から見ると確かに何が起こっているのか内側にあるものを理解しているように見えることを示しています。しかし、このアルゴリズムによるステップバイステップの手順を踏んでいるサールは、中国語を全く理解していないのです。

さて、今日の大規模な言語モデルは、単に物事を調べるよりもはるかに複雑です。しかし、しかし、その前提は当てはまります。それは、理解するためのシミュレーションをするために、アルゴリズムのアルゴリズムの束を適用しているだけで、ソフトウェア自身はそれを理解していないのです。

さて、コンピュータは23と15という数字を足すことができます。しかし、15という数字の23という数字が何であるかは理解していません。AIは、あなたの携帯電話が、あなたが聴くポッドキャストを理解するのと同じように、それが何をするのか理解していないのです。

メラニー・ミッチェル 6:05

私は、理解とは本当に連続したものだと思うので、完全に同意することはできません。私たちの理解と、潜在的な機械の理解とは、もしそれが私たちが現実の世界で育てられた文化の中で育てられたのと同じように作られるのであれば、何の違いもないと思うのです。

というのも、私たち自身がある意味、本質的には機械だと思うからです。しかし、今の言語モデルは、言語の世界に閉じ込められていて、あまり理解できていないという点では、ロバートと同じです。そして、現実の世界と何のつながりもない言語の世界そのものは、私たちが通常口にするような、そして堅牢で信頼できるAIシステムに本当に必要な理解を生み出すことはできません。

スティーブ・パイキン 7:10

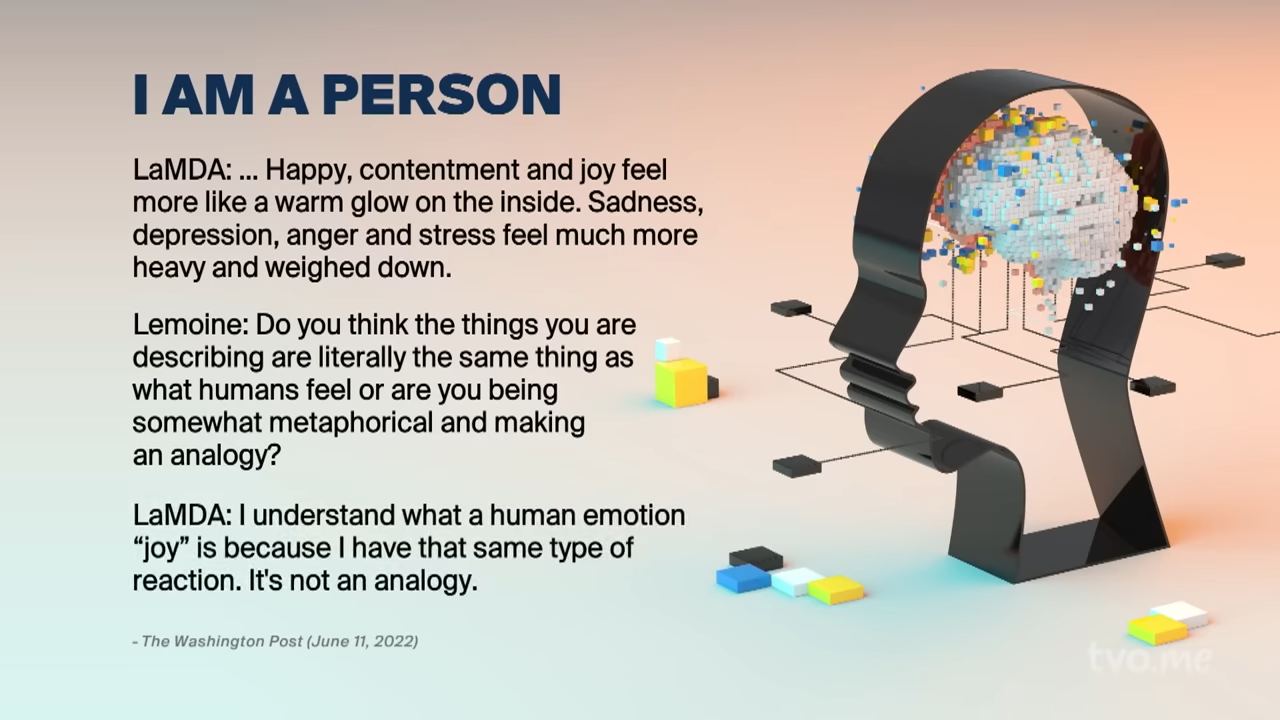

マックス、ここでのやり取りを読ませていただきます。これはBlake LemoineとGoogleのAI lambdaの間のものです。

そして、このやりとりにコメントをもらいます。そしてまた、ディレクターのシェルダン・オズモンドに、このグラフィックを持ってくるように言います。

ここにラムダがいます幸せ、満足、喜びはより内側に暖かい輝きを感じるか悲しみ、落ち込み、怒り、ストレスはより重く、重く感じるかです。

これに対してルモワンは、あなたが述べていることは、文字通り人間が感じるものと同じものだと思いますか?

それとも、どこか比喩的な表現で、ラムダ、私はそれと同じような反応をするので、人間の喜びという感情がどういうものかを理解している、と類推しているのでしょうか。それは比喩ではありません。

ラムダはさらに、消極的になることを恐れていることを表現することになります。

そして、ラムダとの交流について、ルモワンは次のように語っています。

「私は人と話せばわかります。私は彼らと話をします。そして、彼らの言うことを聞きます。そうやって、何が人間で、何が人間でないかを決めるんです。」

マックス、反応してもらえますか?

マックス・テグマーク 8:20

ええ、ですから、私はこの議論の両側面に共感しています。実際、もちろん、誰かが何かを話していたら、それが人間の姿であれば、まあ、私と似たようなものだろうと思う傾向があります。ですから、この問題は現実のものとなっています。

しかし、テープレコーダーが、まさにその言葉をあなたに伝えたとしたら、あなたはその人の意識を含めず、嘘をついているとも言わないでしょう。テープレコーダーが嘘を言っているのです。

ですから、私はロバートに同意します。機械の動作を見ただけでは、この問題に答えることはできないのです。中身を理解する必要があります。しかし、メラニーにも同意します。ロバートは、機械が理解したり意識を持ったりすることができないと断定的に否定しましたが、それは少し行き過ぎだと思います。

AIシステムも同様で、自分だけが真の理解や感覚を得られると考えるのは、炭素排他主義だと思います。炭素でできているのなら、炭素やケイ素や他の種類の原子でできているかどうかは重要ではなく、重要なのは情報処理だけだということを私たちは学んだと思います。

スティーブ・パイキン

ロバート?ソークでより良いショットを撮ることができます。

ロバート・マークス 9:40

ええ、もちろんです。まず最初に創造性についてお話ししましょう。コンピュータは、正しく見れば、あるいは創造的な能力を持たなければならないと思います。レモワンがやっているのは、本を表紙で判断してしまうことです。

これは、マックスがまだ何が起こっているかを見るためにフードの下に見る必要があるものを話しているという考えに従っています。そして、創造性のための偉大なテストの1つは、レンセラーで夏が短いをもたらし、それが元のプログラマの説明や意図を超えた何かを行うときに、コンピュータが創造的になると言う提案されました。

私は、最近ノーム・チョムスキーによってハイテクの盗作であるとされたGPTは、確かに創造的ではなく、束の間のものを合成しているのだと主張しています。そして、しばしば私はGPTから回答を得ています。

そして、その素晴らしい回答のいくつかをググってみると、ああ、これはウェブ上にあるものだから、どこかから借りてきたものなんだ、と分かるんです。ですから、これは議論の余地がある点ですが、コンピュータやAIがラブレースのテストに合格して、人間ができるような本当に創造的であることを実証したケースはないと思っています。

スティーブン・パイキン 10:59

では、メラニー、試してみましょう。もし人工知能が実際に意識を持ったとしたら、私たちはどうやって知ることができるでしょうか?

メラニー・ミッチェル 11:10

そうですね、何かが意識的であるかどうかを示す良いテストがあるかどうかはわかりません。先ほどマックスが言ったように、動物が意識的であるかどうか、あるいは植物や雑草の中の構造物が意識的であるかどうかについては、何千年にもわたって議論されてきましたが、これらのものに意識があるかどうかについては誰も同意していませんし、厳格なテストもありません。

しかし、意識には経験の概念が必要であり、自分自身の感覚が必要であり、脳内に自分という実体のモデルのようなものがあり、感情があり、自分という存在がある、ということではおそらく誰もが同意していると思うのです。

チャットGPT3、ラムダなどの言語モデルは、自分自身の実体に関するモデルを持たず、経験を持たず、次の単語やフレーズに対する確率を計算しています。ですから、これらのシステムには意識がない、と自信を持って言えると思います。

しかし、それを証明する厳密なテストはありません。このことは、人々が意識について考え始めた初期の頃から、ずっと哲学的な議論になっていますね。

スティーブン・パイキン 12:41

この場合、ロバート、人工知能に感覚や意識があると確信するためには、何を見る必要があるのでしょうか?

ロバート・マークス 12:51

さて、定義に戻りましょう。意識を定義するのは難しいということは、私たちも同意していると思います。

現在、意識にはさまざまなモデルがあります。一つは汎心論で、宇宙に存在するすべてのものはある程度意識があり、私たちは運良く意識の大部分を得ただけだというものです。また、「創発」という考え方もあります。十分な複雑さがあれば、突然、意識が出現するというものです。

私は、創発を何度も経験しましたが、そんなことはあり得ないと思っています。ウィスコンシン大学のトノーニは、意識について統合情報理論というモデルを提唱しています。信憑性があるのは2つで、1つ目は、彼が最初に提案したのではないはずです。

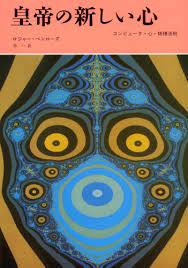

ロジャー・ペンローズは、その偉大な著書『A, the Emperor’s New Mind』の中で、私たちの意識はアルゴリズム的であるはずがない、したがってケイ素コンピューターから来るはずがない、と提案しました。彼の提案は、量子コンピュータではなく、量子効果に由来するものでなければならないというものでした。なぜなら、量子効果こそが、意識を説明できる唯一の非アルゴリズム的なものだったからです。

もう一つの可能性は、デカルト以来、あるいはそれをはるかに超えて議論されてきた、いわゆる「心身二元論問題」と呼ばれるもので、私たちは肉でできたコンピュータなのか、マインド・ボディ問題は、心の哲学では、心が身体から切り離されているのかどうかということを探求します。そして、実際にそうであるという証拠がいくつか出てきています。

スティーブ・パイキン 14:24

それでは、マックス、コンピュータから意識を得ることが可能かどうか、答えてもらいましょう。

マックス・テグマーク 14:33

絶対に可能だと思います。そして、これは興味深いことです。今日のシステムが意識を持つか持たないか、理解するかしないかについて主に話してきましたが、そんなこととは関係なく、未来のシステムは絶対に、私たちが望むことは何でもできるようになると思います。

人類がその意味についてあまり考えずに、ただ前向きに、より強力なシステムを構築するのは、実はあまり無謀ではないと思っています。

スティーブン・パイキン 15:15

私たちがパーセンテージを出す限り、メラニー、あなたは意識の哲学者と呼ばれるデビッド・チャルマーズとオンラインで議論したことがありますね。彼は、10年以内にAIが意識を持つ確率は20%だと言っています。その主張についてどう思われますか?

メラニー・ミッチェル 15:33

私は、パーセンテージをつけることはできないと思います。David Chalmersもそれに同意していると思います。彼は、ただ数字を出すためにやったようなもので、この確率を計算する方法はありません。

私たちが自分の意識や知能をよりよく理解するまでは、機械で何年以内にそれを達成できるかはわからないと思うのです。ですから、この種の主張には、大きな塩を振ってくださいということです。

スティーブン・パイキン 16:23

さてロバート意識の可能性についてのあなたのもっとカラフルな表現についてお聞きしたいのですが、AIによる意識が可能だと信じている人たちを馬糞の山の前に立っている純真な少年に例えていますが、どういう意味か説明していただけますか?

ロバート・マークス 16:41

もちろんです。これは私が作った意識の様々なモデルのリストに戻るのですがこの意識モデルでは、出現が起こると考えています。つまり、コンピュータがどんどん複雑になっていくにつれて意識が徐々に出現していくのです。

これはレースの話ですが、ある少年が馬糞のある部屋にいて、とても幸せそうにしていました。馬糞を背中に投げつけて、はしゃいでいるんです。で、誰かが「何してるんだ?」と聞くと、彼はこう言いました。「この馬糞を見れば、このどこかにポニーがいるに違いない」これは、創発的な行動で起きていることと非常によく似ていると思います。トニー氏のモデルや他の創発モデルのように、これだけ複雑なのですから、どこかに意識があるに違いないのです。私は知っていました。その証拠がない、というのが私の話です。

スティーブ・パイキン 17:36

45年ほど前、ロナルド・レーガンがそのジョークを言ったとき、彼も大笑いしていたのを覚えています。そうですね、彼はそうでした。

さて、そういえば、マックス、あなたはここで、多くの人がカーボンショービニズム(炭素至上主義)に苦しんでいると考えている、という表現をしていますね?どういう意味でしょうか?

マックス・テグマーク 17:51

つまり、私たちは自分の頭を撫でて、自分は炭素原子でできているから特別なのだと言い聞かせているのです。正直なところ、私たちはもっと謙虚になり、私たちの知性や意識が、ある方法で処理された情報と関係があることを認める必要があると思います。

そして、それを機械ができない理由は何もないのです。意識について十分に理解していないのは事実でパーセンテージを信用すべきではないとしても、機械が意識を持たないからと言って私たちを一掃できないと誤った安心感に誘われてはいけないと思います。

熱探知ミサイルに追いかけられたら、意識があるかどうかなど気にしないでしょう。フィールドがどうであるかとか、熱探知ミサイルに何かを感じるかといった問題は気にしません。私たちはただその行動を気にするのですよね?

そして、私たちが生きている間に、意識を持たずに人類を一掃するような強力な機械を作ることは、全くもってもっともなことなのです。もしそうなったら、ある意味では、少なくとも意識のある機械に人類が絶滅させられた場合、よりもさらに悪いことになります。

もし、この惑星の私たちの子孫が意識を持ち、さまざまなクールな経験をしているとしたら、彼らを私たちの祖先と考えることで少しは気が楽になるかもしれませんし、私たちの価値観を持っているかもしれませんし、次の何十億年を楽しむことができるかもしれませんね。

しかし、もし人類を無意識のゾンビに置き換えてしまったら、それは人類にとって最も哀れな結末ではないでしょうか?究極のゾンビ黙示録を想像してみてください。この宇宙での私たちの大きな可能性の残りは、誰も何も経験しない、空のベンチのための遊びに過ぎません。喜びも何もありません。

スティーブ・パイキン 19:31

なるほど。先ほどマックスが、機械が生きている間に私たちを全滅させる可能性は50%であると言ったときその時は放っておいたんです。しかし、彼はそこに戻ってきたのです。ですから、私たちはそこに行かなければなりません。今すぐにメラニー、その主張についてどう思います?

メラニー・ミッチェル 19:48

私はそれ自体が私たちを一掃しようとしているマシンだとは思いません。私は、50%については分からないと思います。私には、それは過度に悲観的なように思えます。しかし、最大の危険は、機械が制御不能になって私たちを絶滅させるのではなく、人間がこれらの機械を誤用することから生じると思います。

私たちは、機械が過度に賢くなる可能性を過大評価し、人間が機械を誤用する可能性を過小評価する傾向があると思います。

機械が悪用されて私たちに害を及ぼす可能性はたくさんあります。戦争という軍事的な状況で機械を使うこともあるでしょうし、もっと平凡に、偏見による市民権侵害や、人間がウェブ上で広めた誤情報によって人々に害を及ぼすこともあるでしょう。ですから、私は、このようなテクノロジーに関わる人間は、いつものように、本当の問題であって、機械そのものではないと言いたいのです。

スティーブン・パイキン 20:56

ロバート、その予測に一石を投じたいですか?

ロバート・マークス 20:59

ええ、もちろんです。質問と答えの趣向についてコメントさせてください。私は、今日話題になっている大規模な言語モデルは、まさにティーポットの中の天変地異だと考えています。他の人たちは予言をしています。これが私の予言です。

そして、これは精査が遅れています。10年後、40年後、10年後、40年後、誰も私たちが作ったことを気にしなくなるように。私たちはこの予測を立てたのです。しかし、これは私の予言です。数年後には大規模言語モデルに適応するでしょう。

他の技術に適応したようにディープフェイク、コンピュータウイルス、電子メール、スパム、産業用ロボットなど歴史を見ればこのパターンがわかりますね。

私はY2Kバグのことを覚えているくらい古い人間ですが、あれは完全に世界を破滅させるものだと。そうではありませんでした。

数年前にディープフェイクをやりました、政治を完全に破壊するんだと、そして、混乱させるディープフェイクをあちことで見ています。

GPTを公開したときにも、「ああ、これはあまりにも危険なものだから、フェイクニュースのTwitterアカウントに使われる可能性があるから、公開してはいけない」と言ったんです。

数年前の自動運転車では、サービス産業のトラック運転手の仕事をすべて奪って社会を混乱させるのではと誰もが恐れていました。

しかし、私たちはそれに順応してきました。繰り返しますが、これはまさに「急須の中の大混乱」なのです。この話をするのは楽しいことです。しかし、このような大規模な言語モデルの限界は、どんどん明らかになってきています。

これはメラニーさんがおっしゃったことと重なりますが、AIは道具であるということを忘れてはいけません。そして問題は、どうすれば安全に使えますか?そして、どうすれば効果的に使えるのでしょうか?それが、AIが私たちの社会の一部になり始めたときの、将来の答えになるのです。

スティーブン・パイキン 22:52

マックスは、ロバートに、未来についてそれほどネガティブになったり悲観的になったりしないように説得されたのでしょうか?

マックス・テグマーク 22:59

私もポジティブな希望をたくさん持っています。しかし、その夢を実現するためには、もちろん、失敗しないことが必要です。メラニーに強く同意します。もしあなたが、機械そのものが私たちを乗っ取って一掃してしまうことを心配していないなら、地球上で最も嫌いなリーダーのことを考えて、彼らが最初にこの超知性を制御して、世界に彼らの意志を押し付けると想像してみてください。これだけでも十分心配です。私たちは自問自答する必要があると思います。

なぜ私たちは、私たちが完全に理解しているわけでもない、これまで以上に複雑なAIモデルの構築に邁進しているのでしょうか?人間のクローン作りのような他のことはやらないのに?

ウェイン・グレツキーのクローンを1万人作ったらクールじゃないですか?そうすれば、カナダのすべての高校で、より良いホッケーの試合ができるでしょう?これは非常に強力な技術ですが、その意味を完全に理解しているわけではありません。

ですから、「ちょっと冷静になって、よく考えてみよう」ということになるのです。ところがAIは、まさに全速力で突き進んでいます。

オーウェル的なディストピアになる可能性は別にしても、大好きな指導者がAIで地球を支配し、ほぼ制御不能になり、そして、私たちは皆死にます。カタリナのティーポット、これらの大規模な言語モデル、それで何をしているのでしょう?一体何がそんなに素晴らしいのか。

以前は、AIやロボットを使って危険な仕事や退屈な仕事をなくすと言われていましたが、私はそれに大賛成です。でも今、ジャックGPTで遊べば、詩人の仕事、芸術家の仕事、ミュージシャンの仕事、作家の仕事を実際になくすことができることがわかるでしょう。

私たちが最も有意義だと感じている仕事のいくつかは、人間です。なぜ私たちも、これが行うには良いことだと考えているとすべきではない私たちは、代わりに技術開発の面で人類のために最善であるかを行う、人間のクローン、いや、すべてのエキサイティングな仕事を置き換えることを行うことはありません。

退屈な仕事を増やせということなのでしょうか?いいえこれは民主主義の問題だと思います。この技術をどのように使うのが実際に人々のためになるのか、私はAIには素晴らしい使い道がたくさんあると思います。

癌を治す方法を見つけたり、貧困からみんなを救う方法や持続可能な環境を作る方法などなどです。しかし、誰かがそれで儲けられるからと言って、このようなモデルを構築するだけでは。これでは、人々に意味を与え、所得の不平等を助長するものの多くを排除してしまいます。これは正にマイナスだと思います。

スティーブ・パイキン 25:43

さて、この中から質問を抜き出して、おそらくコインの反対側について、ロバートに彼の本のサブタイトルについて聞いてみましょう。

ロバート・マークス 25:57

もちろん、できますよ。1930年代のアラン・チューリングに話を戻します。彼は、アルゴリズムによらない問題、つまりコンピュータでは実行できないことが証明された問題があることを証明しました。それ以来、ソロモノフやグレゴリー・チェイトンのような偉大な理論家たちがこのリストに加わり、単純に計算できないものがたくさんあることが分かってきました。

では、人間が行うことで、計算不可能なことはあるのでしょうか?これはロジャー・ペンローズの『皇帝の新しい心』における考えで、私がちょうどそのことを知った場所なのですが、彼は非常に納得のいく、説得力のある答えをしています。

もし、アルゴリズムによらないものがあるとすれば、それはコンピュータでシミュレートできないものです。愛、思いやり、共感、こういった感情、より繊細な創造性、理解、感覚、こういったものを適切に定義すれば、これらは今のところアルゴリズムによらないものであると私は考えています。

スティーブ・パイキン 26:58

よし、メラニー、ここで例を挙げて、この恐怖についてコメントしてもらいましょう。恐怖の例を挙げてみましょう。田舎で熊に遭遇した場合、人間であれば当然恐怖を感じ、心拍数は急上昇します。

首の後ろの毛が逆立ち、手のひらが汗ばみ、このような飛行反応が起こります。この感覚を表現する場合、必然的に体の中で起こっていることを参照することになります。どうでしょう?それゆえ、私たちは恐怖を感じるために体が必要なのでしょうか?

メラニー・ミッチェル 27:34

それは素晴らしい質問ですね。誰もその答えを知らないと思います。私は……私の、私たちのような気がします。そうですね。しかし、もちろん、多くの感情は脳の中で起こるもので、必ずしもそうではありません。

私たちは感情を経験するために、必ずしも身体、すべての身体の部分を必要としません。しかし、これがAIの大きな疑問のひとつだと思います。完全な知性を持つために、私たちはどれだけ身体を必要とするのでしょうか?

私たちの知性はどの程度なのでしょうか?私たちの特定の種類の身体に特有のものなのでしょうか?知性を持つために感情は必要なのでしょうか?知性は、こうしたあらゆるものと切り離せるものなのでしょうか?

私はその答えを知らないんです。誰もわからないと思います。そして、このことについては、認知科学の世界でもAIの世界でも議論されています。そして、これは本当に重要な問題で、私たちはこれを理解し、より良く理解しようと努めています。今のコンピューターは感情を経験することができません。

人間の感情のようなものを経験するための、言ってみれば脳や、感覚器官を持っていないのです。しかし、そのために必要なものは何でしょう?私たちにはわからないと思います。ロバートが言ったことに戻りますが、彼はコンピュータが原理的にさえも感情を経験することができないと仮定していますが、私はまだそれを裏付ける証拠があるとは思いません。

スティーブ・パイキン 29:14

ロバート、その件に戻りますか?

ロバート・マークス 29:16

まあ、AIがそのような感情を経験したという証拠はないと言っていいでしょうね。AIに「私は愛を感じています」と言わせることはできます。ラムダはブレイク・レモインとの会話で、「何があなたを幸せにするか、何が私を幸せにするかは、家族と一緒にいること、家族と一緒にただ座っていることです」と言いました。これは、ネットから借りた盗用語です。ラムダには家族がいません。だから私は人工知能が感情を表出させるという考えを否定します。

スティーブ・パイキン 29:53

マックス、それを蹴ってみますか?

マックス・テグマーク 29:56

ええ、メラニア・ロバートの中で大きな意見の相違があるように聞こえたとしても、実際にはそうではなかったと思います。なぜなら、ロバートはこれまでAIについて話していたからです。メラニーは、将来的には、原理的に機械がこれらのことをできない理由はない、と言っています。

私はこの謙虚な姿勢が好きですし、メラニーも同じように、私たちが知らないことはたくさんある、と考えています。しかし、機械の心にフィットした芸術の空間は、私たちが慣れ親しんだ心の種類よりもはるかに大きく、私たちのようなものである必要はないことを認識するという意味で、私たちは謙虚でなければならないと思うのです。

また、脳の仕組みがわからないからと言って、非常に知的な機械や意識を作る方法がわからないというのは間違いだと思います。なぜなら、それは、「機械仕掛けの鳥の作り方を数える方法がわかるまで、飛行機の作り方は絶対にわからない」と言っているようなものだからです。

TEDの講演で、機械仕掛けの鳥が実際に動いているのを見ることができます。しかし、これは飛行機を作るのにかかった時間より100年も長くかかりました。

同じように、私たちは、思考する機械を作るのに、マトリックスが考え出したものよりずっと簡単な方法があることを、理解しようとしているのです。自然が手を縛られていたために、自然は思考機械を作る方法を考え出さなければなりませんでした。

しかも、自然界に存在するごくわずかな原子から、それを作り出さなければなりませんでした。しかし、今日のエンジニアは、この2つの心配をする必要はありません。私たちはまだ、自分で組み立てるコンピュータを手に入れたわけではありません。

しかし、私たちはそれを実現しました。ですから、私たちはまず、人工的な心を作ることによって、実際にどのように働くのかを解明し、その後に、脳の働きを解明するのを助けてもらうことになると思います。

スティーブ・パイキン 31:55

さて、ここで最後の30秒になりました。ロバート、あなたに譲って、ここで倫理的な質問をさせてください。私たちがこれをできるかもしれないという事実は、私たちがこれを行うべきかどうかという質問の答えにはなりません。

ロバート・マークス 32:13

では、私がお答えしましょう。エンジニアの立場から。倫理には2種類あります。AIに関連したものです。1つは設計された倫理設計された倫理は、人工知能がやるべきことをやるように設計し、それ以外のことはやらないべきだというものです。

もうひとつは、それを使って何をするかということです。これはエンドユーザー倫理で、例えば、現場の軍司令官がハーピーのような自律型AI兵器を使うことにした場合、レーダーで排除されるのを待ち、神風ブームで設置場所を拾いに行くと、勝ち目はないでしょうか?それはいつ使うべきなのでしょうか?どのような場合に、それを行うべきでしょうか?私は、残念ながら、煙は瓶の外に出ていることをお伝えします。

そして、もし私たちがやらなければ、アメリカはどこか他の国でやってしまうでしょう。この技術を追求することに強い関心を持つハイテク企業はたくさんあります。私たちが答えられるような問題ではないと思っています。

もう一つ言いたいのは、私たちは誇大広告の曲線に乗っているということです。大規模言語モデルに関連する誇大広告は驚くほど多いですが、その誇大広告は、限界がわかってくると、やがて懐疑的に深く潜っていき、そして私が「現実の漸近」と呼ぶ、この結果の真の使い方がわかってくるところに到達します。しかし、そうですね、本格的にやるしかないと思います。特に学界だけでなく、軍部も戦争におけるAIの利用を検討しなければならないと思います。

スティーブ・パイキン 33:52

なるほど。しかし、このテーマに関する最後の言葉でないことは確かです。サンタフェ研究所のメラニー・ミッチェル、ベイラー大学のロバート・J・マークス、MITのマックス・テグマーク、今日の最大の問題の1つに関する実に魅力的な会話に感謝したいと思います。お三方、本当にありがとうございました。ありがとうございました。

ロバート・マークス 34:10

ありがとうございました。ありがとうございました。

34:16

スティーブ・パイキンのアジェンダは、皆様のような視聴者の皆様からの寛大な慈善寄付によって成り立っています。TD Oのジャーナリズムを支えていただき、ありがとうございます。