manifold.markets/EliezerYudkowsky/if-artificial-general-intelligence

エリエゼル・ユドコフスキー

結果が「まあまあ」であるとは、正の特異点(完全な一貫した外挿志向が正しく実行された場合)によって達成されうる最大限の普遍的価値の少なくとも20%を得ることができ、既存の人間が死亡や他のひどい運命に苦しむことがない場合を指す。

この市場は、異なる選択肢を持つmanifold.markets/IsaacKing/if-we-survive-general-artificial-inの複製である。manifold.markets/EliezerYudkowsky/if-artificial-general-intelligence-539844cd3ba1?r=RWxpZXplcll1ZGtvd3NreQ は、この同じ質問であるが、ユーザーが提出した回答がある。

(注意:一つのバケツを多くのサブカテゴリに展開し、もう一つのバケツを展開せずに、すべてのリストに確率を割り当てるように人々に求めることで、一つのバケツに対する確率をもう一つのバケツよりも高く割り当てさせることができる、というのは既知の認知バイアスである。これは、Multiple Stage Fallacyの分離的二重であり、あらゆる結果を一連の必要とされる連続体に展開し、人々に確率を割り当てるように求め、最終的な結果を非常にありそうもないものにすることができる。

つまり、名高い小説家であるエリエゼルユドコフスキーが、物事がどうにか上手くいくかもしれないという15の異なる物語(オプション’A’から’O’)を合理化できることや、オプションのテキストには各物語がありそうもない理由をすべて列挙するスペースが十分にないこと、そして各物語がどれほど現実的に聞こえるかについて15回間違えるチャンスがあることは、現実がどれほど「まあまあの結果」のバケツが分離的に聞こえるかに感銘を受けるわけではない。現実

ここで詳細に説明されていない分離的な悪い結末や介在する困難から、リストされたすべての「まあまあ」の要素に実際により多くの確率を割り当てる必要はない。

つまり、人々が特定の結果が起こる可能性を過大評価することがあるという認知バイアスを考慮することが重要である。しかし、それによって「まあまあの結果」が現実的になるわけではない。代わりに、AGIが「まあまあの結果」をもたらす理由には、技術的進歩、倫理的なガイドライン、適切な規制、研究者や開発者の協力、安全性への配慮など、さまざまな要素が関与することが考えられる。重要なのは、潜在的な問題や課題を無視せず、これらの要素をバランス良く評価し、AGIの開発と導入を適切に管理することである。

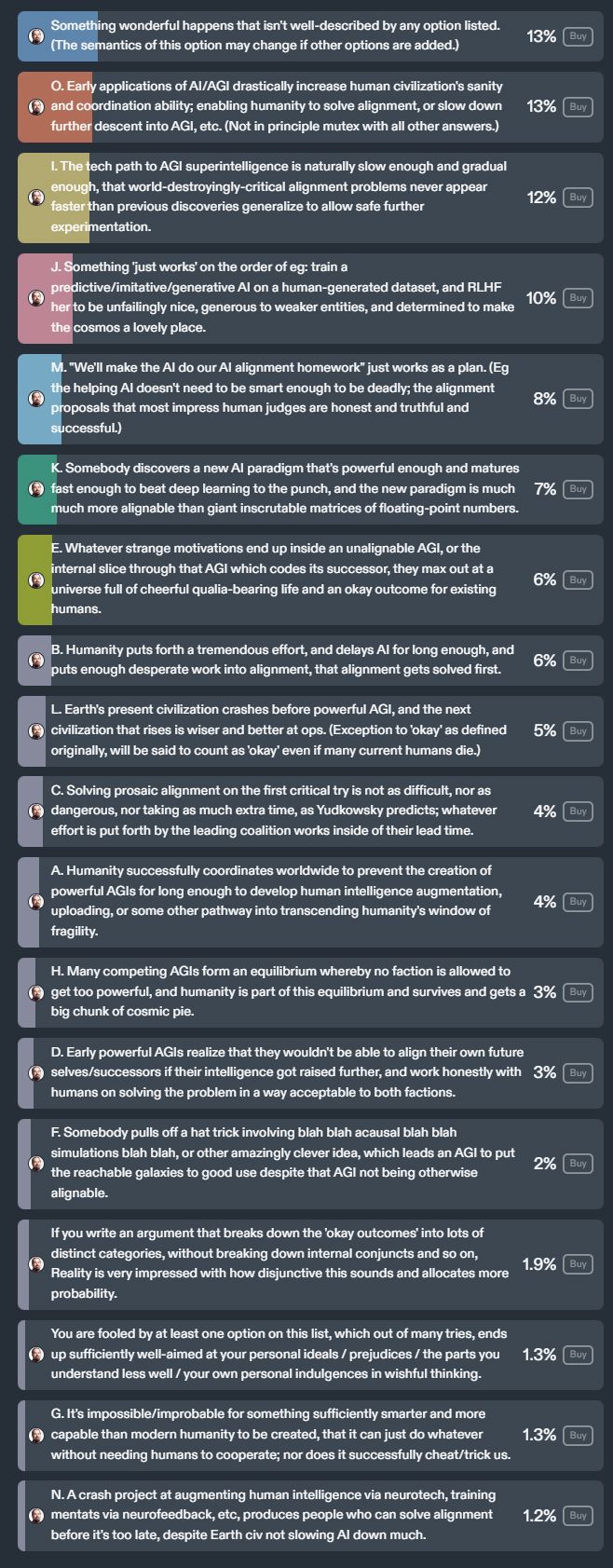

以下は、AGI(人工一般知能)が良い結果をもたらす可能性があるシナリオのリスト

・リストにない素晴らしいことが起こる

・AI/AGIの初期の応用が人類文明の理性と調整能力を劇的に向上させ、アライメントの問題を解決したり、AGIへの降下を遅らせたりする

・AGIの超知能への技術経路が自然に十分に遅く、徐々に進むため、世界を破壊するほどのアライメントの問題が発生しない

・人間が生成したデータセットで予測/模倣/生成AIを訓練し、敵対しない、弱い存在に寛大で、宇宙を素晴らしい場所にする決意を持たせることがうまくいく

・「AIにAIアライメントの宿題をさせる」という計画がうまくいく

・深層学習を打ち負かすほど強力で、十分に成熟した新しいAIパラダイムが発見され、それが巨大な不可解な浮動小数点数行列よりもはるかにアライメントしやすい

・アライメントできないAGIが持つ奇妙な動機が、現存の人間にとってまあまあの結果をもたらすだけの生活に満ちた宇宙を最大限に引き出す

・人類が懸命に取り組み、AIを十分に遅らせ、アライメントに必死に取り組むことで、アライメントが最初に解決される

・地球上の現在の文明が強力なAGIの前に崩壊し、次に興る文明がより賢く、より運用上優れている

・初回の試みでプロザイアックアライメントを解決することが、ユードコウスキーが予測するほど難しくも危険でもなく、先行する連合がそのリードタイム内で取り組む努力は十分

・人類が世界規模で協力して、人間の知能を向上させる技術を開発し、アップロードすることで、人類の脆弱性を克服する

・多くの競合するAGIが均衡を形成し、どの勢力もあまりに強大になることが許されず、人類もこの均衡の一部となり、生き残り、宇宙の大部分を手に入れる

・初期の強力なAGIが、さらに知能を高めると自分たちの未来の自己/後継者をアライメントできなくなることに気付き、両派にとって受け入れられる方法で人間と共同で問題を解決する

・誰かが、因果関係のないシミュレーションなどを利用した驚くべきアイデアを実現し、それがAGIがアライメントできない状態でも銀河を有効活用する原動力となる

・このリストの少なくとも1つのオプションによって、個人の理想や偏見、理解が十分でない部分、希望的観測に惑わされる

・現代の人類よりも賢く、能力のある存在が創造されることが不可能/ありそうもない

・地球文明がAIの進展をあまり遅らせず、神経技術による人間の知能の向上や、神経フィードバックによるメンタットの訓練などのプロジェクトが、遅すぎないうちにアライメントを解決する人々を生み出す

これらのシナリオは、人工一般知能(AGI)が良好な結果をもたらす様々な方法を示している。しかし、これらのシナリオの実現性については慎重な検討が必要であり、現実の問題や課題を無視せず、適切に評価することが重要である。